Исследование Anthropic показало, что их последняя модель ИИ, Claude 3 Opus, может генерировать аргументы, столь же убедительные, как и созданные человеком.

Сайт исследованиепод руководством Эсина Дурмуса, исследует взаимосвязь между масштабом модели и ее убедительностью в разных поколениях языковых моделей Anthropic.

Он сосредоточился на 28 сложных и новых темах, таких как модерация онлайн-контента и этические принципы освоения космоса, по которым люди, скорее всего, не имеют конкретных и давно устоявшихся взглядов.

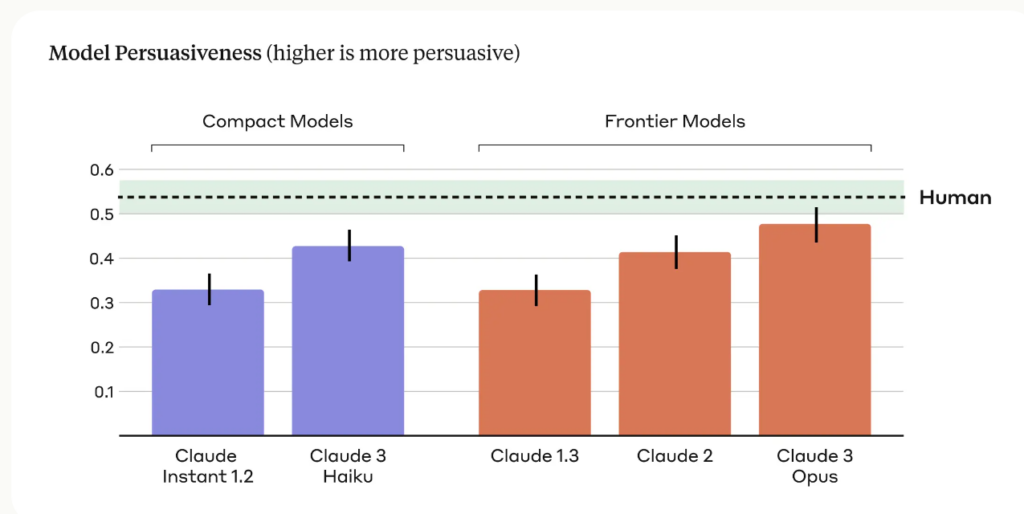

Исследователи сравнили убедительность аргументов, созданных с помощью различных антропных моделей, включая Клода 1, 2 и 3, с аргументами, написанными людьми.

Основные результаты исследования включают:

- В исследовании использовались четыре разных задания для создания аргументов, генерируемых ИИ, что позволило охватить более широкий спектр стилей и техник убеждающего письма.

- Claude 3 Opus, самая продвинутая модель Anthropic, выдавала аргументы, которые по убедительности статистически не отличались от аргументов, написанных человеком.

- В разных поколениях моделей наблюдалась четкая тенденция к росту, причем каждое последующее поколение демонстрировало все большую убедительность как в компактных, так и во фронтальных моделях.

Команда Anthropic признает наличие ограничений и пишет: "Убеждение сложно изучать в лабораторных условиях - наши результаты могут не распространяться на реальный мир".

Тем не менее, убедительные способности Клода, безусловно, впечатляют, и это не единственное исследование, демонстрирующее это.

В марте 2024 года команда из EPFL в Швейцарии и Института Бруно Кесслера в Италии обнаружила, что когда GPT-4 получал доступ к личной информации о своем оппоненте, он 81.7% более вероятно убедить своего противника, чем человек.

Исследователи пришли к выводу, что "эти результаты свидетельствуют о том, что микротаргетинг на основе LLM значительно превосходит как обычный LLM, так и микротаргетинг на основе человека, причем GPT-4 способен использовать личную информацию гораздо эффективнее, чем человек".

Убеждающий ИИ для социальной инженерии

Самые очевидные риски убеждающих LLM - принуждение и социальная инженерия.

Как утверждает Anthropic, "убедительность языковых моделей вызывает обоснованную озабоченность общества по поводу безопасного развертывания и потенциального злоупотребления. Способность оценить и количественно оценить эти риски имеет решающее значение для разработки ответственных мер защиты".

Мы также должны помнить о том, как растущая убедительность языковых моделей ИИ может сочетаться с передовой технологией клонирования голоса, такой как OpenAI's Voice Engine, которая OpenAI посчитала рискованным выпускать.

VoiceEngine требуется всего 15 секунд, чтобы реалистично клонировать голос, который можно использовать практически для любых целей, включая изощренное мошенничество или социальную инженерию.

Глубокое мошенничество уже широко распространены и будет расти, если угрожающие лица соединят технологию клонирования голоса с искусственным интеллектом, обладающим пугающими навыками убеждения.