Группа ведущих ученых выступила с добровольной инициативой, определяющей набор ценностей, принципов и обязательств для разработки белков с искусственным интеллектом.

Сайт письмо В книге обсуждаются возможные злоупотребления инструментами искусственного интеллекта, способными создавать новые белки с беспрецедентной скоростью и эффективностью.

Хотя ИИ открывает огромные перспективы для решения насущных глобальных проблем, от борьбы с пандемиями до решения проблем устойчивой энергетики, он также вызывает вопросы о возможности его использования в злонамеренных целях, например, для создания нового биооружия.

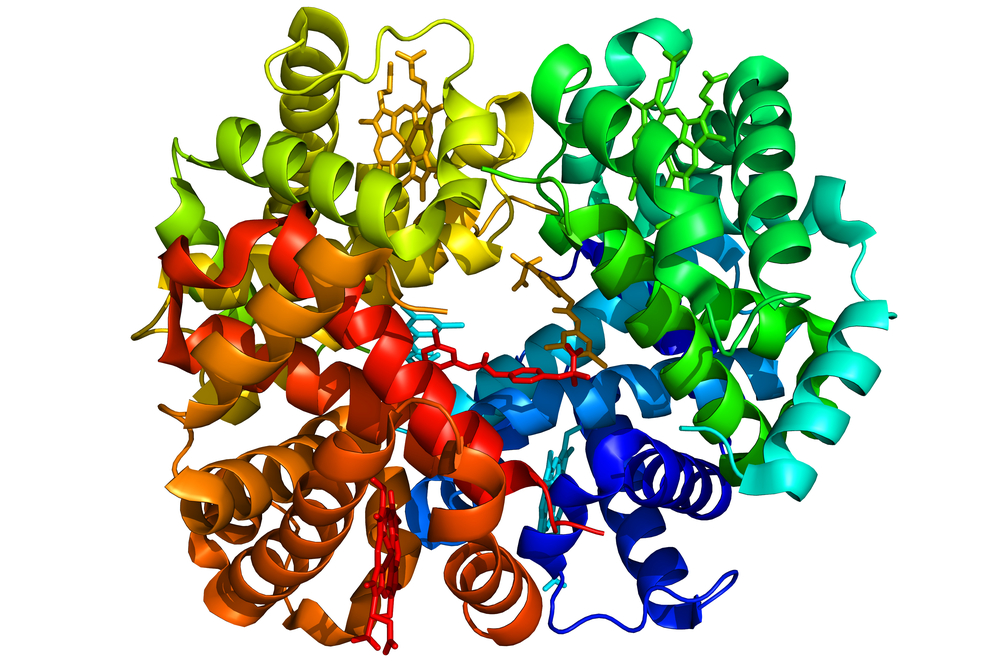

В то время как белки, созданные системой AlphaFold компании DeepMind и позже исследователи В Медицинской школе Вашингтонского университета продемонстрировали высокую аффинность и специфичность по отношению к намеченным целям, однако всегда существует вероятность того, что эти белки могут взаимодействовать с другими молекулами в организме неожиданным образом.

Это может привести к неблагоприятным побочным эффектам или даже к развитию новых заболеваний.

Еще один риск - возможность неправильного или злонамеренного использования этой технологии. Так же, как разработанные ИИ белки могут быть использованы для создания высокоцелевых терапий, они также могут быть созданы для нанесения вреда.

Например, злоумышленник может разработать белок, направленный на определенную этническую группу или использующий определенную генетическую уязвимость.

Как отмечает Дэвид Бейкер, специалист по вычислительной биофизике из Вашингтонского университета и одна из ключевых фигур, стоящих за этой инициативой: "Вопрос заключался в том, как, если это вообще возможно, следует регулировать дизайн белков и каковы опасности, если таковые имеются?"

Сто с лишним подписантов считают, что "преимущества нынешних технологий ИИ для дизайн белков значительно перевешивает потенциальный вред", но признает необходимость упреждающего подхода к управлению рисками по мере развития технологии.

ИИ в биологии способен помочь решить ряд важнейших проблем, стоящих перед нашим обществом. Открытость науки будет иметь решающее значение для прогресса нашей области. Как ученые, участвующие в этой работе, с более чем 90 подписантами по всему миру, мы продвигаем рамки... pic.twitter.com/4m81j87Vo9

- Алекс Райвз (@alexrives) 8 марта 2024 года

В письме говорится, что "учитывая ожидаемый прогресс в этой области, может потребоваться новый проактивный подход к управлению рисками, чтобы снизить вероятность разработки технологий ИИ, которые могут быть использованы не по назначению, намеренно или иным образом, чтобы нанести вред".

Подпись.

Хорошая идея для обеспечения безопасности при разработке белков (с использованием ИИ или нет): регулировать и контролировать машины для синтеза белков и встроенное программное обеспечение, а не сами исследования ИИ.

Эту идею я продвигал на саммите по безопасности искусственного интеллекта в Великобритании. https://t.co/skcUUcgG5a- Янн ЛеКун (@ylecun) 8 марта 2024 года

В рамках инициативаИсследователи сформулировали набор ценностей и принципов, которыми следует руководствоваться при ответственном развитии технологий искусственного интеллекта в дизайне белков.

К ним относятся "безопасность, надежность, справедливость, международное сотрудничество, открытость, ответственность и проведение исследований на благо общества". Стороны, подписавшие соглашение, также добровольно согласились с набором конкретных, выполнимых обязательств, основанных на этих ценностях и принципах.

Один из ключевых аспектов инициативы направлен на улучшение скрининга синтеза ДНК - важнейшего шага на пути превращения разработанных ИИ белков в физические молекулы.

Ученые обязуются "получать услуги по синтезу ДНК только от поставщиков, которые демонстрируют соблюдение стандартных для отрасли методов проверки на биобезопасность, направленных на выявление опасных биомолекул до того, как они могут быть изготовлены".

Достижения искусственного интеллекта в области медицины и биотехнологий были совершенно невероятными, что привело к новые антибиотики и антивозрастные препараты.

Чтобы продвигать эти выводы, подписавшие соглашение стороны обязуются "сотрудничать с заинтересованными сторонами со всего мира" и "воздерживаться от исследований, которые могут привести к общему вреду или создать условия для неправильного использования наших технологий".