Компания OpenAI объявила, что будет использовать стандарт C2PA для добавления метаданных к изображениям, созданным с помощью DALL-E 3.

Это заявление было сделано в то время, когда компании продолжают искать способы предотвратить использование своих продуктов генеративного ИИ для распространения дезинформации.

C2PA - это открытый технический стандарт, который добавляет метаданные к изображению, включая его происхождение, историю редактирования и другую информацию. OpenAI утверждает, что изображения, созданные с помощью DALL-E 3 напрямую или через ChatGPT или его API, теперь будут включать данные C2PA. Пользователи мобильных устройств смогут увидеть это к 12 февраля.

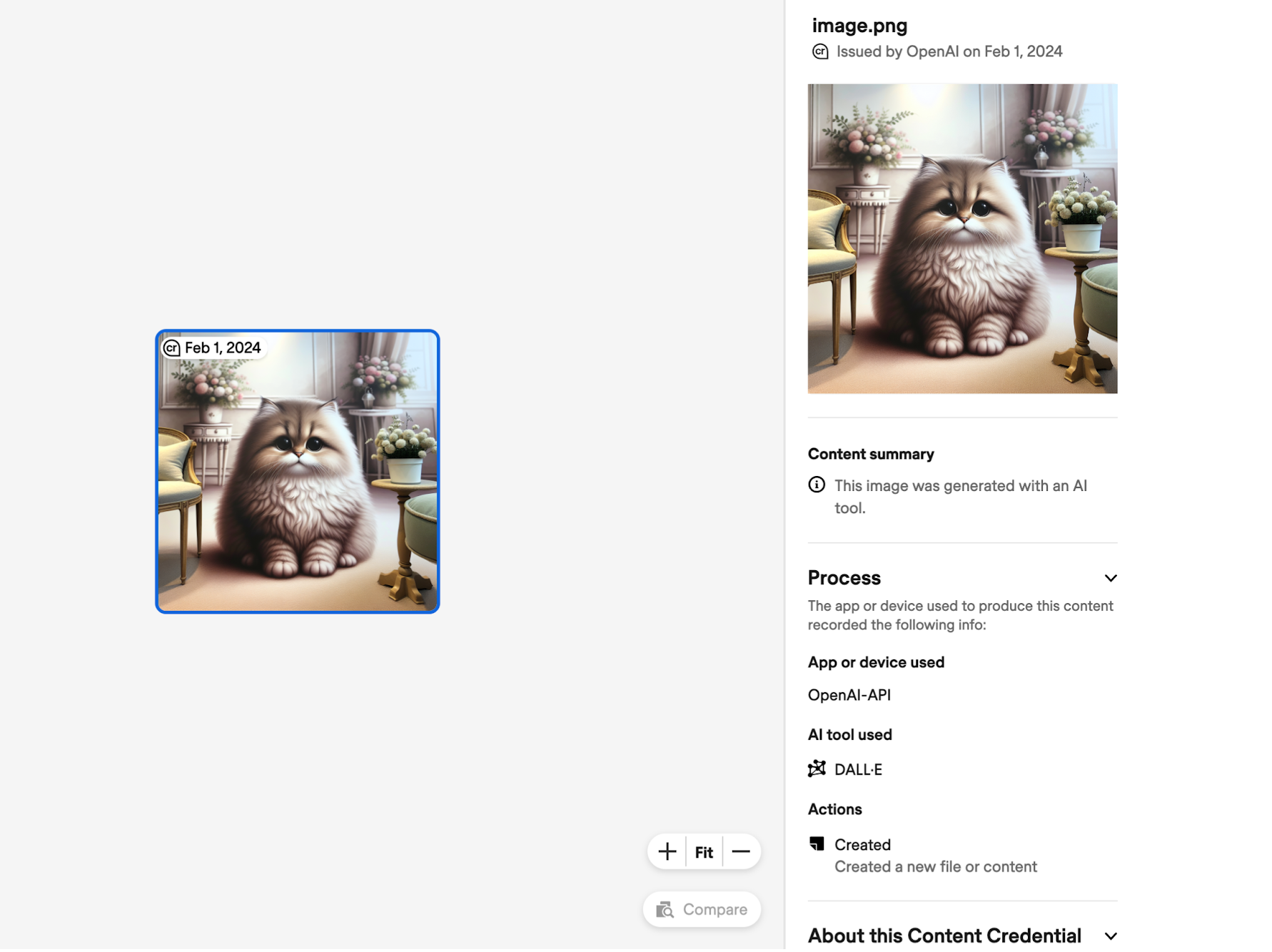

Изображение, к которому добавлены метаданные C2PA, можно загрузить на такие сайты, как Проверка достоверности содержимого чтобы проверить происхождение изображения. Вот пример информации, которую C2PA выдает об изображении, сделанном с помощью DALL-E через API.

Платформы социальных сетей также могут использовать эти данные, чтобы отмечать и маркировать изображения как созданные искусственным интеллектом. Мета недавно объявила что для этого нужно приложить больше усилий.

Добавление данных C2PA увеличивает размер файла: примерные оценки от OpenAI:

- 3,1 МБ → 3,2 МБ для PNG через API (увеличение на 3%)

- 287k → 302k для WebP через API (увеличение на 5%)

- 287k → 381k для WebP через ChatGPT (увеличение на 32%)

OpenAI признает, что "C2PA не является серебряной пулей для решения проблем с проверкой подлинности". Метаданные легко удалить, часто непреднамеренно.

Если вы сделаете скриншот изображения, то данные C2PA не сохранятся. Даже преобразование изображения из PNG в JPG уничтожит большинство метаданных. Большинство платформ социальных сетей удаляют метаданные из изображений при их загрузке.

OpenAI утверждает, что, добавив C2PA к изображениям DALL-E, она надеется побудить "пользователей признать, что эти сигналы являются ключом к повышению достоверности цифровой информации".

Возможно, в какой-то степени это и так, но тот факт, что C2PA так легко удалить, не сильно помогает, когда человек намеренно хочет использовать изображение для введения в заблуждение. Если уж на то пошло, это может лишь немного замедлить работу фальсификаторов.

Цифровой водяной знак SynthID от Google кажется гораздо более безопасным решением, но OpenAI вряд ли будет использовать инструмент, созданный конкурентами.