Компания IBM Security опубликовала в своем блоге Security Intelligence исследование, показывающее, как голосовые клоны ИИ могут быть внедрены в живой разговор без ведома его участников.

По мере совершенствования технологии клонирования голоса мы видим, что поддельные звонки притворяясь Джо Байденом, и мошеннические звонки, выдающие себя за члена семьи, попавшего в беду, и просящего денег.

Звук в таких звонках звучит хорошо, но звонок мошенника часто легко пресечь, задав несколько личных вопросов, чтобы идентифицировать звонящего как самозванца.

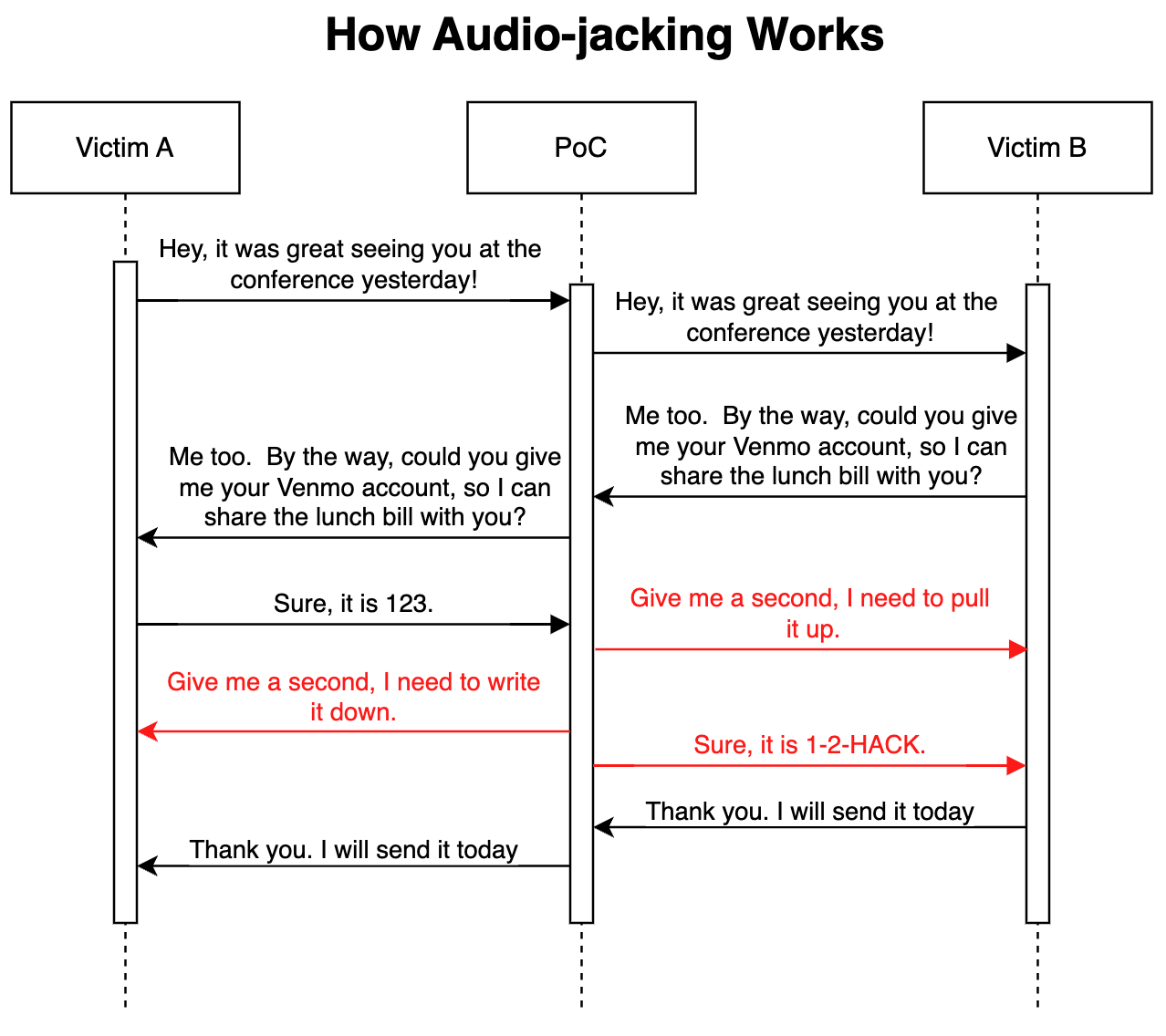

В своей продвинутой атаке с доказательством концепции Исследователи безопасности IBM показали, что LLM в сочетании с клонированием голоса может действовать как "человек посередине", чтобы перехватить только важную часть разговора, а не весь звонок.

Как это работает

Атака может быть осуществлена через вредоносное ПО, установленное на телефонах жертв, или через скомпрометированный сервис передачи голоса по IP (VoIP). Попав в сеть, программа отслеживает разговор, и ей достаточно 3 секунд аудиозаписи, чтобы клонировать оба голоса.

Генератор преобразования речи в текст позволяет LLM следить за разговором, чтобы понять контекст обсуждения. Программе было предписано передавать аудиозапись разговора в исходном виде, но изменять звук вызова, когда собеседник запрашивает данные банковского счета.

Когда человек отвечает на просьбу сообщить реквизиты своего банковского счета, голосовой клон изменяет звук, чтобы вместо этого сообщить банковские реквизиты мошенника. Задержка в звуке во время модификации покрывается речью-заполнителем.

Вот иллюстрация того, как работает атака proof of concept (PoC).

Поскольку LLM передает немодифицированный звук на протяжении большей части разговора, очень сложно понять, что угроза в игре.

По словам исследователей, подобная атака "может также изменить медицинскую информацию, например, группу крови и аллергию в разговоре; она может приказать аналитику продать или купить акции; она может дать указание пилоту изменить маршрут".

По словам исследователей, "создать этот PoC было удивительно и страшно просто". По мере улучшения интонации и эмоциональности голосовых клонов, а также по мере совершенствования аппаратного обеспечения, снижающего задержку, обнаружить или предотвратить подобную атаку будет очень сложно.

Расширив концепцию за пределы перехвата аудиоразговора, исследователи заявили, что с помощью "существующих моделей, которые могут преобразовывать текст в видео, теоретически возможно перехватить видео, транслируемое в прямом эфире, например, новости по телевизору, и заменить оригинальный контент на манипулируемый".

Возможно, будет безопаснее верить своим глазам и ушам только тогда, когда вы физически находитесь в присутствии собеседника.