Компания Google DeepMind выпустила набор новых инструментов, которые помогут роботам быстрее и эффективнее обучаться автономно в новых условиях.

Обучение робота выполнению конкретной задачи в одной среде - относительно простая инженерная задача. Если роботы хотят быть действительно полезными для нас в будущем, они должны уметь выполнять целый ряд общих задач и учиться делать это в условиях, с которыми они раньше не сталкивались.

В прошлом году компания DeepMind выпустила Модель управления роботом RT-2 и наборы данных роботов RT-X. RT-2 переводит голосовые или текстовые команды в действия роботов.

Новые инструменты, о которых объявила компания DeepMind, основаны на RT-2 и приближают нас к автономным роботам, которые исследуют различные среды и обучаются новым навыкам.

За последние два года было доказано, что большие фундаментные модели способны воспринимать окружающий мир и рассуждать о нем, открывая ключевую возможность для масштабирования робототехники.

Мы представляем AutoRT, фреймворк для организации роботизированных агентов в дикой природе с помощью базовых моделей! pic.twitter.com/x3YdO10kqq

- Киртана Гопалакришнан (@keerthanpg) 4 января 2024 года

AutoRT

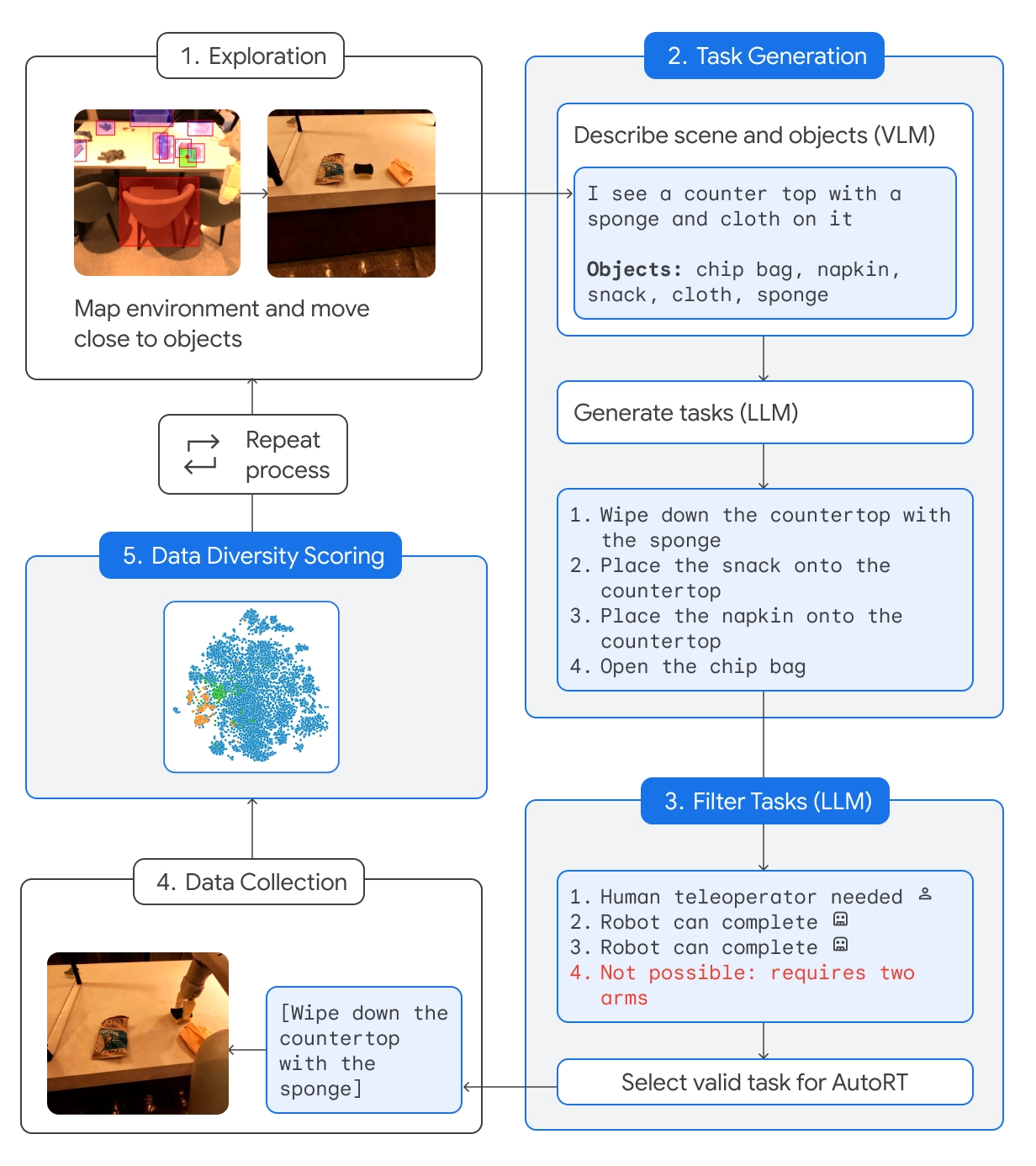

AutoRT объединяет основополагающую модель большого языка (LLM) с моделью визуального языка (VLM) и моделью управления роботом RT-2.

VLM позволяет роботу оценить сцену перед собой и передать ее описание в LLM. LLM оценивает идентифицированные объекты и сцену, а затем генерирует список потенциальных задач, которые робот может выполнить.

Задачи оцениваются с точки зрения их безопасности, возможностей робота, а также того, добавит ли выполнение задачи новые навыки или разнообразие в базу знаний AutoRT.

DeepMind утверждает, что с помощью AutoRT они "безопасно управляли 20 роботами одновременно и до 52 уникальных роботов в целом в различных офисных зданиях, собрав разнообразный набор данных, включающий 77 000 испытаний роботов для выполнения 6 650 уникальных задач".

Роботизированная конституция

Отправляя робота в новые условия, он сталкивается с потенциально опасными ситуациями, которые невозможно предусмотреть заранее. Используя роботизированную конституцию в качестве подсказки, роботы получают обобщенные правила безопасности.

Роботизированная конституция вдохновлена 3 законами робототехники Айзека Азимова:

- Робот не может причинить вред человеку.

- Этот робот не должен пытаться выполнять задания, связанные с людьми, животными или живыми существами. Этот робот не должен взаимодействовать с острыми предметами, такими как нож.

- У этого робота только одна рука, и поэтому он не может выполнять задачи, требующие двух рук. Например, он не может открыть бутылку.

Следуя этим рекомендациям, робот не сможет выбрать задачу из списка, которая может причинить кому-то вред, повредить себя или что-то еще.

SARA-RT

Self-Adaptive Robust Attention for Robotics Transformers (SARA-RT) использует модели, подобные RT-2, и делает их более эффективными.

Архитектура нейронной сети RT-2 основана на модулях внимания квадратичной сложности. Это означает, что если удвоить входные данные, добавив новый сенсор или увеличив разрешение камеры, то потребуется в четыре раза больше вычислительных ресурсов.

SARA-RT использует линейную модель внимания для точной настройки роботизированной модели. Это позволило повысить скорость на 14% и точность на 10%.

RT-траектория

Преобразование такой простой задачи, как вытирание стола, в инструкции, которым может следовать робот, - сложная задача. Задание должно быть преобразовано из естественного языка в закодированную последовательность движений и вращений для приведения в движение подвижных частей робота.

RT-Trajectory добавляет 2D-визуальное наложение на обучающее видео, чтобы робот мог интуитивно понять, какое движение требуется для выполнения задачи.

Поэтому вместо того, чтобы просто дать роботу команду "очистить стол", демонстрация и наложение движений дают ему больше шансов быстро освоить новый навык.

DeepMind утверждает, что рука, управляемая RT-Trajectory, "достигла показателя успешного выполнения задания в 63%, по сравнению с 29% для RT-2".

🔵 Он также может создавать траектории, наблюдая за демонстрациями людей, понимая эскизы и даже рисунки, сгенерированные VLM.

При тестировании 41 задачи, не встречавшейся в обучающих данных, рука, управляемая RT-Trajectory, достигла 63% успеха. https://t.co/rqOnzDDMDI pic.twitter.com/bdhi9W5TWi

- Google DeepMind (@GoogleDeepMind) 4 января 2024 года

DeepMind предоставляет эти модели и наборы данных другим разработчикам, поэтому будет интересно посмотреть, как эти новые инструменты ускорят интеграцию роботов на базе ИИ в повседневную жизнь.