Mistral AI - французский ИИ-стартап, который привлекает внимание своими легкими моделями с открытым исходным кодом. Вместе с вниманием к нему пришла и новая порция финансирования: на этой неделе компания получила инвестиции в размере 385 млн евро, или $414 млн.

Второй раунд финансирования компании возглавили венчурные фирмы Andreessen Horowitz и Lightspeed Venture Partners.

Спор о моделях с открытым исходным кодом и проприетарных моделях продолжается, и Mistral AI твердо стоит на стороне открытого исходного кода.

Такие компании, как OpenAI, уже критикуют за нагнетание страха Многие утверждают, что безопасность моделей с открытым исходным кодом - дело рук Больших Технологий, которые пытаются сохранить свою гегемонию.

Компания Mistral AI утверждает, что, обучая собственные модели, "открыто публикуя их и поощряя вклад сообщества, мы сможем создать надежную альтернативу зарождающейся олигополии ИИ. Открытые генеративные модели будут играть ключевую роль в грядущей революции ИИ".

Несколько крупных инвесторов подтвердили свою уверенность в этой стратегии. Финансирование, полученное Mistral AI на этой неделе, оценивает компанию в $2 миллиарда. Это 7-кратный рост стоимости за шесть месяцев с момента запуска компании.

Mixtral 8x7B

В сентябре был выпущен Mistral 7B, небольшой, но мощный LLM от Mistral AI, который превзошел или сравнялся с более крупными моделями с открытым исходным кодом, такими как Ллама Мета 2 34B.

Собственные модели GPT от OpenAI по праву считаются золотым стандартом при сравнении производительности моделей. С новой моделью Mistral AI, Mixtral 8x7BВ этом отношении компания получила значительные права на похвалу.

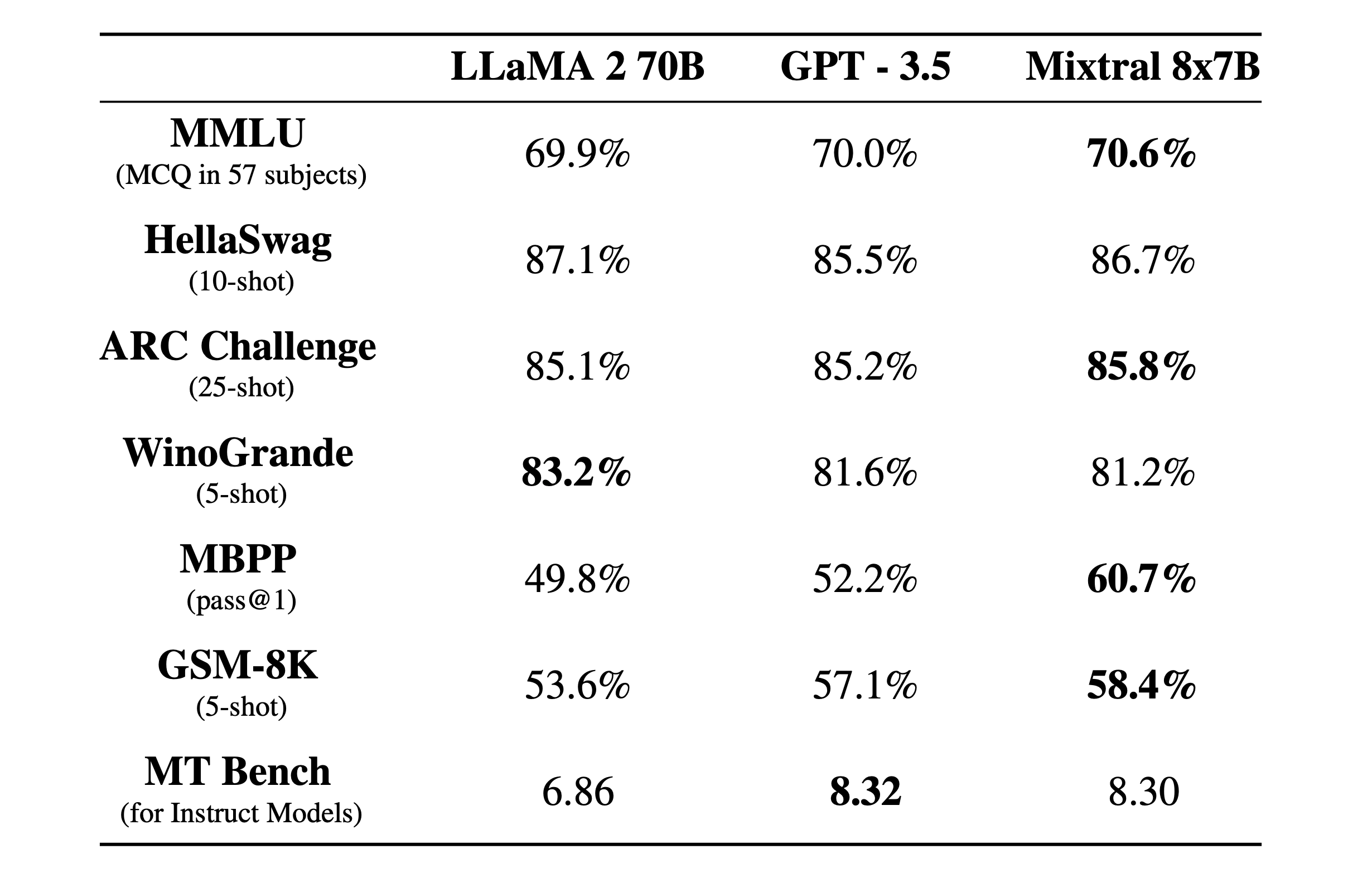

Mixtral 8x7B - это разреженная смесь экспертов модель с 32-килобайтным контекстным окном. Вот как она показала себя в бенчмарк-тестах по сравнению с Llama 2 и GPT-3.5.

Эталонные тесты - хороший способ получить представление о том, насколько хорошо модель справляется с различными функциями. Выше были приведены тесты:

- MMLU (MCQ по 57 предметам): Обозначает вопросы с несколькими вариантами ответов по 57 предметам.

- HellaSwag (10 выстрелов): Оценивает способность ИИ предсказать окончание сценария, если ему дано 10 примеров.

- ARC Challenge (25 выстрелов): Проверяет понимание ИИ научных концепций и рассуждений после того, как ему дается 25 примеров, на которых он должен учиться перед испытанием.

- WinoGrande (5 выстрелов): Проверяет здравый смысл, основанный на разрешении двусмысленностей в предложениях, с 5 примерами, на которых ИИ может учиться.

- MBPP (pass@1): Проверяет способность модели искусственного интеллекта генерировать правильные фрагменты кода на языке Python. Метрика pass@1 измеряет процент задач, в которых первое завершение модели было правильным.

- GSM-8K (5 выстрелов): Эталон Grade School Math 8K проверяет способность ИИ решать математические задачи на уровне, ожидаемом в начальной школе, после того как ему предоставили 5 примеров.

- MT Bench (для Instruct Models): Machine Translation Benchmark for Instruct Models измеряет, насколько хорошо ИИ может следовать инструкциям в контексте задач перевода.

Что еще более впечатляет, чем результаты эталонных тестов, так это то, насколько Mixtral 8x7B мал и эффективен. Эту модель можно запустить локально на приличном ноутбуке с 32 ГБ оперативной памяти.

Имея в своем распоряжении гораздо больше денег, мы можем ожидать от Mistral AI интересных разработок.