Для обучения моделей ИИ, подобных GPT-4, в основном использовались наборы данных, состоящие из текста и изображений. Мультимодальный набор данных восприятия Ego-Exo4D компании Meta предоставляет специалистам по исследованию данных новый богатый набор обучающих данных.

Вы можете научиться новому навыку, прочитав книгу, но гораздо проще, когда кто-то показывает вам, как это делается, и одновременно объясняет. Именно такую цель ставит перед собой команда FAIR (Fundamental Artificial Intelligence Research) компании Meta, создавая Ego-Exo4D.

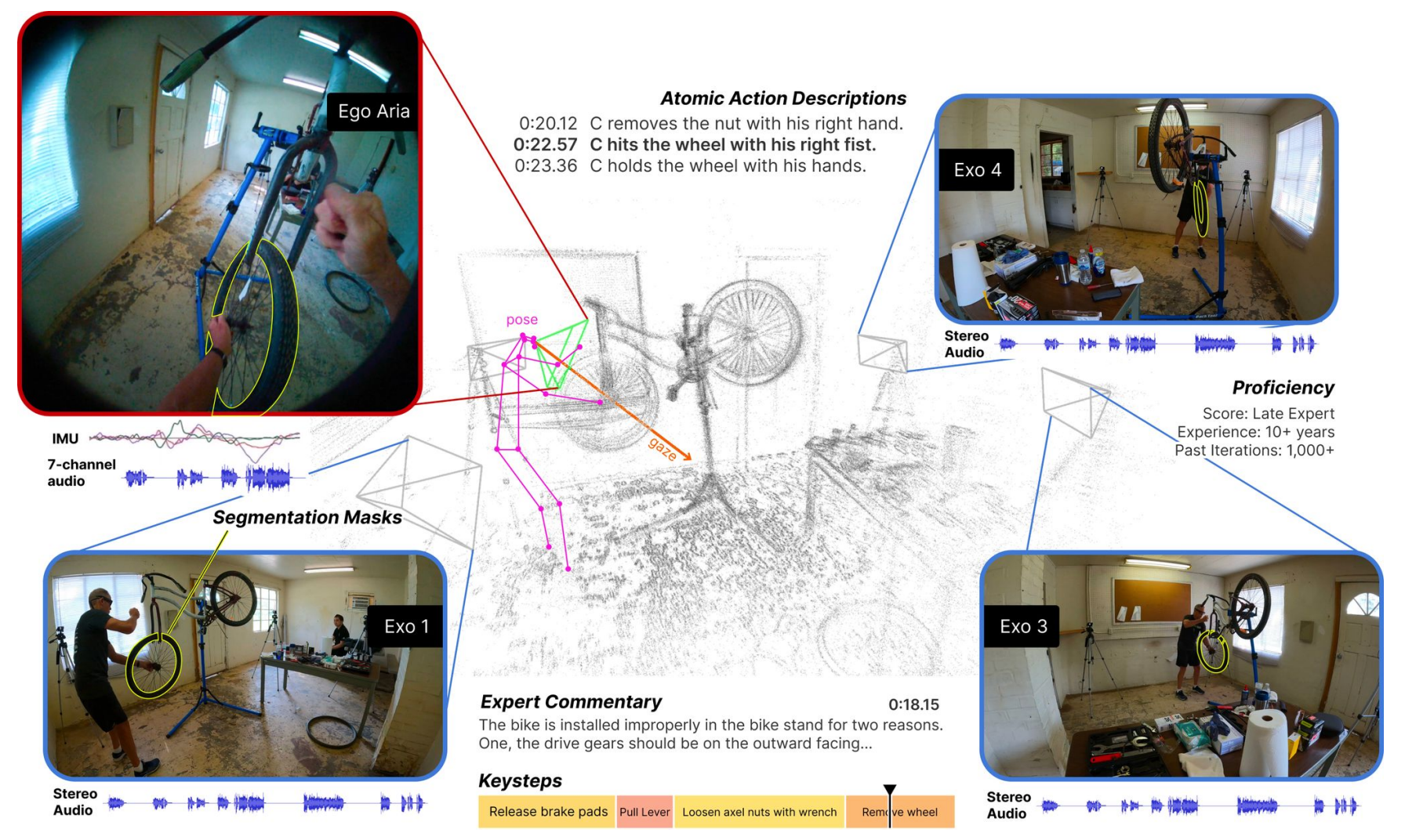

Набор данных состоит из видеороликов с перспективой от первого лица (Ego) и от третьего лица (Exo), на которых люди выполняют различные виды квалифицированной человеческой деятельности. Это может быть что угодно: приготовление пищи, танцы, игра на музыкальных инструментах или ремонт велосипеда. Данные были собраны в 13 городах по всему миру 839 пользователями камер, которые записали 1422 часа видео.

Видео, снятые одновременно, затем дополняются дополнительными данными благодаря очкам Project Aria от Meta.

Очки Project Aria - это носимые компьютеры в форме очков. Они записывают видео и аудио, а также отслеживают движение глаз и информацию о местоположении пользователя. Очки также воспринимают позу головы и 3D-облака точек окружающей среды.

В результате получился набор данных, состоящий из одновременных видеозаписей выполнения задачи, с описанием действий от первого лица владельцами камер, а также отслеживанием головы и глаз человека, выполняющего задачу.

Представляем Ego-Exo4D - основополагающий набор данных и набор эталонов, ориентированных на квалифицированную человеческую деятельность, для поддержки исследований в области видеообучения и мультимодального восприятия. Это крупнейший публичный набор данных такого рода.

Подробнее ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI at Meta (@AIatMeta) 4 декабря 2023 года

Затем Meta добавила описания действий каждого пользователя камеры от третьего лица. Meta также наняла экспертов в различных областях, чтобы они добавили комментарии экспертов от третьего лица с критикой того, как человек на видео выполняет задание.

Собирая эгоцентрические и экзоцентрические виды, набор данных Ego-Exo4D может показать исследователям, как выглядят действия человека с разных точек зрения. Это может помочь им в разработке алгоритмов компьютерного зрения, способных распознавать действия человека с любой точки зрения.

Ego-Exo4D открывает новые возможности для обучения

Одним из ключевых препятствий на пути к созданию AGI или более эффективному обучению роботов является недостаток сенсорного восприятия, которым обладают компьютеры. У нас, как у людей, очень много сенсорных данных из окружающей среды, которые мы часто воспринимаем как должное при освоении новых навыков.

Ego-Exo4D станет чрезвычайно полезным ресурсом, который поможет преодолеть этот пробел.

Доктор Гедас Бертасиус, доцент кафедры компьютерных наук Университета Северной Каролины, сказал: "Ego-Exo4D - это не просто сбор данных, это изменение того, как ИИ понимает, воспринимает и учится. Благодаря ориентированному на человека обучению и перспективам ИИ может стать более полезным в нашей повседневной жизни, помогая нам так, как мы только можем себе представить".

Компания Meta надеется, что Ego-Exo4D "позволит роботам будущего получать представление о сложных ловких манипуляциях, наблюдая за работой опытных специалистов".

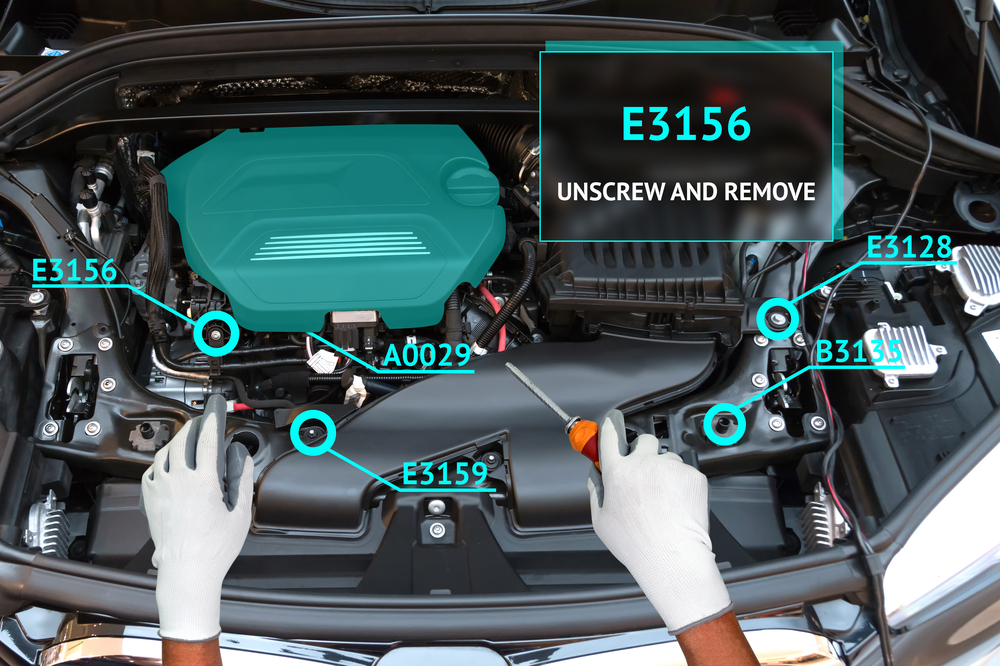

Этот набор данных в сочетании с очками Project Aria в скором времени также позволит создать по-настоящему иммерсивный опыт обучения для людей. Представьте, что вы выполняете задание, а ваши очки с помощью дополненной реальности (AR) накладывают на него обучающее видео или рассказывают о выполнении задания.

Вы можете учиться играть на фортепиано, и визуальное наложение покажет вам, куда должны двигаться ваши руки, а аудиосоветы будут звучать в реальном времени, пока вы это делаете. Или вы можете открыть капот своего автомобиля и получить руководство по поиску и устранению неполадок в двигателе.

Будет интересно посмотреть, будет ли Мета Концепция обучения Ego How-To будет способствовать более широкому распространению очков Project Aria, чем неудачный продукт Google Glass. О том, когда их можно будет приобрести, пока ничего не известно.

Мета создаст набор данных Ego-Exo4D доступен для скачивания до конца декабря.