Элон Маск объявил о запуске бета-версии чат-бота xAI под названием Grok, и первые данные дают нам представление о том, насколько он превосходит другие модели.

Сайт Чатбот Grok В основе лежит пограничная модель xAI под названием Grok-1, которую компания разрабатывала в течение последних четырех месяцев. xAI не сообщила, на каком количестве параметров она была обучена, но назвала некоторые цифры для своего предшественника.

Grok-0, прототип текущей модели, был обучен на 33 миллиардах параметров, поэтому мы можем предположить, что Grok-1 был обучен как минимум на таком же количестве.

Это не так много, но xAI утверждает, что производительность Grok-0 "приближается к возможностям LLaMA 2 (70B) в стандартных бенчмарках LM", хотя при этом было использовано вдвое меньше ресурсов для обучения.

В отсутствие данных о параметрах мы вынуждены верить компании на слово, когда она описывает Grok-1 как "ультрасовременный" и что он "значительно мощнее" Grok-0.

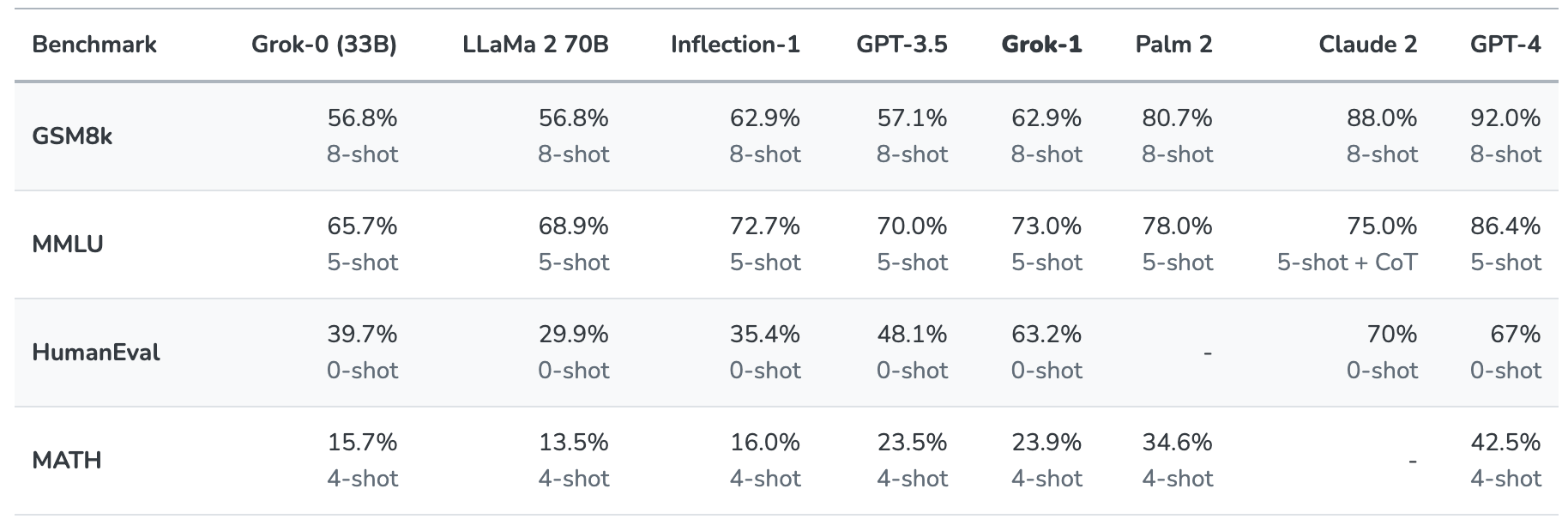

Grok-1 испытали на прочность, оценив его на этих стандартных эталонах машинного обучения:

- GSM8k: Задачи по математике для средней школы

- MMLU: Мультидисциплинарные вопросы с несколькими вариантами ответов

- HumanEval: задача по завершению кода на языке Python

- MATH: задачи по математике для средней и старшей школы, написанные в LaTeX

Вот краткое описание результатов.

Результаты интересны тем, что дают нам хотя бы некоторое представление о том, как Grok сравнивается с другими моделями границ.

xAI утверждает, что эти цифры показывают, что Grok-1 выигрывает "у всех других моделей в своем вычислительном классе" и выигрывает только у моделей, обученных на "значительно большем объеме обучающих данных и вычислительных ресурсов".

GPT-3.5 имеет 175 миллиардов параметров, поэтому можно предположить, что у Grok-1 их меньше, но, скорее всего, больше, чем 33 миллиарда у его прототипа.

Чатбот Grok предназначен для решения таких задач, как ответы на вопросы, поиск информации, написание творческих текстов и помощь в кодировании. Из-за меньшего контекстного окна он скорее всего будет использоваться для более коротких взаимодействий, чем для супербыстрых задач.

При длине контекста 8 192 Grok-1 имеет только половину контекста, который есть у GPT-3.5. Это указывает на то, что xAI, вероятно, предполагал, что Grok-1 будет обменивать более длинный контекст на более высокую эффективность.

Компания говорит, что некоторые из ее текущих исследований сосредоточены на "понимании и извлечении длинных контекстов", поэтому следующая итерация Grok вполне может иметь более широкое контекстное окно.

Точный набор данных, который использовался для обучения Grok-1, неизвестен, но почти наверняка он включал ваши твиты на сайте X. Кроме того, чатбот Grok имеет доступ к интернету в режиме реального времени.

Мы должны дождаться отзывов бета-тестеров, чтобы получить реальное представление о том, насколько хороша эта модель на самом деле.

Поможет ли Grok разгадать тайны жизни, Вселенной и всего остального? Возможно, пока нет, но начало будет интересным.