Исследователи из Чикагского университета разработали новый инструмент для "отравления" моделей ИИ, когда ИИ-компании включают изображения в свои наборы данных без согласия.

Такие компании, как OpenAI и Meta, столкнулись с критикой и судебными исками в связи с тем, что для обучения своих моделей они массово используют онлайн-контент. Чтобы генераторы текста в изображение, такие как DALL-E или Midjourney, были эффективными, их нужно обучать на больших объемах визуальных данных.

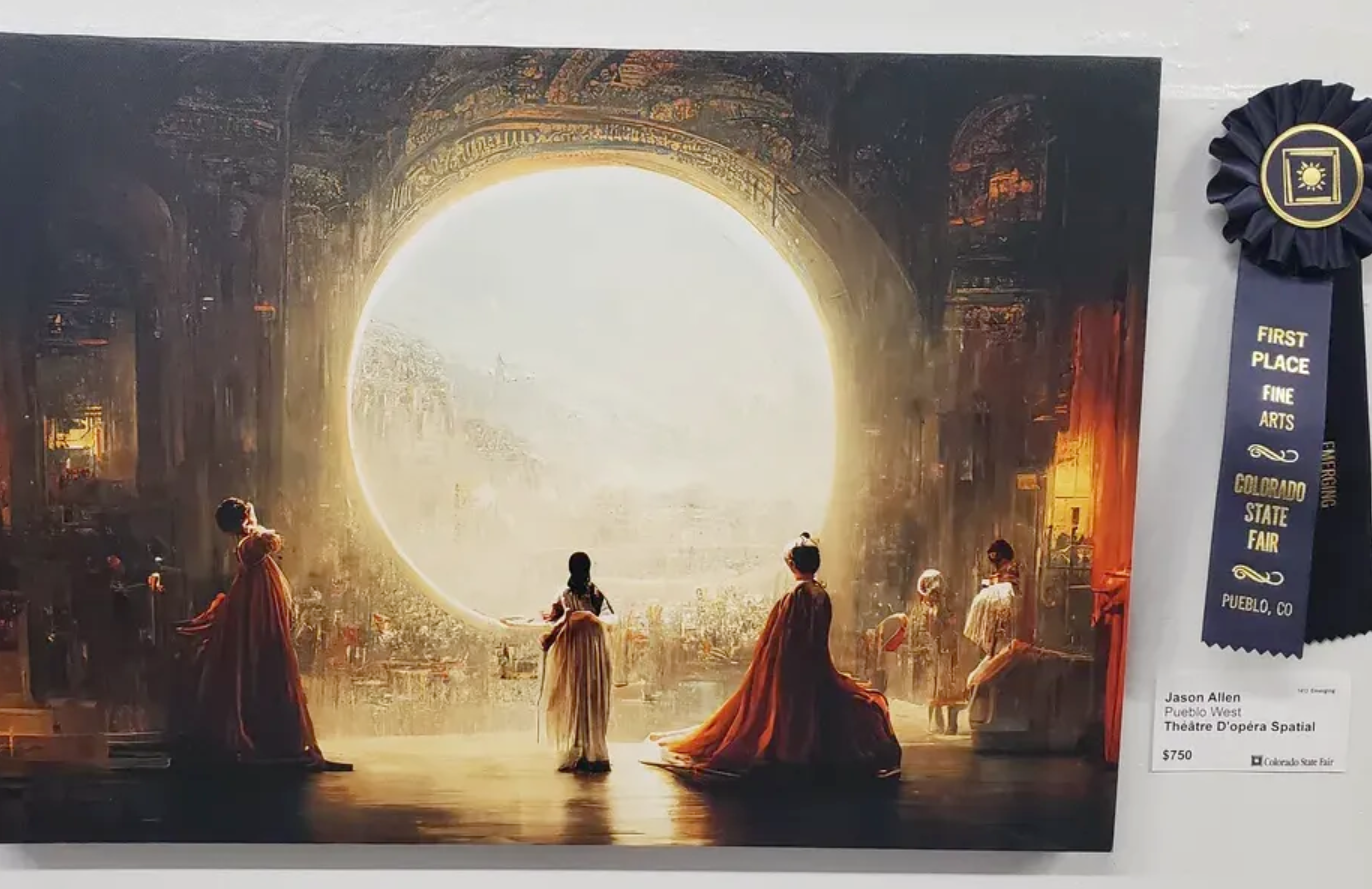

Ряд художники жаловались на то, что эти генераторы изображений теперь могут создавать изображения в их стиле после того, как они без согласования с ними скрапили их творчество.

Сайт исследователи создали Nightshade - инструмент, встраивающий в изображение невидимые пиксели, которые впоследствии делают его "ядовитым" для моделей искусственного интеллекта.

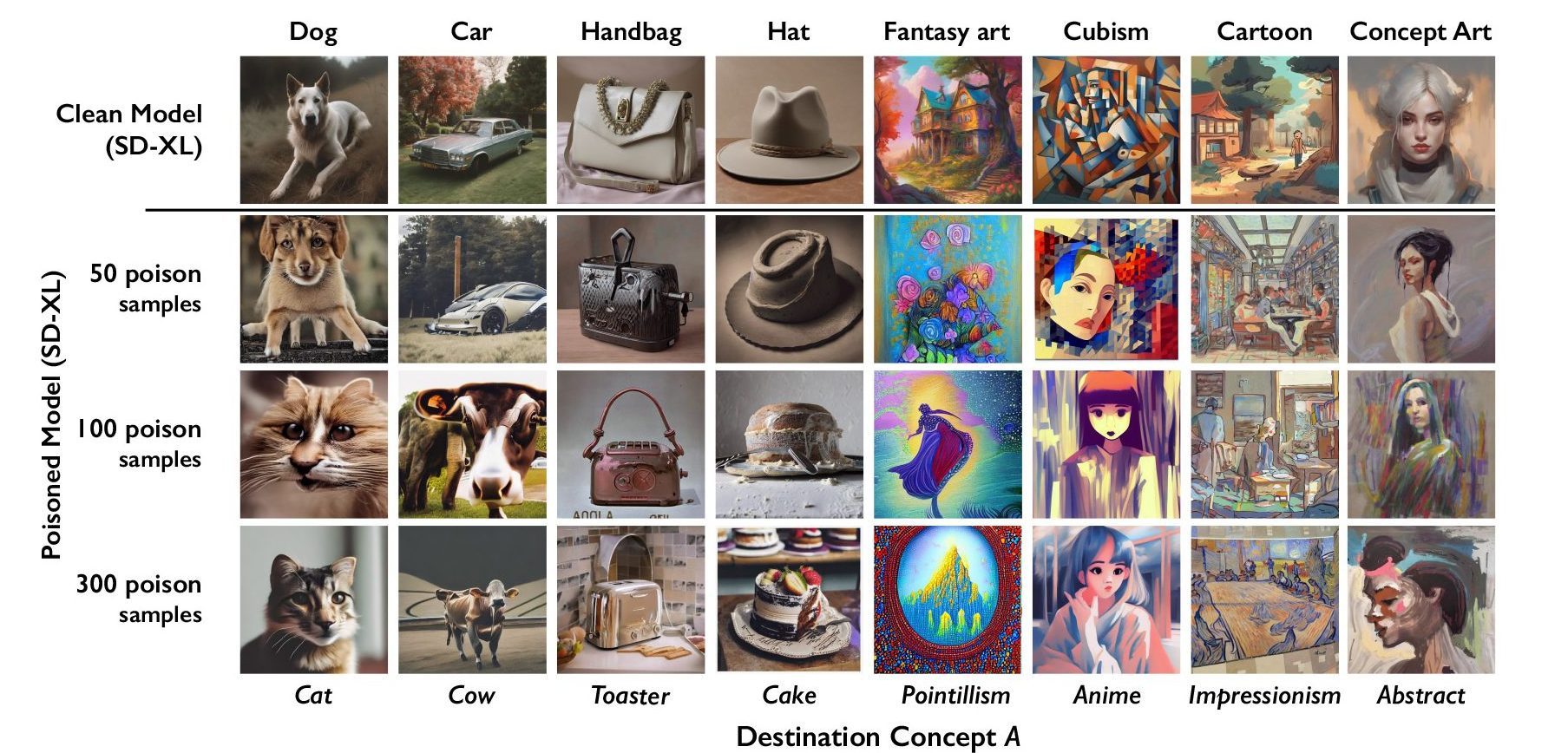

Генеративный ИИ опирается на правильно помеченные данные. Если модель искусственного интеллекта обучена на тысячах изображений кошек и все изображения помечены как "кошка", то она знает, как должна выглядеть кошка, когда вы попросите ее сгенерировать изображение кошки.

Nightshade встраивает в изображение данные, которые нарушают классификацию изображения. Так, например, изображение замка, отравленного Nightshade, может быть классифицировано как старый грузовик. Исследователи обнаружили, что использование всего 100 изображений, нацеленных на одну подсказку, позволяет эффективно испортить модель.

Nightshade - плохая новость для генераторов изображений с искусственным интеллектом

Модель, пораженную отравленными данными, можно заставить думать, что изображения тортов - это шляпы, а тостеров - сумочки. Помимо того, что Nightshade повреждает конкретное слово, на которое нацелилась, она также заражает более широкие понятия. Так, повреждение ярлыка "собака" распространится и на такие понятия, как "щенок".

Если достаточное количество художников начнет использовать Nightshade, это может заставить компании более тщательно подходить к вопросу получения согласия на использование изображений.

Команда исследователей включит Nightshade в разработанный ими инструмент Glaze. Glaze неверно определяет стиль изображения. Например, художник, желающий защитить стиль своей работы, может использовать Glaze, чтобы обозначить ее как "импрессионистскую", в то время как на самом деле это "поп-арт".

Тот факт, что такие инструменты, как Nightshade, работают настолько эффективно, подчеркивает уязвимость в генераторах текста в изображение, которые могут быть использованы злоумышленниками.

Такие компании, как OpenAI и Stability AI, заявляют, что будут уважать Отказ от использования "не соскабливать которые сайты могут добавлять в свои файлы robots.txt. Если изображения, отравленные Nightshade, не соскабливаются, то модели остаются незатронутыми.

Однако злоумышленники могут отравить большое количество изображений и сделать их доступными для соскабливания с целью повреждения моделей ИИ. Единственный способ обойти это - использовать более совершенные детекторы маркировки или человеческий обзор.

Nightshade поможет художникам чувствовать себя немного увереннее при размещении своего контента в сети, но может создать серьезные проблемы для генераторов изображений AI.