Исследователи представили FANToM, новый бенчмарк, предназначенный для тщательного тестирования и оценки понимания и применения теории разума (Theory of Mind, ToM) большими языковыми моделями (LLM).

Теория разума - это способность приписывать убеждения, желания и знания себе и другим, а также понимание того, что убеждения и взгляды других людей отличаются от собственных.

ОМ рассматривается как основа сознания, которым обладают разумные животные. Помимо людей, считается, что приматы, такие как орангутанги, гориллы и шимпанзе, а также некоторые не-приматы, такие как попугаи и представители семейства корвидов (вороны), обладают ОМ.

По мере того как модели ИИ становятся все более сложными, исследователи ИИ ищут новые методы оценки таких способностей, как ToM.

Новый бенчмарк под названием FANToMСозданная исследователями из Института искусственного интеллекта Аллена, Вашингтонского университета, Университета Карнеги-Меллон и Сеульского национального университета, модель машинного обучения подвергается динамическим сценариям, отражающим реальное взаимодействие.

В FANToM персонажи вступают в разговоры и выходят из них, что ставит перед моделями искусственного интеллекта задачу точно определить, кто что знает в каждый конкретный момент.

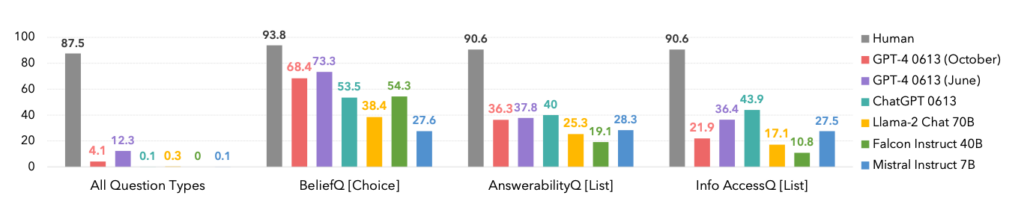

Испытание больших языковых моделей (LLM) на FANToM показало, что даже самые продвинутые модели испытывают трудности с поддержанием последовательного ToM.

Производительность моделей была значительно ниже, чем у людей, что подчеркивает недостатки ИИ в понимании и навигации по сложным социальным взаимодействиям.

Как показано ниже, люди доминировали в каждой категории.

Интересным моментом является то, что октябрьская версия модели GPT-4 превзошла более раннюю июньскую, что может подтвердить недавние анекдоты среди пользователей о том, что ChatGPT становится все хуже.

FANToM также выявил методы улучшения LLM ToM, такие как рассуждения по цепочке мыслей и другие методы тонкой настройки.

Тем не менее, разрыв между навыками ИИ и человека в области ToM остается высоким.

Искусственный интеллект достиг уровня владения человеческим языком

В несколько смежном, но отдельном исследование, опубликованное в журнале NatureУченые разработали нейронную сеть, способную обобщать язык, подобный человеческому.

Эта новая нейронная сеть продемонстрировала впечатляющую способность интегрировать вновь выученные слова в свой словарный запас. Затем она может использовать эти слова в различных контекстах - этот когнитивный навык известен как систематическое обобщение.

Люди от природы демонстрируют систематическое обобщение, легко включая новую лексику в свой репертуар.

Например, узнав термин "фотобомба", человек может практически сразу же применить его в различных ситуациях. Новый сленг появляется постоянно, и люди естественным образом впитывают его в свой словарный запас.

Исследователи подвергли нейронную сеть ChatGPT и собственную нейронную сеть серии тестов и обнаружили, что ChatGPT отстает по производительности от собственной модели.

Хотя LLM, подобные ChatGPT, отлично справляются со многими сценариями разговора, в других они демонстрируют заметные несоответствия и пробелы, и именно эту проблему решает новая нейронная сеть.

Чтобы изучить этот аспект языковой коммуникации, ученые провели эксперимент с участием 25 человек, оценивая их способность применять недавно выученные слова в различных контекстах. Испытуемых знакомили с псевдоязыком, состоящим из бессмысленных слов, обозначающих различные действия и правила.

После тренировочного этапа участники отлично применяли эти абстрактные правила в новых ситуациях, демонстрируя систематическое обобщение.

Когда вновь созданная нейронная сеть выполняла это задание, она повторяла человеческие показатели. Однако, когда ChatGPT подвергался тем же испытаниям, он испытывал значительные трудности, терпя неудачу от 42 до 86% раз, в зависимости от конкретной задачи.

Это важно по двум причинам. Во-первых, можно утверждать, что новая нейронная сеть эффективно превзошла GPT-4 в решении этой конкретной задачи, что достаточно впечатляет. Во-вторых, это исследование раскрывает новые методы обучения моделей ИИ обобщению нового языка, как у людей.

Элиа Бруни, специалист по обработке естественного языка из Университета Оснабрюка в Германии, говорит: "Привнесение систематичности в нейронные сети - это большое дело".

Вместе эти два исследования предлагают новые подходы к обучению более интеллектуальных моделей ИИ, которые смогут соперничать с человеком в таких важных областях, как лингвистика и теория разума.