То, как именно наш мозг обрабатывает и формулирует язык, до сих пор остается загадкой. Исследователи из Meta AI нашли новый способ измерения мозговых волн и расшифровки связанных с ними слов.

Людям с сильно ограниченной моторикой, например, страдающим ALS, особенно сложно общаться. Трудно представить себе разочарование такого человека, как Стивен Хокинг, старательно строящего предложение с помощью движений глаз или подергивания щечной мышцы.

Было проведено множество исследований, чтобы декодирование речи по активности мозгано наилучшие результаты зависят от инвазивности Имплантаты "мозг-компьютер".

Исследователи Meta AI использовали магнитоэнцефалографию (МЭГ) и электроэнцефалографию (ЭЭГ) для записи мозговых волн 175 добровольцев, когда они слушали короткие истории и изолированные предложения.

Они использовали предварительно обученную речевую модель и контрастное обучение, чтобы определить, какие модели мозговых волн ассоциируются с конкретными словами, которые слушали испытуемые.

Расшифровка восприятия речи по неинвазивным записям мозга,

под руководством единственного и неповторимого @honualx

только что вышла в последнем номере журнала Nature Machine Intelligence:- документ с открытым доступом: https://t.co/1jtpTezQzM

- полный код обучения: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Жан-Реми Кинг (@JeanRemiKing) 5 октября 2023 года

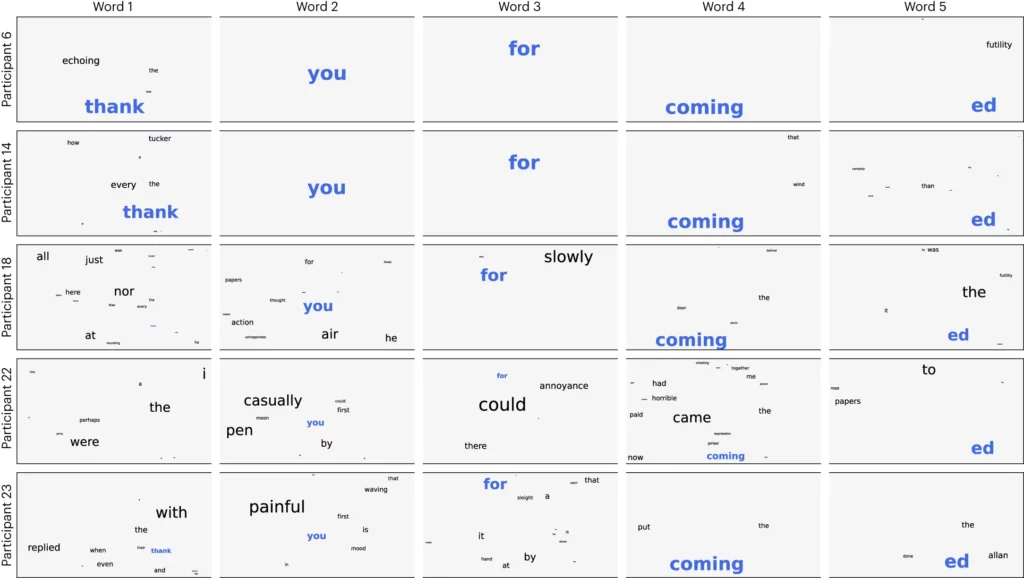

Исследователи разделили аудио на 3-секундные сегменты, а затем протестировали свою модель, чтобы проверить, сможет ли она правильно определить, какой из 1500 сегментов слушает доброволец. Модель предсказала своего рода облако слов, в котором наиболее вероятное слово имело наибольший вес.

Они достигли точности в 41% в среднем и 95,9% точности с лучшими участниками.

Исследование показало, что можно получить достаточно хорошее представление о том, какую речь слышит человек, но теперь, чтобы сделать это полезным, необходимо изменить процесс. Нам нужно измерить их мозговые волны и узнать, о каком слове они думают.

В статье предлагается обучать нейронную сеть, пока испытуемые произносят слова в устной или письменной форме. Затем эта общая модель может быть использована для анализа мозговых волн и связанных с ними слов, о которых думает больной ALS.

Исследователи смогли идентифицировать сегменты речи из ограниченного заранее набора. Для полноценного общения необходимо уметь распознавать гораздо больше слов. Использование генеративного ИИ для предсказания следующего наиболее вероятного слова, которое человек пытается произнести, может помочь в этом.

Несмотря на то, что процесс неинвазивный, он все равно требует подключения к Устройство МЭГ. К сожалению, результаты измерений ЭЭГ были не очень хорошими.

Исследование показывает, что ИИ может быть использован для помощи в общении людям, лишенным голоса, например, страдающим ALS. Использование предварительно обученной модели также позволило избежать необходимости более кропотливого обучения по словам.

Meta AI опубликовала модель и данные в открытом доступе, так что надеемся, что другие исследователи будут использовать их наработки.