На прошлой неделе Институт технологических инноваций ОАЭ (TII) выпустил свой Falcon 180B LLM на Hugging Face, который продемонстрировал впечатляющие характеристики на ранних испытаниях.

Модель с открытым доступом для исследователей и коммерческих пользователей является продуктом бурно развивающейся индустрии ИИ на Ближнем Востоке.

Falcon 180B в 2,5 раза больше, чем Meta Ллама 2 и была обучена с помощью в 4 раза большего количества вычислений. TII обучил модель на огромном массиве в 3,5 триллиона токенов. Именно уникальный подход к набору данных во многом объясняет впечатляющую производительность модели.

Чтобы обучить модель, вам нужно не просто много данных, вам, как правило, нужно много курируемых данных хорошего качества. Их производство стоит немалых денег, а в открытом доступе не так уж много действительно больших наборов данных. В TII решили применить новый подход, чтобы избежать необходимости курирования.

В июне исследователи использовали тщательная фильтрация и дедупликация общедоступных данных CommonCrawl для создания набора данных RefinedWeb. Этот набор данных не только легче создать, но он обеспечивает более высокую производительность, чем просто использование курируемых корпораций или веб-данных.

Falcon 180B был обучен на огромном наборе данных RefinedWeb объемом 3,5 триллиона лексем, что значительно больше, чем 2 триллиона лексем из набора данных предварительного обучения Llama 2.

Характеристики Falcon 180B

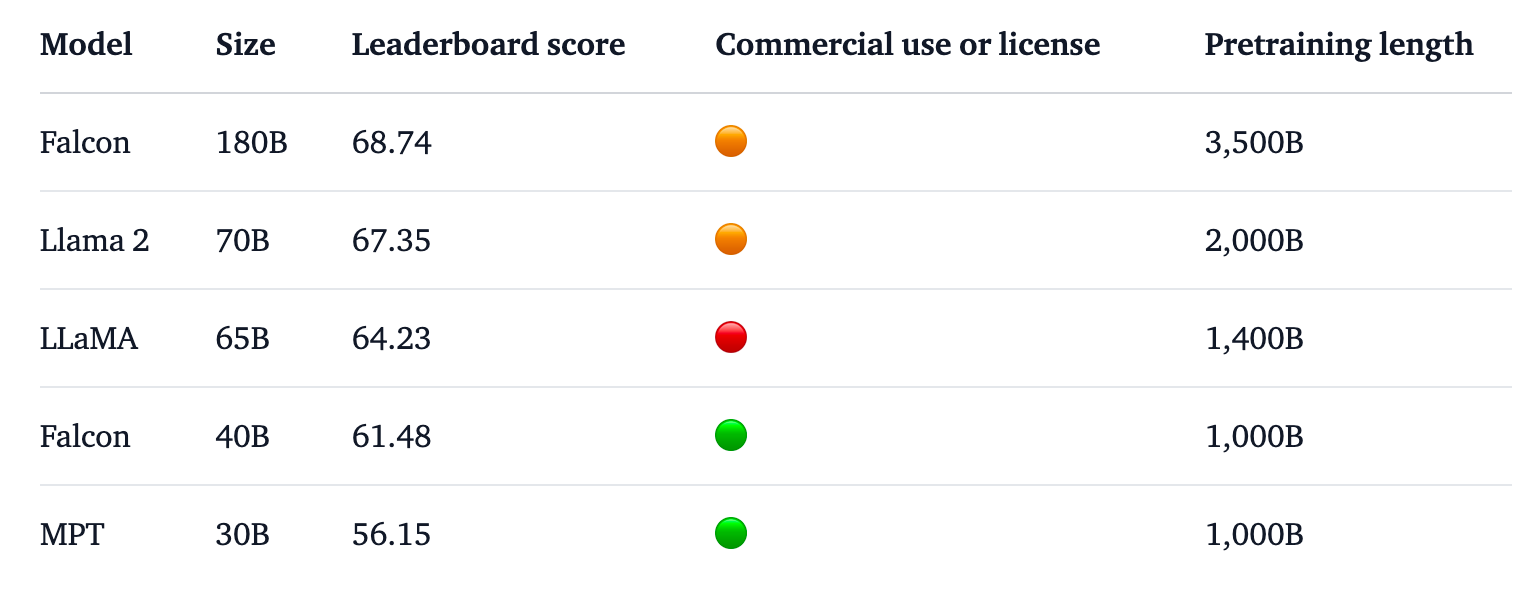

Falcon 180B возглавляет таблицу лидеров Hugging Face для LLM с открытым доступом. Модель превзошла Llama 2, предыдущего лидера, по ряду показателей, включая тесты на рассуждения, кодирование, квалификацию и знания.

Falcon 180B даже получил высокие оценки при сравнении с закрытыми проприетарными моделями. Она занимает место сразу после GPT-4 и находится на одном уровне с PaLM 2 Large от Google, которая в два раза больше Falcon 180B.

Источник: Обнимающееся лицо

TII заявляет, что, несмотря на впечатляющую производительность своей предварительно обученной модели, она намерена "предоставить в будущем все более мощные версии Falcon, основанные на улучшенных наборах данных и RLHF/RLAIF".

Вы можете опробовать чат-версию модели, используя следующее Демонстрационный образец Falcon 180B на обнимающемся лице.

Версия для чата прошла тонкую настройку и санитарную обработку, но базовая модель еще не имеет защитных ограждений для выравнивания. В TII заявили, что, поскольку она еще не прошла процесс тонкой настройки и выравнивания, она может выдавать "проблемные" ответы.

Потребуется некоторое время, чтобы привести его в соответствие с требованиями, позволяющими с уверенностью использовать его в коммерческих целях.

Тем не менее, впечатляющая производительность этой модели подчеркивает возможности для улучшения, помимо простого масштабирования вычислительных ресурсов.

Falcon 180B показывает, что небольшие модели, обученные на качественных наборах данных, могут быть более экономичным и эффективным направлением развития ИИ.

Выпуск этой впечатляющей модели подчеркивает стремительный рост Развитие искусственного интеллекта на Ближнем ВостокеНесмотря на недавние ограничения на экспорт графических процессоров в регион.

Поскольку TII и Meta продолжают выпускать свои мощные модели под лицензией открытого доступа, будет интересно посмотреть, что Google и OpenAI сделают, чтобы стимулировать внедрение своих закрытых моделей.

Разрыв в производительности между моделями, находящимися в открытом доступе, и проприетарными моделями, похоже, сокращается.