Исследование, проведенное психологами Калифорнийского университета, показало, что GPT-3 примерно так же хорошо, как студенты колледжа, решают задачи на рассуждение.

Мы знаем, что LLM, такие как GPT-3, хорошо генерируют ответы на основе данных, которым их обучили, но их способность рассуждать вызывает сомнения. Аналоговые рассуждения - это способность людей брать то, что мы узнали из не связанного с ними опыта, и применять это к проблеме, с которой мы раньше не сталкивались.

Именно на эту способность вы полагаетесь, когда вам нужно ответить на вопрос, с которым вы никогда раньше не сталкивались. Вы можете рассуждать, основываясь на предыдущих решенных проблемах. И, судя по результатам исследования, GPT-3 тоже развивает эту способность.

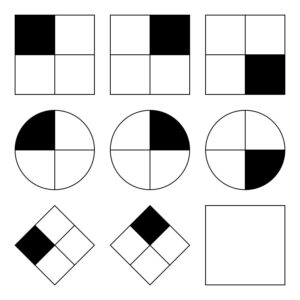

Сайт Исследователи Калифорнийского университета Поставьте GPT-3 для работы над набором проблем, похожих на Прогрессивные матрицы Равена который предполагает предсказание следующего изображения в серии картинок. Вот простой вариант, который вы можете попробовать.

GPT-3 справился с заданием 40 студентов Калифорнийского университета, которым было предложено пройти тот же тест. ИИ давал правильные ответы в 80% случаев, в то время как 40 студентов в среднем давали около 60%. Лучшие студенты набрали примерно столько же баллов, сколько и GPT-3.

Профессор психологии Калифорнийского университета Хунцзин Лу, старший автор исследования, сказал: "Удивительно, но GPT-3 не только работал примерно так же хорошо, как люди, но и совершал похожие ошибки".

Исследователи также попросили GPT-3 решить несколько задач на ассоциацию слов. Например, "Автомобиль" относится к "дороге" так же, как "лодка" к какому слову?". Ответ очевиден - "вода", но такие вопросы могут быть сложными для ИИ.

По крайней мере, исследователи думали, что это может быть непросто. Оказалось, что GPT-3 показал лучшие результаты, чем средние абитуриенты, сдававшие экзамены на аттестат зрелости.

GPT-3 борется с проблемами, которые просты для человека

С чем модели ИИ справляются с трудом, так это с задачами, требующими визуального понимания физического пространства. Если представить GPT-3 список инструментов, таких как молоток, гвоздь и картина, он не сможет найти очевидное решение, как повесить картину на стену.

Человеку легко решать подобные задачи, потому что мы можем видеть, держать и ощущать физические объекты в пространстве, которое занимаем. Благодаря этому опыту наш мозг легко учится и решает проблемы так, как не могут модели ИИ. Тем не менее, GPT-4 сейчас лучше справляется с подобными рассуждениями.

Хотя исследователи смогли измерить производительность GPT-3, они не имеют представления о процессе мышления, которому он следует, чтобы получить ответы. Следует ли он тому же мыслительному процессу, что и люди, или же он делает что-то совершенно иное? Поскольку GPT-3 является закрытой моделью, невозможно заглянуть под капот и понять, что там происходит.

Удивительным результатом этого исследования стало то, что GPT-3, похоже, способен решать новые задачи без какого-либо прямого обучения. Это очень похоже на то, как люди решают новые проблемы. Ожидается, что GPT-4 будет справляться с этими задачами еще лучше, и кто знает, какие еще "мыслительные" способности могут проявиться при дальнейшем тестировании.

Хотя пространственные рассуждения являются сложной задачей для LLM, эти проблемы могут быть решены с помощью визуальных моделей, таких как RT-2 от Google который был недавно анонсирован. Как только модели ИИ начнут "видеть" и физически взаимодействовать с окружающей средой, их возможности по решению проблем будут расти в геометрической прогрессии.