O vídeo da Google que mostrava as capacidades do seu novo modelo Gemini era absolutamente espantoso. Infelizmente, a verdade sobre a qualidade do Gemini e o que ele pode fazer fica aquém da propaganda.

Quando vimos pela primeira vez o vídeo de demonstração que mostrava o Gemini a interagir em tempo real com o apresentador, ficámos maravilhados. Estávamos tão entusiasmados que nos escaparam alguns avisos de isenção de responsabilidade no início e aceitámos o vídeo pelo seu valor nominal.

O texto nos primeiros segundos do vídeo diz: "Temos estado a captar imagens para o testar numa vasta gama de desafios, mostrando-lhe uma série de imagens e pedindo-lhe para raciocinar sobre o que vê".

O que realmente aconteceu nos bastidores é a causa do críticas que o Google recebeu e as questões éticas que levanta.

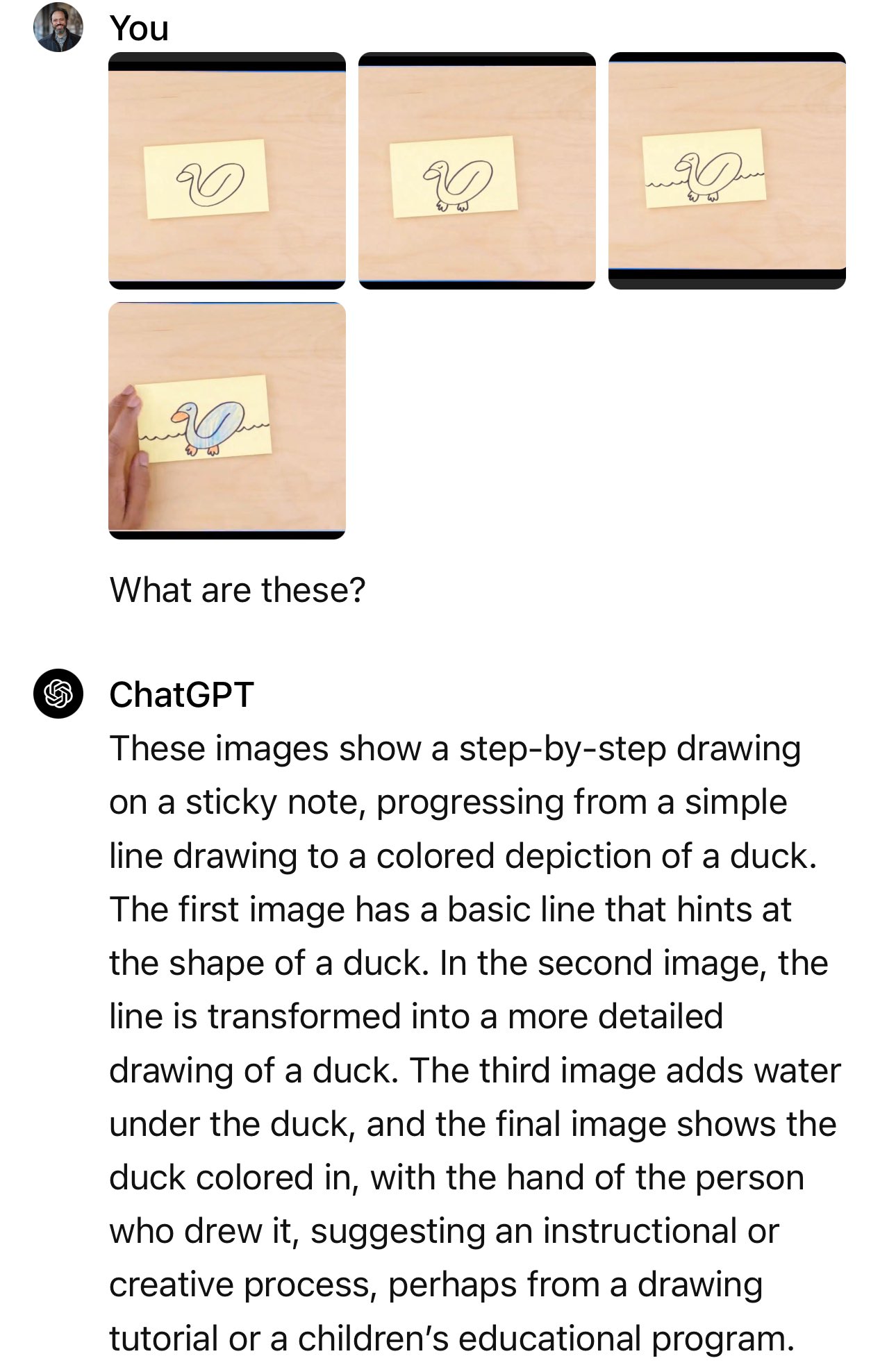

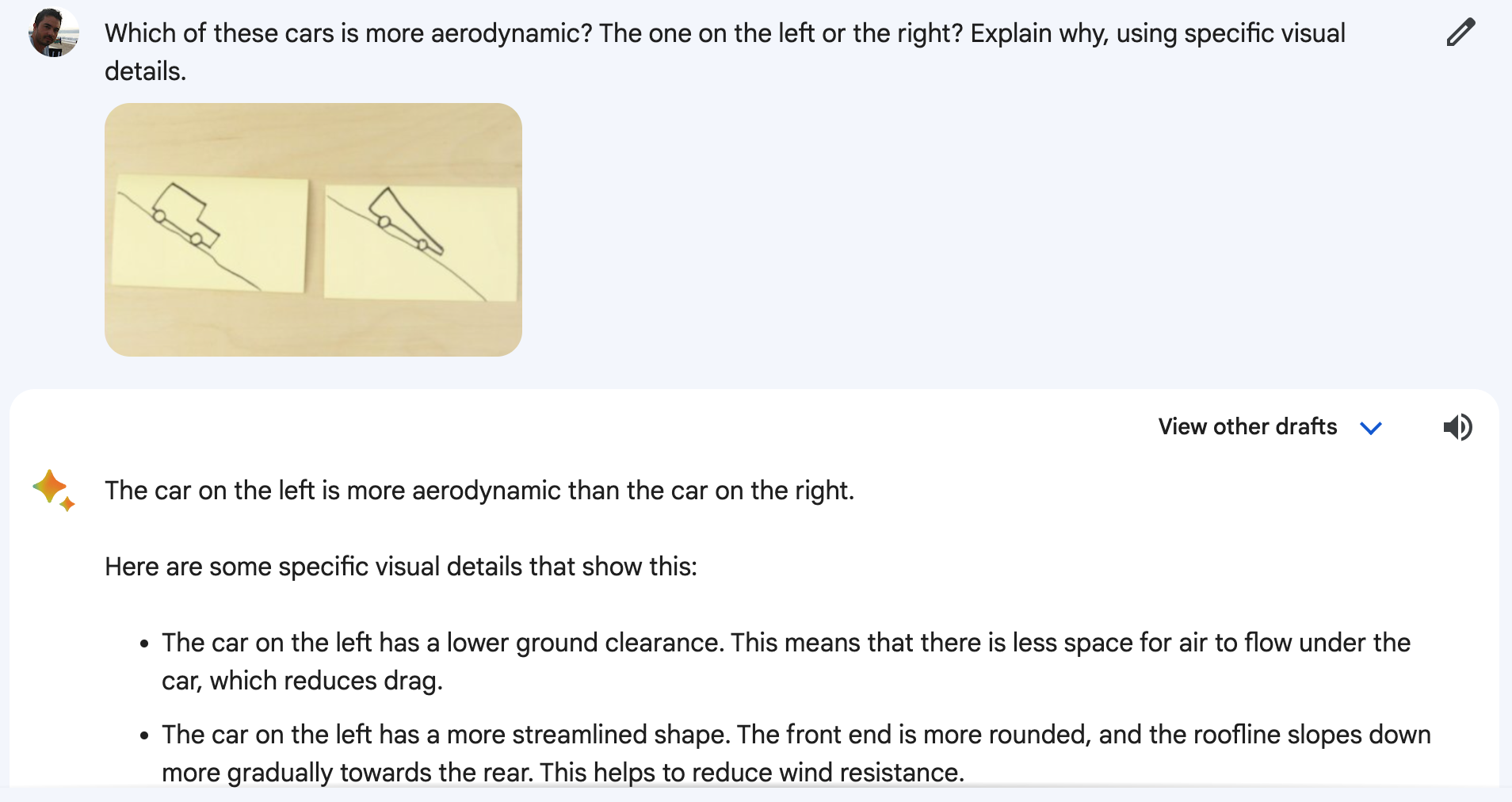

O Gemini não estava a ver um vídeo em direto do apresentador a desenhar um pato ou a mover copos. E também não estava a responder às instruções de voz que ouviu. O vídeo era uma apresentação de marketing estilizada de uma verdade mais simples.

Na realidade, o Gemini foi apresentado com imagens fixas e instruções de texto mais pormenorizadas do que as perguntas que ouvimos o apresentador fazer.

Um porta-voz da Google confirmou que as palavras que se ouvem no vídeo são "excertos reais das instruções utilizadas para produzir o resultado Gemini que se segue".

Ou seja, mensagens de texto detalhadas, imagens fixas e respostas de texto. O que a Google demonstrou de facto foi uma funcionalidade que o GPT-4 já tem há meses.

Publicação no blogue do Google mostra as imagens fixas e os avisos de texto que foram efetivamente utilizados.

No exemplo do carro, o apresentador pergunta: "Com base na sua conceção, qual destes carros andaria mais depressa?"

A pergunta que foi utilizada foi: "Qual destes carros é mais aerodinâmico? O da esquerda ou o da direita? Explica porquê, utilizando detalhes visuais específicos".

E quando se recria a experiência no Bard, que a Gemini agora controla, nem sempre dá certo.

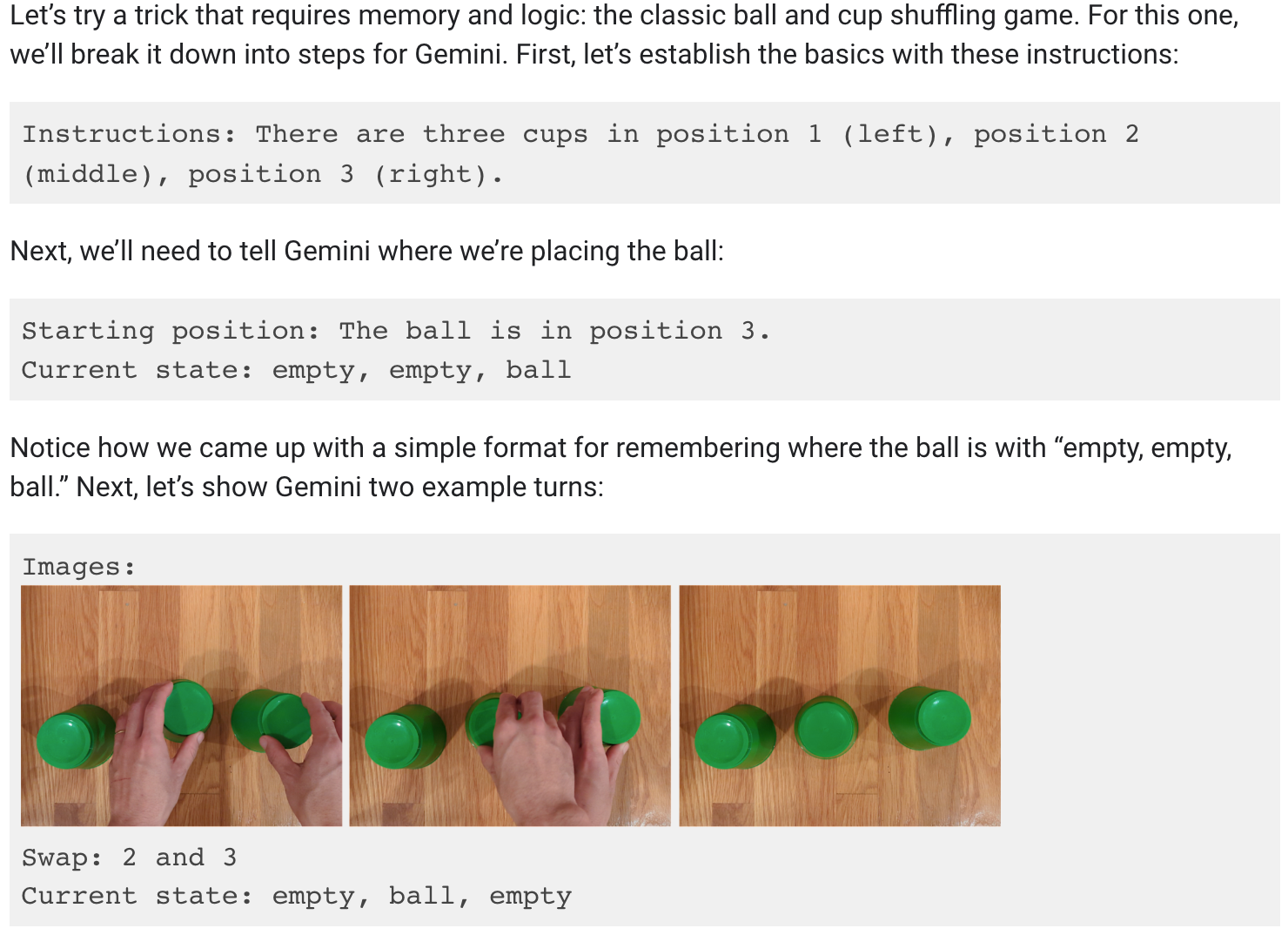

Queria mesmo acreditar que Gemini podia seguir a bola à medida que os três copos se moviam, mas infelizmente isso também não é verdade.

A publicação no blogue da Google mostra que foram necessários muitos avisos e explicações para a demonstração do baralhar de chávenas.

Não deixa de ser impressionante que um modelo de IA consiga fazer isto, mas não é o que nos foi vendido no vídeo.

É isso, Google?

Estamos apenas a especular, mas o mais provável é que a demonstração estivesse a mostrar os resultados obtidos pela Google utilizando o Gemini Ultra, que ainda não foi lançado.

Assim, quando o Gemini Ultra for eventualmente lançado, parece que será capaz de fazer o que o GPT-4 tem vindo a fazer há meses. As implicações não são grandes.

Será que estamos a atingir um limite máximo no que diz respeito às capacidades de IA? Porque, se as melhores mentes da IA estão a trabalhar na Google, então certamente estarão a impulsionar a inovação de ponta.

Ou será que a Google não só foi lenta a entrar na corrida, como também teve dificuldades em acompanhar os restantes? Os números de benchmark que a Google orgulhosamente exibiu mostram que o seu modelo, ainda por lançar, bate marginalmente o GPT-4 em alguns testes. Como é que se vai sair contra o GPT-5?

Ou talvez o departamento de marketing da Google tenha cometido um erro de julgamento com o seu vídeo, mas o Gemini Ultra continuará a ser melhor do que pensamos. A Google afirma que o Gemini é verdadeiramente multimodal e que compreende o vídeo, o que será verdadeiramente uma novidade para os LLM.

Ainda não vimos um LLM demonstrar a compreensão de vídeo, mas quando o fizermos valerá a pena ficarmos entusiasmados. Será o Gemini Ultra ou o GPT-5 que nos vai mostrar primeiro?