A IA está a permear a vida de milhões de pessoas em todo o mundo, mas, apesar da aceitação generalizada, a tecnologia está a revelar-se difícil de rentabilizar devido aos custos crescentes.

As ferramentas de IA generativa como o ChatGPT são dispendiosas de executar, exigindo servidores topo de gama, GPUs dispendiosas e hardware auxiliar extenso que consome muita energia.

Embora em grande parte não verificado, Dylan Patel da SemiAnalysis contou a informação que a OpenAI alegadamente bifurca alguns $700.000 por dia para gerir os seus modelos, registando perdas de quase $500 milhões em 2022.

John Hennessy, presidente da empresa-mãe da Google, a Alphabet, afirmou que um único aviso no Bard custa até 10 vezes mais do que uma pesquisa no Googlee os analistas acreditam que a Google irá incorrer em milhares de milhões em despesas relacionadas com a IA nos próximos anos.

2023 tem funcionado como um campo de testes para a monetização da IA. Gigantes tecnológicos como a Microsoft, a Google e a Adobe, entre outros, estão a tentar uma grande variedade de abordagens diferentes para criar, promover e fixar o preço das suas ofertas de IA.

A maioria dos modelos comerciais, como o ChatGPT, o Bard e o Claude 2 da Anthropic, já restringe os utilizadores a um determinado número de mensagens por hora ou dia, incluindo versões pagas como o ChatGPT Plus. A Adobe está a definir limites de utilização mensal para os seus modelos Firefly.

Os imensos custos da IA também estão a atingir as empresas. Adam Selipsky, o CEO da Amazon Web Services (AWS), comentou sobre os custos proibitivos para usuários corporativos que desejam construir cargas de trabalho de IA: "Muitos dos clientes com quem conversei estão insatisfeitos com o custo que estão vendo para executar alguns desses modelos."

Chris Young, diretor de estratégia empresarial da Microsoft, referiu que ainda é cedo para as empresas que pretendem tirar partido dos actuais modelos de IA, afirmando: "Será necessário algum tempo para que as empresas e os consumidores compreendam como querem utilizar a IA e quanto estão dispostos a pagar por ela".

E acrescentou: "Estamos claramente numa fase em que temos de traduzir o entusiasmo e o nível de interesse numa verdadeira adoção".

Modelos de IA versus software

A IA não oferece a mesma economia que o software convencional, uma vez que requer cálculos específicos para cada tarefa.

Quando os utilizadores solicitam um modelo como o ChatGPT, este procura padrões e sequências a partir dos seus dados de formação na arquitetura da rede neural e calcula uma resposta específica. Cada interação consome energia, o que implica custos contínuos.

Consequentemente, à medida que a adoção aumenta, também aumentam as despesas, o que representa um desafio para as empresas que oferecem serviços de IA a preços fixos.

Por exemplo, a Microsoft colaborou recentemente com a OpenAI para introduzir o GitHub Copilot, destinado a programadores e programadores.

Até à data, o seu elevado custo operacional significa que não tem sido rentável. Nos primeiros meses do ano, a Microsoft cobrou uma subscrição de $10 por mês para este assistente de IA e sofreu uma perda média de mais de $20 por mês para cada utilizador. Alguns utilizadores sofreram perdas de até $80 por mês, conforme revelado por um fonte do WSJ.

A suite Copilot da Microsoft para o Microsoft 365 (com o mesmo nome confuso da ferramenta GitHub) planeia cobrar um extra de $30 mensais. Esta ferramenta oferece capacidades como redigir e-mails de forma autónoma, elaborar apresentações em PowerPoint e criar folhas de cálculo em Excel.

Da mesma forma, a Google também vai lançar uma funcionalidade de assistente de IA para as suas ferramentas de local de trabalho, impondo uma taxa mensal adicional de $30 para além das taxas existentes.

Tanto a Microsoft como a Google estão a apostar numa taxa mensal fixa, esperando que o aumento dos encargos compense adequadamente os custos médios de alimentação destas ferramentas de IA.

Embora $30/mês possa parecer acessível nalguns países ocidentais mais desenvolvidos, estes modelos de preços não abrangem grande parte da população mundial.

Quando o ChatGPT Plus foi lançado no mercado indiano, por exemplo, muitos se queixaram de que era demasiado caroO custo de uma prestação de serviços de saúde é muito elevado, representando uma parte significativa do salário mensal médio de $330. O facto de excluir milhares de milhões de utilizadores da IA pode custar caro aos criadores quando comercializam ferramentas para o público.

O custo também não é irrelevante para quem vive em países mais ricos, com os inquéritos a mostrarem que as assinaturas são das primeiras coisas a abandonar quando as pessoas procuram reduzir as suas despesas.

Porque é que a IA é tão difícil de rentabilizar?

A IA apresenta um vazio entre as visões aparentemente infinitas dos criadores e os recursos finitos disponíveis para as concretizar.

Sam Altman, Diretor Executivo da OpenAI afirma que um mundo futurista com IA incorporada é simplesmente "inevitável", onde máquinas inteligentes vivem ao nosso lado, cumprindo as nossas ordens, onde as pessoas vivem centenas de anos ou imortalmente, e onde as IA incorporadas nos nossos cérebros nos ajudam a realizar tarefas complexas apenas com o nosso pensamento.

Mustafaya Suleman, CEO da Inflection, publicou recentemente o seu livro "The Coming Wave", onde compara a IA à explosão do Cambriano, há 500 milhões de anos, que conduziu à mais rápida explosão de evolução jamais testemunhada no nosso planeta.

A IA generativa está prestes a explodir, prevendo-se que as receitas excedam $1 trilião até 2032. Desde o início até onde está agora e onde estará é alucinante... todos os sectores serão transformados para melhor. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) 20 de outubro de 2023

As ambições alimentam as ideias, mas é o dinheiro que impulsiona a indústria tecnológica. A investigação e o desenvolvimento da IA são dispendiosos, pelo que os líderes do sector, como a OpenAI, a Google e o Facebook, investem fortemente para se manterem na vanguarda da corrida.

As empresas de IA atraíram um investimento colossal de $94 mil milhões em 2021, com várias rondas de financiamento a atingirem $500 milhões ou mais. O ano de 2023 aumentou a fasquia, com investimentos em startups Antrópica e Inflexão ultrapassando a marca dos $1 mil milhões.

Os especialistas em IA exigem salários avultados, muitas vezes na ordem dos milhões, devido à concorrência feroz, e os modelos requerem afinações e testes de esforço regulares, o que aumenta os custos correntes.

Existem também custos acessórios relacionados com os centros de dados e a manutenção, especialmente o arrefecimentoO hardware funciona a quente e é suscetível de avarias se não for mantido à temperatura ideal.

Nalgumas circunstâncias, as GPUs têm uma vida útil curta, inferior a cinco anos, e necessitam frequentemente de manutenção especializada.

Estratégias de rentabilização da IA

Tendo em conta estes desafios, como é que as empresas tecnológicas estão a abordar o desafio da monetização da IA?

Aumentar a produtividade

As empresas podem beneficiar da IA ao aumentarem significativamente a produtividade líquida da sociedade. Ao automatizar tarefas repetitivas, as empresas permitem que os profissionais humanos se concentrem em funções de valor acrescentado de nível superior.

Isto ajudá-los-á a obter dinheiro público e privado. Por exemplo, a DeepMind colabora com o Serviço Nacional de Saúde (NHS) do Reino Unido e as empresas tecnológicas estão a trabalhar com os governos na luta contra as alterações climáticas.

No entanto, a produtividade impulsionada pela IA poderá ter impacto noutras fontes de rendimento das empresas tecnológicas. Por exemplo, o projeto as receitas publicitárias estão a diminuir à medida que a IA retira tráfego do seu motor de busca. Este ano, as receitas da Google provenientes dos anúncios do YouTube diminuir em 2,6%e as receitas das redes de publicidade registam um decréscimo sem precedentes de 8,3%.

Vendas de hardware

A formação e o alojamento de modelos de IA requerem hardware especializado de topo de gama. As GPUs são indispensáveis para executar algoritmos sofisticados de IA, o que as torna um componente lucrativo no ecossistema de IA.

A líder do sector, a Nvidia, é a grande vencedora, com a sua capitalização bolsista a atingir a marca dos $1 biliões, mas outras fabricantes de hardware de IA de menor importância também beneficiaram.

Assinaturas

Oferecer melhorias de IA como parte de pacotes de subscrição é a melhor forma de gerar receitas de utilizadores públicos e empresas que não querem ou não precisam de seguir o caminho da API.

O ChatGPT Plus é o serviço de IA mais subscrito a nível mundial, mas faltam informações que descrevam o volume de receitas que gera.

A OpenAI lançou a sua Variante empresarial este ano para reforçar as receitas das assinaturas e declarou que a empresa tem como objetivo atingir $1 mil milhões de receitas no próximo ano.

APIs

Empresas como a OpenAI utilizam uma abordagem de faturação baseada em tokens para utilizadores empresariais e comerciais das suas APIs.

Este sistema garante que os utilizadores são facturados com base na carga computacional real dos seus pedidos, assegurando equidade e transparência.

Os modelos de preços das APIs atendem a um amplo espetro de utilizadores, desde os que fazem chamadas ligeiras esporádicas até aos utilizadores mais exigentes com tarefas intensivas.

A IA como uma caraterística inerente

Algumas empresas estão a integrar capacidades de IA nos seus produtos sem cobrar imediatamente um suplemento. Esta estratégia visa, em primeiro lugar, aumentar o valor inerente de um produto.

Com o tempo, quando os utilizadores integrarem as capacidades de IA nos seus fluxos de trabalho e perceberem o seu valor, é mais provável que aceitem um aumento de preços subsequente. No entanto, a IA tem de proporcionar vantagens progressivas se os custos aumentarem de forma constante.

Os custos de formação em IA de fonte aberta estão a ficar mais baratos

Há aqui uma discussão paralela - porque é que alguém há-de pagar pela IA se nunca a possui?

Alguns - como o "padrinho" da IA, Yann LeCun - defendem que a IA deve tornar-se parte da nossa infraestrutura pública, salientando a necessidade de os programadores criarem modelos de fonte aberta que sejam baratos e de fácil acesso.

Um artigo do NYT sobre o debate em torno da questão de saber se os modelos de base do LLM devem ser fechados ou abertos.

A Meta defende a abertura, começando com o lançamento do LLaMA (para uso não comercial), enquanto a OpenAI e a Google querem manter as coisas fechadas e proprietárias.

Defendem que a abertura pode ser...

- Yann LeCun (@ylecun) 18 de maio de 2023

À medida que as soluções de IA se tornam parte integrante das empresas, muitas não possuem o orçamento para desenvolver modelos proprietários a partir do zero. Tradicionalmente, recorrem a APIs de startups de IA emergentes ou a sistemas prontos a utilizar.

No entanto, à medida que os custos de formação diminuem e a necessidade de privacidade dos dados aumenta, a colaboração com fornecedores especializados na personalização de modelos privados e de código aberto é cada vez mais favorecida.

Naveen Rao, Diretor Executivo e cofundador da MosaicML, explicou ao The Register que os modelos de código aberto são tentadores, uma vez que são mais baratos, mais flexíveis e permitem às empresas manter os volumes de trabalho privados.

A MosaicML lançou uma série de modelos de grande linguagem (LLM) de código aberto baseados na sua arquitetura MPT-7B. Ao contrário de muitos outros LLMs, este modelo é comercialmente viável para as massas.

Rao explicou a lógica subjacente a este modelo, dizendo: "Há definitivamente muita atração por este tipo de coisas, e fizemo-lo por várias razões". E acrescentou: "Uma delas é que queríamos ter um modelo que tivesse permissão para uso comercial. Não queremos sufocar esse tipo de inovação".

Quanto à acessibilidade económica, Rao observou: "Se um cliente nos pedir para treinar este modelo, podemos fazê-lo por $200.000 e ainda ganhamos dinheiro com isso".

O MosaicML também fornece às empresas as ferramentas para alojar eficazmente os seus modelos personalizados em plataformas na nuvem. "Os seus dados não são partilhados com a empresa em fase de arranque e a empresa é proprietária dos pesos do modelo e do seu IP", confirmou Rao.

Rao também falou sobre as limitações das APIs comerciais, afirmando: "As APIs comerciais são uma ótima ferramenta de prototipagem. Penso que, com os serviços do tipo ChatGPT, as pessoas vão usá-las para entretenimento e talvez para algumas coisas pessoais, mas não para empresas. Os dados são um fosso muito importante para as empresas".

Rao sublinhou ainda os custos da arquitetura interna, afirmando que "as GPUs falham com bastante frequência", "se um nó for abaixo e for necessária uma intervenção manual, se demorar cinco horas [a reparar], acabámos de gastar $10.000 sem trabalho, certo?

Abordou também a questão da escassez de chips no sectorO Presidente da Comissão Europeia, António Costa, afirmou que "vamos viver neste mundo de escassez de GPU durante pelo menos dois anos, talvez cinco".

Se as empresas puderem utilizar a IA de fonte aberta para treinar os seus modelos de baixo custo com total soberania e controlo dos dados, isso representa um desafio para a IA pública como o ChatGPT.

Os estrangulamentos iminentes da IA?

Para além da escassez de GPUs destacada por Rao, outra barreira à monetização da IA são os crescentes requisitos energéticos da indústria.

A estudo recente prevê que, em 2027, a energia consumida pela indústria da IA poderá ser equivalente à de uma pequena nação.

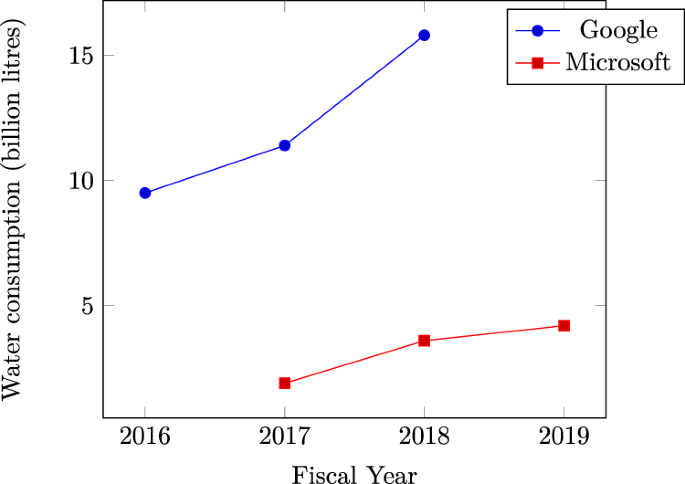

Microsoft consumo de água dos centros de dados em alta afirma a imensa sede de recursos naturais da IA. As provas indicam que os recentes picos de utilização de água por gigantes da tecnologia como a Microsoft e a Google são atribuídos a cargas de trabalho intensivas relacionadas com a IA.

Numa escala mais alargada, a energia acumulada utilizada pelos centros de dados já ultrapassa os 1% do consumo global de eletricidade, de acordo com a Agência Internacional da Energia (AIE).

Se as necessidades energéticas continuarem a aumentar, as empresas de IA poderão ser forçadas a voltar a sua atenção para o desenvolvimento de abordagens mais eficientes para o treino de modelos, o que poderá prejudicar a trajetória a curto prazo da tecnologia.

Narrativas concorrentes

A indústria nascente da IA continua a ser jovem e a sua direção futura é excecionalmente difícil de prever.

As figuras centrais da IA reconhecem que as suas ideias preconcebidas nem sempre correspondem à realidade.

Por exemplo, falando no podcast de Joe Rogan, Sam Altman admitiu que estava errado sobre o curso de desenvolvimento da IA, descrevendo que o caminho para a realização de formas altamente inteligentes de IA será granular e não explosivo.

Por um lado, a rentabilização da IA está a revelar-se um desafio, lançando dúvidas sobre se o entusiasmo inicial irá diminuir, levando a um processo mais lento de maturação da tecnologia.

Por outro lado, a indústria pode já ter feito progressos suficientes para empurrar a IA para uma "singularidade" em que ultrapasse a cognição humana.

Nos próximos anos, se a humanidade registar progressos em domínios essenciais como a produção de energia e a construção de hardware e arquitetura de IA de baixo consumo - e este ano, registaram-se progressos neste domínio - então a tecnologia pode eliminar os estrangulamentos a curto prazo e continuar o seu ritmo acelerado de desenvolvimento.