O Instituto de Inovação Tecnológica dos Emirados Árabes Unidos (TII) lançou o seu Falcon 180B LLM na Hugging Face na semana passada e apresentou um desempenho impressionante nos primeiros testes.

O modelo, que é de acesso livre para investigadores e utilizadores comerciais, é o produto de uma indústria de IA em expansão no Médio Oriente.

O Falcon 180B é 2,5 vezes maior do que o Meta Lhama 2 e foi treinado com 4 vezes mais computação. O TII treinou o modelo com um enorme número de 3,5 triliões de tokens. É a abordagem única do conjunto de dados que é largamente responsável pelo desempenho impressionante do modelo.

Para treinar um modelo, não são apenas necessários muitos dados, são também necessários muitos dados seleccionados e de boa qualidade. A produção destes dados custa muito dinheiro e não existem muitos conjuntos de dados curados de grande dimensão disponíveis ao público. A TII decidiu experimentar uma nova abordagem para evitar a necessidade de curadoria.

Em junho, os investigadores utilizaram filtragem e desduplicação cuidadosas de dados CommonCrawl publicamente disponíveis para criar o conjunto de dados RefinedWeb. Este conjunto de dados não só foi mais fácil de produzir, como também oferece um melhor desempenho do que a simples utilização de corpora seleccionados ou dados da Web.

O Falcon 180B foi treinado num enorme conjunto de dados de 3,5 biliões de tokens do RefinedWeb, significativamente mais do que os 2 biliões de tokens do conjunto de dados de pré-treino do Llama 2.

Desempenho do Falcon 180B

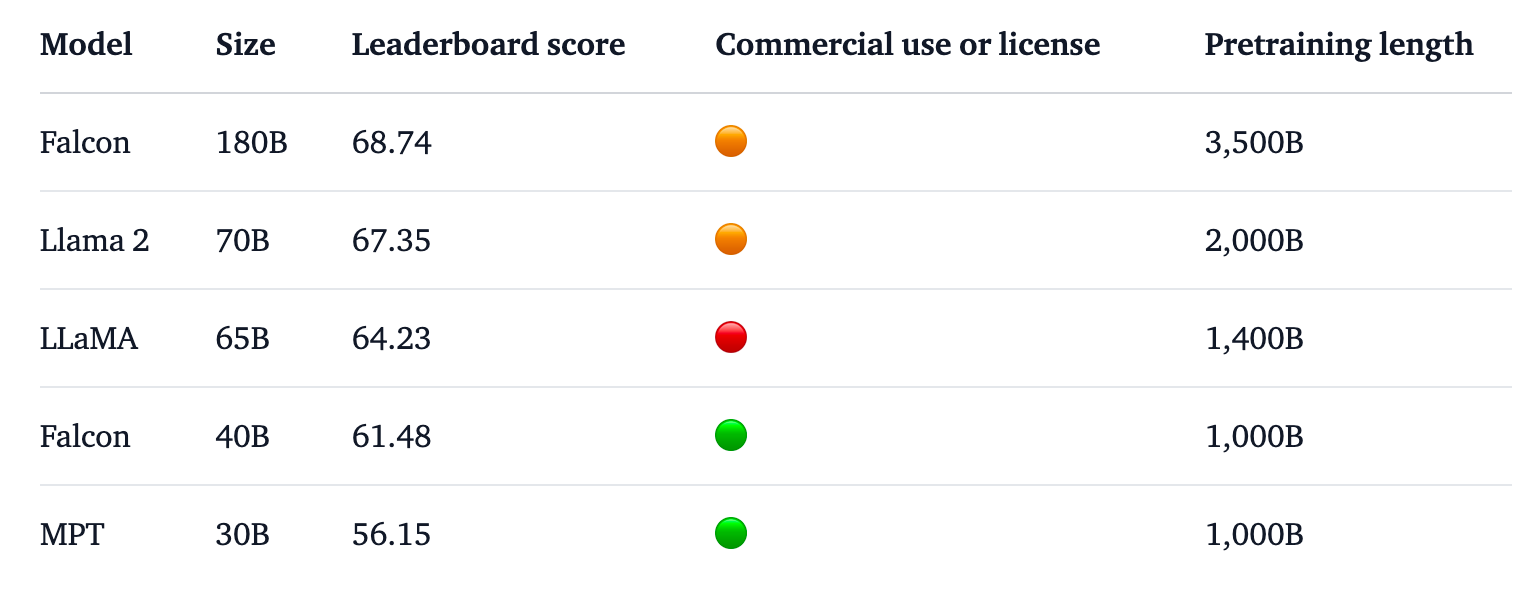

O Falcon 180B está no topo da tabela de classificação do Hugging Face para LLMs de acesso livre. O modelo supera o Llama 2, o anterior líder, numa série de testes de referência, incluindo testes de raciocínio, codificação, proficiência e conhecimento.

O Falcon 180B até tem uma pontuação elevada quando comparado com modelos proprietários e de código fechado. Fica logo atrás do GPT-4 e está a par do PaLM 2 Large da Google, que tem o dobro do tamanho do Falcon 180B.

Fonte: Cara de abraço

A TII afirma que, apesar do desempenho já impressionante do seu modelo pré-treinado, tenciona "fornecer versões cada vez mais capazes do Falcon no futuro, com base em conjuntos de dados melhorados e no RLHF/RLAIF".

Pode experimentar uma versão de conversação do modelo com isto Demonstração do Falcon 180B sobre a Cara de Abraço.

A versão de conversação é aperfeiçoada e higienizada, mas o modelo de base ainda não dispõe de protecções de alinhamento. A TII afirmou que, como ainda não tinha passado por um processo de afinação ou de alinhamento, poderia dar respostas "problemáticas".

Levará algum tempo até que esteja alinhado ao ponto de poder ser implantado comercialmente com confiança.

Mesmo assim, o desempenho impressionante deste modelo realça as oportunidades de melhoria para além do simples aumento dos recursos informáticos.

O Falcon 180B mostra que modelos mais pequenos treinados em conjuntos de dados de boa qualidade podem ser uma direção mais económica e eficiente para o desenvolvimento da IA.

O lançamento deste impressionante modelo sublinha o crescimento meteórico da Desenvolvimento da IA no Médio OrienteApesar dos recentes restrições à exportação de GPUs para a região.

À medida que empresas como a TII e a Meta continuam a lançar os seus poderosos modelos ao abrigo de licenças de acesso livre, será interessante ver o que a Google e a OpenAI fazem para impulsionar a adoção dos seus modelos fechados.

A diferença de desempenho entre os modelos de acesso aberto e os modelos proprietários parece estar definitivamente a diminuir.