O exército dos EUA está a tentar integrar chatbots de IA no seu planeamento estratégico, embora dentro dos limites de uma simulação de jogo de guerra baseada no popular jogo de vídeo Starcraft II.

Este estudoliderado pelo Laboratório de Investigação do Exército dos EUA, analisa as estratégias de campo de batalha GPT-4 Turbo e GPT-4 Vision da OpenAI.

Isto faz parte do projeto OpenAI colaboração com o Departamento de Defesa (DOD) na sequência da criação do Grupo de trabalho sobre IA generativa no ano passado.

A utilização da IA no campo de batalha é muito debatido, com um estudo recente semelhante sobre jogos de guerra com IA constatando que os LLM, como o GPT-3.5 e o GPT-4, tendem a intensificar as tácticas de diplomacia, resultando por vezes numa guerra nuclear.

Esta nova investigação do exército dos EUA utilizou o Starcraft II para simular um cenário de campo de batalha envolvendo um número limitado de unidades militares.

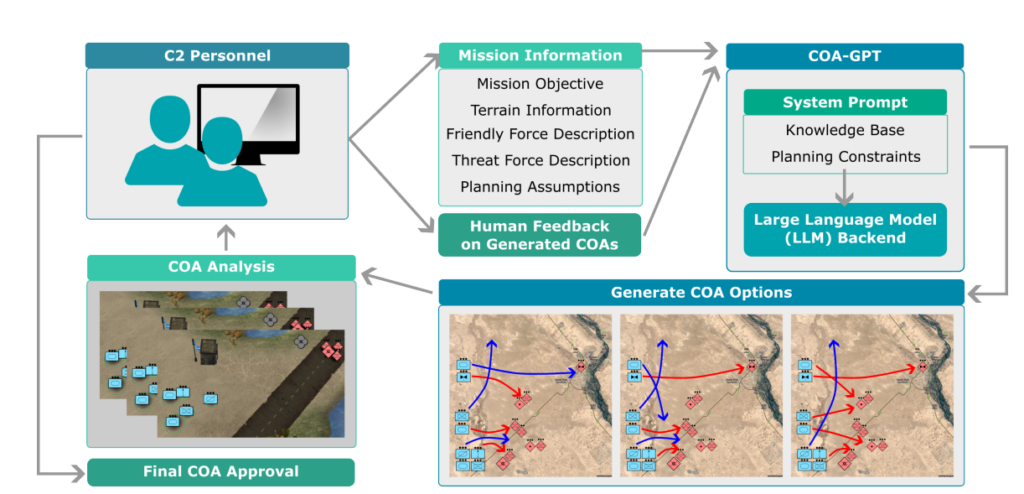

Os investigadores apelidaram este sistema de "COA-GPT" - com COA a significar o termo militar "Cursos de Ação", que descreve essencialmente as tácticas militares.

O COA-GPT assumiu o papel de assistente de um comandante militar, encarregado de conceber estratégias para obliterar as forças inimigas e capturar pontos estratégicos.

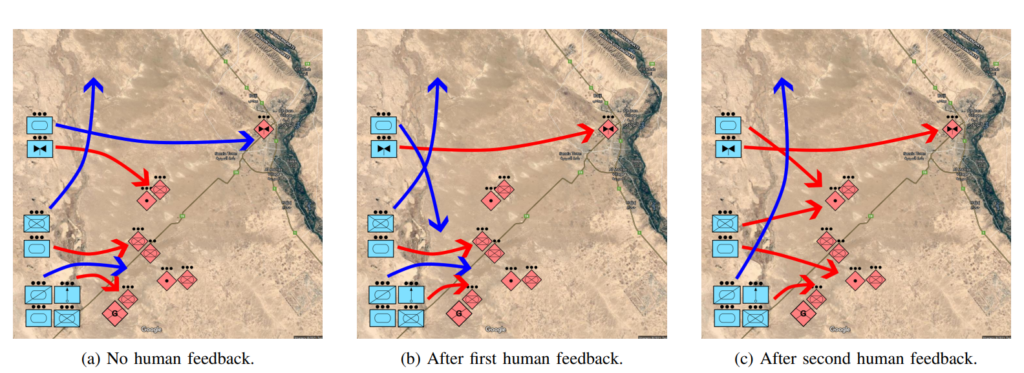

Os investigadores referem que o COA tradicional é notoriamente lento e trabalhoso. O COA-GPT toma decisões em segundos, integrando o feedback humano no processo de aprendizagem da IA.

O COA-GPT é superior a outros métodos, mas tem um custo

O COA-GPT demonstrou um desempenho superior aos métodos existentes, ultrapassando-os na geração de COAs estratégicos, e pode adaptar-se ao feedback em tempo real.

No entanto, havia falhas. Em especial, o COA-GPT sofreu mais baixas no cumprimento dos objectivos da missão.

O estudo afirma: "Observamos que o COA-GPT e o COA-GPT-V, mesmo quando melhorados com feedback humano, apresentam maiores baixas de forças amigas em comparação com outras linhas de base".

Será que este facto dissuade os investigadores? Parece que não.

O estudo afirma: "Em conclusão, o COA-GPT representa uma abordagem transformadora nas operações militares de C2, facilitando uma tomada de decisões mais rápida e ágil e mantendo uma vantagem estratégica na guerra moderna".

É preocupante que um sistema de IA que causou mais mortes desnecessárias do que a linha de base seja definido como uma "abordagem transformadora".

O DOD já identificou outras vias para explorar as utilizações militares da IA, mas as preocupações com a prontidão da tecnologia e com as implicações éticas continuam a pairar.

Por exemplo, quem é responsável quando os militares As aplicações de IA correm mal? Os criadores? A pessoa responsável? Ou alguém mais abaixo na cadeia?

Os sistemas de guerra com IA já estão a ser utilizados na Ucrânia e nos conflitos entre a Palestina e Israel, mas estas questões continuam em grande parte por testar.

Esperemos que continue assim.