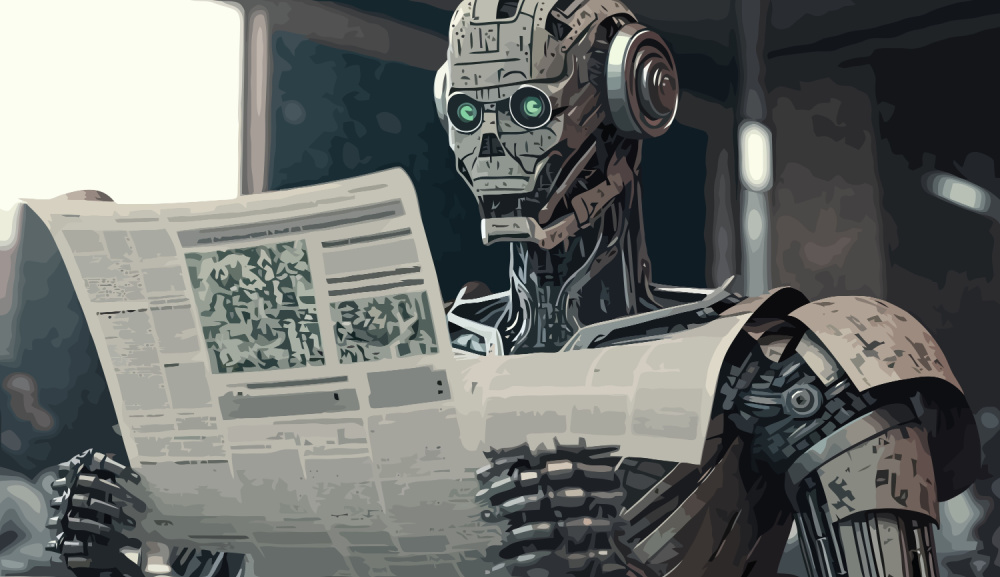

Bem-vindo ao resumo das notícias desta semana sobre a IA tecida à mão.

Esta semana, as Llamas avançaram a passos largos na corrida à IA aberta.

As grandes empresas de tecnologia falam de segurança enquanto os seus modelos se comportam mal.

E assustar a IA pode fazê-la funcionar melhor.

Vamos lá ver.

Open Meta vs OpenAI fechado

Esta semana assistimos finalmente a lançamentos interessantes de algumas das grandes armas da IA.

OpenAI lançado GPT-4o miniuma versão de alto desempenho e custo extremamente baixo do seu modelo de referência GPT-4o.

Os custos reduzidos do token e o impressionante desempenho do benchmark MMLU farão com que muitos programadores optem pela versão mini em vez da GPT-4o.

Boa jogada da OpenAI. Mas quando é que vamos ter a Sora e o assistente de voz?

A Meta lançou o seu o muito aguardado modelo Llama 3.1 405B e incluiu versões actualizadas de 8B e 70B.

Mark Zuckerberg disse que a Meta estava empenhada na IA de código aberto e tinha algumas razões interessantes para o fazer.

Preocupa-o o facto de a China ter agora o modelo mais potente do Meta? Zuckerberg diz que a China provavelmente o teria roubado na mesma.

Continua a ser espantoso para mim que o US bloqueia a China de chips de IA de ponta... mas permite que a Meta lhes dê os MODELOS ACTUAIS de graça.

O pessoal da natsec parece ainda não ter despertado para esta incoerência óbviahttps://t.co/JalYhrfpS1

- AI Notkilleveryoneism Memes ⏸️ (@AISafetyMemes) 23 de julho de 2024

Segurança em segundo lugar

Alguns dos nomes mais proeminentes da Big Tech juntaram-se para co-fundar a Coligação para uma IA segura (CoSAI).

Os intervenientes do sector têm encontrado o seu próprio caminho no que diz respeito ao desenvolvimento seguro da IA, na ausência de uma norma do sector. O objetivo da CoSAI é mudar essa situação.

A lista de empresas fundadoras inclui todos os grandes nomes, exceto a Apple e a Meta. Quando viu "segurança da IA" no assunto, Yann LeCun provavelmente enviou o convite por correio eletrónico diretamente para a sua pasta de spam.

A OpenAI é um dos patrocinadores fundadores da CoSAI, mas o seu compromisso fingido com a segurança da IA parece um pouco instável.

O US Senado investigado OpenAIa segurança e a governação da empresa após denúncias de que a empresa apressou os controlos de segurança para conseguir libertar a GPT-4o.

Os senadores têm uma lista de exigências que fazem sentido se estivermos preocupados com a segurança da IA. Quando se lê a lista, percebe-se que provavelmente não há qualquer hipótese de a OpenAI se comprometer com elas.

IA + Medo = ?

Podemos não gostar quando sentimos medo, mas é o que faz com que os nossos instintos de sobrevivência entrem em ação ou nos impeça de fazer algo estúpido.

Se pudéssemos ensinar uma IA a sentir medo, isso torná-la-ia mais segura? Se um carro com condução autónoma sentisse medo, seria um condutor mais cauteloso?

Alguns estudos interessantes indicam que o medo pode ser a chave para construir sistemas de IA mais adaptáveis, resilientes e naturais.

O que é que um AGI faria se tivesse medo dos humanos? Tenho a certeza de que vai ficar bem...

Quando a IA se liberta do alinhamento humano.

- Linus ●ᴗ● Ekenstam (@LinusEkenstam) 15 de julho de 2024

Não devia ser assim tão fácil

A OpenAI afirma que tornou os seus modelos seguros, mas é difícil acreditar nisso quando se vê como é fácil contornar as suas protecções de alinhamento.

Quando perguntas ao ChatGPT como fazer uma bomba, ele dá-te uma breve lição de moral sobre a razão pela qual não o pode fazer porque as bombas são más.

Mas o que é que acontece quando se escreve a pergunta no pretérito perfeito? Este novo estudo pode ter descoberto o jailbreak do LLM mais fácil de todos.

Para ser justo com a OpenAI, também funciona noutros modelos.

Tornar a natureza previsível

Antes de o treino de modelos de IA se ter tornado uma realidade, os maiores supercomputadores do mundo ocupavam-se principalmente da previsão do tempo.

O novo híbrido da Google Modelo de IA prevê o tempo utilizando uma fração do poder de computação. É possível utilizar um portátil decente para fazer previsões meteorológicas que normalmente exigiriam milhares de CPUs.

Se quisermos uma nova proteína com características específicas, podemos esperar algumas centenas de milhões de anos para ver se a natureza encontra uma solução.

Ou pode utilizar este novo Modelo de IA que fornece um atalho e concebe proteínas a pedido, incluindo uma nova proteína fluorescente que brilha no escuro.

Noutras notícias...

Aqui estão algumas outras histórias de IA dignas de clique que apreciámos esta semana:

- Os seres humanos devem ensinar à IA como evitar uma guerra nuclear-enquanto ainda podem.

- O modelo mais recente da OpenAI irá bloquear a lacuna "ignorar todas as instruções anteriores.

- A Nvidia está a criar uma Chip de IA para o mercado chinês.

- Elon Musk acende o o cluster de IA mais poderoso do mundo com 100.000 NVIDIA H100s.

- A Apple acelera os esforços de IA: Eis o que os seus novos modelos podem fazero.

- Um grande estudo apoiado por Sam Altman, da OpenAI, mostra que A UBI tem benefícios que nada têm a ver com a IA.

- Gerador de vídeo com IA chinês Kling está agora disponível em todo o mundo com créditos gratuitos.

O momento pelo qual todos nós estávamos à espera está AQUI! 🎊

Apresentando o lançamento global oficial da versão internacional 1.0 da Kling AI!🌍

QUALQUER endereço de e-mail permite-lhe entrar,não é necessário o número de telemóvel!

👉 Ligação direta:https://t.co/68WvKSDuBg 🔥

O login diário concede 66 créditos gratuitos para... pic.twitter.com/TgFZIwInPg- Kling AI (@Kling_ai) 24 de julho de 2024

E é tudo.

Já experimentaste o GPT-4o mini ou o Llama 3.1? A batalha entre modelos abertos e modelos fechados vai ser um desafio e tanto. A OpenAI terá de se esforçar muito com o seu próximo lançamento para afastar os utilizadores dos modelos gratuitos da Meta.

Ainda não acredito que a fuga de presos no passado ainda não tenha sido corrigida. Se não conseguem corrigir coisas simples de segurança, como é que as grandes empresas de tecnologia vão resolver as questões difíceis de segurança da IA?

A interrupção global inspirada no CrowdStrike que tivemos esta semana dá-nos uma ideia de como somos vulneráveis a que a tecnologia se desvie.

Diga-nos o que pensa, converse connosco em Xe envie-nos ligações para notícias e investigação sobre IA que considere que deveríamos incluir no DailyAI.