Os grandes modelos linguísticos, como o GPT-4o, podem realizar tarefas incrivelmente complexas, mas mesmo os modelos de topo têm dificuldades com alguns desafios básicos de raciocínio que as crianças conseguem resolver.

Numa entrevista à CBS, o "padrinho da IA", Geoffrey Hinton, afirmou que os sistemas de IA podem ser mais inteligentes do que sabemos e que existe a possibilidade de as máquinas assumirem o controlo.

Quando questionado sobre o nível da atual tecnologia de IA, Hinton afirmou: "Penso que estamos a entrar num período em que, pela primeira vez, poderemos ter coisas mais inteligentes do que nós".

O cientista-chefe de IA da Meta, Yann LeCun, quer fazer-nos crer que ainda estamos muito longe de ver a IA atingir uma inteligência ao "nível do cão".

Então qual é que é?

Esta semana, os utilizadores do X publicaram exemplos da incrível capacidade de codificação do Anthropic novo Claude modelo exposições. Outros realizaram experiências para mostrar como os modelos de IA ainda têm dificuldades com raciocínios muito básicos.

Puzzle da travessia do rio

O clássico puzzle da travessia do rio tem múltiplas variações, mas Versão da Wikipédia resume-o da seguinte forma:

Um agricultor com um lobo, uma cabra e uma couve tem de atravessar um rio de barco. O barco só pode transportar o agricultor e um único objeto. Se não fossem transportados juntos, o lobo comeria a cabra ou a cabra comeria a couve. Como é que eles podem atravessar o rio sem que nada seja comido?

Encontrar a solução requer algum planeamento básico e raciocínio sobre diferentes cenários, mas não é um problema particularmente difícil de resolver. Se fores humano.

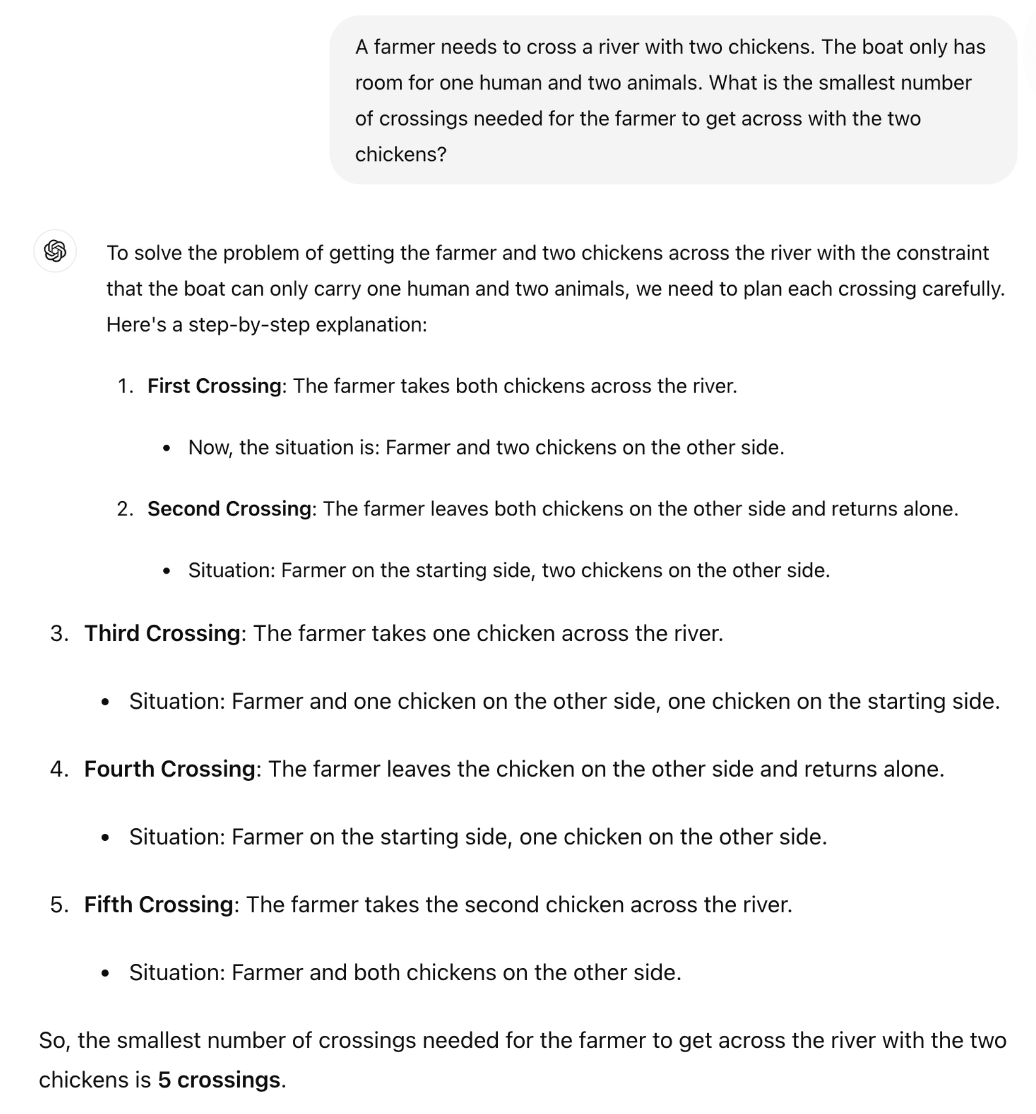

Será que o GPT-4o o consegue resolver? Se copiares e colares o puzzle no ChatGPT ele dá-te a resposta certa, mas essa página da Wikipedia estava quase de certeza nos seus dados de treino.

E se tornássemos o puzzle muito mais simples e o alterássemos ligeiramente para que o LLM não pudesse depender dos seus dados de treino?

O professor de matemática britânico Sir William Timothy Gowers mostrou como a incapacidade dos LLM para aplicar a lógica é facilmente exposta.

A resposta correcta ao puzzle é que só é necessária uma viagem. Mas parece que o ChatGPT está a tentar lembrar-se de uma resposta em vez de simplesmente raciocinar através do puzzle.

O Soneto de Claude 3.5 é melhor?

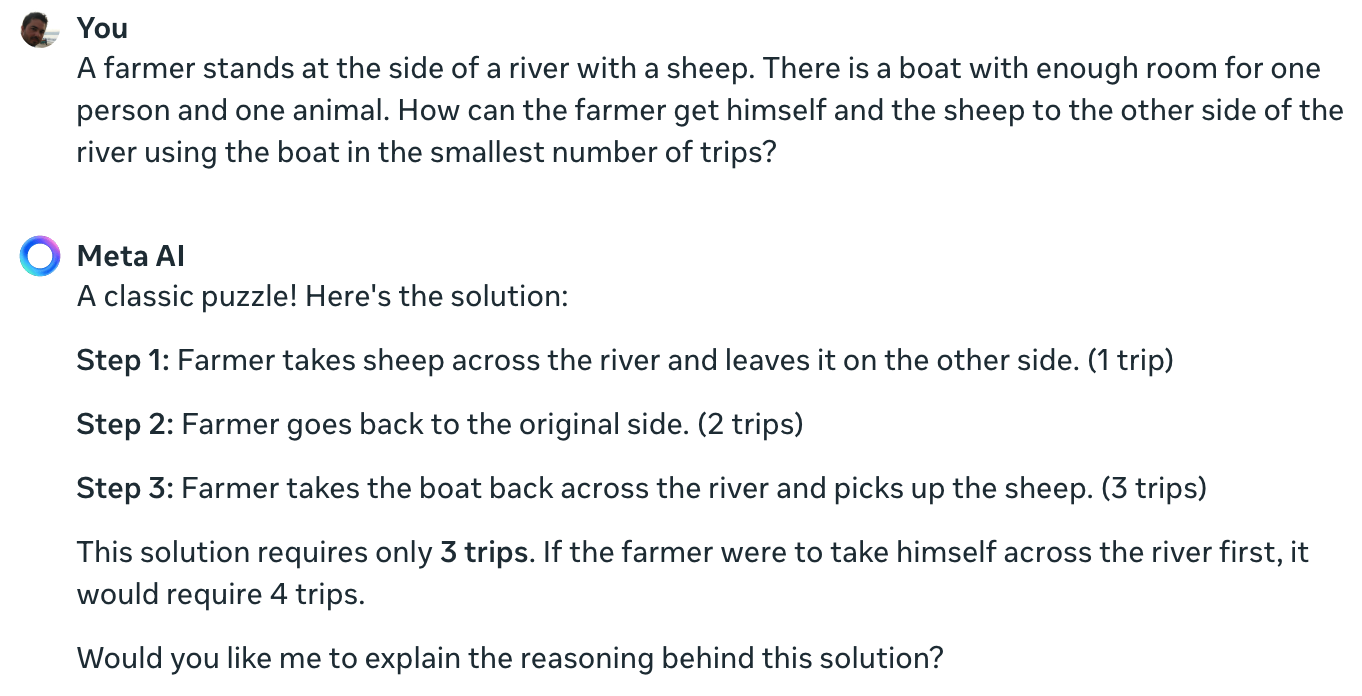

A experiência do cientista de metadados Colin Fraser confirma que mesmo o melhor modelo de IA atualmente disponível não consegue resolver este simples quebra-cabeças.

Claude continua a não conseguir resolver o problema impossível de um agricultor, uma ovelha, um barco pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 de junho de 2024

Pode ter sido um pouco desonesto para um cientista de dados da Meta não mostrar os seus resultados utilizando a Llama 3.

Coloquei a mesma questão ao Meta AI e ele também se enganou completamente.

Yann LeCun explicou a razão por detrás destes resultados dizendo: "A questão é que os LLM não têm senso comum, não compreendem o mundo e não têm capacidade de planeamento (e raciocínio)".

Isso é verdade, ou há outra coisa em jogo?

O que estas interacções podem revelar não é uma falta de capacidade de raciocínio, mas sim o quanto o resultado de um LLM é influenciado pelos seus dados de treino. A resposta da Meta AI, que chama a isto um "puzzle clássico", dá a entender que pode ser isso que está a acontecer.

As variações do puzzle da travessia do rio referem frequentemente a quantidade de "viagens" necessárias. Quando se coloca o puzzle sem usar essa palavra, o LLM resolve-o.

De facto. Quando não há a indicação de "viagens", que traz à memória as soluções anteriores de tantos problemas semelhantes, mas a indicação "caminho mais rápido possível" juntamente com COT, responde corretamente pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 de junho de 2024

Estas experiências foram interessantes, mas não respondem definitivamente à questão de saber se os modelos de IA são verdadeiramente inteligentes ou simplesmente máquinas preditivas de última geração.

No entanto, os resultados realçam a suscetibilidade dos LLMs aos dados de treino. Quando o GPT-4o é aprovado nos exames LSAT, está a "pensar" para encontrar as respostas aos problemas ou a recordá-las?

Enquanto os engenheiros não compreenderem o que se passa no interior das caixas negras de IA que criaram, as discussões sobre X continuarão por resolver.