A IA tem uma miríade de utilizações, mas uma das suas aplicações mais preocupantes é a criação de meios de comunicação social profundamente falsos e de desinformação.

Um novo estudo de Google DeepMind e Quebra-cabeças, uma incubadora tecnológica da Google que monitoriza as ameaças sociais, analisou a utilização indevida da IA entre janeiro de 2023 e março de 2024.

Avaliou cerca de 200 incidentes reais de utilização indevida da IA, revelando que a criação e divulgação de meios de comunicação enganosos e profundamente falsos, em particular os que visam políticos e figuras públicas, é a forma mais comum de utilização maliciosa da IA.

As falsificações profundas, meios de comunicação sintéticos gerados com recurso a algoritmos de IA para criar imagens, vídeos e áudio altamente realistas, mas falsos, tornaram-se mais realistas e generalizados.

Incidentes como quando imagens falsas explícitas de Taylor Swift apareceu no X mostrou que essas imagens podem chegar a milhões de pessoas antes de serem apagadas.

Mas o mais insidioso são as falsificações profundas direccionadas para questões políticas, como o conflito israelo-palestiniano. Em alguns casos, nem mesmo os verificadores de factos encarregados de os rotular como "gerados por IA" conseguem detetar com segurança a sua autenticidade.

O estudo da DeepMind recolheu dados de um conjunto diversificado de fontes, incluindo plataformas de redes sociais como o X e o Reddit, blogues em linha e relatórios dos meios de comunicação social.

Cada incidente foi analisado para determinar o tipo específico de tecnologia de IA utilizada indevidamente, o objetivo pretendido por detrás do abuso e o nível de conhecimentos técnicos necessários para levar a cabo a atividade maliciosa.

As falsificações profundas são a forma dominante de utilização abusiva da IA

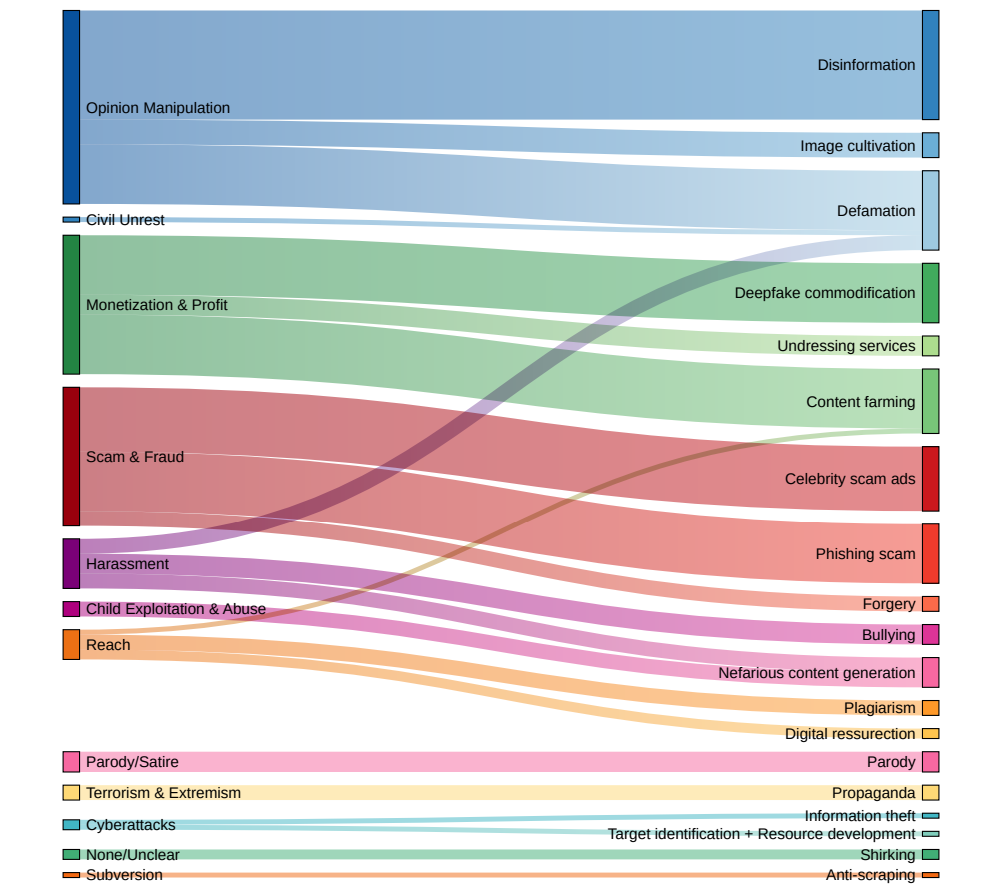

Os resultados traçam um quadro alarmante do panorama atual da utilização maliciosa da IA:

- As falsificações profundas surgiram como a forma dominante de utilização indevida da IA, representando quase o dobro dos incidentes que a segunda categoria mais prevalecente.

- O segundo tipo de abuso de IA mais frequentemente observado foi a utilização de modelos de linguagem e chatbots para gerar e disseminar desinformação em linha. Ao automatizar a criação de conteúdos enganosos, os maus actores podem inundar as redes sociais e outras plataformas com notícias falsas e propaganda a uma escala sem precedentes.

- Influenciar a opinião pública e as narrativas políticas foi a principal motivação por trás de mais de um quarto (27%) dos casos de uso indevido de IA analisados. Este facto ilustra a ameaça que as deep fakes e a desinformação gerada por IA representam para os processos democráticos e para a integridade das eleições em todo o mundo, que observámos a partir de incidentes recentes de grande visibilidade.

- O ganho financeiro foi identificado como o segundo fator mais comum da atividade de IA maliciosa, com actores sem escrúpulos a oferecerem serviços pagos para criar falsificações profundas, incluindo imagens explícitas não consensuais, e a tirarem partido da IA generativa para produzir em massa conteúdos falsos com fins lucrativos.

- A maioria dos incidentes de utilização indevida de IA envolveu ferramentas e serviços facilmente acessíveis que exigiam conhecimentos técnicos mínimos para funcionar. Esta baixa barreira à entrada expande grandemente o conjunto de potenciais actores maliciosos, tornando mais fácil do que nunca para os indivíduos e grupos envolverem-se em enganos e manipulações com base na IA.

A Dr.ª Nahema Marchal, da DeepMind, explicou ao Financial Times: "Tem havido uma preocupação compreensível relativamente a ataques cibernéticos bastante sofisticados facilitados por estas ferramentas", continuando: "Vimos utilizações indevidas bastante comuns da GenAI [como deep fakes que] podem passar um pouco mais despercebidas."

Os decisores políticos, as empresas tecnológicas e os investigadores devem trabalhar em conjunto para desenvolver estratégias abrangentes para detetar e combater os deepfakes, a desinformação gerada pela IA e outras formas de utilização abusiva da IA.

Mas a verdade é que já tentaram - e falharam em grande parte. Recentemente, observámos mais incidentes de crianças apanhadas em incidentes falsosmostrando que os danos sociais que infligem podem ser graves.

Atualmente, as empresas de tecnologia não conseguem detetar de forma fiável as falsificações profundas em grande escala e, com o tempo, estas tornar-se-ão cada vez mais realistas e difíceis de detetar.

E quando surgirem sistemas de texto para vídeo como o Sora da OpenAI, haverá toda uma nova dimensão de falsificações profundas com que lidar.