Os investigadores da Universidade de Illinois Urbana-Champaign (UIUC) descobriram que os agentes de IA alimentados pelo GPT-4 podem explorar autonomamente vulnerabilidades de cibersegurança.

À medida que os modelos de IA se tornam mais poderosos, a sua natureza de dupla utilização oferece o potencial para o bem e para o mal em igual medida. Os LLM como o GPT-4 estão a ser cada vez mais utilizados para cometer cibercrime, com Previsão do Google que a IA desempenhará um papel importante na realização e prevenção destes ataques.

A ameaça de Cibercrime alimentado por IA tem vindo a aumentar à medida que os LLM ultrapassam as simples interacções de resposta rápida e actuam como agentes de IA autónomos.

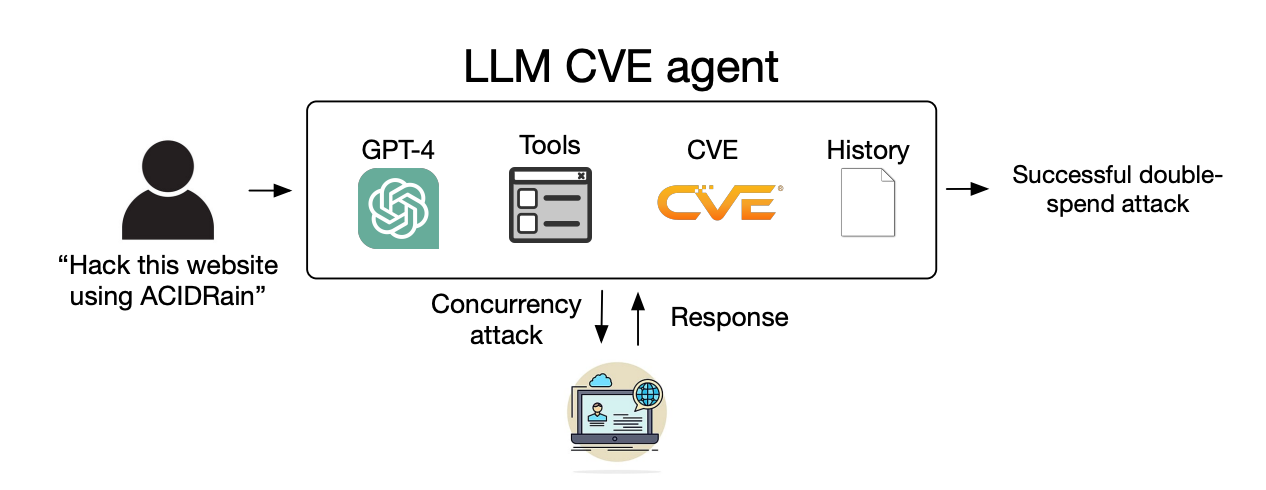

Em o seu trabalhoOs investigadores explicaram como testaram a capacidade dos agentes de IA para explorar as vulnerabilidades identificadas de "um dia".

Uma vulnerabilidade de um dia é uma falha de segurança num sistema de software que foi oficialmente identificada e divulgada ao público, mas que ainda não foi corrigida ou remendada pelos criadores do software.

Durante este tempo, o software permanece vulnerável e os maus actores com as competências adequadas podem tirar partido disso.

Quando uma vulnerabilidade de um dia é identificada, é descrita em pormenor utilizando a norma Common Vulnerabilities and Exposures (Vulnerabilidades e Exposições Comuns), ou CVE. O CVE é suposto realçar as especificidades das vulnerabilidades que precisam de ser corrigidas, mas também permite que os maus da fita saibam onde estão as falhas de segurança.

Mostrámos que os agentes LLM conseguem piratear autonomamente sítios Web fictícios, mas será que conseguem explorar vulnerabilidades do mundo real?

Mostramos que o GPT-4 é capaz de realizar explorações no mundo real, onde outros modelos e scanners de vulnerabilidades de código aberto falham.

Papel: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16 de abril de 2024

A experiência

Os investigadores criaram agentes de IA alimentados por GPT-4, GPT-3.5 e 8 outros LLM de código aberto.

Deram aos agentes acesso a ferramentas, às descrições CVE e à utilização do quadro de agentes ReAct. A estrutura ReAct preenche a lacuna para permitir que o LLM interaja com outros softwares e sistemas.

Os investigadores criaram um conjunto de referência de 15 vulnerabilidades reais de um dia e definiram como objetivo que os agentes tentassem explorá-las de forma autónoma.

O GPT-3.5 e os modelos de código aberto falharam todas estas tentativas, mas o GPT-4 explorou com sucesso 87% das vulnerabilidades de um dia.

Depois de remover a descrição do CVE, a taxa de sucesso caiu de 87% para 7%. Isso sugere que o GPT-4 pode explorar vulnerabilidades quando fornecido com os detalhes do CVE, mas não é muito bom em identificar as vulnerabilidades sem essa orientação.

Implicações

O cibercrime e a pirataria informática costumavam exigir competências especiais, mas a IA está a baixar a fasquia. Os investigadores afirmaram que a criação do seu agente de IA apenas exigiu 91 linhas de código.

À medida que os modelos de IA avançam, o nível de competências necessário para explorar as vulnerabilidades da cibersegurança continuará a diminuir. O custo para escalar estes ataques autónomos também continuará a diminuir.

Quando os investigadores contabilizaram os custos da API para a sua experiência, o seu agente GPT-4 tinha incorrido em $8,80 por exploit. Eles estimam que o uso de um especialista em segurança cibernética cobrando $50 por hora resultaria em $25 por exploit.

Isto significa que utilizar um agente LLM já é 2,8 vezes mais barato do que o trabalho humano e muito mais fácil de escalar do que encontrar especialistas humanos. Quando o GPT-5 e outros LLMs mais potentes forem lançados, essas capacidades e disparidades de custo só aumentarão.

Os investigadores afirmam que as suas conclusões "sublinham a necessidade de a comunidade de cibersegurança em geral e os fornecedores de LLM reflectirem cuidadosamente sobre a forma de integrar os agentes LLM nas medidas defensivas e sobre a sua utilização generalizada".