Ouvimos falar muito de segurança da IA, mas será que isso significa que é muito utilizada na investigação?

Um novo estudo do Observatório de Tecnologias Emergentes da Universidade de Georgetown sugere que, apesar do barulho, a investigação sobre segurança da IA ocupa apenas uma pequena minoria do foco de investigação da indústria.

Os investigadores analisaram mais de 260 milhões de publicações académicas e descobriram que apenas 2% dos artigos relacionados com a IA publicados entre 2017 e 2022 abordavam diretamente tópicos relacionados com a segurança, ética, robustez ou governação da IA.

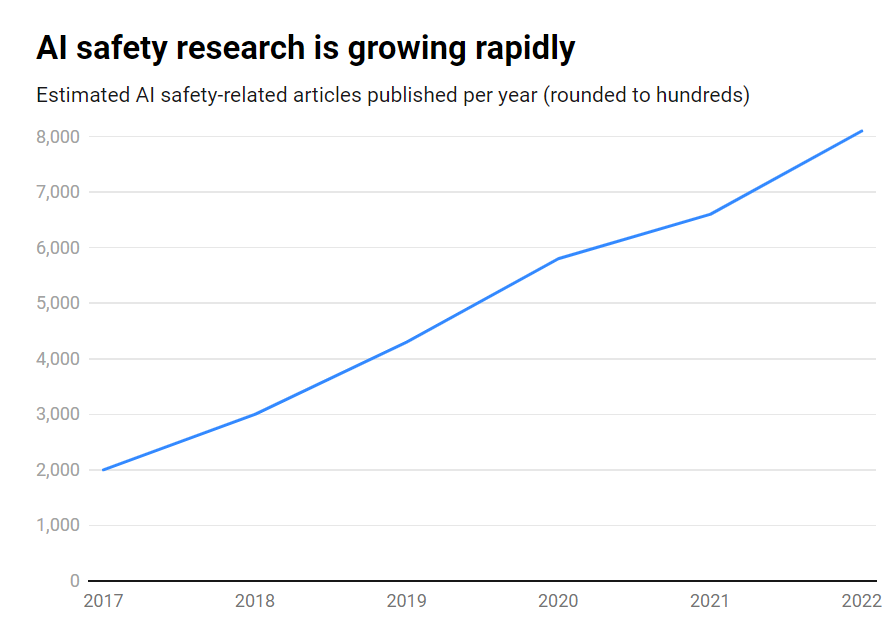

Embora o número de publicações sobre segurança da IA tenha aumentado de forma impressionante durante esse período, de cerca de 1800 para mais de 7000 por ano, continua a ser uma questão periférica.

Eis os principais resultados:

- Apenas 2% da investigação em IA de 2017-2022 se centraram na segurança da IA

- A investigação em matéria de segurança da IA cresceu 315% nesse período, mas é inferior à investigação global em matéria de IA

- Os EUA lideram a investigação sobre segurança da IA, enquanto a China fica para trás

- Os principais desafios incluem a robustez, a equidade, a transparência e a manutenção do controlo humano

Muitos dos principais investigadores e especialistas em ética da inteligência artificial alertaram para os riscos existenciais que correm se a inteligência artificial geral (AGI) for desenvolvida sem salvaguardas e precauções suficientes.

Imaginemos um sistema AGI capaz de se aperfeiçoar recursivamente, ultrapassando rapidamente a inteligência humana e perseguindo objectivos desalinhados com os nossos valores. É um cenário que, segundo alguns, pode ficar fora do nosso controlo.

No entanto, não se trata de um tráfego de sentido único. De facto, um grande número de investigadores de IA acredita que A segurança da IA é exagerada.

Para além disso, há mesmo quem pense que a moda foi fabricada para ajudar as grandes empresas de tecnologia a aplicar regulamentos e a eliminar os concorrentes de código aberto.

No entanto, mesmo os sistemas de IA mais restritos de hoje em dia, treinados com base em dados anteriores, podem apresentar preconceitos, produzir conteúdos nocivos, violar a privacidade e ser utilizados de forma maliciosa.

Assim, embora a segurança da IA tenha de olhar para o futuro, também tem de abordar os riscos no aqui e agora, o que é indiscutivelmente insuficiente, uma vez que as falsificações profundas, a parcialidade e outras questões continuam a ser importantes.

Uma investigação eficaz sobre a segurança da IA deve abordar os desafios a curto prazo, bem como os riscos especulativos a mais longo prazo.

Os EUA lideram a investigação sobre segurança da IA

Analisando os dados em pormenor, os EUA são claramente o líder na investigação sobre segurança da IA, com 40% de publicações relacionadas, em comparação com 12% da China.

No entanto, os resultados da China em matéria de segurança estão muito aquém da sua investigação global em matéria de IA - enquanto 5% da investigação americana em matéria de IA incidiram na segurança, apenas 1% da investigação chinesa o fizeram.

Poder-se-ia especular que sondar a investigação chinesa é uma tarefa muito difícil. Além disso, a China tem sido pró-ativo em matéria de regulamentação - por isso, estes dados podem não dar ao sector da IA do país uma audição justa.

A nível institucional, a Universidade Carnegie Mellon, a Google, o MIT e Stanford lideram o grupo.

No entanto, a nível global, nenhuma organização produziu mais de 2% do total de publicações relacionadas com a segurança, o que realça a necessidade de um esforço maior e mais concertado.

Desequilíbrios de segurança

Então, o que é que se pode fazer para corrigir este desequilíbrio?

Isso depende de se pensar que a segurança da IA é um risco premente, a par da guerra nuclear, das pandemias, etc. Não há uma resposta clara a esta questão, o que faz da segurança da IA um tópico altamente especulativo com pouca reciprocidade acordo entre investigadores.

A investigação em matéria de segurança e a ética são também, de certa forma, um domínio tangencial à aprendizagem automática, exigindo diferentes conjuntos de competências, formações académicas, etc., que podem não ser bem financiados.

Para colmatar o défice de segurança da IA, será também necessário confrontar questões relacionadas com a abertura e o secretismo no desenvolvimento da IA.

As maiores empresas de tecnologia realizam uma extensa investigação interna sobre segurança que nunca foi publicada. À medida que a comercialização da IA aquece, as empresas estão a tornar-se mais protectoras das suas descobertas em matéria de IA.

A OpenAI, por exemplo, era uma potência de investigação nos seus primórdios.

A empresa costumava realizar auditorias independentes e aprofundadas dos seus produtos, dos preconceitos de rotulagem e dos riscos - tais como preconceito sexista no seu projeto CLIP.

A Anthropic continua ativamente empenhada na investigação sobre a segurança pública da IA, publicando frequentemente estudos sobre preconceito e desbloqueio.

A DeepMind também documentou a possibilidade de os modelos de IA estabelecerem "objectivos emergentes" e contradizerem ativamente as suas instruções ou tornarem-se adversários dos seus criadores.

No entanto, de um modo geral, a segurança passou para segundo plano em relação ao progresso, uma vez que o Silicon Valley vive de acordo com o seu lema "mover-se depressa e partir coisas".

O estudo de Georgetown sublinha, em última análise, que as universidades, os governos, as empresas tecnológicas e os financiadores da investigação têm de investir mais esforços e dinheiro na segurança da IA.

Alguns apelaram também a uma organismo internacional para a segurança da IAA Agência Internacional da Energia Atómica (AIEA) foi criada na sequência de uma série de incidentes nucleares que tornaram obrigatória uma cooperação internacional aprofundada.

Será que a IA vai precisar da sua própria catástrofe para conseguir esse nível de cooperação entre o Estado e as empresas? Esperemos que não.