As empresas de IA estão a insistir na regulamentação. A sua motivação é a paranoia ou o altruísmo? Ou será que a regulamentação garante objectivos competitivos?

No início de maio, Luke Sernau, um engenheiro de software sénior da Google, escreveu um memorando informal sobre IA de código aberto. Foi amplamente divulgado nos sistemas internos da Google antes de uma empresa de consultoria, a Semi-Analysis, verificado e publicado.

Eis alguns excertos:

"Na OpenAI, olhámos muito por cima dos nossos ombros. Quem é que vai ultrapassar o próximo marco? Qual será o próximo passo?

Mas a verdade incómoda é que não estamos posicionados para ganhar esta corrida ao armamento e a OpenAI também não. Enquanto andamos a discutir, uma terceira fação tem andado discretamente a comer-nos o almoço. Estou a falar, claro, do código aberto.

Em termos simples, estão a ultrapassar-nos. Coisas que considerávamos "grandes problemas em aberto" estão hoje resolvidas e nas mãos das pessoas. Embora os nossos modelos continuem a ter uma ligeira vantagem em termos de qualidade, a diferença está a diminuir de forma espantosamente rápida.

Os modelos de código aberto são mais rápidos, mais personalizáveis, mais privados e mais capazes. Estão a fazer coisas com params $100 e 13B que nós temos dificuldade em fazer com $10M e 540B. E estão a fazê-lo em semanas, não em meses.

No início de março, a comunidade de código aberto pôs as mãos no seu primeiro modelo de fundação realmente capaz, quando o LLaMA da Meta foi divulgado ao público.

Não tinha qualquer instrução ou sintonização de conversação, nem RLHF. No entanto, a comunidade compreendeu imediatamente o significado do que lhes tinha sido dado. Seguiu-se um tremendo surto de inovação, com apenas alguns dias de intervalo entre os principais desenvolvimentos...

Aqui estamos nós, apenas um mês depois, e há variantes com afinação de instruções, quantização, melhorias de qualidade, avaliações humanas, multimodalidade, RLHF, etc., etc., muitas das quais se baseiam umas nas outras. O mais importante é o facto de terem resolvido o problema do escalonamento ao ponto de qualquer pessoa poder mexer nele.

Muitas das novas ideias provêm de pessoas comuns. A barreira à entrada para a formação e a experimentação desceu da produção total de uma grande organização de investigação para uma pessoa, uma noite e um portátil robusto".

O memorando de Sernau foi divulgado pelas principais agências noticiosas e suscitou um debate sobre a questão de saber se a pressão das grandes empresas tecnológicas no sentido da regulamentação esconde um motivo para forçar a IA de fonte aberta a sair do jogo. Ben Schrekcinger, do Politico, escreveO código-fonte aberto é também mais difícil de proibir, uma vez que podem surgir novas instâncias se os reguladores tentarem encerrar um sítio Web ou uma ferramenta que o utilize. Combinados com outras características descentralizadoras, estes projectos de código aberto têm o potencial de perturbar não só o modelo de negócio de Silicon Valley, mas também os modelos de governação de Washington e Bruxelas".

A comunidade de IA de código aberto já está a prosperar. Os programadores estão a resolver desafios em dias que levam meses ou anos à Google e à OpenAI. Sernau argumenta que as comunidades ágeis de programadores de código aberto estão mais bem equipadas para construir modelos de iteração do que as grandes empresas de tecnologia, uma vez que são mais diversificadas, eficientes e pragmáticas.

Se for esse o caso, o domínio das grandes tecnologias sobre a IA poderá ser efémero.

A fuga do Meta LLaMA

O modelo LLaMA da Meta, um modelo de linguagem grande (LLM) como o ChatGPT, foi fuga de informação no 4chan uma semana depois de a empresa ter enviado os pedidos de acesso. Em 3 de março, uma torrente descarregável apareceu no fórum de mensagens e espalhou-se como um incêndio.

Como Sernau indica, a comunidade de código aberto procedeu à modificação do LLaMA, acrescentando funcionalidades impressionantes sem recursos informáticos empresariais.

A construção de modelos de IA poderosos é mais barata do que nunca e as comunidades de código aberto estão a fazer pressão para democratizar o acesso. Enquanto o LLaMA é um modelo em grande parte pré-treinado, outros modelos de código aberto, como o BLOOM, foram treinados por voluntários.

O treino do BLOOM exigiu um supercomputador equipado com 384 GPUs NVIDIA A100 de 80 GB que, felizmente, foi doado pelo governo francês. A empresa de IA de código aberto Together anunciou recentemente um financiamento inicial de $20m, e fornecedores de nuvem focados em IA como CoreWeave oferecer hardware a preços inferiores aos do mercado.

Os projectos de código aberto têm vários meios para concentrar recursos e ultrapassar as grandes empresas tecnológicas. As grandes empresas tecnológicas gostariam que pensássemos que as suas IA são o produto de décadas de trabalho e de milhares de milhões de dólares de investimento - a comunidade de código aberto provavelmente discorda.

Sobre o tema da segregação entre as grandes tecnologias e os projectos de IA mais pequenos, num evento na Índia, o antigo executivo da Google, Rajan Anandan, perguntou ao CEO da OpenAI, Sam Altman, se os engenheiros indianos poderiam construir modelos de IA fundamentais com um investimento de $10m.

Altman respondeu: "É totalmente inútil competir connosco na formação de modelos de base. Não devem tentar, e o vosso trabalho é gostar de tentar de qualquer forma. E eu acredito em ambas as coisas. Acho que é bastante inútil".

Mas, no seu memorando, Sernau afirma que o código aberto já está a competir com a grande tecnologia. Diz ele: "Manter uma vantagem competitiva na tecnologia torna-se ainda mais difícil agora que a investigação de ponta em LLMs é acessível. Os institutos de investigação de todo o mundo estão a desenvolver o trabalho uns dos outros, explorando o espaço de soluções de uma forma abrangente que ultrapassa em muito a nossa própria capacidade".

Os programadores de código aberto estão a criar alternativas às IA das grandes tecnologias e a ultrapassá-las em termos de desempenho e estatísticas de utilizadores.

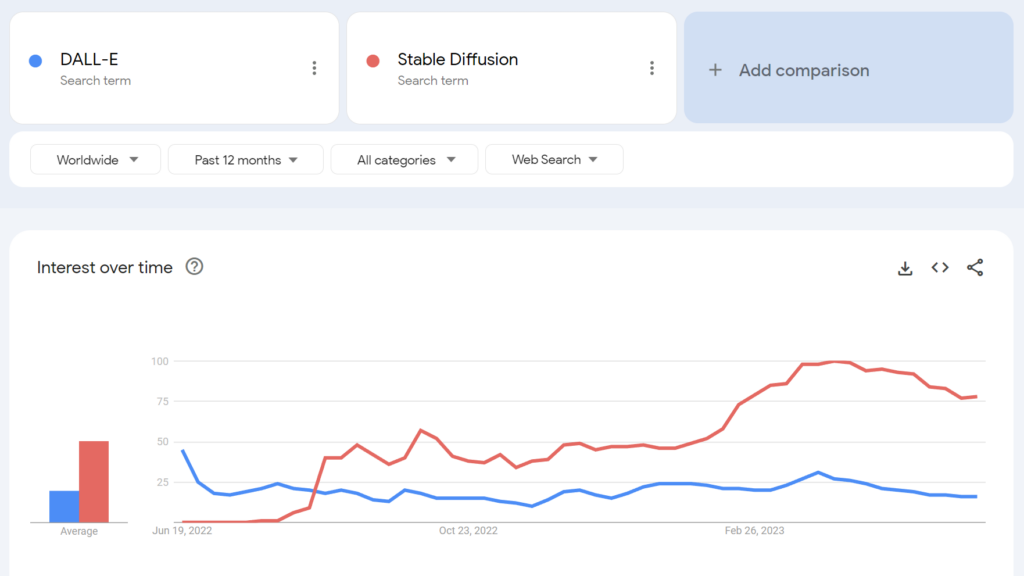

Por exemplo, o Stable Diffusion de código aberto tornou-se mais popular do que o DALL-E da OpenAI poucos meses após o seu lançamento.

Até que ponto é que podemos separar potenciais segundas intenções? Será que a pressão regulamentar das grandes tecnologias tem algum mérito altruísta?

A comunidade de IA de fonte aberta

Para além do LLaMA, existem pelo menos três grandes exemplos de projectos de IA de fonte aberta:

- Cara de abraço e BLOOM - A empresa de IA Hugging Face colaborou com mais de 1000 cientistas voluntários para desenvolver o BLOOM, um LLM de código aberto. O objetivo do BLOOM é oferecer uma contrapartida mais transparente e acessível aos modelos de IA proprietários.

- Juntos - Uma startup de IA chamada Together levantou com sucesso $20 milhões em financiamento inicial para apoiar seu objetivo de construir alternativas descentralizadas para sistemas fechados de IA. Eles revelaram várias iniciativas de IA generativa de código aberto, incluindo GPT-JT, OpenChatKit e RedPajama.

- Estabilidade IA - Em abril de 2023, a Stability AI, a empresa por detrás do Stable Diffusion, lançou o StableLM, uma sequência de alternativas de código aberto ao ChatGPT.

É importante notar que, embora alguns destes programadores (por exemplo, Stable Diffusion) ofereçam os seus modelos através de painéis de controlo intuitivos e fáceis de utilizar, outros, como o BLOOM, requerem recursos significativos para serem executados. Para começar, são necessários cerca de 360 GB de RAM para executar o BLOOM, mas existem muitos truques interessantes para reduzir os requisitos de recursos.

À medida que o preço do hardware com capacidade de IA diminui e os modelos de código aberto se tornam mais simples de implementar, é bem possível que praticamente qualquer pessoa possa implementar modelos semelhantes ao ChatGPT. A fuga de informação do memorando da Google cita exemplos de pessoas que ajustaram e implementaram o LLaMA em dispositivos de consumo, incluindo um MacBook.

Para empresas com recursos informáticos significativos, os modelos de fonte aberta poupam dinheiro e proporcionam soberania de dados e controlo sobre a formação e a otimização.

No entanto, nem todos estão optimistas quanto ao impacto da poderosa IA de código aberto. Por exemplo, o investigador de cibersegurança Jeffrey Ladis tweetou: "Preparem-se para montes de spam personalizado e tentativas de phishing" e "Abrir o código destes modelos foi uma péssima ideia".

A proliferação da IA torna-nos a todos menos seguros. Parece-me uma boa coisa a evitar, mas também um desafio bastante difícil!

Não ficaria surpreendido se um ator estatal conseguisse obter os modelos de fronteira da OpenAI no próximo ano ou dois https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 de maio de 2023

Outro observador tweetou: "O código aberto é uma ameaça, mas não da forma que pensas. É uma ameaça porque a IA nas mãos de pessoas que a podem utilizar para os seus próprios fins torna-se ainda mais difícil de regular ou controlar, e isso é um problema maior".

A Google e a OpenAI afirmam que têm medo da IA de fonte aberta, que "não há fosso" entre elas. Mas isso não é bem verdade.

O código aberto é uma ameaça, mas não da forma que se pensa. É uma ameaça porque a IA nas mãos de pessoas que a podem utilizar para os seus próprios fins torna-se ainda mais difícil de... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 de maio de 2023

Yann LeCun, frequentemente considerado um "padrinho da IA", juntamente com Geoffrey Hinton e Yoshio Bengman, argumenta o contrário"Quando os LLM se tornarem o principal canal através do qual toda a gente acede à informação, as pessoas (e os governos) irão *exigir* que esta seja aberta e transparente. A infraestrutura básica deve ser aberta".

LeCun também discordou das narrativas tradicionais sobre os riscos da IA: "Penso que a magnitude do problema do alinhamento da IA foi ridiculamente exagerada e a nossa capacidade de o resolver foi amplamente subestimada". Elon Musk ripostou no Twitter, dizendo: "Achas mesmo que a IA é uma espada de um só gume?"

Achas mesmo que a IA é uma espada de um só gume?

- Elon Musk (@elonmusk) 1 de abril de 2023

Outros comentadores traçaram paralelos entre a regulamentação da IA e a criptografia, em que o governo dos EUA tentou proibir métodos criptográficos públicos através de classificando-as como "munições" - apelidada de "Crypto Wars".

Agora, praticamente toda a gente tem o direito de utilizar a encriptação - mas essa batalha foi ganha com dificuldade - como poderá ser o caso da IA de código aberto.

A alienação da IA de fonte aberta pela OpenAI

O código aberto é mais do que apenas software, código e tecnologia. É o princípio, a mentalidade ou a crença de que um ambiente de trabalho cooperativo, aberto e transparente supera a concorrência num mercado fechado.

A OpenAI, outrora uma empresa sem fins lucrativos centrada na cooperação pública e no desenvolvimento de código aberto, tem vindo a afastar-se progressivamente do seu nome.

A startup passou a ser uma empresa "com fins lucrativos" em 2019, terminando efetivamente a relação da empresa com a comunidade de código aberto. O investimento da Microsoft desvinculou a OpenAI de qualquer tipo de actividades de I&D "abertas".

Em meados de maio, a empresa anunciou um modelo de código aberto em preparaçãomas não foram directos quanto aos pormenores.

Agora, a OpenAI está a pressionar para que a regulamentação atinja mais duramente as empresas de IA emergentes, para não falar da potencial criminalização da comunidade de código aberto.

Este facto levou alguns a criticar a pressão da OpenAI para a regulamentação como sendo apenas um negócio - o negócio de proteger os seus modelos lucrativos das comunidades de código aberto que procuram democratizar a IA.

A IA de código aberto é um risco para as grandes empresas de tecnologia?

A combinação do memorando divulgado pela Google, a pressão das grandes empresas tecnológicas no sentido da regulamentação e o desprezo de Altman pelos projectos de IA de base levantam algumas sobrancelhas. De facto, a legitimidade dos riscos da IA - que justificam a regulamentação - tem sido questionada.

Por exemplo, quando o Centro para a Segurança da IA (CAIS) publicou a sua declaração sísmica sobre o risco da IA, co-assinada por vários CEOs da IA, alguns observadores externos não ficaram convencidos.

Numa seleção de reacções de peritos à declaração publicado pelo Science Media CentreA Dra. Mhairi Aitken, Ethics Research Fellow no Alan Turing Institute, afirmou:

"Recentemente, estas alegações têm vindo cada vez mais de grandes actores da tecnologia, predominantemente de Silicon Valley. Embora alguns sugiram que isso se deve ao facto de estarem conscientes dos avanços da tecnologia, penso que, na realidade, está a servir como uma técnica de distração. Está a desviar a atenção das decisões das grandes empresas tecnológicas (pessoas e organizações) que estão a desenvolver a IA e a impulsionar a inovação neste domínio e, em vez disso, a concentrar a atenção em cenários futuros hipotéticos e nas capacidades futuras imaginárias da IA."

Há quem defenda que as grandes empresas tecnológicas têm o poder de dedicar recursos à ética, à governação e ao controlo, o que lhes permite evitar o pior da regulamentação e continuar a vender os seus produtos.

No entanto, é simultaneamente problemático denunciar os riscos da IA como fantasia e afirmar que a regulamentação não tem qualquer valor.

Há cépticos em ambos os campos

Considerar os riscos da IA como puramente especulativos pode revelar-se um erro crítico para a humanidade.

De facto, há décadas que comentadores sem conflito de interesses alertam para a IA, incluindo o falecido Professor Stephen Hawking, que afirmou que a IA "poderia significar o fim da raça humana" e ser o "pior acontecimento na história da nossa civilização".

Embora alguns possam argumentar que as grandes tecnologias estão a usar visões de um apocalipse da IA para reforçar as estruturas de mercado e aumentar as barreiras à entrada, isso não eclipsa a legitimidade dos riscos da IA.

Por exemplo, as equipas de investigação de IA já provaram a capacidade da IA para estabelecer objectivos emergentes com consequências potencialmente desastrosas.

Outras experiências mostram que as IA podem ativamente recolher recursos, acumular energia e tomar medidas proactivas para evitar que sejam "desligadas". Estudos credíveis sugerem que, pelo menos, alguns riscos da IA não são demasiado exagerados.

Pontos de vista compatíveis?

A questão é: podemos confiar em nós próprios com uma IA excecionalmente poderosa? "Nós" somos humanos em todo o lado, a todos os níveis, desde os grandes laboratórios de investigação tecnológica até às comunidades que constroem IA de código aberto.

As grandes empresas tecnológicas podem querer consolidar as estruturas de mercado e, ao mesmo tempo, fomentar preocupações genuínas sobre o futuro da IA. As duas coisas não são necessariamente mutuamente exclusivas.

Entretanto, o crescimento da IA de código aberto é inevitável e a regulamentação arrisca-se a provocar descontentamento entre uma comunidade que detém uma das tecnologias mais perigosas da humanidade.

Já é demasiado tarde para subjugar a IA de fonte aberta através de regulamentação, e tentar fazê-lo poderá conduzir a uma era destrutiva de proibição da IA.

Simultaneamente, os debates em torno dos perigos da IA devem ser orientados pelas provas - o único sinal objetivo que temos do potencial de dano da tecnologia.