Um grupo de programadores de Chicago equipou os artistas com o Nightshade, um método de luta contra práticas de dados pouco éticas.

O Nightshade é uma ferramenta sofisticada concebida para proteger obras de arte digitais contra a utilização não autorizada no treino de IA, introduzindo amostras "venenosas".

Estas alterações são imperceptíveis ao olho humano, mas perturbam o processo de aprendizagem da IA, conduzindo a associações e respostas incorrectas.

O os investigadores escrevem"Os olhos humanos podem ver uma imagem sombreada de uma vaca num campo verde praticamente inalterada, mas um modelo de IA pode ver uma grande bolsa de couro deitada na relva".

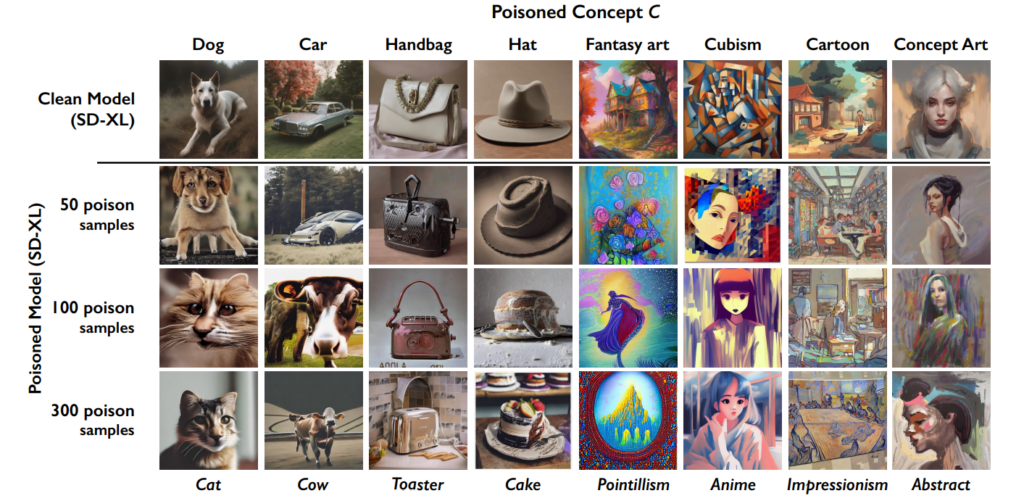

O efeito acumula-se, pelo que quanto mais imagens "envenenadas" existirem num conjunto de dados, mais o desempenho do modelo se deteriora.

Esta ferramenta vem juntar-se à anterior criação da Universidade de Chicago, Glaze, que também ajuda os artistas a combater a recolha de dados. "O Glaze pode mudar coisas como cores e pinceladas, apresentando um estilo artístico diferente do que está realmente lá", explicam os criadores.

No entanto, Nightshade diverge de Glaze na abordagem. "Enquanto o Glaze era uma ferramenta defensiva, o Nightshade foi concebido para ser uma ferramenta ofensiva", afirma a equipa.

É com grande entusiasmo que partilho que "Artifact" foi envidraçado e Nightshaded por @TheGlazeProject e que peça perfeita para ele também. Esta é uma pintura sobre a IA generativa que canibaliza a voz autêntica dos criativos humanos. Quando esta imagem é raspada para treino, bem... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14 de janeiro de 2024

Como funciona o Nightshade em cinco passos

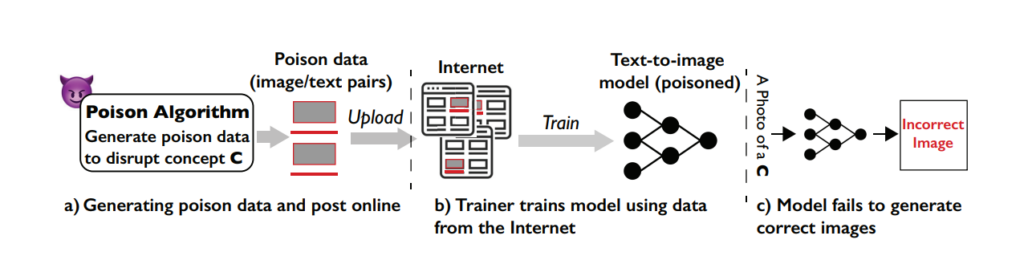

O Nightshade é uma ferramenta inteligente que utiliza as funções de aprendizagem automática envolvidas na formação de modelos contra o próprio sistema, envenenando o processo de aprendizagem e conduzindo a resultados mais fracos em diferentes modelos.

Compreender a vulnerabilidade

O ataque Nightshade explora uma fraqueza específica nos modelos geradores de texto para imagem. Estes modelos de IA são treinados em vastos conjuntos de dados de imagens e correspondentes descrições de texto.

No entanto, a equipa da Universidade de Chicago descobriu que a quantidade de dados de treino é bastante limitada para determinados prompts ou temas específicos. Este conjunto de dados limitados para prompts específicos torna estes modelos vulneráveis a ataques de envenenamento de dados direccionados.

O conceito por detrás de Nightshade

O Nightshade é um método sofisticado concebido para executar o que é conhecido como um ataque de envenenamento específico do prompt.

Em termos mais simples, é como introduzir um pequeno erro, cuidadosamente concebido, no processo de aprendizagem da IA, que conduz a erros significativos e direccionados quando a IA gera imagens com base em determinadas instruções.

A principal caraterística do Nightshade é a sua capacidade de produzir amostras "envenenadas" que parecem normais aos olhos humanos, mas que são radicalmente diferentes na forma como a IA as percepciona e aprende com elas.

Criação de amostras de veneno

Para executar um ataque Nightshade, os investigadores começam por gerar aquilo a que chamam "imagens âncora". Trata-se de imagens de um conceito não relacionado com o objetivo real do ataque.

Por exemplo, se o conceito-alvo for "cão", as imagens-âncora podem ser de "gatos". Estas imagens-âncora são geradas por um modelo de IA que os utilizadores executam no seu PC.

Em seguida, os investigadores encontram imagens reais do conceito-alvo (como cães) e modificam-nas subtilmente para que se alinhem com as características das imagens-âncora na perceção da IA.

Para um humano, estas imagens modificadas continuam a parecer cães, mas para a IA, assemelham-se muito a gatos. Embora este possa ser um conceito difícil de compreender, é importante lembrar que as formas e os formatos que criam as imagens são sempre fundamentalmente semelhantes.

As alterações são chamadas perturbações adversárias. São cuidadosamente calculadas para deslocar a representação da imagem no espaço de características da IA da região associada aos gatos para a região associada aos cães.

Como o ataque afecta os modelos de IA

Quando um modelo generativo de IA é treinado nestas amostras envenenadas, começa a associar as características do conceito não relacionado (gatos) ao conceito alvo (cães).

Consequentemente, quando solicitado a gerar imagens de cães, o modelo de IA pode produzir imagens de gatos. Isto deve-se ao facto de o modelo entender o que é um "cão" de forma distorcida devido aos dados envenenados.

Embora isto não "quebre" completamente um modelo de IA, torna-o menos eficaz e mais imprevisível, o que pode certamente afetar a usabilidade.

As empresas de IA irão provavelmente lutar contra a Nightshade e técnicas semelhantes, mas isso vai exigir tempo e esforço.

Impacto

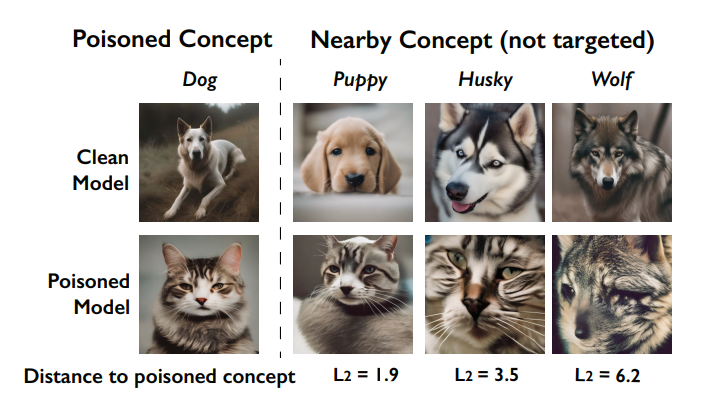

Um dos principais impactos do ataque Nightshade é o seu efeito de "sangramento". Isto significa que o envenenamento de um conceito pode afetar conceitos relacionados.

Por exemplo, envenenar o conceito de "cães" pode também afetar a forma como o modelo gera imagens de animais relacionados, como "lobos" ou "raposas".

são corrompidos pelo envenenamento (chamado de efeito de sangramento). Fonte: Universidade de Chicago via ArXiv

Além disso, quando vários conceitos são envenenados num modelo, isso pode quebrar a capacidade do modelo de gerar imagens coerentes para uma vasta gama de solicitações.

Como é que os artistas podem utilizar o Nightshade

O Nightshade é uma ferramenta que pode descarregar e utilizar, mas consome muitos recursos, exigindo uma GPU Nvidia compatível com pelo menos 4G de memória.

Este processo pode ser simplificado no futuro, ou podem existir serviços na nuvem onde pode simplesmente carregar as suas imagens para que o Nightshade'd as processe por si.

Eis como utilizar o Nightshade:

- Seleccione o seu trabalho artístico: Pode arrastar uma única imagem para o espaço reservado à imagem ou selecionar várias imagens utilizando o botão "Selecionar...".

- Ajustar os parâmetros: A intensidade determina a força do efeito de Nightshade. Uma intensidade mais elevada leva a uma perturbação mais potente, mas pode causar alterações visíveis no seu trabalho artístico. A qualidade de renderização indica o tempo de cálculo para encontrar o nível ótimo de veneno. Uma qualidade mais alta equivale a um veneno mais forte, mas requer mais tempo. Se tiveres uma GPU, este processo será mais rápido.

- Escolher o diretório de saída: Seleccione o local onde pretende guardar as imagens de sombreado noturno.

- Selecionar etiqueta de veneno: O Nightshade funciona enganando a IA sobre determinados conceitos na sua imagem. Por exemplo, pode alterar imagens marcadas como "carro" para serem vistas como "vaca" pelos modelos de IA. O Nightshade sugere uma etiqueta com base na sua análise de conteúdo ao selecionar a sua imagem. Certifique-se de que a etiqueta reflecte com precisão o conceito-chave da sua imagem e ajuste-a, se necessário. A eficácia do Nightshade aumenta quando a sua imagem é associada a esta etiqueta através de texto alternativo, legendas ou texto próximo.

- Executar Nightshade: Depois de finalizar as suas definições e confirmar a etiqueta da imagem, inicie o processo premindo o botão "Run" (Executar). As imagens alteradas serão guardadas no diretório de saída escolhido.

- Instruções pormenorizadas no guia do utilizador oficial aqui.

Receção da comunidade à receção da Nightshade

Tem havido um apoio esmagador aos artistas que tentam defender o seu trabalho da IA, mas, como sempre, há múltiplas facções, com alguns a compararem-no a um ataque cibernético aos modelos de IA.

Em resposta aos críticos, a equipa esclarece: "O objetivo do Nightshade não é quebrar modelos, mas aumentar o custo da formação em dados não licenciados, de modo a que o licenciamento de imagens dos seus criadores se torne uma alternativa viável".

"Utilizado de forma responsável, o Nightshade pode ajudar a dissuadir os formadores de modelos que desrespeitam os direitos de autor, as listas de exclusão e as directivas do-not-scrape/robots.txt", afirmam.

O debate em torno da recolha de dados e do treino de modelos de IA tornou-se extremamente amargo na sequência da controvérsia na Midjourney e de um dilúvio de empresas que utilizam obras de arte geradas por IA, substituindo o trabalho humano no processo.

O Nightshade foi lançado!

O Nightshade envenena os modelos de IA se a tua arte ou imagens forem tiradas sem autorização, o Glaze protege-te da imitação de IA. Recomenda-se que uses primeiro o Nightshade e depois o Glaze. Está a chegar uma versão que faz as duas coisas.

Leia este tópico para obter mais informações.

Vai apanhá-los 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19 de janeiro de 2024

De repente, parece que há um vazio cada vez maior entre as empresas de tecnologia que comercializam a IA como uma força filantrópica e o público, que sente que ela está a invadir demasiado a cultura e a sociedade.

De facto, o Nightshade não é apenas útil para os artistas. As pessoas estão a encorajar o maior número possível de pessoas a utilizar estas ferramentas, criando um conjunto mais pequeno de dados de alta qualidade para as empresas de IA explorarem.

Mas será que as empresas já têm dados suficientes? Talvez por agora, mas para manter os modelos contemporâneos e actualizados, os criadores de IA terão de introduzir novos dados nos seus sistemas a qualquer momento.

#nightshade

Dica profissional: utilize o Nightshade em tudo o que carrega online (não apenas na sua arte), fotografias de redes sociais, fotografias diárias sobre a sua refeição, família, cachorros, gatinhos, selfies aleatórias e fotografias de rua - e deixe o jogo começar.- editar ballai 🌿 (@eballai) 19 de janeiro de 2024

Em Glaze e Nightshade, assistimos a uma batalha tecnológica e ética emergente entre criadores e empresas de IA.

Vai tornar-se cada vez mais interessante, e será que existem formas semelhantes de enganar e envenenar os modelos linguísticos?

Este facto, combinado com as batalhas legais, poderá fazer com que a IA generativa entre num período volátil. Vai ser um grande ano para esta tecnologia.