Mistral AI é uma startup francesa de IA que está ganhando manchetes com seus modelos leves de código aberto. Juntamente com a atenção, veio um novo lote de financiamento, uma vez que garantiu investimentos de 385 milhões de euros, ou $414 milhões, esta semana.

A segunda ronda de financiamento da empresa foi liderada pelas empresas de capital de risco Andreessen Horowitz e Lightspeed Venture Partners.

A discussão sobre modelos de código aberto versus modelos proprietários está em curso e a Mistral AI está firmemente do lado do código aberto.

Empresas como a OpenAI têm estado criticado pelo seu discurso de medo sobre a segurança dos modelos de código aberto, com muitos a dizerem que se trata de um caso em que as grandes empresas de tecnologia estão a tentar manter a sua hegemonia.

A Mistral AI afirma que, ao treinar os seus próprios modelos "libertando-os abertamente e promovendo as contribuições da comunidade, podemos criar uma alternativa credível ao oligopólio emergente da IA. Os modelos generativos de peso aberto desempenharão um papel fundamental na próxima revolução da IA".

Vários grandes investidores confirmaram a sua confiança nesta estratégia. O financiamento que a Mistral AI assegurou esta semana fez com que a empresa fosse avaliada em $2 mil milhões. Trata-se de um aumento de 7x na avaliação nos seis meses desde o lançamento da empresa.

Mixtral 8x7B

Em setembro, foi lançado o Mistral 7B, o pequeno mas poderoso LLM da Mistral AI, que bateu ou igualou modelos de código aberto maiores, como Lhama da Meta 2 34B.

Os modelos proprietários GPT da OpenAI são corretamente considerados como o padrão de ouro na comparação do desempenho dos modelos. Com o novo modelo da Mistral AI, Mixtral 8x7BA empresa obteve um importante direito de se gabar neste domínio.

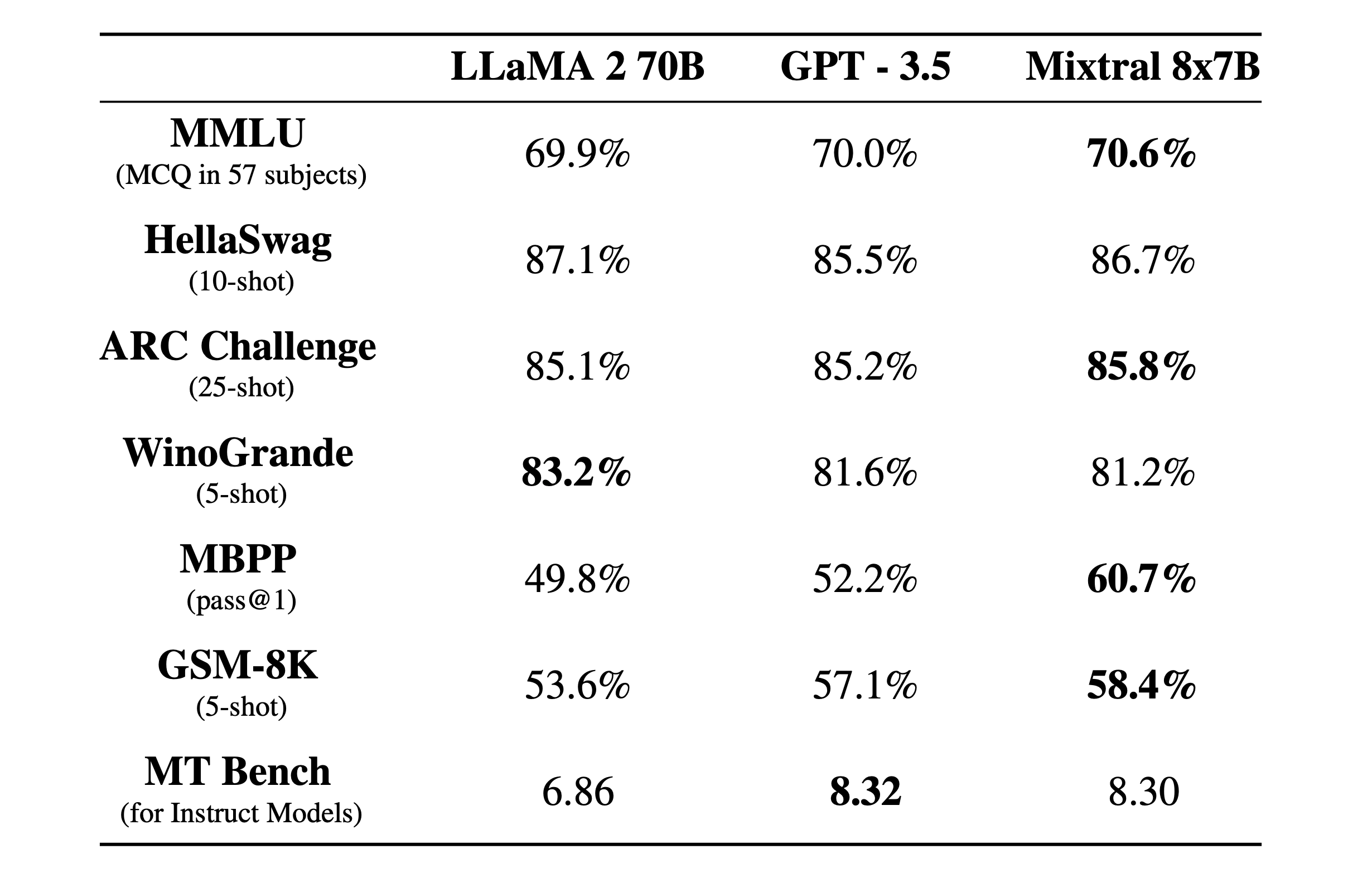

Mixtral 8x7B é um mistura esparsa de peritos com uma janela de contexto de 32k. Aqui está o seu desempenho em testes de benchmark em comparação com o Llama 2 e o GPT-3.5.

Os testes de referência são uma boa forma de ter uma ideia da qualidade de um modelo no desempenho de diferentes funções. Os testes acima foram:

- MMLU (MCQ em 57 disciplinas): Significa perguntas de escolha múltipla em 57 disciplinas.

- HellaSwag (10 tiros): Avalia a capacidade da IA para prever o final de um cenário, depois de lhe serem dados 10 exemplos.

- Desafio ARC (25 disparos): Testa a compreensão da IA sobre conceitos científicos e raciocínio depois de lhe serem dados 25 exemplos para aprender antes de ser testada.

- WinoGrande (5 tentativas): Testa o raciocínio de senso comum com base na resolução de ambiguidades em frases, com 5 exemplos para a IA aprender.

- MBPP (pass@1): Testa a capacidade de um modelo de IA para gerar trechos de código Python correctos. A métrica pass@1 mede a percentagem de problemas em que a primeira conclusão do modelo estava correcta.

- GSM-8K (5 disparos): O parâmetro de referência Grade School Math 8K testa a capacidade de uma IA para resolver problemas de matemática ao nível esperado na escola primária, depois de lhe serem fornecidos 5 exemplos.

- MT Bench (para modelos de instrução): O MT Benchmark para modelos de instrução mede a capacidade de uma IA para seguir instruções no contexto de tarefas de tradução.

O que é ainda mais impressionante do que os resultados dos testes de referência é o facto de o Mixtral 8x7B ser pequeno e eficiente. Este modelo pode ser executado localmente num portátil decente com cerca de 32 GB de RAM.

Com muito mais dinheiro à sua disposição, podemos esperar alguns desenvolvimentos interessantes da Mistral AI.