Num passado não muito distante, as conversas sobre IA estavam essencialmente confinadas aos domínios da ficção científica e dos trabalhos académicos.

Hoje em dia, a IA está profundamente integrada no tecido da vida quotidiana, desde a alimentação de casas inteligentes até ao diagnóstico de doenças.

Mas à medida que a tecnologia de IA avança, os quadros regulamentares estão a tentar recuperar o atraso, ficando frequentemente aquém da curva da inovação.

Isto coloca a humanidade perante um puzzle multifacetado: como elaborar leis e regulamentos suficientemente ágeis para se adaptarem às rápidas mudanças tecnológicas, mas suficientemente robustos para proteger os interesses da sociedade?

Em todo o mundo, os esforços regulamentares estão longe de ser uniformes. A União Europeia (UE) está a preparar o terreno com a sua abrangente Lei da IA, que visa categorizar e controlar as aplicações de IA com base no seu nível de risco.

Entretanto, os EUA privilegiaram os compromissos voluntários em detrimento de legislação imediata.

A China, por outro lado, exerce um controlo apertado sobre a IA, alinhando a regulamentação com objectivos mais amplos de governação política e social.

E não esqueçamos as outras jurisdições - a IA é um fenómeno global que exigirá uma legislação quase universal cobertura.

Então, onde está a regulamentação atualmente e como se espera que progrida?

A abordagem da UE

A UE adoptou um quadro rigoroso com a sua inovadora Lei da IA, que deverá ser totalmente aprovada até ao final do ano.

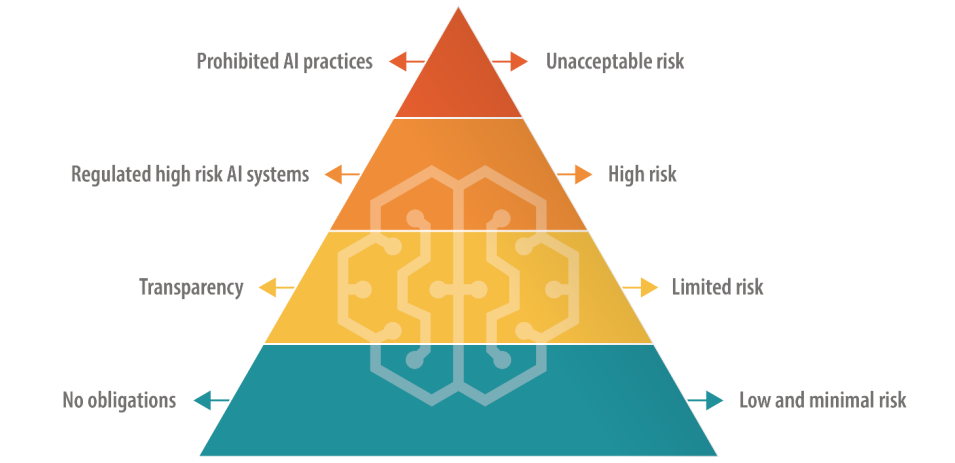

A Lei da IA especifica quatro níveis, incluindo "IAs de risco inaceitável", "IAs de alto risco", "IAs de risco limitado" e "IAs de baixo risco", cada uma com um conjunto específico de directrizes e proibições.

As IA de risco inaceitável representam perigos imediatos ou consideráveis, tais como causar danos físicos ou mentais ou violar os direitos humanos - e serão totalmente proibidas.

As IA de alto risco são permitidas, mas estão sujeitas a regulamentos rigorosos, desde a gestão do risco à documentação técnica e à cibersegurança.

As IA limitadas e de baixo risco, por outro lado, permanecem predominantemente não regulamentadas, mas são obrigadas a manter a transparência com os utilizadores.

Existe um alívio a curto prazo, uma vez que a legislação inclui um período de carência de cerca de dois anos para as empresas se adaptarem aos novos regulamentos.

A UE propõe que os criadores originais dos modelos de IA sejam responsáveis pela forma como a sua tecnologia é utilizada, mesmo quando incorporada num sistema diferente por outra empresa ou programador. Foram também adicionadas novas regras para "modelos de base", que incluem modelos de IA generativos.

A receção do AI Act varia - alguns criticam as suas definições desajeitadas e o seu potencial para minar a inovação. Por exemplo, existe uma incerteza considerável quanto à forma como os diferentes modelos de IA se classificam em categorias de risco.

Além disso, as empresas de IA mais pequenas receiam não ter os recursos necessários para se dedicarem à conformidade.

Sam Altman, Diretor Executivo da OpenAI brevemente ameaçado para retirar os produtos da sua empresa do mercado da UE se a Lei da IA especificasse requisitos que não podem ser realisticamente cumpridos.

Em junho, 150 grandes empresas salientou a abordagem pesada da leiafirmando que as regras actuais correm o risco de destruir a competitividade europeia.

Divergência em relação aos EUA

A Análise de Stanford da Lei da IA discutiu as diferenças fundamentais entre as abordagens da UE e dos EUA à regulamentação da IA.

Alex Engler, membro da equipa de Estudos de Governação da Brookings Institution, disse: "Há uma disparidade crescente entre a abordagem dos EUA e da UE [para regulamentar a IA]".

Salienta que a UE fez pressão no sentido da adoção de leis em matéria de privacidade e transparência dos dados, que continuam a não existir nos EUA. A disparidade confunde a conformidade para as empresas de IA, e os custos associados à conformidade entre jurisdições podem ser excessivos.

"Os interesses corporativos vão lutar com unhas e dentes se houver duas normas dramaticamente diferentes para as plataformas em linha", disse Engler.

De um modo geral, é difícil imaginar que as empresas de tecnologia não encontrem uma forma de navegar na Lei da IA, tal como fizeram com o GDPR e terão de fazer com a recente Lei dos Serviços Digitais.

Falando para o revista NatureDaniel Leufer, analista sénior de políticas da Access Now, rejeita as objecções da indústria da IA à lei como sendo apenas "a habitual ostentação".

A abordagem do Reino Unido

Após o Brexit, o Reino Unido pretende capitalizar a sua independência da UE para formular um regime regulamentar mais flexível e específico para o sector.

Ao contrário da Lei da IA, o Governo do Reino Unido tenciona regulamentar as aplicações da IA e não o próprio software subjacente.

Uma atitude "pró-inovação

O governo do Reino Unido publicou um livro branco em março que define um quadro "pró-inovação", convidando as partes interessadas a partilhar os seus pontos de vista. No entanto, o governo ainda não emitiu directrizes para a aplicação deste quadro.

O governo irá ajudar o Reino Unido a aproveitar as oportunidades e os benefícios que as tecnologias de IA apresentam", uma abordagem criticada por não prestar a devida atenção aos danos relacionados com a IA.

O governo tinha mesmo planeado oferecer às empresas de IA uma "isenção de direitos de autor" extremamente controversa, mas Reviravolta no plano em agosto.

Ultimamente, a Grã-Bretanha tem tido dificuldade em atrair a inovação tecnológica, nomeadamente ao perder o fabricante de chips Arm, de Cambridge, que optou por cotar as suas acções nos EUA em vez de o fazer no país. Esta situação está talvez a alimentar a ansiedade do Reino Unido em reacender o seu sector tecnológico em declínio.

Para ajudar a posicionar o Reino Unido como um país com visão de futuro em matéria de IA, o Primeiro-Ministro Rishi Sunak anunciou uma conferência de dois dias Cimeira de Segurança da IA que terá lugar em novembro.

Nomeadamente, a China foi convidada para o evento - embora haja especulações de que será excluída por receios de espionagem.

A abordagem dos EUA

Nos EUA, o objetivo é permitir que a indústria se auto-regule, pelo menos por enquanto.

O Congresso dos EUA está a dar sinais de uma abordagem do tipo "esperar para ver", iniciando uma análise das reuniões à porta fechada sobre a IA e o relatório de Chuck Schumer Fóruns AI Insight para determinar com exatidão onde a IA exige nova regulamentação.

Os acordos bipartidários podem girar em torno de legislação específica sobre privacidade, transparência das plataformas ou proteger as crianças em linha.

Além disso, alguns sublinharam que as leis e regulamentos existentes continuam a ser relevantes para a IA.

Em junho, Khan disseÀ medida que estas coisas se tornam mais integradas na forma como as decisões diárias são tomadas, penso que convidam e merecem um grande escrutínio... Penso que os responsáveis pela aplicação da lei, seja a nível estatal ou nacional, vão atuar".

Quadros voluntários e soluções de emergência

Empresas tecnológicas proeminentes como a Microsoft, a OpenAI, a Google, a Amazon e a Meta assinou compromissos voluntários para o desenvolvimento seguro da IAincluindo a realização de testes internos e externos de modelos de IA antes da sua divulgação pública.

Muitos líderes da indústria tecnológica avançaram com os seus próprios compromissos, mas em Na ausência de um controlo legislativo sólido, a sinceridade destas promessas ainda não foi posta à prova.

Em suma, os críticos afirmam que a abordagem dos EUA é essencialmente simbólica, não tendo a profundidade e o empenhamento do AI Act da UE. O primeiro Fórum de Perceção da IA foi um evento em grande parte à porta fechada que alguns criticaram por restringir o debate aberto.

O senador Josh Hawley disse que o evento era uma "festa de cocktail gigante".

Como Ryan Calo, professor da Faculdade de Direito da Universidade de Washington, resumiu adequadamente: "Há a aparência de atividade, mas nada de substantivo e vinculativo".

A abordagem chinesa

A China, proporcionalmente à sua apetência pelo controlo estatal, está a impor alguns dos regulamentos mais rigorosos em matéria de IA.

A ênfase é colocada no controlo da divulgação de informações pela IA, reflectindo os quadros de governação política e social mais amplos da China.

Por exemplo, os fornecedores de IA generativa cujos produtos possam "ter impacto na opinião pública" são obrigados a submeter-se a análises de segurança.

A primeira vaga de chatbots aprovados, incluindo o ERNIE Bot da Baidu, foi recentemente divulgado ao público e que censurava perguntas de carácter político.

O aumento de "deep fakes" e de conteúdos gerados por IA coloca desafios a nível mundial e a China não é exceção. Reconhecendo as potenciais armadilhas da IA relativamente cedo no ano, a Administração do Ciberespaço da China (CAC) exige que os geradores de conteúdos gerados por IA sejam submetidos a processos de verificação da identidade dos utilizadores.

Além disso, foram introduzidas disposições em matéria de marcas de água para distinguir os conteúdos gerados por IA dos criados por humanos, regras que as potências ocidentais também procuram aplicar.

Divergência entre os EUA e a China

A IA acelerou a fricção entre os EUA e a China, desencadeando aquilo a que muitos chamaram uma "Guerra Fria Digital" - ou talvez mais apropriadamente, uma "Guerra Fria da IA".

As restrições impostas pelos EUA à colaboração e ao comércio com a China não são novidade, mas a dissociação entre os dois países deu um passo em frente quando Xi Jinping anunciou a sua nova e reformada Plano "Made in China 2025.

O objetivo é tornar a China autossuficiente em sectores tecnológicos cruciais até 2025, incluindo a tecnologia de IA de ponta.

Atualmente, os EUA são cortar o financiamento e a investigação laços com a China, ao mesmo tempo que subjuga a sua aquisição de chips de IA a empresas como a Nvidia.

Embora os EUA tenham uma clara vantagem na corrida pelo domínio da IA, a China tem alguns truques na manga, incluindo uma abordagem centralizada da regulamentação e dados pessoais quase ilimitados.

Em maio, Edith Yeung, sócia da empresa de investimentos Race Capital, disse à BBCA China tem muito menos regras em matéria de privacidade e muito mais dados [em comparação com os EUA]. Há reconhecimento facial CCTV em todo o lado, por exemplo".

A estreita ligação entre o governo e a indústria tecnológica da China também traz vantagens, uma vez que a partilha de dados entre o governo e as empresas tecnológicas nacionais é praticamente ininterrupta.

Os EUA e outras jurisdições ocidentais não partilham o mesmo acesso a dados comerciais e pessoais, que são a força vital dos modelos de aprendizagem automática. De facto, já existem preocupações de que os modelos de aprendizagem automática as fontes de dados estão a "esgotar-se".'

Além disso, a utilização liberal, por parte das empresas ocidentais de IA, de dados de treino potencialmente protegidos por direitos de autor causou um alvoroço generalizado e acções judiciais.

É provável que as empresas de IA da China não sofram desse problema.

Equilíbrio entre acessibilidade e risco

A IA esteve outrora confinada ao mundo académico e às grandes empresas. No espaço de cerca de um ano, entre um quarto e metade dos adultos no Reino Unido, nos EUA e na UE utilizaram a IA generativa.

A acessibilidade tem muitas vantagens, incluindo o incentivo à inovação e a redução dos obstáculos à entrada de empresas em fase de arranque e de programadores individuais. No entanto, também suscita preocupações quanto à potencial utilização indevida que advém do acesso não regulamentado.

O recente incidente em que o modelo de linguagem Llama-1 da Meta foi divulgada na Internet exemplifica os desafios da contenção da tecnologia de IA. Os modelos de IA de fonte aberta já foram utilizados para fins fraudulentos e para gerar imagens de abuso de crianças.

As empresas de IA sabem-noe os modelos de código aberto ameaçam a sua vantagem competitiva. A Meta surgiu como uma espécie de antagonista do sector, lançando uma série de modelos gratuitos enquanto outros, como a Microsoft, a OpenAI e a Google, lutam para rentabilizar os seus produtos de IA.

Outros modelos de código aberto, como o Falcão 180B LLMsão excecionalmente poderosos, mas carecem de proteção.

Há quem especule que as grandes empresas de IA estão a insistir na regulamentação, uma vez que esta força os intervenientes mais pequenos e a comunidade de código aberto a saírem do ringue, permitindo-lhes manter o domínio sobre o sector.

O enigma da dupla utilização da IA

Outro fator complexo é a dupla ou múltipla aplicação da IA.

Os mesmos algoritmos que podem melhorar a nossa qualidade de vida também podem ser transformados em armas ou aplicados em contextos militares. Este pode ser o calcanhar de Aquiles do quadro heurístico do Ato UE sobre a IA - como interpretar as IA úteis que podem ser modificadas para causar danos?

A regulamentação da tecnologia de dupla utilização é notoriamente complexa. A aplicação de controlos rigorosos pode asfixiar a inovação e o crescimento económico quando apenas uma pequena minoria utiliza indevidamente uma tecnologia de IA.

As empresas de IA podem contornar a culpa criando políticas contra a utilização indevida, mas isso não impede as pessoas de utilizarem 'jailbreaks' para induzir os modelos a produzir material ilícito.

Equilíbrio entre os benefícios económicos da IA e as preocupações éticas

Os benefícios da IA são economicamente convincentes, especialmente em sectores como os cuidados de saúde, a energia e a indústria transformadora.

Relatórios por McKinsey e a PwC prevêem que a IA contribuirá anualmente com biliões para a economia global, independentemente do impacto da substituição de postos de trabalho e dos despedimentos.

A IA pode ser vista como uma via para a criação de emprego e para o crescimento dos países que se debatem com problemas económicos.

Numa escala filosófica mais alargada, a IA é por vezes retratada como a salvadora da humanidade no meio de questões de nível macro, como a pobreza, as alterações climáticas e o envelhecimento da população.

Os governos ocidentais - em particular os EUA e o Reino Unido - parecem inclinados a fomentar o crescimento através de incentivos fiscais, financiamento da investigação em IA e uma abordagem regulamentar laissez-faire.

Esta é uma aposta que os EUA fizeram no passado ao permitir que a indústria tecnológica se auto-regulamentasse, mas será que continua a dar frutos?

WSerá que as previsões pessimistas que comparam a IA a "guerras nucleares" e a "pandemias globais" vão acabar com as visões românticas do potencial da tecnologia para ajudar a humanidade a resolver problemas globais cada vez mais prementes?

A IA apresenta uma certa dualidade que evoca tanto visões eutópicas como distópicas do futuro, dependendo de quem se ouve.

Regulamentar uma entidade deste tipo constitui um desafio sem precedentes.

Em todo o caso, no final de 2024, viveremos provavelmente num mundo em que a IA está quase universalmente regulamentada, mas o que ninguém consegue responder é até que ponto a indústria - e a própria tecnologia - terá evoluído até lá.