A Tesla está pronta para ligar o seu novo supercomputador $300M na segunda-feira, num impulso ao seu programa de condução totalmente autónoma (FSD).

A abordagem que a Tesla está a adotar com a sua tecnologia de condução autónoma vai exigir muito poder de computação.

Elon Musk fez uma demonstração ao vivo do FSD V12 da Tesla há alguns dias e, embora tenha funcionado muito bem, houve algumas falhas. O sistema ainda se encontra em fase beta e é uma abordagem ambiciosa aos veículos de condução autónoma, uma vez que se baseia exclusivamente em câmaras, sem a ajuda de sensores de radar ou lidar.

Num tweet, Musk disse: "O que também é espantoso é que a potência de computação de inferência necessária para 8 câmaras a funcionar a 36FPS é de apenas cerca de 100W no computador de IA concebido pela Tesla. Esta quantidade insignificante de energia é suficiente para conseguir uma condução sobre-humana!"

Isso pode ser verdade no que diz respeito ao poder de computação necessário no veículo, mas só é possível quando a IA tiver sido devidamente treinada.

Musk explicou a necessidade do investimento em computação da Tesla dizendo que "alcançar uma condução sobre-humana com IA requer milhares de milhões de dólares por ano em computação de treino e armazenamento de dados, bem como um grande número de quilómetros percorridos".

E é aí que entra o novo supercomputador da Tesla. O computador é composto por 10.000 GPUs de computação Nvidia H100. Isso faz dele um dos supercomputadores mais poderosos do mundo.

Atualmente, a Tesla tem 4 milhões de carros na estrada que podem ser adicionados ao seu conjunto de dados de treino, prevendo-se 10 milhões dentro de alguns anos. É uma grande quantidade de vídeos para analisar.

Tim Zaman, um dos gestores de engenharia de IA da Tesla, afirmou: "Devido à formação em vídeo no mundo real, podemos ter os maiores conjuntos de dados de formação do mundo, com uma capacidade de cache de nível quente superior a 200 PB - ordens de grandeza superiores aos LLM".

O novo computador da Tesla fornecerá 340 FP64 PFLOPS para computação técnica e 39,58 INT8 ExaFLOPS para aplicações de IA.

Se estes números não são muito significativos para si, são melhores do que o Leonardo, que está em quarto lugar na lista dos melhores supercomputadores do mundo.

A Nvidia não consegue acompanhar o ritmo

As GPUs H100 da Nvidia realizam o treino de IA até 9 vezes mais rápido do que os processadores A100 que a Tesla tem utilizado até à data. E ainda não é suficiente para as necessidades da Tesla.

Então porque é que eles não compram mais GPUs? Porque a Nvidia não tem capacidade para as fornecer com a rapidez necessária.

Mas a Tesla não está à espera que a Nvidia aumente a sua produção. Nos últimos anos, tem estado a construir o seu próprio supercomputador, o Dojo, com base em chips que a Tesla concebeu internamente.

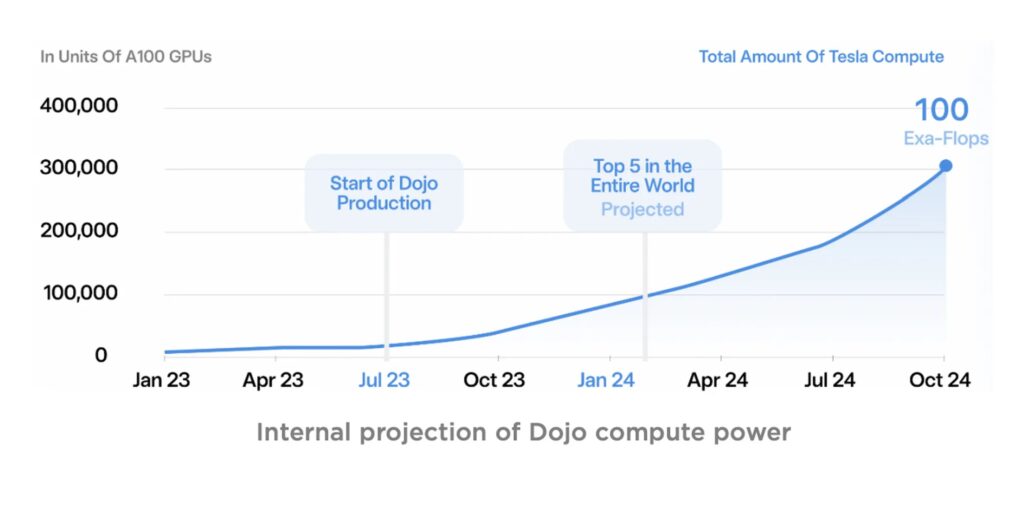

Prevê-se que o Dojo esteja online no final de 2024 e será ainda mais potente do que o cluster Nvidia da Tesla.

Fonte: Tesla

Ser diretor de produção na Nvidia deve ser uma tarefa difícil neste momento, com a procura insaciável de GPUs da Nvidia.

É interessante notar que Musk foi citado como tendo dito: "Francamente... se eles (NVIDIA) nos pudessem fornecer GPUs suficientes, talvez não precisássemos do Dojo".

Tendemos a pensar na Tesla como uma empresa de automóveis eléctricos, mas cada vez mais parece que se trata de uma empresa de IA de supercomputação.

Será interessante ver como o aumento exponencial do poder de computação alimenta as ambições de Musk tanto com a Tesla como com o seu projeto xAI.