A Nvidia revelou uma versão atualizada de seu Grace Hopper Superchip (GH200) que anunciou há 2 meses. O GH200 foi concebido para alimentar centros de dados para processamento de IA em grande escala.

O GH200 ainda não entrou em produção em série, mas já teve um grande atualização na sua memória. O ingrediente secreto destes novos chips é a memória de alta largura de banda actualizada chamada HBM3e, que é capaz de aceder a dados a 5 TB/s.

Isto representa uma melhoria de 50% em relação à memória HBM3 no chip que foi anunciado no final de maio.

A Nvidia ligou esta memória de alta velocidade a CPUs e GPUs potentes no mesmo dispositivo. O aumento resultante na velocidade de processamento irá melhorar drasticamente a capacidade de processamento de IA dos actuais centros de dados.

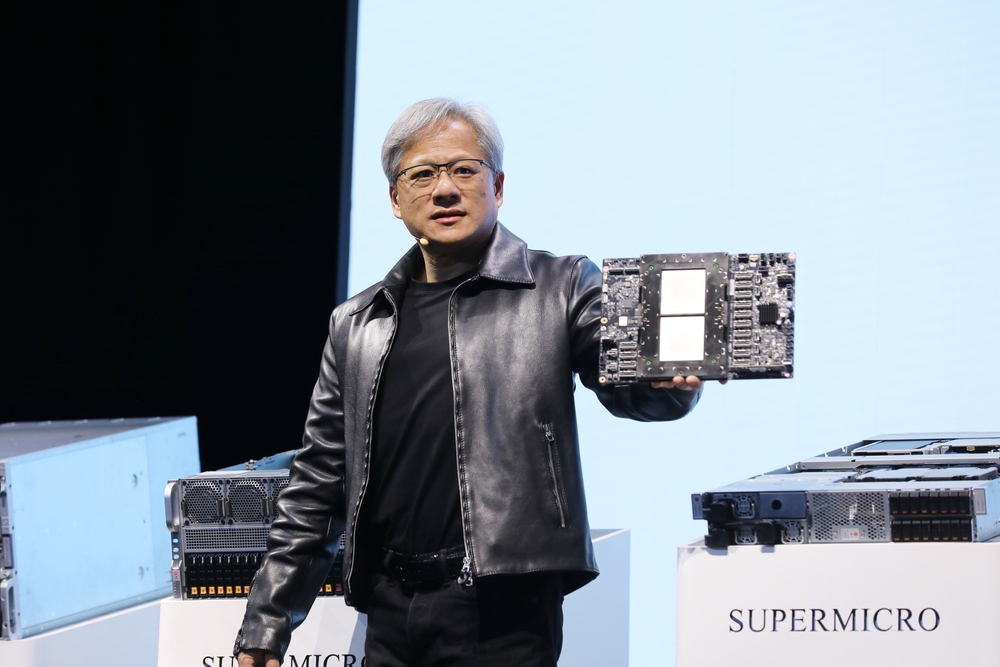

Para além do chip atualizado, a Nvidia anunciou também a plataforma GH200 Grace Hopper, que permite ligar 2 dos chips GH200 numa única placa.

A plataforma oferece oito petaflops de processamento de IA e 282GB de memória HBM3e com uma largura de banda de 10TB/s.

Como é que o chip da Nvidia vai mudar os centros de dados?

Os números podem ser um pouco difíceis de compreender. Então, qual é a importância deste novo chip e desta nova plataforma?

Na sua apresentação, o Diretor Executivo da Nvidia, Jensen Huang, utilizou o exemplo de um centro de dados típico com 8800 processadores x86 que executam uma variedade de funções de computação (orçamento ISO).

Um centro de dados como este, que utilize o Llama 2 para inferência, com uma base de dados vetorial a ser consultada e o SDXL a gerar os resultados, custaria cerca de $100m e consumiria 5MW de energia.

Um centro de dados $100m utilizando 2500 plataformas GH200 poderia executar os mesmos modelos 12 vezes mais rapidamente e utilizaria apenas 3MW de energia.

Se um centro de dados se concentrar num conjunto muito específico de tarefas (carga de trabalho ISO), a comparação torna-se ainda mais surpreendente.

Só precisaria de gastar $8m para 210 dispositivos GH200 que gastam 20 vezes menos energia para igualar o desempenho de um centro de dados de $100m.

Escusado será dizer que todos os centros de dados de computação em nuvem com IA que estavam em fase de planeamento antes deste lançamento vão voltar à prancheta de desenho.

Os chips GH200 serão lançados no segundo trimestre de 2024 e espera-se que venham a consumir uma grande parte do negócio dos processadores x86. O novo chip MI300 da AMD é o rival mais próximo da Nvidia, mas a sua maior vantagem em termos de memória parece estar a ser corroída pela atualização do novo GH200.

O avanço na tecnologia de processadores que estamos a ver está a exceder Lei de Moore e não mostra sinais de abrandamento. As aplicações de IA generativa já estão a apresentar um desempenho impressionante, mas parece que estão prestes a ficar muito mais rápidas.