À medida que as conversas se multiplicam em torno dos riscos dos sistemas de IA, não podemos ignorar a pressão que a tecnologia exerce sobre as fontes de energia e de água já sobrecarregadas do mundo.

Os projectos complexos de aprendizagem automática (ML) dependem de uma constelação de tecnologias, incluindo hardware de treino (GPUs) e hardware para alojar e implementar modelos de IA.

Embora as técnicas e arquitecturas eficientes de formação de IA prometam reduzir o consumo de energia, o boom da IA ainda agora começou e as grandes tecnologias estão a aumentar o investimento em centros de dados que consomem muitos recursos e em tecnologia de nuvem.

À medida que a crise climática se agrava, é mais crítico do que nunca encontrar um equilíbrio entre o avanço tecnológico e a eficiência energética.

Desafios energéticos para a IA

O consumo de energia da IA aumentou com o advento de arquitecturas complexas e computacionalmente dispendiosas, como as redes neuronais.

Por exemplo, há rumores de que o GPT-4 é baseado em 8 modelos com 220 bilhões de parâmetros cada, totalizando cerca de 1,76 trilhão de parâmetros. A Inflection está atualmente a construir um cluster de 22 000 chips Nvidia topo de gamaque poderá custar cerca de $550.000.000 a um preço de retalho aproximado de $25.000 por cartão. E isto apenas para os chips.

Cada modelo avançado de IA requer imensos recursos para ser treinado, mas tem sido um desafio compreender o verdadeiro custo do desenvolvimento da IA precisamente até há pouco tempo.

A Estudo de 2019 da Universidade de Massachusetts em Amherst investigou o consumo de recursos associado às abordagens das redes neuronais profundas (DNN).

Normalmente, estas DNNs exigem que os cientistas de dados concebam manualmente ou utilizem a Pesquisa de Arquitetura Neural (NAS) para encontrar e treinar uma rede neural especializada de raiz para cada caso específico.

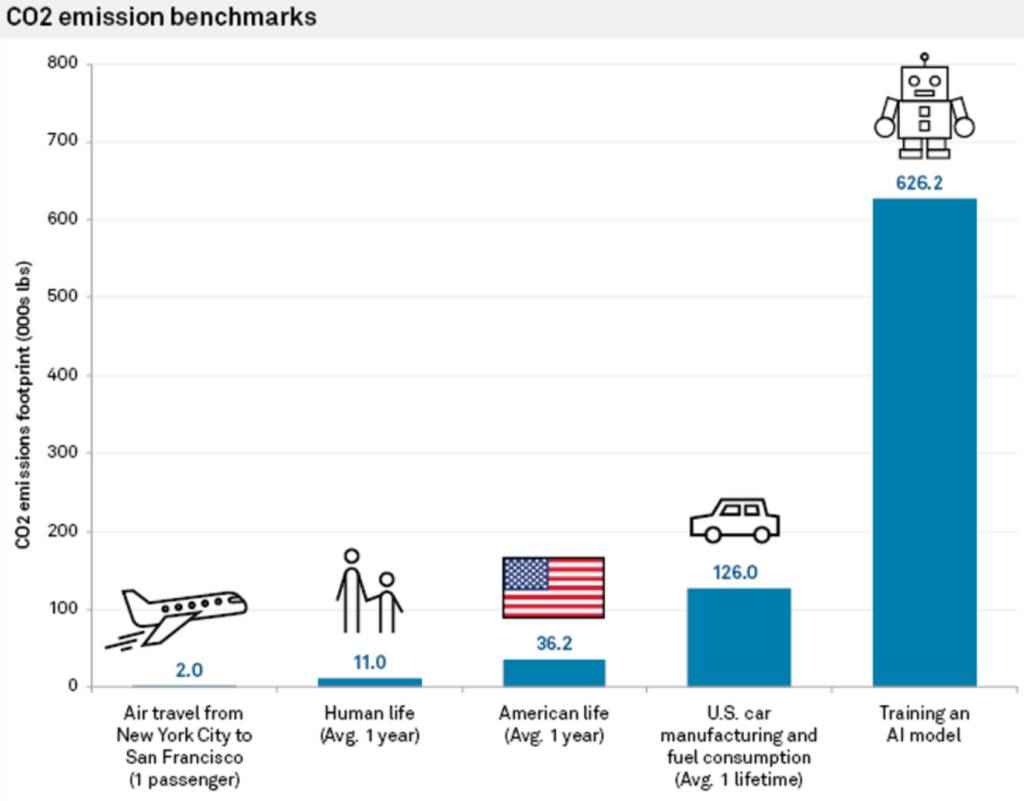

Esta abordagem não só consome muitos recursos como também tem uma pegada de carbono significativa. O estudo descobriu que o treino de uma única rede neural de grandes dimensões baseada no Transformer, construída utilizando o NAS - uma ferramenta habitualmente utilizada na tradução automática - gerou cerca de 626 000 libras de dióxido de carbono.

Este valor é aproximadamente equivalente às emissões de gases durante o tempo de vida de 5 automóveis.

Carlos Gómez-Rodríguez, cientista informático da Universidade da Corunha, em Espanha, comentou o estudo: "Embora provavelmente muitos de nós tenhamos pensado nisto a um nível abstrato e vago, os números mostram realmente a magnitude do problema", acrescentando: "Nem eu nem outros investigadores com quem os discuti pensámos que o impacto ambiental fosse assim tão substancial".

Os custos energéticos do treino do modelo são apenas linhas de base - a quantidade mínima de trabalho necessária para tornar um modelo operacional.

Como diz Emma Strubell, candidata a doutoramento na Universidade de Massachusetts, "treinar um único modelo é a quantidade mínima de trabalho que se pode fazer".

A abordagem "uma vez por todas" do MIT

Mais tarde, os investigadores do MIT propuseram uma solução para este problema: o Abordagem "uma vez por todas" (OFA).

Os investigadores descrever a questão com a formação de redes neuronais convencionais: "A conceção de DNNs especializadas para cada cenário é dispendiosa do ponto de vista técnico e computacional, quer com métodos baseados em humanos quer com NAS. Uma vez que esses métodos têm de repetir o processo de conceção da rede e voltar a treinar a rede concebida de raiz para cada caso, o seu custo total cresce linearmente à medida que o número de cenários de implementação aumenta, o que resultará num consumo excessivo de energia e em emissões de CO2."

Com o paradigma OFA do MIT, os investigadores treinam uma única rede neural de objetivo geral a partir da qual podem ser criadas várias sub-redes especializadas. O processo OFA não requer formação adicional para novas sub-redes, reduzindo as horas de GPU que consomem muita energia necessárias para a formação de modelos e diminuindo as emissões de CO2.

Para além dos seus benefícios ambientais, a abordagem OFA proporciona melhorias substanciais no desempenho. Em testes internos, os modelos criados usando a abordagem OFA tiveram um desempenho até 2,6 vezes mais rápido em dispositivos de borda (dispositivos IoT compactos) do que os modelos criados usando NAS.

A abordagem OFA do MIT foi reconhecida no 4º Desafio de Visão Computacional de Baixa Potência em 2019 - um evento anual organizado pelo IEEE que promove a investigação para melhorar a eficiência energética dos sistemas de visão computacional (CV).

A equipa do MIT conquistou as honras máximas, com os organizadores do evento a elogiarem: "As soluções destas equipas superam as melhores soluções da literatura".

O 2023 Desafio da visão computacional de baixa potência está atualmente a receber candidaturas até 4 de agosto.

O papel da computação em nuvem no impacto ambiental da IA

Para além dos modelos de formação, os programadores necessitam de imensos recursos na nuvem para alojar e implementar os seus modelos.

As grandes empresas tecnológicas, como a Microsoft e a Google, estão a aumentar o investimento em recursos de nuvem ao longo de 2023 para dar resposta à crescente procura de produtos relacionados com a IA.

A computação em nuvem e os centros de dados associados têm imensos requisitos de recursos. A partir de 2016, estimativas sugeridas que os centros de dados a nível mundial representavam cerca de 1% a 3% do consumo global de eletricidade, o que equivale ao consumo de energia de algumas pequenas nações.

A pegada hídrica dos centros de dados é também colossal. Os grandes centros de dados podem consumir milhões de litros de água por dia.

Em 2020, foi noticiado que os centros de dados da Google na Carolina do Sul foram autorizados a utilizar 549 milhões de galões de águaquase o dobro da quantidade utilizada dois anos antes. Um centro de dados de 15 megawatts pode consumir até 360.000 galões de água por dia.

Em 2022, A Google divulgou que a sua frota global de centros de dados consumiu cerca de 4,3 mil milhões de galões de água. No entanto, salientam que o arrefecimento a água é substancialmente mais eficiente do que outras técnicas.

Todas as grandes empresas tecnológicas têm planos semelhantes para reduzir a sua utilização de recursos, como a Google, que atingiu o seu objetivo de fazer corresponder 100% da sua utilização de energia a compras de energias renováveis em 2017.

Hardware de IA de última geração modelado no cérebro humano

A IA consome imensos recursos, mas os nossos cérebros funcionam com apenas 12 watts de potência - poderá esta eficiência energética ser reproduzida na tecnologia de IA?

Mesmo um computador de secretária consome mais de 10 vezes mais energia do que o cérebro humano, e os modelos de IA potentes requerem milhões de vezes mais energia. A criação de tecnologia de IA capaz de reproduzir a eficiência dos sistemas biológicos transformaria completamente o sector.

Para ser justo com a IA, esta comparação não tem em conta o facto de o cérebro humano ter sido "treinado" ao longo de milhões de anos de evolução. Para além disso, os sistemas de IA e os cérebros biológicos são excelentes em tarefas diferentes.

Mesmo assim, a criação de hardware de IA capaz de processar informações com um consumo de energia semelhante ao dos cérebros biológicos permitiria a criação de IA autónomas de inspiração biológica que não estivessem ligadas a fontes de energia volumosas.

Em 2022, uma equipa de investigadores do Instituto Indiano de Tecnologia, em Bombaim, anunciou o desenvolvimento de um novo chip de IA modelado no cérebro humano. O chip funciona com redes neuronais de picos (SNN), que imitam o processamento de sinais neuronais dos cérebros biológicos.

O cérebro é composto por 100 mil milhões de pequenos neurónios ligados a milhares de outros neurónios através de sinapses, transmitindo informações através de padrões coordenados de picos eléctricos. Os investigadores construíram neurónios artificiais de energia ultra-baixa, equipando os SNN com corrente de tunelamento de banda para banda (BTBT).

"Com a BTBT, a corrente de tunelamento quântico carrega o condensador com uma corrente ultra baixa, o que significa que é necessária menos energia", explicou Udayan Ganguly da equipa de investigação.

De acordo com o Professor Ganguly, em comparação com os neurónios existentes de última geração implementados em SNNs de hardware, a sua abordagem atinge "5.000 vezes menos energia por pico numa área semelhante e 10 vezes menos energia de espera numa área e energia semelhantes por pico".

Os investigadores demonstraram com êxito a sua abordagem num modelo de reconhecimento da fala inspirado no córtex auditivo do cérebro. As SNN podem melhorar as aplicações em dispositivos compactos como telemóveis e sensores IoT.

A equipa pretende desenvolver um "núcleo neurossináptico de consumo extremamente baixo e um mecanismo de aprendizagem em tempo real no chip, que são fundamentais para as redes neuronais autónomas de inspiração biológica".

Os impactos ambientais da IA são muitas vezes ignorados, mas a resolução de problemas como o consumo de energia dos chips de IA também abrirá novas vias de inovação.

Se os investigadores conseguirem modelar a tecnologia de IA com base em sistemas biológicos, que são excecionalmente eficientes em termos energéticos, isso permitirá o desenvolvimento de sistemas de IA autónomos que não dependem de uma ampla fonte de alimentação e da conetividade dos centros de dados.