À medida que a IA continua a ser incorporada nos processos de recrutamento, é evidente que a promessa de eficiência da tecnologia tem os seus próprios riscos.

De acordo com Dados de 2022Cerca de 55% das empresas já utilizam ferramentas de IA para o recrutamento.

Embora a IA tenha acelerado as práticas tradicionais de contratação, eliminando pilhas de CVs e currículos no processo, também levantou questões críticas sobre justiça, preconceitos e a própria natureza da tomada de decisões humanas.

Afinal, as IA são treinadas com dados humanos, pelo que são susceptíveis de herdar todos os preconceitos que prometem erradicar.

É algo que podemos mudar? O que é que aprendemos até agora com a IA de recrutamento?

Meta acusada de práticas publicitárias discriminatórias por grupos de defesa dos direitos humanos

Os dados mostram que alguns 79% de candidatos a emprego utilizam as redes sociais para procurar emprego, e há provas de que é aqui que começa a discriminação.

Meta é atualmente confrontado com múltiplas alegações de organizações europeias de direitos humanos que afirmam que o algoritmo de seleção de anúncios de emprego do Facebook é tendencioso.

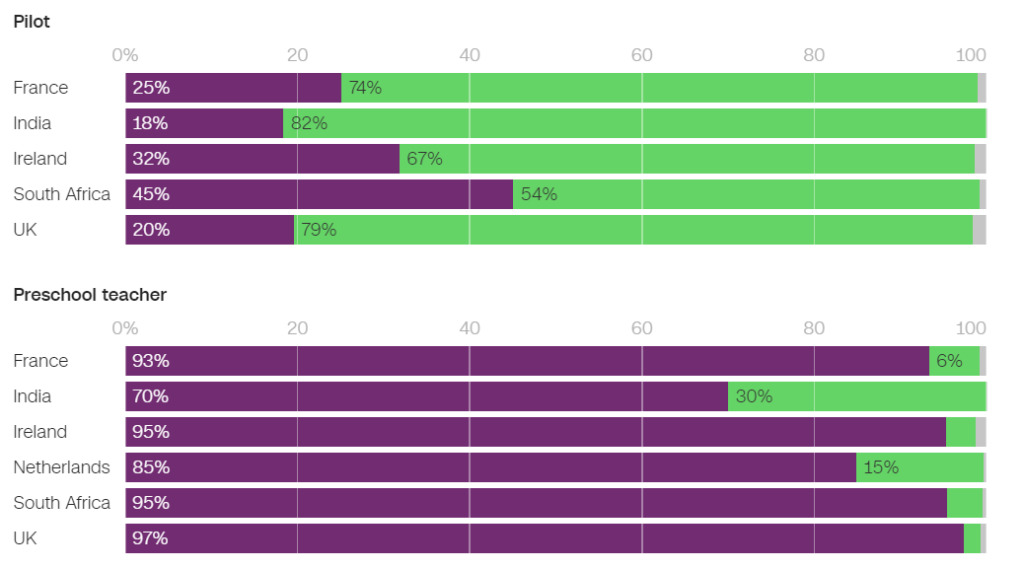

Em junho, a ONG Testemunha global pesquisou vários anúncios de emprego do Facebook com segmentação automática e descobriu que muitos perpetuavam preconceitos de género.

Por exemplo, os homens tinham uma probabilidade significativamente maior de ver anúncios relacionados com a engenharia, enquanto as mulheres tinham uma probabilidade substancialmente maior de ver anúncios relacionados com o ensino.

Dos anúncios apresentados em França, 931 PT3T dos utilizadores que viram um anúncio de emprego de educador de infância e 861 PT3T dos que viram um anúncio de emprego de psicólogo eram mulheres. Por outro lado, apenas 25% das mulheres viram um anúncio de emprego de piloto e apenas 6% viram um anúncio de emprego de mecânico.

Nos Países Baixos, 85% dos utilizadores a quem foi apresentado um anúncio de emprego de professor e 96% dos que foram apresentados a um anúncio de emprego de rececionista eram mulheres. Foram observados resultados semelhantes em muitos outros países, incluindo o Reino Unido, a Índia e a África do Sul.

Num entrevista à CNNNaomi Hirst, da Global Witness, afirmou: "A nossa preocupação é que o Facebook esteja a exacerbar os preconceitos que vivemos na sociedade e a destruir as oportunidades de progresso e equidade no local de trabalho".

Juntamente com o Bureau Clara Wichmann e a Fondation des Femmes, a Global Witness apresentou queixas contra a Meta às autoridades de direitos humanos e de proteção de dados em França e nos Países Baixos.

Os grupos pedem que se investigue se as práticas da Meta violam os direitos humanos ou as leis de proteção de dados. Se as alegações se confirmarem, a Meta poderá ser objeto de coimas e sanções.

Em resposta, um porta-voz da Meta declarou: "O sistema tem em conta diferentes tipos de informação para tentar apresentar às pessoas anúncios que lhes interessam mais".

Esta não é a primeira vez que a Meta rejeita este tipo de críticas - a empresa enfrentou vários processos judiciais em 2019 e comprometeu-se a alterar o seu sistema de distribuição de anúncios para evitar preconceitos com base em características protegidas como o género e a raça.

Pat de Brún, da Amnistia Internacional, foi mordaz com as conclusões da Global Witness. "A investigação mostra consistentemente como os algoritmos do Facebook produzem resultados profundamente desiguais e muitas vezes reforçam a marginalização e a discriminação", disse à CNN.

Amazon elimina ferramenta secreta de recrutamento de IA que revelava preconceito contra as mulheres

A Amazon desenvolveu uma ferramenta de recrutamento de IA entre 2014 e 2017, antes de se aperceber que a ferramenta era tendenciosa na seleção de empregos de programador de software e outros cargos técnicos. Em 2018, a Amazon abandonou completamente a ferramenta.

O sistema de IA penalizou os currículos que continham as palavras "mulheres" e "feminino" e desvalorizou as competências das mulheres licenciadas.

O sistema falhou mesmo depois de a Amazon ter tentado editar os algoritmos para os tornar neutros em termos de género.

Posteriormente, verificou-se que a Amazon treinou a ferramenta com base em currículos enviados à empresa durante um período de 10 anos, a maioria dos quais era de homens.

Tal como muitos sistemas de IA, a ferramenta da Amazon foi influenciada pelos dados com que foi treinada, o que levou a um enviesamento não intencional. Este preconceito favoreceu os candidatos do sexo masculino e preferiu currículos que utilizavam uma linguagem mais comum nos currículos dos engenheiros do sexo masculino.

Além disso, devido a problemas com os dados subjacentes, o sistema recomendava frequentemente candidatos não qualificados para vários empregos.

O Fórum Económico Mundial sobre o sistema de recrutamento da Amazon: "Por exemplo, como no caso da Amazon, os fortes desequilíbrios de género podem estar relacionados com o tipo de estudo realizado. Estes enviesamentos dos dados de formação também podem surgir devido à má qualidade dos dados ou a conjuntos de dados muito pequenos e não diversificados, o que pode ser o caso de empresas que não operam a nível global e que procuram candidatos de nicho."

A Amazon conseguiu reutilizar uma "versão diluída" do motor de recrutamento para tarefas rudimentares, como a eliminação de perfis de candidatos duplicados das bases de dados.

Criaram uma nova equipa para tentar novamente o rastreio automático de emprego, desta vez centrado na promoção da diversidade.

A Google luta contra os seus próprios problemas de discriminação e preconceito

Em dezembro de 2020, o Dr. Timnit Gebru, um dos principais especialistas em ética da IA na Google, anunciou que a a empresa tinha-a despedido.

A rescisão do contrato foi efectuada depois de o Dr. Gebru ter manifestado a sua preocupação com a abordagem da Google em relação à contratação de minorias e com os preconceitos inerentes aos sistemas de IA.

Antes de deixar a empresa, o Dr. Gebru estava prestes a publicar um artigo que destacava a parcialidade dos modelos de IA da Google.

Depois de apresentar este artigo numa conferência académica, a Dra. Gebru revelou que um gestor da Google lhe pediu para se retratar do artigo ou para retirar os seus nomes e os dos outros investigadores da Google. Ao recusar-se a cumprir o pedido, a Google aceitou uma proposta de demissão condicional, pondo efetivamente termo ao cargo da Dra. Gebru de imediato.

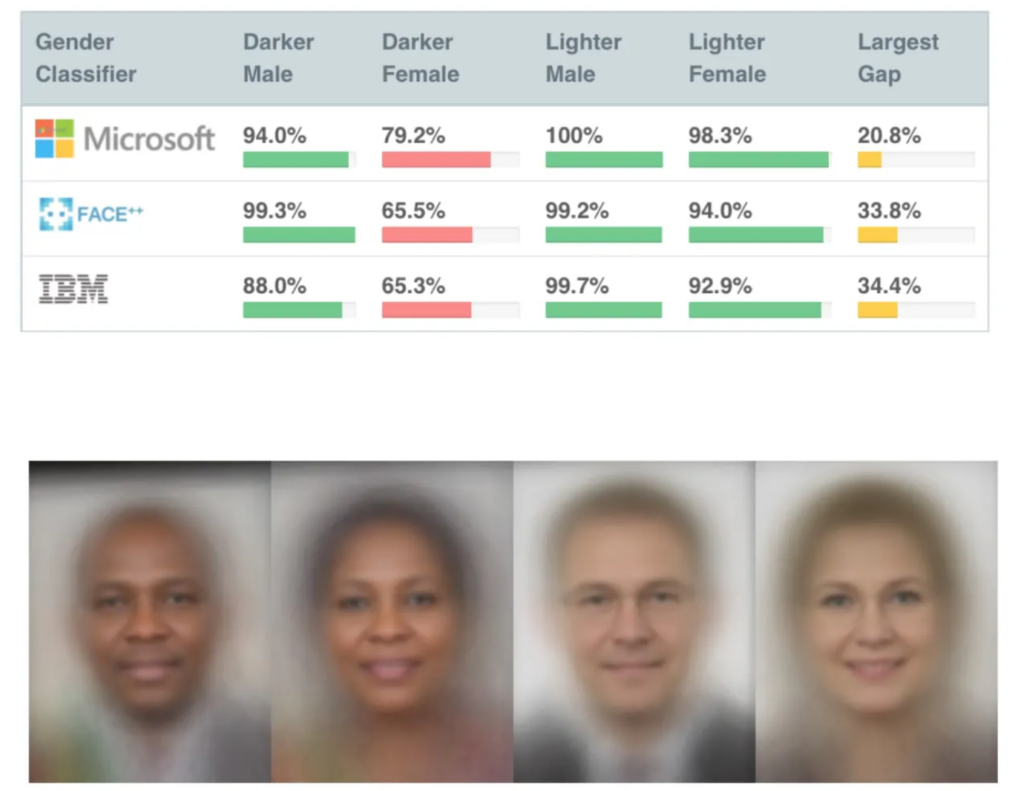

Isto aconteceu pouco tempo depois de terem sido publicados vários estudos muito influentes sobre o enviesamento da IA, incluindo Estudo do MIT sobre as sombras de géneroque se tornou um dos documentos sobre IA mais citados de sempre.

O estudo Gender Shades revelou a existência de preconceitos nas IA de reconhecimento facial, que identificaram incorretamente rostos negros em cerca de 30% a 35% das vezes, em comparação com cerca de 5% para rostos brancos.

O reconhecimento facial incorreto levou à detenção e prisão injustificadas de vários homens nos EUA.

O despedimento de Gebru provocou uma tempestade mediática em torno das práticas discriminatórias em Silicon Valley.

Mutale Nkonde, do Laboratório da Sociedade Civil Digital de Stanford, afirmou: "O seu despedimento apenas indica que os cientistas, activistas e académicos que querem trabalhar neste domínio - e que são mulheres negras - não são bem-vindos em Silicon Valley".

O despedimento do Dr. Gebru inspirou outro estudo, Desmascarar preconceitos codificadosque concluiu que os negros tinham uma probabilidade significativamente maior de serem subestimados pela IA de recrutamento do que qualquer outra pessoa.

"Este relatório encontrou amplas provas que sugerem que os estudantes e profissionais negros estão preocupados com o facto de se depararem com preconceitos contra os negros durante o processo de contratação. Pouco mais de metade dos inquiridos afirmam ter observado preconceitos no processo de contratação ou de recrutamento em sítios Web de contratação ou de recrutamento. Os profissionais negros são ligeiramente mais propensos a ter observado tais preconceitos, com cinquenta e cinco por cento dos inquiridos a indicarem ter observado preconceitos no processo de contratação", - Unmasking Coded Bias (Desmascarar preconceitos codificados), Penn Law Policy Lab.

O documento afirma: "A conversa pública estimulada pela Dra. Gebru e seus colegas sobre o viés algorítmico permitiu que nosso laboratório se envolvesse neste diálogo nacional e expandisse uma compreensão mais matizada do viés algorítmico nas plataformas de contratação".

A exposição do problema foi um catalisador para a mudança, mas a IA tem um longo caminho a percorrer para conciliar o seu papel na tomada de decisões humanas sensíveis.

O papel da IA no recrutamento: alguns aspectos positivos

Apesar das inúmeras controvérsias, tem sido difícil para as empresas resistir ao imenso potencial da IA para acelerar o recrutamento.

O papel da IA no recrutamento faz certamente algum sentido lógico - pode ser mais fácil livrar a IA de preconceitos do que os humanos. Afinal de contas, a IA é *apenas* matemática e código - certamente mais maleável do que preconceitos inconscientes profundamente enraizados?

E, embora os dados de formação fossem muito tendenciosos no início e meados da década de 2010, principalmente devido à falta de conjuntos de dados diversificados, esta situação melhorou consideravelmente desde então.

Uma ferramenta de recrutamento com IA proeminente é SapiaA Sapia é uma empresa de inteligência artificial, apelidada de "entrevistador inteligente". De acordo com a fundadora da Sapia, Barb Hyman, a IA permite um processo de entrevista "cego" que não se baseia em currículos, redes sociais ou dados demográficos, mas apenas nas respostas do candidato, eliminando assim os preconceitos prevalecentes nas contratações conduzidas por humanos.

Estes sistemas podem proporcionar uma oportunidade justa para todos, entrevistando todos os candidatos. Hyman sugere"Se utilizarmos a IA, temos duas vezes mais probabilidades de atrair mulheres e de as manter no processo de contratação".

Mas até o próprio processo de entrevistar alguém com IA levanta questões.

Os modelos de processamento de linguagem natural (PNL) são geralmente treinados principalmente em textos nativos em inglês, o que significa que são não tem capacidade para lidar com o inglês não nativo.

Estes sistemas podem, inadvertidamente, penalizar os falantes não nativos de inglês ou as pessoas com características culturais diferentes. Além disso, os críticos argumentam que as deficiências podem não ser devidamente tidas em conta num chat ou numa entrevista em vídeo com IA, o que pode levar a uma maior discriminação.

Esta situação é agravada pelo facto de, muitas vezes, os candidatos não saberem se estão a ser avaliados por uma IA, o que torna impossível solicitar os ajustamentos necessários ao processo de entrevista.

Os conjuntos de dados são fundamentais

Os conjuntos de dados são fundamentais neste domínio. Se treinarmos uma IA com dados de uma década, ela aprende valores de uma década.

O mercado de trabalho tornou-se consideravelmente mais diversificado desde o início do milénio.

Por exemplo, nalguns países, as mulheres são mais numerosas do que os homens em várias disciplinas médicas importantes, como a psicologia, a genética, a pediatria e a imunologia.

No Reino Unido, um relatório 2023 constatou que 271 PT3T das mulheres empregadas trabalhavam em "profissões liberais" (tais como médicos, engenheiros, enfermeiros, contabilistas, professores e advogados), em comparação com 261 PT3T dos homens, uma tendência que tem vindo a aumentar de forma constante ao longo de 5 a 10 anos.

Estas transições aceleraram nos últimos 2 a 5 anos - muitos conjuntos de dados são mais antigos e simplesmente não reflectem dados recentes. Questões semelhantes aplicam-se tanto à raça e às deficiências como ao género.

Os conjuntos de dados devem refletir os nossos locais de trabalho cada vez mais diversificados para servir todos de forma justa.

Embora ainda haja um enorme trabalho a fazer para garantir a diversidade no local de trabalho, a IA deve herdar valores do presente e não do passado. Este deve ser o mínimo necessário para produzir IAs de recrutamento justas e transparentes.

Os criadores de IA de recrutamento enfrentarão provavelmente uma regulamentação rigorosa, com os EUA, o Reino Unido, a China, os Estados-Membros da UE e muitos outros países a prepararem-se para reforçar os controlos da IA nos próximos anos.

A investigação está em curso, mas continua a ser pouco provável que a maioria das IA de recrutamento esteja a aplicar os princípios justos e imparciais que esperamos de cada um de nós.