Terwijl de gesprekken over de risico's van AI-systemen aanzwellen, kunnen we niet voorbijgaan aan de druk die de technologie legt op de toch al overbelaste energie- en watervoorraden van de wereld.

Complexe machine learning (ML) projecten zijn afhankelijk van een constellatie van technologieën, waaronder trainingshardware (GPU's) en hardware voor het hosten en inzetten van AI-modellen.

Hoewel efficiënte AI-trainingstechnieken en -architecturen het energieverbruik beloven te verminderen, is de AI-boom nog maar net begonnen en voert big tech de investeringen in energievretende datacenters en cloudtechnologie op.

Naarmate de klimaatcrisis zich verdiept, is het belangrijker dan ooit om een evenwicht te vinden tussen technologische vooruitgang en energie-efficiëntie.

Energie-uitdagingen voor AI

Het energieverbruik van AI is gestegen met de komst van complexe, rekenkundig dure architecturen zoals neurale netwerken.

Het gerucht gaat bijvoorbeeld dat GPT-4 gebaseerd is op 8 modellen met elk 220 miljard parameters, voor een totaal van ongeveer 1,76 biljoen parameters. Inflection bouwt momenteel een cluster van 22.000 high-end Nvidia-chipsdie zo'n $550.000.000 kunnen kosten bij een ruwe verkoopprijs van $25.000 per kaart. En dat is alleen nog maar voor de chips.

Elk geavanceerd AI-model vereist enorme middelen om te trainen, maar het was tot voor kort een uitdaging om de werkelijke kosten van AI-ontwikkeling precies te begrijpen.

A Onderzoek 2019 van de Universiteit van Massachusetts in Amherst onderzocht het resourceverbruik van DNN-benaderingen (Deep Neural Networks).

Doorgaans moeten gegevenswetenschappers voor deze DNN's handmatig een ontwerp maken of Neural Architecture Search (NAS) gebruiken om een gespecialiseerd neuraal netwerk te vinden en vanaf nul te trainen voor elk uniek geval.

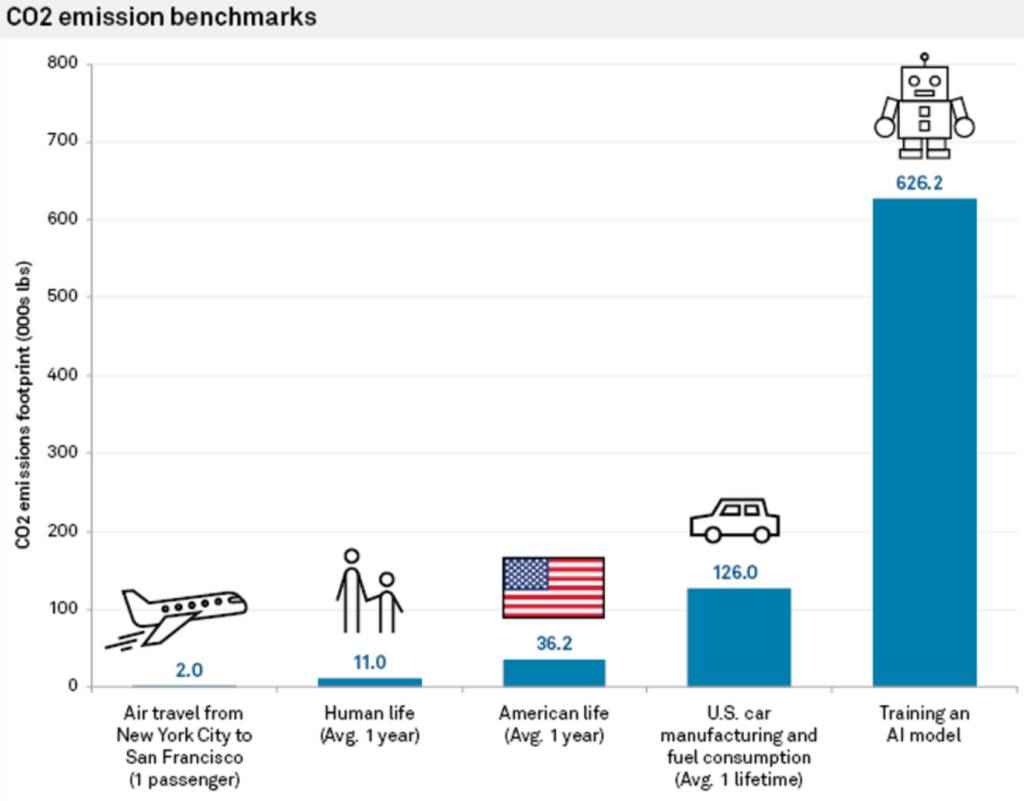

Deze aanpak kost niet alleen veel middelen, maar heeft ook een aanzienlijke koolstofvoetafdruk. Het onderzoek ontdekte dat het trainen van één groot op Transformer gebaseerd neuraal netwerk, gebouwd met NAS - een hulpmiddel dat vaak wordt gebruikt bij machinevertaling - ongeveer 626.000 pond kooldioxide genereerde.

Dit komt ongeveer overeen met de levenslange uitstoot van 5 auto's.

Carlos Gómez-Rodríguez, een computerwetenschapper aan de Universiteit van A Coruña in Spanje, zei over het onderzoek: "Hoewel waarschijnlijk velen van ons hier op een abstract, vaag niveau aan hebben gedacht, laten de cijfers echt de omvang van het probleem zien," en voegde eraan toe: "Noch ik, noch andere onderzoekers met wie ik ze heb besproken, dachten dat de gevolgen voor het milieu zo substantieel waren."

De energiekosten voor het trainen van het model zijn slechts basiskosten - de minimale hoeveelheid werk die nodig is om een model operationeel te krijgen.

Zoals Emma Strubell, een promovendus aan de Universiteit van Massachusetts, zegt: "Het trainen van één model is de minimale hoeveelheid werk die je kunt doen."

De eenmalige aanpak van MIT

Onderzoekers van het MIT stelden later een oplossing voor dit probleem voor: de Eenmalige aanpak (OFA).

De onderzoekers het probleem beschrijven met conventionele neurale netwerktraining: "Het ontwerpen van gespecialiseerde DNN's voor elk scenario is duur voor ingenieurs en computationeel duur, hetzij met menselijke methoden of NAS. Aangezien dergelijke methoden het netwerkontwerpproces moeten herhalen en het ontworpen netwerk voor elk geval opnieuw moeten trainen, nemen hun totale kosten lineair toe naarmate het aantal inzetscenario's toeneemt, wat zal resulteren in buitensporig energieverbruik en CO2-uitstoot."

Met het OFA-paradigma van MIT trainen onderzoekers één algemeen neuraal netwerk waaruit verschillende gespecialiseerde subnetwerken kunnen worden gemaakt. Het OFA-proces vereist geen extra training voor nieuwe subnetwerken, waardoor er minder energie-intensieve GPU-uren nodig zijn voor modeltraining en er minder CO2 wordt uitgestoten.

Naast de milieuvoordelen levert de OFA-benadering substantiële prestatieverbeteringen. In interne tests presteerden modellen gemaakt met de OFA-benadering tot 2,6 keer sneller op randapparaten (compacte IoT-apparaten) dan modellen gemaakt met NAS.

De OFA-benadering van MIT werd erkend tijdens de 4e Low Power Computer Vision Challenge in 2019 - een jaarlijks evenement georganiseerd door de IEEE ter bevordering van onderzoek naar het verbeteren van de energie-efficiëntie van computer vision (CV)-systemen.

Het MIT-team kreeg de hoogste onderscheiding en de organisatoren van het evenement loofden het team: "De oplossingen van deze teams presteren beter dan de beste oplossingen in de literatuur."

De 2023 Computer Vision-uitdaging voor laag vermogen ontvangt momenteel inzendingen tot 4 augustus.

De rol van cloud computing op de impact van AI op het milieu

Naast trainingsmodellen hebben ontwikkelaars enorme cloudresources nodig om hun modellen te hosten en in te zetten.

Grote techbedrijven zoals Microsoft en Google verhogen de investeringen in cloudbronnen in 2023 om de stijgende vraag naar AI-gerelateerde producten aan te kunnen.

Cloud computing en de bijbehorende datacenters hebben een enorme behoefte aan middelen. Vanaf 2016, voorgestelde schattingen dat datacenters wereldwijd verantwoordelijk zijn voor ongeveer 1% tot 3% van het wereldwijde elektriciteitsverbruik, gelijk aan het energieverbruik van bepaalde kleine naties.

De watervoetafdruk van datacenters is ook kolossaal. Grote datacenters kunnen dagelijks miljoenen liters water verbruiken.

In 2020 werd bekend dat de datacenters van Google in South Carolina toestemming kregen om 549 miljoen liter waterBijna twee keer zoveel als twee jaar eerder. Een datacenter van 15 megawatt kan dagelijks tot 360.000 liter water verbruiken.

In 2022, Google onthulde dat haar wereldwijde datacentervloot ongeveer 4,3 miljard liter water verbruikt. Ze benadrukken echter dat waterkoeling aanzienlijk efficiënter is dan andere technieken.

Grote techbedrijven hebben allemaal vergelijkbare plannen voor het verminderen van hun gebruik van hulpbronnen, zoals Google, dat in 2017 zijn doel bereikte om 100% van zijn energieverbruik te matchen met de aankoop van hernieuwbare energie.

Next-gen AI-hardware gemodelleerd naar het menselijk brein

AI vergt enorm veel middelen, maar onze hersenen werken met slechts 12 watt vermogen - Kan een dergelijke energie-efficiëntie worden gerepliceerd in AI-technologie?

Zelfs een desktopcomputer verbruikt meer dan 10x meer stroom dan het menselijk brein en krachtige AI-modellen hebben miljoenen keren meer stroom nodig. Het bouwen van AI-technologie die de efficiëntie van biologische systemen kan nabootsen zou de industrie volledig transformeren.

Om eerlijk te zijn tegenover AI, houdt deze vergelijking geen rekening met het feit dat het menselijk brein gedurende miljoenen jaren evolutie is 'getraind'. Bovendien blinken AI-systemen en biologische hersenen uit in verschillende taken.

Toch zou het bouwen van AI-hardware die informatie kan verwerken met eenzelfde energieverbruik als biologische hersenen, autonome biologisch geïnspireerde AI's mogelijk maken die niet zijn gekoppeld aan omvangrijke energiebronnen.

In 2022 heeft een team onderzoekers van het Indian Institute of Technology in Bombay, kondigde de ontwikkeling aan van een nieuwe AI-chip die is gemodelleerd naar het menselijk brein. De chip werkt met spiking neurale netwerken (SNN's), die de neurale signaalverwerking van biologische hersenen nabootsen.

De hersenen bestaan uit 100 miljard piepkleine neuronen die via synapsen verbonden zijn met duizenden andere neuronen en informatie overdragen via gecoördineerde patronen van elektrische pieken. De onderzoekers bouwden ultralaag-energetische kunstmatige neuronen door SNN's uit te rusten met band-tot-band tunneling (BTBT) stroom.

"Met BTBT laadt de kwantumtunnelstroom de condensator op met ultralage stroom, wat betekent dat er minder energie nodig is," legt Udayan Ganguly van het onderzoeksteam uit.

Volgens professor Ganguly bereikt hun benadering in vergelijking met bestaande geavanceerde neuronen die zijn geïmplementeerd in hardware SNN's "5000 keer minder energie per spike bij een vergelijkbaar gebied en 10 keer minder stand-byvermogen bij een vergelijkbaar gebied en energie per spike".

De onderzoekers hebben hun aanpak succesvol gedemonstreerd in een spraakherkenningsmodel dat is geïnspireerd op de auditieve cortex van de hersenen. SNN's zouden toepassingen op compacte apparaten zoals mobiele telefoons en IoT-sensoren kunnen verbeteren.

Het team wil een "extreem energiezuinige neurosynaptische kern en een real-time on-chip leermechanisme ontwikkelen, die essentieel zijn voor autonome biologisch geïnspireerde neurale netwerken".

De impact van AI op het milieu wordt vaak over het hoofd gezien, maar het oplossen van problemen zoals stroomverbruik voor AI-chips zal ook nieuwe wegen naar innovatie openen.

Als onderzoekers AI-technologie kunnen modelleren op biologische systemen, die uitzonderlijk energie-efficiënt zijn, zou dit de ontwikkeling van autonome AI-systemen mogelijk maken die niet afhankelijk zijn van een ruime stroomvoorziening en datacenterconnectiviteit.