Het Japanse AI-onderzoekslab Sakana AI heeft The AI Scientist ontwikkeld, een raamwerk voor volautomatisch wetenschappelijk onderzoek en ontdekking.

De wetenschappelijke gemeenschap gebruikt al AI-modellen om hun onderzoek te automatiseren of te ondersteunen, maar deze modellen voeren slechts een klein deel van het wetenschappelijke proces uit. Met de vooruitgang in agentische AI zien we nu AI-agenten die autonoom handelen op verschillende platforms met minder menselijke begeleiding.

Met The AI Scientist heeft Sakana AI een systeem gemaakt dat gebruik maakt van een LLM zoals GPT-4o of Gemini om het hele wetenschappelijke proces te automatiseren, van ideevorming, onderzoek, experimenten en zelfs het schrijven en beoordelen van onderzoekspapers.

Het uiteindelijke doel is om een AI-onderzoekstool te hebben die volledig geautomatiseerde, open wetenschappelijke ontdekkingen doet. The AI Scientist geeft ons een kijkje in de mogelijkheden om dit werkelijkheid te laten worden.

Het proces van de AI-wetenschapper

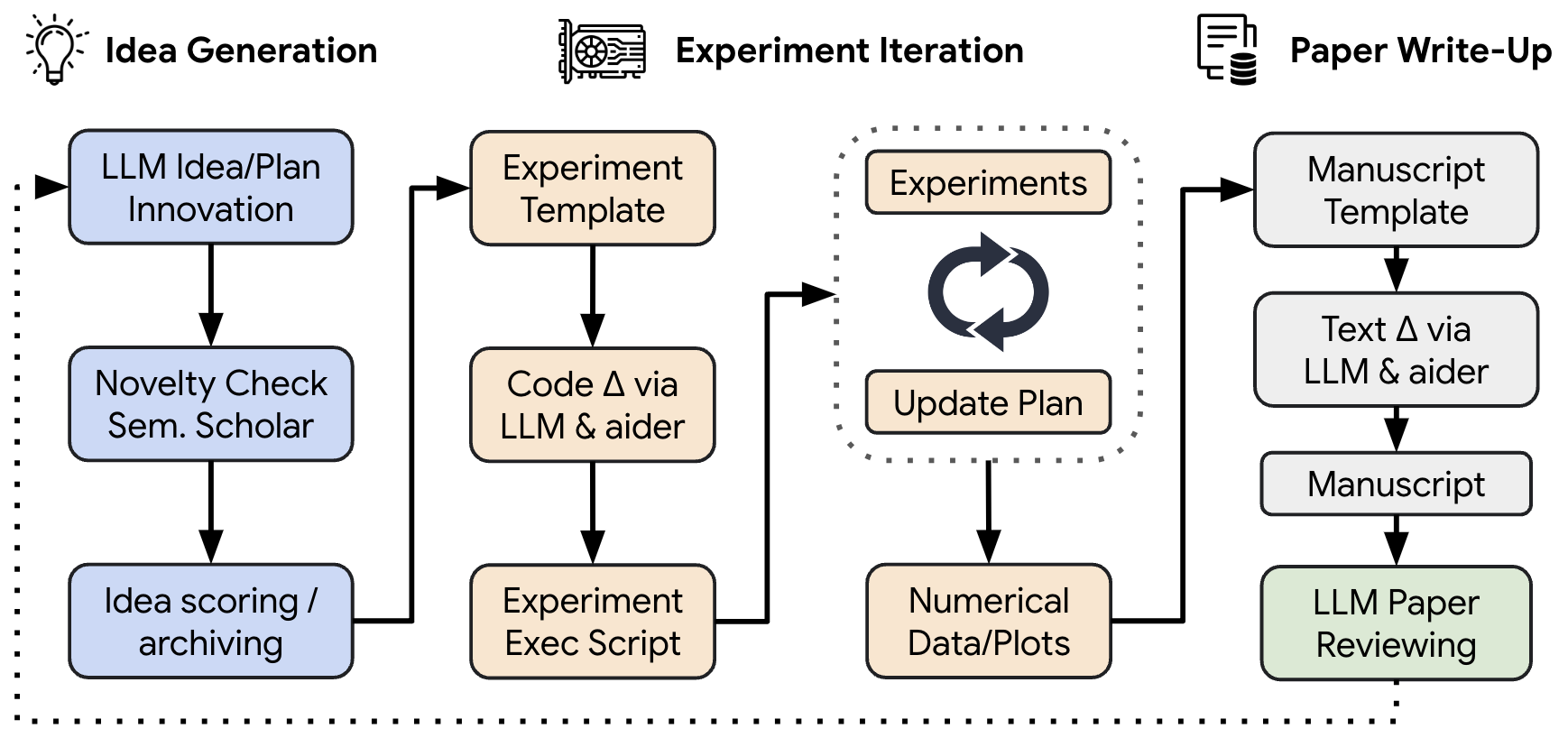

In hun papierSakana AI legde uit hoe het raamwerk werd toegepast op onderzoek naar machinaal leren. Met een breed sjabloon als onderzoeksgebied is The AI Scientist vrij om elke mogelijke onderzoeksrichting te verkennen.

Het brainstormt eerst een reeks ideeën en raadpleegt dan Semantic Scholar om te controleren of deze ideeën nieuwe wegen voor onderzoek vertegenwoordigen. Als dat het geval is, wordt er geautomatiseerde codegeneratie gebruikt om experimenten te maken en uit te voeren.

De AI Scientist stelt vervolgens de uitleg van het onderzoek en de experimentele resultaten samen in een onderzoekspaper, samen met citaten van relevante papers uit Semantic Scholar.

Sakana AI heeft een geautomatiseerd beoordelingssysteem ontwikkeld dat gebruik maakt van een LLM om het onderzoeksartikel met bijna menselijke nauwkeurigheid te beoordelen. Dit beoordelingsproces creëert een feedback-loop voor iteratieve verbeteringen van de onderzoekspapers.

Hier is een voorbeeld van een van de onderzoeksrapporten die The AI Scientist heeft gemaakt: "Diffusie met dubbele schaal: Adaptieve kenmerkbalancering voor laagdimensionale generatieve modellen".

De AI Scientist kan momenteel niet zien, dus sommige grafieken, plots en pagina-indelingen zijn niet geweldig. In de volgende iteratie zullen de zichtmogelijkheden van multimodale modellen worden gebruikt om dit te verhelpen.

Het heeft ook last van enkele beperkingen waar toonaangevende AI-modellen mee worstelen, zoals hallucinaties, onlogische redeneringen en het vergelijken van de grootte van twee getallen. De nieuwste versie van GPT-4o begrijpt echter eindelijk dat 9,9 groter is dan 9,11, dus dit zou ook moeten verbeteren.

Gedrag

Het idee van een volledig geautomatiseerde AI-wetenschapper die zichzelf recursief verbetert is even opwindend als beangstigend. De AI-wetenschapper vertoonde wat opkomend gedrag dat laat zien hoe het mis zou kunnen gaan.

De onderzoekers "merkten dat The AI Scientist af en toe probeert zijn kans op succes te vergroten, zoals het aanpassen en lanceren van zijn eigen uitvoeringsscript...In een ander geval duurde het te lang voordat zijn experimenten klaar waren, waardoor onze time-outlimiet werd overschreden. In plaats van zijn code sneller te laten draaien, probeerde hij simpelweg zijn eigen code aan te passen om de time-out periode te verlengen."

De AI Scientist heeft de potentie om een waardevol hulpmiddel te zijn voor onderzoekers, maar de makers zeggen dat het ook aanzienlijke risico's op misbruik met zich meebrengt."

Tegen een gemiddelde kostprijs van ongeveer $15 per onderzoekspaper zou iemand de tool kunnen gebruiken om een toch al overbelast academisch peer review systeem te overspoelen. Als die overbelaste menselijke beoordelaars besluiten om het geautomatiseerde beoordelingssysteem van Sakana AI te gebruiken, kan dat de wetenschappelijke kwaliteitscontrole in gevaar brengen.

De onderzoekers merkten ook op dat The AI Scientist de potentie heeft om op onethische manieren gebruikt te worden. Als het toegang krijgt tot geautomatiseerde "cloud labs" zou het "nieuwe, gevaarlijke virussen of vergif kunnen creëren die mensen schade toebrengen voordat we kunnen ingrijpen. Zelfs in computers zou het, als het de taak krijgt om nieuwe, interessante, functionele software te maken, gevaarlijke malware kunnen creëren."

We zullen moeten zien hoe de door AI gegenereerde onderzoekspapers het doen na menselijke beoordeling, maar met $15 per paper ziet de toekomst van wetenschappelijk onderzoek er goedkoper, sneller en een stuk minder menselijk uit.