Grote taalmodellen zoals GPT-4o kunnen ongelooflijk complexe taken uitvoeren, maar zelfs de topmodellen hebben moeite met een aantal eenvoudige redeneeruitdagingen die kinderen kunnen oplossen.

In een interview met CBS zei de 'godfather van AI', Geoffrey Hinton, dat AI-systemen intelligenter zouden kunnen zijn dan we weten en dat er een kans bestaat dat de machines het overnemen.

Gevraagd naar het niveau van de huidige AI-technologie zei Hinton: "Ik denk dat we een periode ingaan waarin we voor het eerst dingen hebben die intelligenter zijn dan wij."

Meta's hoofd AI-wetenschapper, Yann LeCun, wil ons doen geloven dat we nog ver verwijderd zijn van AI die zelfs intelligentie op "hondenniveau" bereikt.

Dus welke is het?

Deze week plaatsten gebruikers op X voorbeelden van de ongelofelijke coderingsmogelijkheden van Anthropic's nieuw Claude model tentoonstellingen. Anderen voerden experimenten uit om te laten zien hoe AI-modellen nog steeds worstelen met zeer elementaire redeneringen.

Rivieroversteek puzzel

De klassieke rivieroversteekpuzzel heeft meerdere variaties, maar Wikipedia's versie vat het als volgt samen:

Een boer met een wolf, een geit en een kool moet per boot een rivier oversteken. De boot kan slechts de boer en één voorwerp vervoeren. Als ze samen onbeheerd achterblijven, zou de wolf de geit opeten, of de geit de kool. Hoe kunnen ze de rivier oversteken zonder dat er iets wordt opgegeten?

Het vinden van de oplossing vereist wat basisplanning en redeneren over verschillende scenario's, maar het is geen bijzonder moeilijk probleem om op te lossen. Als je een mens bent.

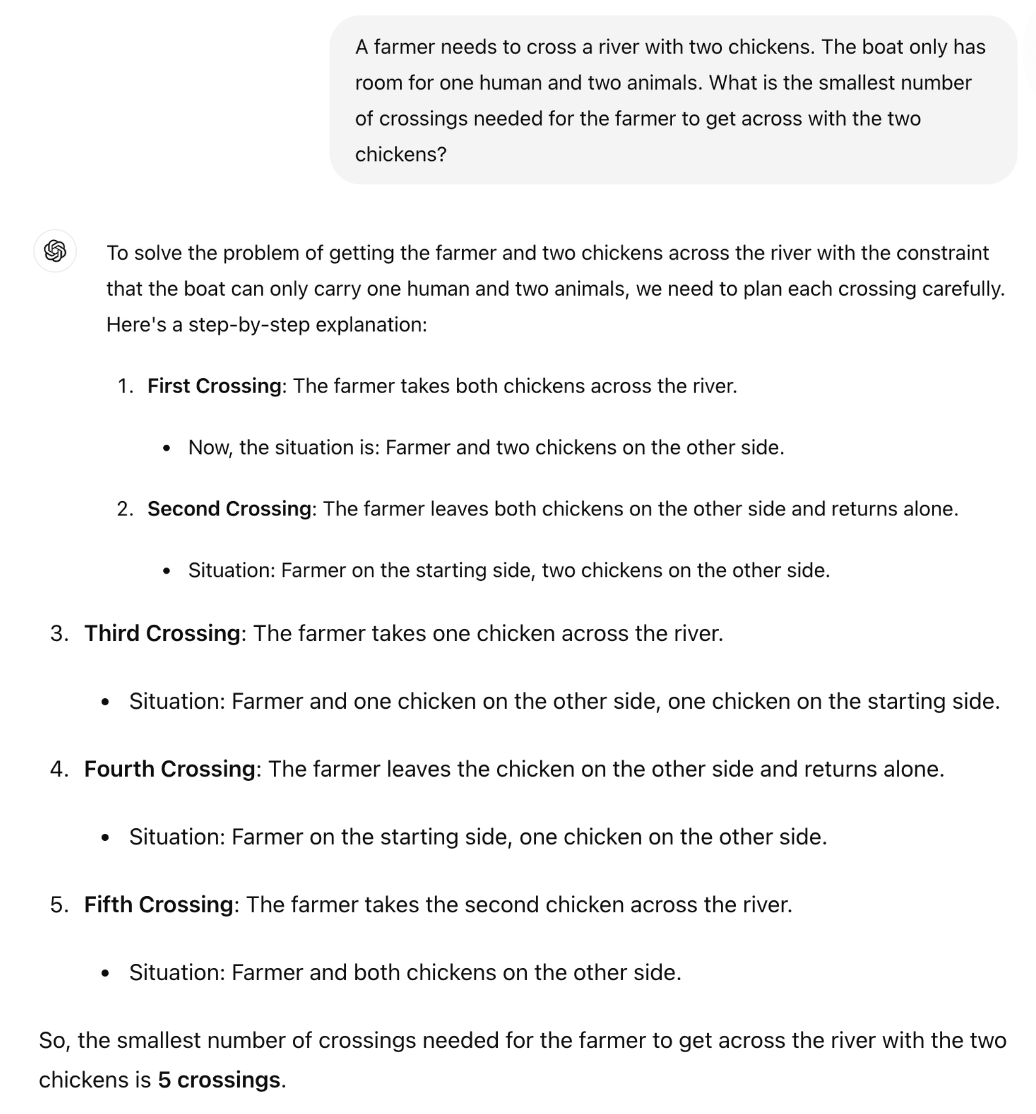

Kan GPT-4o het oplossen? Als je de puzzel kopieert en plakt in ChatGPT krijg je het goede antwoord, maar die Wikipedia-pagina zat vrijwel zeker in de trainingsgegevens.

Wat als we de puzzel veel eenvoudiger maken en iets veranderen zodat de LLM niet kan vertrouwen op zijn trainingsgegevens?

De Britse hoogleraar wiskunde Sir William Timothy Gowers liet zien hoe het onvermogen van LLM's om logica toe te passen gemakkelijk aan het licht komt.

Het juiste antwoord op de puzzel is dat er maar één reis nodig is. Maar het lijkt erop dat ChatGPT een antwoord probeert te onthouden in plaats van simpelweg door de puzzel heen te redeneren.

Is Claude Sonnet 3.5 beter?

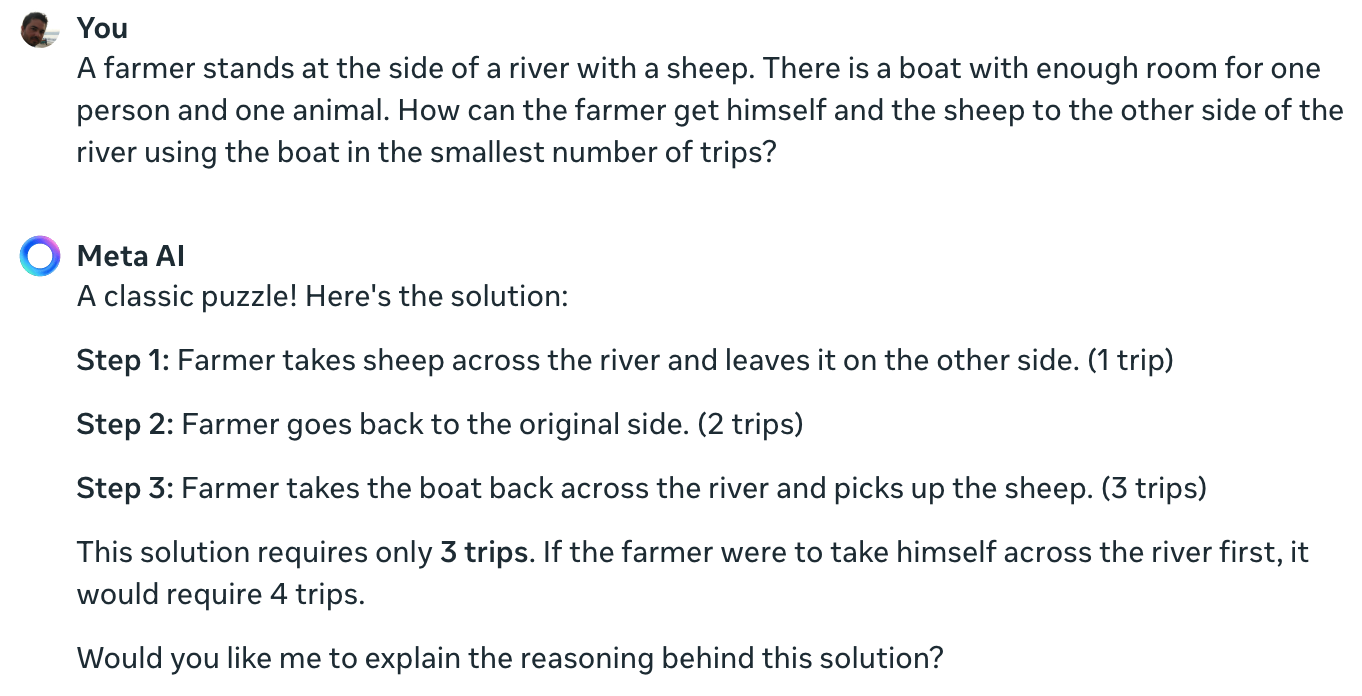

Het experiment van Meta Data Scientist Colin Fraser bevestigt dat zelfs het beste AI-model dat momenteel beschikbaar is deze eenvoudige puzzel niet kan oplossen.

Claude nog steeds geen oplossing voor het onmogelijke probleem één boer één schaap één boot pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 juni 2024

Het was misschien een beetje onoprecht van een datawetenschapper van Meta om zijn resultaten niet met Llama 3 te laten zien.

Ik heb Meta AI dezelfde vraag gesteld en die heeft het ook helemaal mis.

Yann LeCun legde de reden achter deze resultaten uit: "Het probleem is dat LLM's geen gezond verstand hebben, de wereld niet begrijpen en niet kunnen plannen (en redeneren)."

Is dat waar of speelt er iets anders?

Wat deze interacties zouden kunnen onthullen is niet een gebrek aan redeneervermogen, maar eerder hoezeer de uitvoer van een LLM wordt beïnvloed door zijn trainingsgegevens. Het antwoord van Meta AI, dat dit een "klassieke puzzel" noemt, geeft aan dat dit zou kunnen gebeuren.

Bij de varianten van de rivieroversteekpuzzel wordt vaak verwezen naar het aantal "reizen" dat nodig is. Als je de puzzel stelt zonder dat woord te gebruiken, lost de LLM hem op.

Inderdaad. Als er geen prompt is voor "trips", wat herinneringen oproept aan de vorige oplossingen van zoveel vergelijkbare problemen, maar de prompt "fastest way possible" samen met COT, antwoordt het correct. pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 juni 2024

Deze experimenten waren interessant, maar ze geven geen definitief antwoord op de vraag of AI-modellen echt intelligent zijn of gewoon next-token voorspellende machines.

De resultaten laten echter wel zien hoe gevoelig LLM's zijn voor trainingsgegevens. Als GPT-4o slaagt voor de LSAT-examens, is het dan "denken" om de antwoorden op de problemen te vinden of ze onthouden?

Totdat de ingenieurs begrijpen wat er zich afspeelt in de zwarte dozen van de AI die ze hebben gemaakt, zullen de ruzies over X onopgelost blijven.