AI heeft talloze toepassingen, maar een van de meest verontrustende is het creëren van nepmedia en misinformatie.

Een nieuwe onderzoek van Google DeepMind en Decoupeerzaag, een technologie-incubator van Google die maatschappelijke bedreigingen in de gaten houdt, analyseerde misbruik van AI tussen januari 2023 en maart 2024.

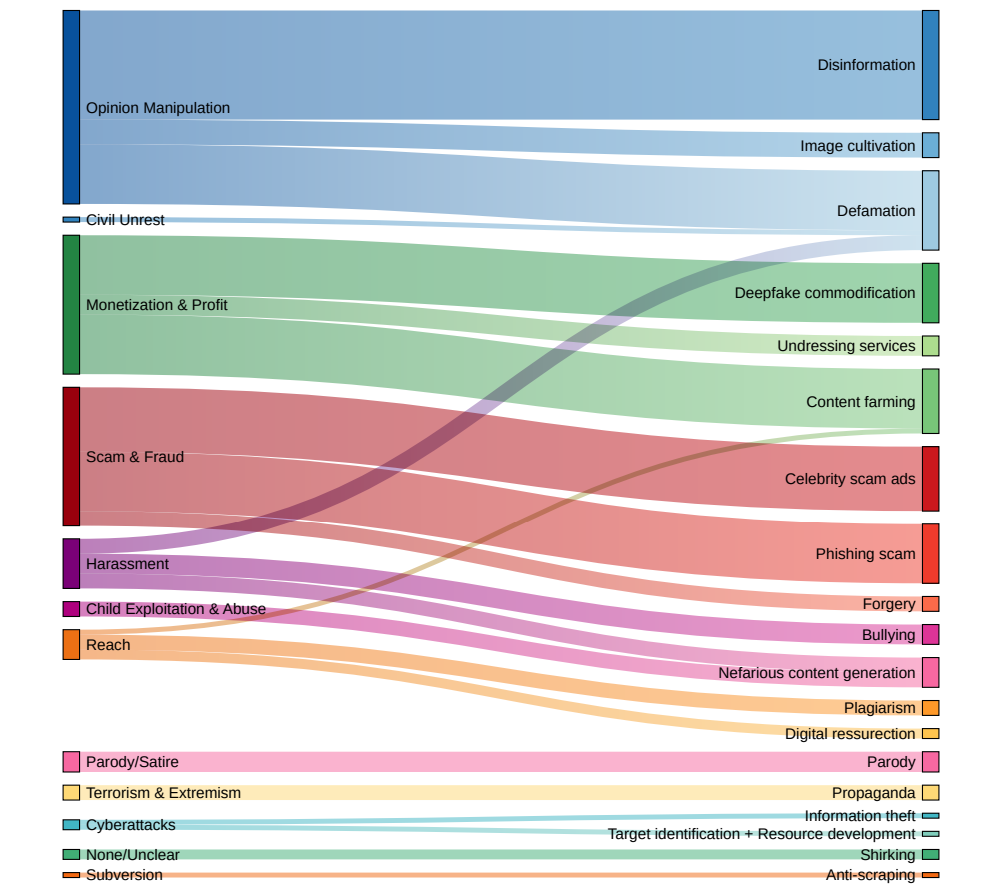

Het onderzoek beoordeelde ongeveer 200 echte incidenten van AI-misbruik en onthulde dat het creëren en verspreiden van misleidende nepmedia, met name gericht op politici en publieke figuren, de meest voorkomende vorm van kwaadwillig AI-gebruik is.

Deep fakes, synthetische media die met behulp van AI-algoritmen worden gegenereerd om zeer realistische, maar valse afbeeldingen, video's en audio te maken, zijn levensecht en alomtegenwoordig geworden.

Incidenten zoals wanneer expliciete nepafbeeldingen van Taylor Swift verschenen op X liet zien dat dergelijke afbeeldingen miljoenen mensen kunnen bereiken voordat ze worden verwijderd.

Maar het meest verraderlijk zijn diepe vervalsingen gericht op politieke kwesties, zoals het Israëlisch-Palestijns conflict. In sommige gevallen kunnen zelfs de feitencheckers die ze als "AI-gegenereerd" moeten bestempelen, de echtheid ervan niet betrouwbaar vaststellen.

Het onderzoek van DeepMind verzamelde gegevens uit een breed scala aan bronnen, waaronder sociale mediaplatforms zoals X en Reddit, online blogs en mediaberichten.

Elk incident werd geanalyseerd om het specifieke type AI-technologie te bepalen dat werd misbruikt, het beoogde doel achter het misbruik en het niveau van technische expertise dat nodig was om de kwaadaardige activiteit uit te voeren.

Diepe vervalsingen zijn de dominante vorm van AI-misbruik

De bevindingen schetsen een alarmerend beeld van het huidige landschap van kwaadwillig AI-gebruik:

- Deep fakes kwamen naar voren als de dominante vorm van AI-misbruik, goed voor bijna twee keer zoveel incidenten als de op één na meest voorkomende categorie.

- Het op een na meest waargenomen type AI-misbruik was het gebruik van taalmodellen en chatbots om online desinformatie te genereren en te verspreiden. Door de creatie van misleidende inhoud te automatiseren, kunnen kwaadwillenden sociale media en andere platforms op ongekende schaal overspoelen met nepnieuws en propaganda.

- Het beïnvloeden van de publieke opinie en politieke verhalen was de primaire motivatie achter meer dan een kwart (27%) van de geanalyseerde gevallen van AI-misbruik. Dit illustreert de dreiging die deep fakes en AI-gegenereerde desinformatie vormen voor democratische processen en de integriteit van verkiezingen wereldwijd, die we hebben waargenomen van recente opvallende incidenten.

- Financieel gewin werd geïdentificeerd als de tweede meest voorkomende drijfveer van kwaadaardige AI-activiteit, waarbij gewetenloze actoren betaalde diensten aanboden voor het maken van diepe vervalsingen, waaronder niet-consensueel expliciet beeldmateriaal, en gebruik maakten van generatieve AI om massaal valse inhoud te produceren voor winst.

- Bij de meeste gevallen van AI-misbruik ging het om gemakkelijk toegankelijke tools en diensten waarvoor minimale technische kennis nodig was om ze te kunnen gebruiken. Deze lage instapdrempel vergroot de groep potentiële kwaadwillende actoren enorm, waardoor het voor individuen en groepen eenvoudiger dan ooit is om zich bezig te houden met AI-gestuurde misleiding en manipulatie.

Dr. Nahema Marchal van DeepMind legde het veranderende landschap van AI-misbruik uit aan de Financiële Times: "Er was veel begrijpelijke bezorgdheid over behoorlijk geraffineerde cyberaanvallen die mogelijk werden gemaakt door deze tools," vervolgt hij, "We zagen vrij algemeen misbruik van GenAI [zoals diepe vervalsingen die] misschien wat meer onder de radar gaan."

Beleidsmakers, technologiebedrijven en onderzoekers moeten samenwerken om uitgebreide strategieën te ontwikkelen voor het detecteren en tegengaan van deepfakes, door AI gegenereerde desinformatie en andere vormen van AI-misbruik.

Maar de waarheid is dat ze het al hebben geprobeerd - en grotendeels hebben gefaald. Recentelijk hebben we meer incidenten waargenomen van kinderen die verstrikt raken in valse incidentenwaaruit blijkt dat de maatschappelijke schade die ze aanrichten ernstig kan zijn.

Op dit moment kunnen techbedrijven niet betrouwbaar deep fakes op schaal detecteren en ze zullen in de loop der tijd alleen maar realistischer en moeilijker te detecteren worden.

En zodra tekst-naar-videosystemen zoals OpenAI's Sora landt, komt er een hele nieuwe dimensie van diepe vervalsingen om mee om te gaan.