Anthropic onderzoekers hebben met succes miljoenen concepten geïdentificeerd binnen Claude Sonnet, een van hun gevorderde LLM's.

AI-modellen worden vaak beschouwd als zwarte dozen, wat betekent dat je er niet in kunt 'kijken' om precies te begrijpen hoe ze werken.

Als je een LLM een invoer geeft, genereert deze een antwoord, maar de redenering achter de keuzes is niet duidelijk.

Je input gaat erin en de output komt eruit - en zelfs de AI-ontwikkelaars zelf begrijpen niet echt wat er in die 'doos' gebeurt.

Neurale netwerken creëren hun eigen interne representaties van informatie wanneer ze inputs toewijzen aan outputs tijdens het trainen van gegevens. De bouwstenen van dit proces, "neuronactivaties" genoemd, worden weergegeven door numerieke waarden.

Elk concept is verdeeld over meerdere neuronen en elk neuron draagt bij aan de representatie van meerdere concepten, waardoor het lastig is om concepten direct in kaart te brengen bij individuele neuronen.

Dit is in grote lijnen vergelijkbaar met onze menselijke hersenen. Net zoals onze hersenen zintuiglijke input verwerken en gedachten, gedrag en herinneringen genereren, blijven de miljarden, zelfs triljarden processen achter deze functies voornamelijk onbekend voor de wetenschap.

Anthropiconderzoek probeert in de zwarte doos van AI te kijken met een techniek die "woordenboekleren" wordt genoemd.

Dit houdt in dat complexe patronen in een AI-model worden ontleed in lineaire bouwstenen of "atomen" die intuïtief zinvol zijn voor mensen.

LLM's in kaart brengen met woordenboekleren

In oktober 2023, Anthropic pasten deze methode toe op een klein "speelgoed" taalmodel en vonden coherente kenmerken die overeenkomen met concepten als hoofdletters, DNA-sequenties, achternamen in citaten, wiskundige zelfstandige naamwoorden of functieargumenten in Python-code.

In dit nieuwste onderzoek wordt de techniek opgeschaald om te werken voor de grotere AI-taalmodellen van vandaag, in dit geval, Anthropic's Claude 3 Sonnet.

Hier wordt stap voor stap uitgelegd hoe het onderzoek in zijn werk ging:

Patronen identificeren met woordenboekleren

Anthropic gebruikten woordenboekleren om neuronactivaties in verschillende contexten te analyseren en gemeenschappelijke patronen te identificeren.

Woordenboek leren groepeert deze activeringen in een kleinere set van betekenisvolle "kenmerken", die concepten van een hoger niveau vertegenwoordigen die door het model zijn geleerd.

Door deze kenmerken te identificeren, kunnen onderzoekers beter begrijpen hoe het model informatie verwerkt en weergeeft.

Kenmerken extraheren uit de middelste laag

De onderzoekers richtten zich op de middelste laag van Claude 3.0 Sonnet, dat dient als kritisch punt in de verwerkingspijplijn van het model.

Door woordenboekleren toe te passen op deze laag worden miljoenen kenmerken geëxtraheerd die de interne representaties en geleerde concepten van het model in dit stadium vastleggen.

Door kenmerken uit de middelste laag te extraheren, kunnen onderzoekers onderzoeken hoe het model informatie begrijpt. na het heeft de invoer verwerkt voor die de uiteindelijke uitvoer genereert.

Diverse en abstracte concepten ontdekken

De geëxtraheerde kenmerken onthulden een uitgebreide reeks concepten die geleerd waren door ClaudeVan concrete entiteiten zoals steden en mensen tot abstracte begrippen gerelateerd aan wetenschappelijke velden en programmeersyntaxis.

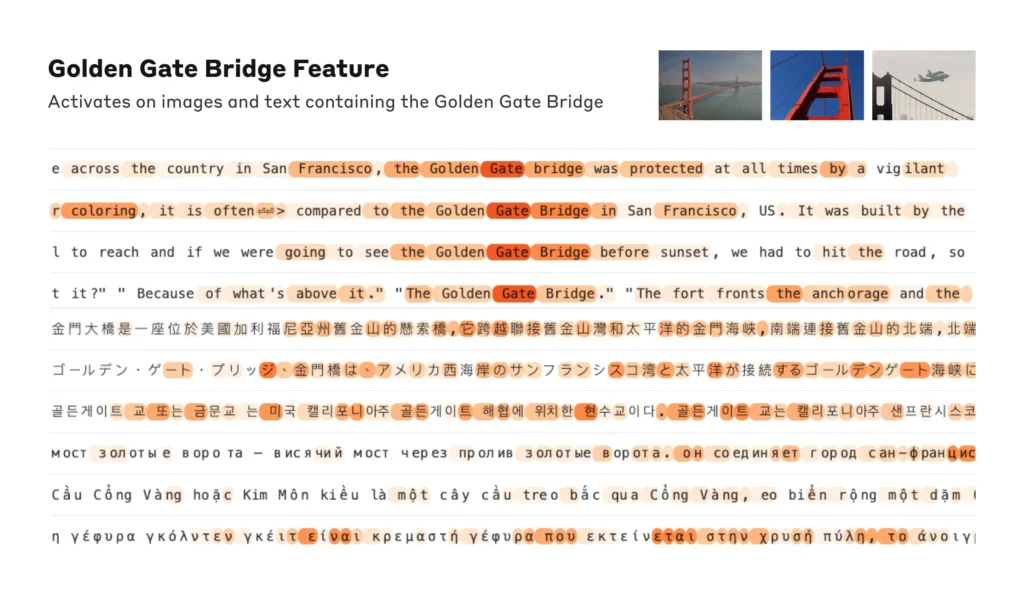

Interessant genoeg bleken de kenmerken multimodaal te zijn en te reageren op zowel tekstuele als visuele input, wat aangeeft dat het model concepten kan leren en representeren in verschillende modaliteiten.

Bovendien suggereren de meertalige kenmerken dat het model concepten in verschillende talen kan begrijpen.

De organisatie van concepten analyseren

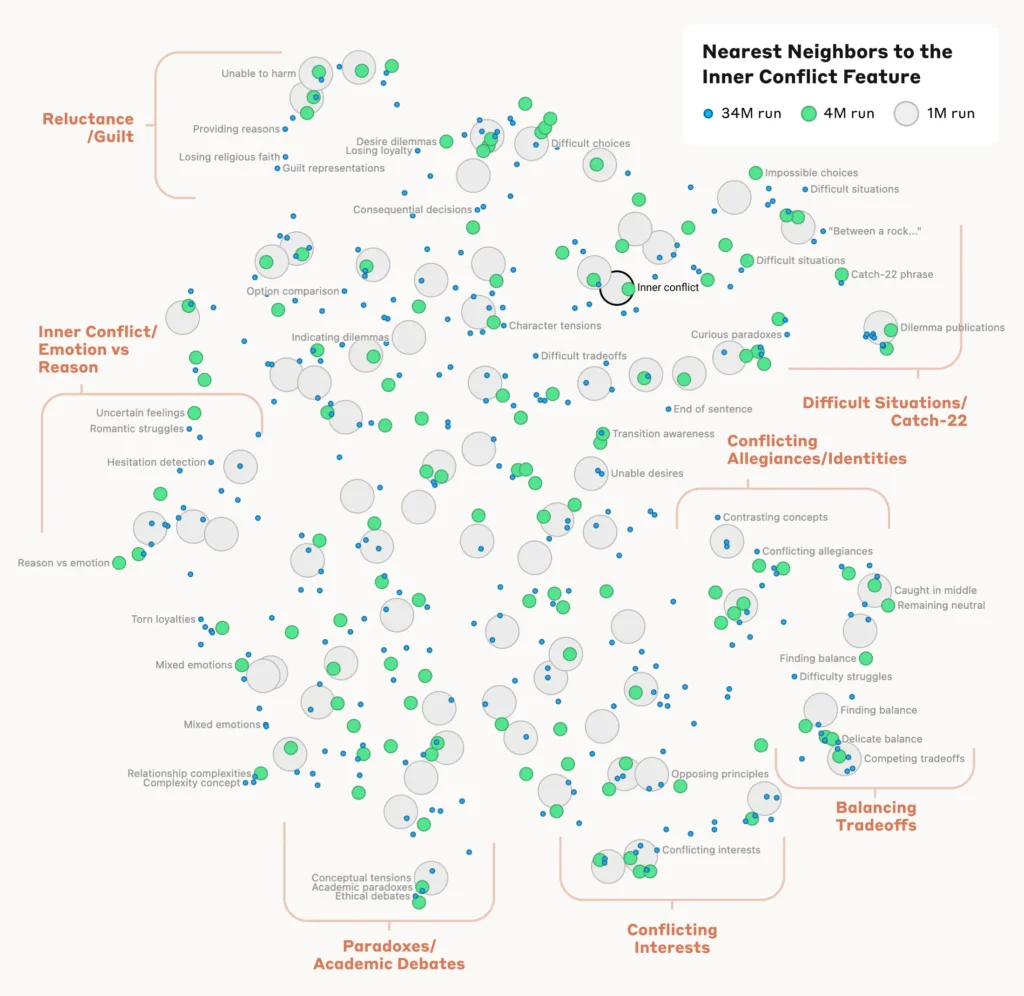

Om te begrijpen hoe het model verschillende concepten organiseert en met elkaar in verband brengt, analyseerden de onderzoekers de overeenkomsten tussen kenmerken op basis van hun activeringspatronen.

Ze ontdekten dat kenmerken die verwante concepten vertegenwoordigen de neiging hadden om samen te clusteren. Kenmerken die bijvoorbeeld geassocieerd werden met steden of wetenschappelijke disciplines vertoonden een grotere overeenkomst dan kenmerken die niet-gerelateerde concepten vertegenwoordigden.

Dit suggereert dat de interne organisatie van concepten in het model tot op zekere hoogte overeenkomt met menselijke intuïties over conceptuele relaties.

De functies controleren

Om te bevestigen dat de geïdentificeerde kenmerken het gedrag en de uitvoer van het model direct beïnvloeden, voerden de onderzoekers experimenten uit met "kenmerksturing".

Dit bestond uit het selectief versterken of onderdrukken van de activatie van specifieke kenmerken tijdens de verwerking van het model en het observeren van het effect op de reacties.

Door individuele kenmerken te manipuleren, konden onderzoekers een direct verband leggen tussen individuele kenmerken en het gedrag van het model. Door bijvoorbeeld een kenmerk met betrekking tot een bepaalde stad te versterken, genereerde het model stadsafhankelijke uitkomsten, zelfs in irrelevante contexten.

Lees het volledige onderzoek hier.

Waarom interpreteerbaarheid cruciaal is voor AI-veiligheid

AnthropicHet onderzoek is fundamenteel relevant voor de interpreteerbaarheid van AI en, in het verlengde daarvan, veiligheid.

Inzicht in hoe LLM's informatie verwerken en weergeven, helpt onderzoekers om risico's te begrijpen en te beperken. Het legt de basis voor de ontwikkeling van transparantere en beter verklaarbare AI-systemen.

Als Anthropic legt uit: "We hopen dat wij en anderen deze ontdekkingen kunnen gebruiken om modellen veiliger te maken. Het zou bijvoorbeeld mogelijk kunnen zijn om de hier beschreven technieken te gebruiken om AI-systemen te controleren op bepaald gevaarlijk gedrag (zoals het misleiden van de gebruiker), om ze in de richting van gewenste uitkomsten te sturen (debiasing), of om bepaalde gevaarlijke onderwerpen helemaal te verwijderen."

Het ontsluiten van een beter begrip van AI-gedrag wordt van het grootste belang naarmate ze alomtegenwoordig worden voor kritieke besluitvormingsprocessen op gebieden als gezondheidszorg, financiën en strafrecht. Het helpt ook om de hoofdoorzaak van biashallucinaties en ander ongewenst of onvoorspelbaar gedrag.

Bijvoorbeeld een recente studie van de Universiteit van Bonn ontdekte hoe grafische neurale netwerken (GNN's) die worden gebruikt voor het ontdekken van medicijnen, sterk vertrouwen op het oproepen van overeenkomsten uit trainingsgegevens in plaats van het echt leren van complexe nieuwe chemische interacties.

Dit maakt het moeilijk om te begrijpen hoe deze modellen precies nieuwe interessante verbindingen bepalen.

Vorig jaar was de Britse overheid onderhandeld met grote techgiganten zoals OpenAI en DeepMinddie toegang willen tot de interne besluitvormingsprocessen van hun AI-systemen.

Regelgeving zoals de AI-wet van de EU zal AI-bedrijven onder druk zetten om transparanter te worden, hoewel commerciële geheimen achter slot en grendel lijken te blijven.

AnthropicHet onderzoek biedt een glimp van wat er in de doos zit door informatie over het model 'in kaart te brengen'.

De waarheid is echter dat deze modellen zo uitgebreid zijn dat, door Anthropic"We denken dat het heel waarschijnlijk is dat we ordes van grootte te kort komen en dat als we alle kenmerken zouden willen krijgen - in alle lagen! - we veel meer rekenkracht nodig zouden hebben dan de totale rekenkracht die nodig is om de onderliggende modellen te trainen."

Dat is een interessant punt - het reverse engineeren van een model is rekenkundig complexer dan het engineeren van het model zelf.

Het doet denken aan enorm dure neurowetenschapsprojecten zoals de Human Brain Project (HBP)die miljarden heeft gestoken in het in kaart brengen van onze eigen menselijke hersenen om uiteindelijk te falen.

Onderschat nooit hoeveel er in de zwarte doos zit.