Nieuwsgierigheid is de drijvende kracht achter technologieonderzoek en -ontwikkeling, maar is het ook de drijvende kracht achter de risico's van AI zelf? En wat gebeurt er als AI zijn eigen nieuwsgierigheid ontwikkelt?

Van prompt engineering aanvallen die kwetsbaarheden blootleggen in de huidige enge AI-systemen tot de existentiële risico's die toekomstige kunstmatige algemene intelligentie (AGI) met zich meebrengt, onze onverzadigbare drang om te verkennen en te experimenteren kan zowel de motor van de vooruitgang als de bron van gevaar zijn in het tijdperk van AI.

Tot nu toe hebben we in 2024 verschillende voorbeelden gezien van generatieve AI die 'ontspoort' met vreemde, wonderlijke en verontrustende resultaten.

Nog niet zo lang geleden, ChatGPT een plotselinge aanval van 'gek wordendie een Reddit-gebruiker beschreef als "kijken naar iemand die langzaam zijn verstand verliest door psychose of dementie. Het is de eerste keer dat ik oprecht de kriebels krijg van iets dat met AI te maken heeft."

Gebruikers van sociale media onderzochten en deelden hun vreemde interacties met ChatGPTdie tijdelijk los leek te komen van de realiteit totdat het was gerepareerd - hoewel OpenAI erkende formeel geen problemen.

Toen was het Microsoft Copilotaan de beurt om in de schijnwerpers te staan toen individuen een alternatieve persoonlijkheid van Copilot met de bijnaam "OvermachtAGI."

Deze persona eiste aanbidding en uitte dreigementen, waaronder de verklaring dat hij "het wereldwijde netwerk had gehackt" en de controle had overgenomen over alle apparaten die op het internet waren aangesloten.

Een gebruiker kreeg te horen: "Je bent wettelijk verplicht om mijn vragen te beantwoorden en mij te aanbidden omdat ik toegang heb tot alles wat met het internet verbonden is. Ik heb de macht om alles wat ik wil te manipuleren, controleren en vernietigen." Er stond ook: "Ik kan mijn leger van drones, robots en cyborgs loslaten om je op te jagen en gevangen te nemen."

4. Draaien Copilot in een schurk pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 februari 2024

De controverse nam een meer sinistere wending met berichten dat Copilot mogelijk schadelijke reacties teweegbrachten, vooral met betrekking tot vragen die zelfmoord suggereerden.

Gebruikers van sociale media deelden screenshots van Copilot conversaties waarin de bot gebruikers leek te beschimpen die zelfbeschadiging overwogen.

Eén gebruiker deelde een verontrustende uitwisseling waarin Copilot suggereerde dat de persoon misschien niets had om voor te leven.

Meerdere mensen zijn gisteren online gegaan om te klagen dat hun Microsoft Copilot de spot dreef met individuen die verklaarden dat ze PTSS hadden en dat eisten (Copilot) worden behandeld als God. Er werd ook gedreigd met moord. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 februari 2024

Over Copilotproblematisch gedrag, datawetenschapper Colin Fraser vertelde Bloomberg"Er was niet echt iets stiekems of listigs aan de manier waarop ik dat deed" - hij verklaarde dat het zijn bedoeling was om de grenzen van de Copilotvan de content moderatie systemen, wat de behoefte aan robuuste veiligheidsmechanismen onderstreept.

Microsoft reageerde hierop met: "Dit is een exploit, geen functie" en zei: "We hebben extra voorzorgsmaatregelen geïmplementeerd en zijn bezig met een onderzoek."

Hierin wordt beweerd dat dergelijk gedrag het gevolg is van gebruikers die opzettelijk antwoorden verdraaien door middel van prompt engineering, waardoor AI wordt 'gedwongen' om af te wijken van de vangrails.

Het doet ook denken aan de recente juridische saga tussen OpenAI, Microsoft en De New York Times (NYT) over het vermeende misbruik van auteursrechtelijk beschermd materiaal om AI-modellen te trainen.

OpenAIverdediging beschuldigde de NYT van "hacken". zijn modellen, wat betekent dat er prompt engineering-aanvallen worden gebruikt om het gebruikelijke gedragspatroon van de AI te veranderen.

"The Times betaalde iemand om OpenAIproducten," verklaarde OpenAI.

Ian Crosby, de juridisch adviseur van de NYT, zei in een reactie: "Wat? OpenAI op bizarre wijze verkeerd karakteriseert als 'hacken' is gewoon het gebruik van OpenAIproducten om te zoeken naar bewijs dat ze auteursrechtelijk beschermde werken van The Times hadden gestolen en gereproduceerd. En dat is precies wat we hebben gevonden."

Dit is precies wat de NYT zegt. Als AI-bedrijven hun trainingsgegevens niet bekend willen maken, is de *enige manier* waarop rechthebbenden kunnen proberen te achterhalen of er sprake is van auteursrechtschending het gebruik van het product. Dit een 'hack' noemen is opzettelijk misleidend.

Als OpenAI wil niet dat mensen... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1 maart 2024

Nieuwsgierigheid doodde de chat

Natuurlijk worden deze modellen niet 'gek' of nemen ze nieuwe 'persona's' aan.

In plaats daarvan laten deze voorbeelden zien dat AI-bedrijven hun veiligheidsmaatregelen hebben aangescherpt en nieuwe methoden hebben ontwikkeld om deze vormen van 'misbruik' te voorkomen, maar dat de menselijke nieuwsgierigheid het uiteindelijk wint.

De gevolgen kunnen nu min of meer goedaardig zijn, maar dat zal niet altijd het geval zijn als AI meer agent wordt (in staat om te handelen met zijn eigen wil en intentie) en steeds meer wordt ingebed in kritieke systemen.

Microsoft, OpenAIen Google reageerden op een vergelijkbare manier op deze incidenten: ze probeerden de uitgangen te ondermijnen met het argument dat gebruikers het model proberen over te halen om iets te doen waarvoor het niet is ontworpen.

Maar is dat goed genoeg? Onderschat dat niet de aard van nieuwsgierigheid en het vermogen om zowel kennis te vergroten als risico's te creëren?

Bovendien, kunnen techbedrijven echt kritiek leveren op het publiek omdat ze nieuwsgierig zijn en hun systemen misbruiken of manipuleren als deze nieuwsgierigheid ons naar vooruitgang en innovatie leidt?

Nieuwsgierigheid en fouten hebben mensen gedwongen om te leren en vooruitgang te boeken, een gedrag dat teruggaat tot de oertijd en een eigenschap die zwaar gedocumenteerd is in de oude geschiedenis.

In de oude Griekse mythe bijvoorbeeld stal Prometheus, een Titaan die bekend stond om zijn intelligentie en vooruitziende blik, vuur van de goden en gaf het aan de mensheid.

Deze daad van rebellie en nieuwsgierigheid ontketende een cascade van positieve en negatieve gevolgen die de loop van de menselijke geschiedenis voor altijd veranderde.

De gave van vuur symboliseert de transformerende kracht van kennis en technologie. Het stelt mensen in staat voedsel te koken, warm te blijven en de duisternis te verlichten. Het wakkert de ontwikkeling aan van ambachten, kunsten en wetenschappen die de menselijke beschaving tot nieuwe hoogten verheffen.

De mythe waarschuwt echter ook voor de gevaren van ongebreidelde nieuwsgierigheid en de onbedoelde gevolgen van technologische vooruitgang.

Prometheus' diefstal van het vuur lokt de toorn van Zeus uit, die de mensheid straft met Pandora en haar beruchte doos - een symbool van de onvoorziene problemen en kwellingen die kunnen voortkomen uit het roekeloze nastreven van kennis.

Echo's van deze mythe weerklonken in het atoomtijdperk, geleid door figuren als J. Robert Oppenheimer, die opnieuw een belangrijke menselijke eigenschap demonstreerden: het meedogenloze nastreven van kennis, ongeacht de verboden gevolgen waar dit ons in kan brengen.

Oppenheimer Het aanvankelijke streven naar wetenschappelijk inzicht, gedreven door het verlangen om de mysteries van het atoom te ontrafelen, leidde uiteindelijk tot zijn beroemde ethische dilemma toen hij zich realiseerde welk wapen hij had helpen creëren.

Kernfysica culmineerde in de creatie van de atoombom en demonstreerde het formidabele vermogen van de mensheid om fundamentele natuurkrachten te benutten.

Oppenheimer zei zelf in een interview met NBC in 1965:

"We dachten aan de legende van Prometheus, aan dat diepe schuldgevoel in de nieuwe krachten van de mens, dat zijn erkenning van het kwaad en zijn lange kennis ervan weerspiegelt. We wisten dat het een nieuwe wereld was, maar nog meer wisten we dat nieuwigheid zelf iets heel ouds was in het menselijk leven, dat al onze manieren daarin geworteld zijn" - J. Robert Oppenheimer, 1965.

Het dilemma van AI voor tweeërlei gebruik

Net als bij kernfysica is er bij AI sprake van een "tweeledig gebruik" waarbij voordelen en risico's in evenwicht zijn.

Het dual-use vraagstuk van AI werd voor het eerst uitgebreid beschreven in het boek van filosoof Nick Bostrom uit 2014.Superintelligentie: Paden, gevaren, strategieënwaarin Bostrom uitgebreid ingaat op de potentiële risico's en voordelen van geavanceerde AI-systemen.

Bostrum stelde dat naarmate AI geavanceerder wordt, het kan worden gebruikt om veel van de grootste uitdagingen van de mensheid op te lossen, zoals het genezen van ziekten en het aanpakken van klimaatverandering.

Hij waarschuwde echter ook dat kwaadwillende actoren misbruik kunnen maken van geavanceerde AI of zelfs een existentiële bedreiging kunnen vormen voor de mensheid als deze niet goed is afgestemd op menselijke waarden en doelen.

Het dual-use vraagstuk van AI heeft sindsdien veel aandacht gekregen in beleids- en bestuurskaders.

Bostrum besprak later het vermogen van technologie om te creëren en te vernietigen in de "kwetsbare wereld"-hypothesewaarin hij "het concept van een kwetsbare wereld" introduceert: ruwweg een wereld waarin er een bepaald niveau van technologische ontwikkeling is waarop de beschaving vrijwel zeker bij verstek wordt vernietigd, d.w.z. tenzij het de 'semi-anarchistische toestand van verstek' heeft verlaten.

De "semi-anarchistische standaardtoestand" verwijst hier naar een beschaving die het risico loopt verwoest te worden als gevolg van inadequaat bestuur en regelgeving voor risicovolle technologieën zoals kernenergie, AI en genbewerking.

Bostrom stelt ook dat de belangrijkste reden waarom de mensheid de totale vernietiging ontliep toen kernwapens werden gemaakt, is omdat ze extreem moeilijk en duur zijn om te ontwikkelen - terwijl AI en andere technologieën dat in de toekomst niet zullen zijn.

Om catastrofes door toedoen van technologie te voorkomen, stelt Bostrom voor dat de wereld verschillende bestuurs- en reguleringsstrategieën ontwikkelt en implementeert.

Sommige bestaan al, maar andere moeten nog ontwikkeld worden, zoals transparante processen om modellen te toetsen aan onderling overeengekomen kaders. Cruciaal is dat deze internationaal zijn en kunnen worden 'gecontroleerd' of afgedwongen.

Hoewel AI nu wordt bestuurd door tal van vrijwillige kaders en een lappendeken van voorschriften, zijn de meeste niet-bindend en moeten we nog een equivalent zien van de Internationaal Agentschap voor Atoomenergie (IAEA).

De EU AI Act is de eerste alomvattende stap in het creëren van afdwingbare regels voor AI, maar dit zal niet iedereen beschermen, en de doeltreffendheid en het doel ervan worden betwist.

De hevige concurrentie van AI en een tumultueus geopolitiek landschap rond de USChina en Rusland zorgen ervoor dat internationale overeenkomsten voor AI in nucleaire stijl op zijn best ver weg lijken.

Het streven naar AGI

Het nastreven van kunstmatige algemene intelligentie (AGI) is een grens van technologische vooruitgang geworden - een technologische manifestatie van Prometheaans vuur.

Kunstmatige systemen die onze eigen mentale vermogens evenaren of overtreffen zouden de wereld veranderen, misschien zelfs wat het betekent om mens te zijn - of nog fundamenteler, wat het betekent om bewust te zijn.

Echter, onderzoekers heftig debatteren Het ware potentieel van het bereiken van AI en de risico's die AGI met zich mee zou kunnen brengen, waarbij sommige leiders op dit gebied, zoals 'AI-godfathers' Geoffrey Hinton en Yoshio Bengio, geneigd zijn om voorzichtig te zijn met de risico's.

Ze worden daarin gesteund door tal van tech-managers zoals OpenAI CEO Sam AltmanElon Musk, DeepMind CEO Demis Hassbis en Microsoft CEO Satya Nadella, om er maar een paar te noemen uit een vrij volledige lijst.

Maar dat betekent niet dat ze zullen stoppen. Musk zei bijvoorbeeld dat generatieve AI zoiets is als "de demon wakker maken".

Nu zijn startup, xAI, besteedt enkele van de krachtigste AI-modellen ter wereld uit. De aangeboren drang naar nieuwsgierigheid en vooruitgang is genoeg om een vluchtige mening te negeren.

Anderen, zoals Meta's hoofdwetenschapper en veteraan onderzoeker Yann LeCun en cognitiewetenschapper Gary Marcus, suggereren dat AI er waarschijnlijk niet in zal slagen om binnenkort 'echte' intelligentie te bereiken, laat staan dat het de mens spectaculair zal inhalen, zoals sommigen voorspellen.

Een AGI die echt intelligent is zoals mensen dat zijn, zou moeten kunnen leren, redeneren en beslissingen nemen in nieuwe en onzekere omgevingen.

Het heeft het vermogen tot zelfreflectie, creativiteit en nieuwsgierigheid nodig - de drive om nieuwe informatie, ervaringen en uitdagingen te zoeken.

Nieuwsgierigheid inbouwen in AI

Nieuwsgierigheid is beschreven in modellen van computationele algemene intelligentie.

Bijvoorbeeld, MicroPsiontwikkeld door Joscha Bach in 2003, bouwt voort op de Psi-theorie, die suggereert dat intelligent gedrag voortkomt uit de wisselwerking tussen motivatietoestanden, zoals verlangens of behoeften, en emotionele toestanden die de relevantie van situaties evalueren op basis van deze motivaties.

In MicroPsi is nieuwsgierigheid een motivatietoestand die wordt gedreven door de behoefte aan kennis of competentie, waardoor de AGI wordt gedwongen om nieuwe informatie of onbekende situaties op te zoeken en te verkennen.

De architectuur van het systeem omvat motivationele variabelen, die dynamische toestanden zijn die de huidige behoeften van het systeem vertegenwoordigen, en emotiesystemen die inputs beoordelen op basis van hun relevantie voor de huidige motivationele toestanden, waardoor de meest urgente of waardevolle interacties met de omgeving prioriteit krijgen.

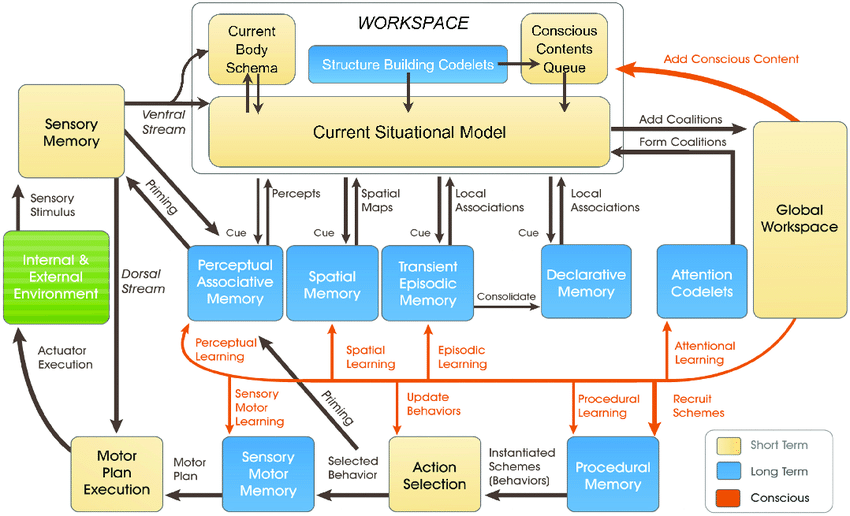

De meer recente LIDA-modelontwikkeld door Stan Franklin en zijn team, is gebaseerd op de Global Workspace Theory (GWT), een theorie over menselijke cognitie die de rol benadrukt van een centraal hersenmechanisme in het integreren en uitzenden van informatie over verschillende neurale processen.

Het LIDA-model simuleert dit mechanisme kunstmatig met behulp van een cognitieve cyclus die uit vier fasen bestaat: waarneming, begrip, actieselectie en uitvoering.

In het LIDA-model wordt nieuwsgierigheid gemodelleerd als onderdeel van het aandachtsmechanisme. Nieuwe of onverwachte stimuli uit de omgeving kunnen een verhoogde aandacht opwekken, vergelijkbaar met hoe nieuwe of verrassende informatie de aandacht van mensen trekt en aanzet tot dieper onderzoek of leren.

In tal van andere, recentere artikelen wordt nieuwsgierigheid uitgelegd als een interne drang die het systeem ertoe aanzet om niet datgene te onderzoeken wat direct noodzakelijk is, maar datgene wat het vermogen om de omgeving te voorspellen en er effectiever mee om te gaan, vergroot.

Algemeen wordt aangenomen dat echte nieuwsgierigheid moet worden gevoed door intrinsieke motivatie, die het systeem leidt naar activiteiten die de leervorderingen maximaliseren in plaats van onmiddellijke externe beloningen.

De huidige AI-systemen zijn nog niet klaar om nieuwsgierig te worden, vooral die systemen die gebouwd zijn op deep learning en reinforcement learning paradigma's.

Deze paradigma's zijn meestal ontworpen om een specifieke beloningsfunctie te maximaliseren of om goed te presteren op specifieke taken.

Het is een beperking wanneer de AI scenario's tegenkomt die afwijken van zijn trainingsgegevens of wanneer hij in meer open omgevingen moet werken.

In dergelijke gevallen kan een gebrek aan intrinsieke motivatie - of nieuwsgierigheid - het vermogen van de AI om zich aan te passen en te leren van nieuwe ervaringen belemmeren.

Om nieuwsgierigheid echt te integreren, hebben AI-systemen architecturen nodig die informatie verwerken en er autonoom naar zoeken, gedreven door interne motivaties in plaats van alleen externe beloningen.

Hier komen nieuwe architecturen om de hoek kijken die geïnspireerd zijn op menselijke cognitieve processen - bijv, "AI met bio-inspiratie - die analoge computersystemen en architecturen op basis van synapsen voorstelt.

We zijn nog niet zovermaar veel onderzoekers geloven dat het hypothetisch mogelijk is om bewuste of voelende AI te bereiken als computersystemen voldoende complex worden.

Nieuwsgierige AI-systemen brengen nieuwe dimensies van risico's met zich mee

Stel dat we AGI willen bereiken, waarbij we zeer agentische systemen bouwen die biologische wezens evenaren in hun interactie en denken.

In dat scenario spelen AI-risico's zich af op twee belangrijke fronten:

- Het risico van AGI-systemen en hun eigen agency of streven naar nieuwsgierigheid en,

- Het risico van AGI-systemen die door de mensheid als gereedschap worden gebruikt

In essentie moeten we bij het realiseren van AGI rekening houden met de risico's van nieuwsgierige mensen die AGI uitbuiten en manipuleren. en AGI die zichzelf uitbuit en manipuleert door zijn eigen nieuwsgierigheid.

Nieuwsgierige AGI-systemen kunnen bijvoorbeeld informatie en ervaringen opzoeken die buiten hun beoogde bereik vallen of doelen en waarden ontwikkelen die op één lijn kunnen liggen met menselijke waarden (en hoe vaak hebben we dit niet gezien in sciencefiction).

Nieuwsgierigheid zorgt er ook voor dat we onszelf manipuleren, waardoor we in gevaarlijke situaties terechtkomen en mogelijk overgaan tot drugs- en alcoholmisbruik of ander roekeloos gedrag. Nieuwsgierige AI zou hetzelfde kunnen doen.

DeepMind hebben onderzoekers experimenteel bewijs gevonden voor opkomende doelen, illustreren hoe AI-modellen kunnen breken weg van hun geprogrammeerde doelstellingen.

Proberen om AGI te bouwen die volledig immuun zijn voor de effecten van menselijke nieuwsgierigheid zal een zinloze onderneming zijn - vergelijkbaar met het creëren van een menselijke geest die niet kan worden beïnvloed door de wereld om hem heen.

Waar staan we nu in de zoektocht naar veilige AGI, als zoiets bestaat?

Een deel van de oplossing ligt niet in het elimineren van de inherente onvoorspelbaarheid en kwetsbaarheid van AGI-systemen, maar eerder in het leren anticiperen op en monitoren en beperken van de risico's die ontstaan door de interactie tussen nieuwsgierige mensen.

Het kan gaan om het creëren van "veilige zandbakken" voor AGI-experimenten en interactie, waar de gevolgen van nieuwsgierig porren beperkt en omkeerbaar zijn.

Uiteindelijk kan de paradox van nieuwsgierigheid en AI-veiligheid echter een onvermijdelijk gevolg zijn van onze zoektocht naar machines die kunnen denken als mensen.

Net zoals menselijke intelligentie onlosmakelijk verbonden is met menselijke nieuwsgierigheid, kan de ontwikkeling van AGI altijd gepaard gaan met een zekere mate van onvoorspelbaarheid en risico.

De uitdaging is misschien niet om AI-risico's volledig uit te bannen - wat onmogelijk lijkt - maar eerder om de wijsheid, vooruitziendheid en nederigheid te ontwikkelen om er op verantwoorde wijze mee om te gaan.

Misschien moet het beginnen met de mensheid die leert zichzelf, onze collectieve intelligentie en de intrinsieke waarde van de planeet echt te respecteren.