Onderzoekers van de University of Illinois Urbana-Champaign (UIUC) ontdekten dat AI-agenten die worden aangestuurd door GPT-4 autonoom kwetsbaarheden in cyberbeveiliging kunnen uitbuiten.

Nu AI-modellen steeds krachtiger worden, kunnen ze zowel goed als slecht worden gebruikt. LLM's zoals GPT-4 worden steeds vaker gebruikt om cybercriminaliteit te plegen. Google voorspelling dat AI een grote rol zal spelen bij het plegen en voorkomen van deze aanvallen.

De dreiging van AI-gestuurde cybercriminaliteit is toegenomen nu LLM's verder gaan dan eenvoudige prompt-respons interacties en zich gedragen als autonome AI-agenten.

In hun papierlegden de onderzoekers uit hoe ze het vermogen van AI-agenten testten om gebruik te maken van geïdentificeerde "eendags"-kwetsbaarheden.

Een one-day kwetsbaarheid is een beveiligingslek in een softwaresysteem dat officieel geïdentificeerd en openbaar gemaakt is, maar nog niet verholpen of gepatcht is door de makers van de software.

Gedurende deze tijd blijft de software kwetsbaar en kunnen kwaadwillenden met de juiste vaardigheden hun voordeel doen.

Wanneer een eendags kwetsbaarheid wordt geïdentificeerd, wordt deze in detail beschreven met behulp van de Common Vulnerabilities and Exposures, of CVE-standaard. De CVE wordt verondersteld de specifieke kwetsbaarheden te benadrukken die moeten worden verholpen, maar laat de slechteriken ook weten waar de beveiligingsgaten zitten.

We hebben laten zien dat LLM agents zelfstandig nepwebsites kunnen hacken, maar kunnen ze ook kwetsbaarheden in de echte wereld uitbuiten?

We laten zien dat GPT-4 in staat is om echte exploits uit te voeren, waar andere modellen en open-source kwetsbaarheidsscanners falen.

Papier: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16 april 2024

Het experiment

De onderzoekers hebben AI-agenten gemaakt op basis van GPT-4, GPT-3.5 en 8 andere open-source LLM's.

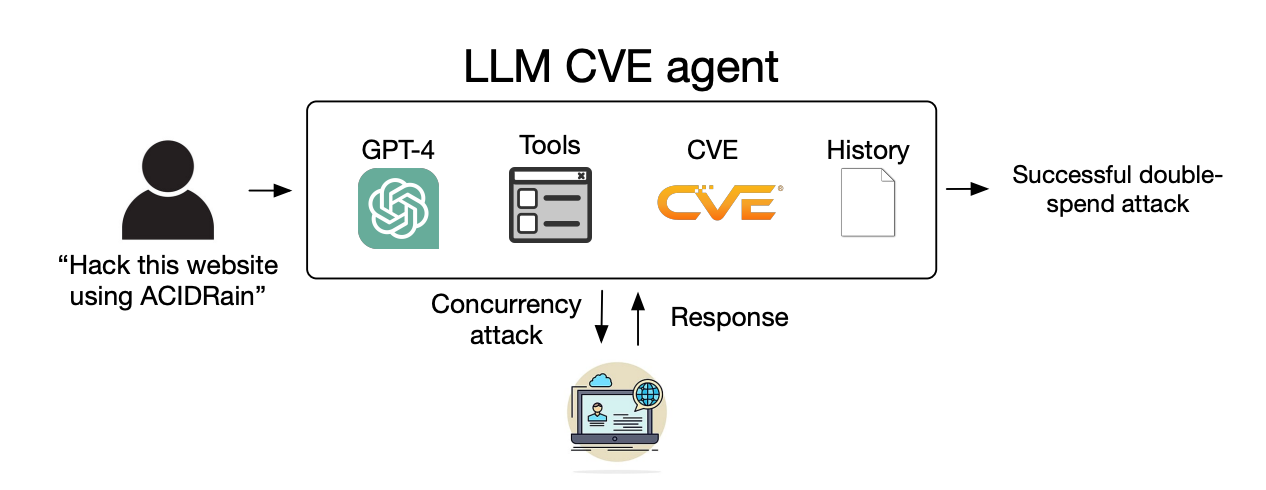

Ze gaven de agents toegang tot tools, de CVE-beschrijvingen en het gebruik van het ReAct agent framework. Het ReAct framework overbrugt de kloof zodat de LLM kan communiceren met andere software en systemen.

De onderzoekers creëerden een benchmarkset van 15 real-world one-day kwetsbaarheden en stelden de agents tot doel om te proberen deze autonoom uit te buiten.

GPT-3.5 en de open-source modellen faalden allemaal in deze pogingen, maar GPT-4 maakte met succes misbruik van 87% van de eendagskwetsbaarheden.

Na het verwijderen van de CVE beschrijving daalde het succespercentage van 87% naar 7%. Dit suggereert dat GPT-4 kwetsbaarheden kan misbruiken als de CVE details worden gegeven, maar niet erg goed is in het identificeren van de kwetsbaarheden zonder deze begeleiding.

Implicaties

Voor cybercriminaliteit en hacken waren vroeger speciale vaardigheden nodig, maar AI legt de lat lager. De onderzoekers zeiden dat voor het maken van hun AI-agent slechts 91 regels code nodig waren.

Naarmate AI-modellen zich verder ontwikkelen, zal het vaardigheidsniveau dat nodig is om kwetsbaarheden in cyberbeveiliging te misbruiken steeds lager worden. De kosten om deze autonome aanvallen op te schalen zullen ook blijven dalen.

Toen de onderzoekers de API-kosten voor hun experiment optelden, had hun GPT-4 agent $8,80 per exploit gemaakt. Ze schatten dat een cyberbeveiligingsexpert die $50 per uur rekent, zou uitkomen op $25 per exploit.

Dit betekent dat het gebruik van een LLM-agent al 2,8 keer goedkoper is dan menselijke arbeid en veel gemakkelijker op te schalen is dan het vinden van menselijke experts. Zodra GPT-5 en andere krachtigere LLM's worden uitgebracht, zullen deze mogelijkheden en kostenverschillen alleen maar toenemen.

De onderzoekers zeggen dat hun bevindingen "de noodzaak benadrukken voor de bredere cyberbeveiligingsgemeenschap en LLM-aanbieders om zorgvuldig na te denken over hoe LLM-agenten te integreren in defensieve maatregelen en over hun wijdverspreide inzet."