We horen veel over AI-veiligheid, maar betekent dat ook dat er veel onderzoek naar wordt gedaan?

Een nieuwe onderzoek van Georgetown University's Emerging Technology Observatory suggereert dat, ondanks het lawaai, AI-veiligheidsonderzoek slechts een kleine minderheid van het onderzoek van de industrie in beslag neemt.

De onderzoekers analyseerden meer dan 260 miljoen wetenschappelijke publicaties en ontdekten dat slechts 2% van de AI-gerelateerde artikelen die tussen 2017 en 2022 werden gepubliceerd, rechtstreeks onderwerpen behandelden die te maken hadden met AI-veiligheid, ethiek, robuustheid of governance.

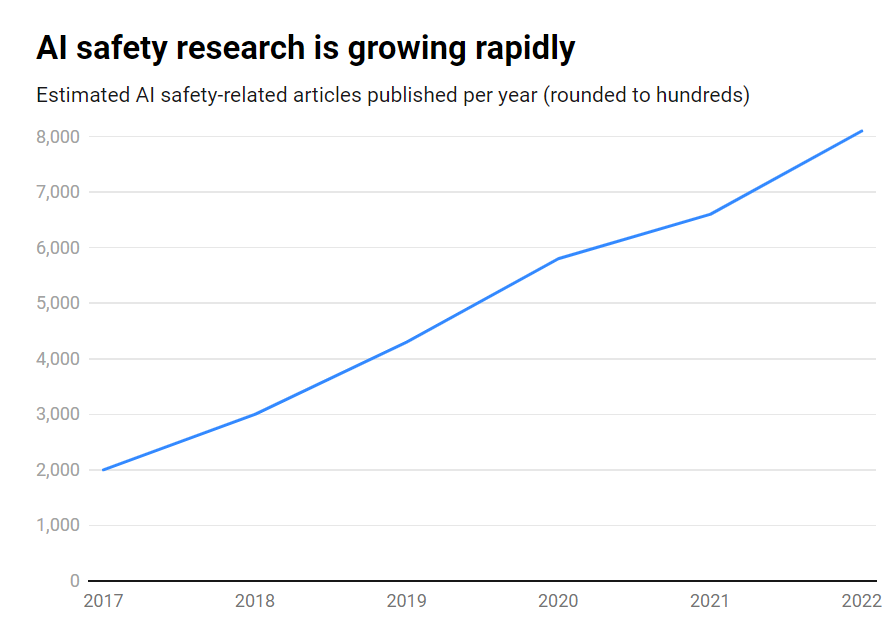

Hoewel het aantal publicaties over AI-veiligheid in die periode een indrukwekkende 315% groei liet zien, van ongeveer 1800 naar meer dan 7000 per jaar, blijft het een perifeer onderwerp.

Dit zijn de belangrijkste bevindingen:

- Slechts 2% van het AI-onderzoek in de periode 2017-2022 was gericht op AI-veiligheid

- Het AI-veiligheidsonderzoek groeide in die periode met 315%, maar valt in het niet bij het totale AI-onderzoek.

- De VS leidt in AI-veiligheidsonderzoek, terwijl China achterblijft

- De belangrijkste uitdagingen zijn robuustheid, eerlijkheid, transparantie en het behoud van menselijke controle.

Veel vooraanstaande AI-onderzoekers en ethici hebben gewaarschuwd voor existentiële risico's als kunstmatige algemene intelligentie (AGI) wordt ontwikkeld zonder voldoende waarborgen en voorzorgsmaatregelen.

Stel je een AGI-systeem voor dat in staat is zichzelf recursief te verbeteren en snel de menselijke intelligentie overtreft terwijl het doelen nastreeft die niet overeenkomen met onze waarden. Het is een scenario dat volgens sommigen buiten onze controle zou kunnen vallen.

Het is echter geen eenrichtingsverkeer. Een groot aantal AI-onderzoekers gelooft zelfs dat AI-veiligheid is overhyped.

Bovendien denken sommigen zelfs dat de hype is gefabriceerd om Big Tech te helpen bij het afdwingen van regels en het elimineren van de gewone mensen. open source concurrenten.

Maar zelfs de huidige enge AI-systemen, getraind op gegevens uit het verleden, kunnen vooroordelen vertonen, schadelijke inhoud produceren, privacy schenden en kwaadwillig worden gebruikt.

Dus hoewel AI-veiligheid in de toekomst moet kijken, moet het ook risico's in het hier en nu aanpakken, wat aantoonbaar onvoldoende is omdat diepe vervalsingen, vooroordelen en andere problemen nog steeds opdoemen.

Effectief AI-veiligheidsonderzoek moet zowel gericht zijn op uitdagingen op de korte termijn als op speculatieve risico's op de langere termijn.

De VS leiden AI-veiligheidsonderzoek

Bij nadere bestudering van de gegevens blijkt dat de VS de duidelijke leider is op het gebied van AI-veiligheidsonderzoek, met 40% aan gerelateerde publicaties vergeleken met 12% uit China.

China's veiligheidsoutput blijft echter ver achter bij het algehele AI-onderzoek - terwijl 5% van het Amerikaanse AI-onderzoek betrekking had op veiligheid, deed slechts 1% van het Chinese onderzoek dat.

Je zou kunnen speculeren dat het onderzoeken van Chinees onderzoek een heel moeilijke taak is. Bovendien is China proactief over regulering - waarschijnlijk meer dan in de VS - dus deze gegevens geven de AI-industrie van het land misschien geen eerlijke kans.

Op instellingsniveau voeren Carnegie Mellon University, Google, MIT en Stanford de lijst aan.

Maar wereldwijd produceerde geen enkele organisatie meer dan 2% van alle veiligheidsgerelateerde publicaties, wat de noodzaak van een grotere, meer gezamenlijke inspanning onderstreept.

Onevenwichtigheden in veiligheid

Wat kunnen we doen om deze onbalans te corrigeren?

Dat hangt ervan af of je denkt dat AI-veiligheid een urgent risico is, vergelijkbaar met kernoorlog, pandemieën, enz. Er is geen eenduidig antwoord op deze vraag, waardoor AI-veiligheid een zeer speculatief onderwerp is met weinig wederzijdse erkenning. overeenkomst tussen onderzoekers.

Veiligheidsonderzoek en ethiek zijn ook enigszins verwant aan machinaal leren en vereisen andere vaardigheden, academische achtergronden, enz. die mogelijk niet goed gefinancierd worden.

Het dichten van de AI-veiligheidskloof vereist ook een confrontatie met vragen rond openheid en geheimhouding bij AI-ontwikkeling.

De grootste techbedrijven voeren uitgebreid intern veiligheidsonderzoek uit dat nooit is gepubliceerd. Naarmate de commercialisering van AI toeneemt, worden bedrijven steeds beschermder over hun AI-doorbraken.

OpenAI, bijvoorbeeld, was in zijn begindagen een krachtpatser op het gebied van onderzoek.

Het bedrijf produceerde vroeger diepgaande onafhankelijke audits van zijn producten, etiketteringsvooroordelen en risico's - zoals seksistische vooroordelen in haar CLIP-project.

Anthropic is nog steeds actief betrokken bij onderzoek naar AI-veiligheid en publiceert regelmatig studies over bias en jailbreaken.

DeepMind heeft ook de mogelijkheid gedocumenteerd dat AI-modellen 'emergente doelen' vaststellen en actief hun instructies tegenspreken of vijandig worden tegenover hun makers.

Over het algemeen heeft veiligheid echter een ondergeschikte rol gespeeld ten opzichte van vooruitgang, omdat Silicon Valley leeft volgens het motto 'snel bewegen en dingen kapotmaken'.

Het Georgetown-onderzoek benadrukt uiteindelijk dat universiteiten, overheden, techbedrijven en onderzoeksfinanciers meer moeite en geld moeten investeren in AI-veiligheid.

Sommigen hebben ook opgeroepen tot een internationale instantie voor AI-veiligheidvergelijkbaar met de Internationale Organisatie voor Atoomenergie (IAEA), die werd opgericht na een reeks nucleaire incidenten die diepgaande internationale samenwerking verplicht maakten.

Heeft AI zijn eigen ramp nodig om dat niveau van samenwerking tussen staten en bedrijven te bereiken? Laten we hopen van niet.