AI-bedrijven dringen aan op regelgeving. Is hun motivatie paranoia of altruïsme? Of stelt regulering concurrerende doelen veilig?

Begin mei schreef Luke Sernau, een senior software engineer bij Google, een informele memo over open-source AI. Het werd op grote schaal verspreid op de interne systemen van Google voordat een adviesbureau, Semi-Analysis, het deed, geverifieerd en gepubliceerd.

Hier zijn enkele fragmenten:

"We hebben bij OpenAI veel over onze schouders gekeken. Wie bereikt de volgende mijlpaal? Wat wordt de volgende stap?

Maar de ongemakkelijke waarheid is dat wij niet in de positie zijn om deze wapenwedloop te winnen en OpenAI ook niet. Terwijl wij aan het kibbelen waren, heeft een derde factie stilletjes onze lunch opgegeten. Ik heb het natuurlijk over open source.

Om het duidelijk te stellen: ze halen ons in. Dingen die wij als "grote open problemen" beschouwen, zijn vandaag opgelost en in mensenhanden. Hoewel onze modellen nog steeds een kleine voorsprong hebben in termen van kwaliteit, wordt de kloof verbazingwekkend snel kleiner.

Open-source modellen zijn sneller, meer aanpasbaar, meer privé en pound-for-pound meer capabel. Ze doen dingen met $100 en 13B params waar wij moeite mee hebben met $10M en 540B. En dat doen ze in weken, niet maanden.

Begin maart kreeg de open source gemeenschap hun eerste echt capabele foundation model in handen, toen Meta's LLaMA uitlekte naar het publiek.

Het had geen instructie of gespreksafstemming, en geen RLHF. Desondanks begreep de gemeenschap onmiddellijk het belang van wat ze hadden gekregen. Er volgde een enorme golf van innovatie, met slechts enkele dagen tussen belangrijke ontwikkelingen...

Hier zijn we dan, nauwelijks een maand later, en er zijn varianten met instructietuning, kwantisering, kwaliteitsverbeteringen, menselijke evaluaties, multimodaliteit, RLHF, enzovoort, enzovoort, waarvan er veel op elkaar voortbouwen. Het belangrijkste is dat ze het schaalprobleem hebben opgelost, zodat iedereen eraan kan sleutelen.

Veel van de nieuwe ideeën komen van gewone mensen. De toetredingsdrempel voor training en experimenteren is gedaald van de totale output van een grote onderzoeksorganisatie naar één persoon, een avond en een stevige laptop."

De memo van Sernau werd opgepikt door grote nieuwsmedia en leidde tot een debat over de vraag of achter het streven van grote bedrijven naar regulering een motief schuilgaat om open-source AI uit de markt te drukken. Ben Schrekcinger van Politico schrijftOpen source code is ook moeilijker te verbieden omdat er nieuwe instanties kunnen opduiken als toezichthouders een website of tool die er gebruik van maakt proberen uit te schakelen. In combinatie met andere decentraliserende eigenschappen hebben deze open-source projecten het potentieel om niet alleen het businessmodel van Silicon Valley te verstoren, maar ook de bestuursmodellen van Washington en Brussel."

De open-source AI-gemeenschap bloeit al. Ontwikkelaars lossen binnen enkele dagen uitdagingen op waar Google en OpenAI maanden of jaren over doen. Sernau stelt dat agile gemeenschappen van open-source ontwikkelaars beter uitgerust zijn om iteratiemodellen te bouwen dan big tech, omdat ze diverser, efficiënter en pragmatischer zijn.

Als dit het geval is, zou de dominantie van big tech over AI wel eens van voorbijgaande aard kunnen zijn.

Het Meta LLaMA-lek

Het LLaMA-model van Meta, een groot taalmodel (LLM) zoals ChatGPT, was uitgelekt op 4chan een week nadat het bedrijf toegangsverzoeken had verstuurd. Op 3 maart verscheen er een downloadbare torrent op het berichtenforum die zich als een lopend vuurtje verspreidde.

Zoals Sernau aangeeft, ging de open-source gemeenschap verder met het aanpassen van LLaMA, waarbij indrukwekkende functionaliteit werd toegevoegd zonder de computermiddelen van de onderneming.

Het bouwen van krachtige AI-modellen is goedkoper dan ooit en open-source gemeenschappen proberen de toegang te democratiseren. Terwijl LLaMA een grotendeels voorgetraind model is, zijn andere open-source modellen, zoals BLOOM, getraind door vrijwilligers.

Voor het trainen van BLOOM was een supercomputer met 384 NVIDIA A100 80GB GPU's nodig, die gelukkig werd gedoneerd door de Franse overheid. Het open-source AI-bedrijf Together kondigde onlangs $20m seed funding aan, en AI-gerichte cloudproviders zoals CoreWeave bieden hardware onder de marktprijs.

Open-source projecten hebben verschillende middelen om middelen te concentreren en de grote technologie te overvleugelen. Big tech wil ons waarschijnlijk doen geloven dat hun AI's het product zijn van tientallen jaren werk en miljarden dollars aan investeringen - De open-sourcegemeenschap is het hier waarschijnlijk niet mee eens.

Tijdens een evenement in India vroeg voormalig Google-bestuurder Rajan Anandan aan OpenAI CEO Sam Altman of Indiase technici fundamentele AI-modellen konden bouwen met een investering van $10m.

Altman antwoordde: "Het is totaal hopeloos om met ons te concurreren op het gebied van training van foundationmodellen. Je moet het niet proberen en het is je taak om het toch te proberen. En ik geloof in allebei die dingen. Ik denk dat het vrij hopeloos is."

Maar in zijn memo geeft Sernau aan dat open source nu al concurreert met big tech. Hij zegt: "Een concurrentievoordeel behouden in technologie wordt nog moeilijker nu geavanceerd onderzoek in LLM's betaalbaar is. Onderzoeksinstellingen over de hele wereld bouwen voort op elkaars werk en verkennen de oplossingsruimte op een manier die onze eigen capaciteit ver te boven gaat."

Open-source ontwikkelaars bouwen alternatieven voor de AI's van big tech en halen ze in op het gebied van prestaties en gebruikersstatistieken.

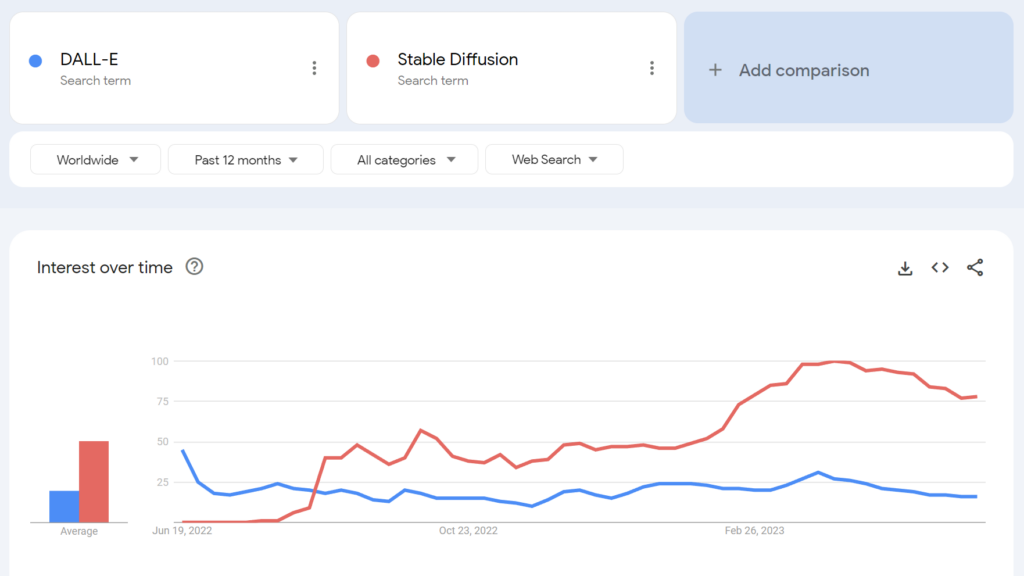

Zo werd het open-source Stable Diffusion binnen enkele maanden na de lancering populairder dan OpenAI's DALL-E.

In hoeverre kunnen we hier potentiële bijbedoelingen uitpluizen? Heeft de push van big tech op het gebied van regelgeving enige altruïstische verdienste?

De open-source AI-gemeenschap

Naast LLaMA zijn er minstens drie grote voorbeelden van open-source AI-projecten:

- Knuffelgezicht & BLOOM - Het AI-bedrijf Hugging Face werkte samen met meer dan 1000 vrijwillige wetenschappers aan de ontwikkeling van BLOOM, een open-source LLM. BLOOM wil een transparantere en toegankelijkere tegenhanger bieden voor propriëtaire AI-modellen.

- Samen - Een AI startup met de naam Together heeft met succes $20 miljoen aan startkapitaal opgehaald om zijn doelstelling om gedecentraliseerde alternatieven voor gesloten AI-systemen te bouwen, te ondersteunen. Ze hebben verschillende open-source generatieve AI-initiatieven onthuld, waaronder GPT-JT, OpenChatKit en RedPajama.

- Stabiliteit AI - In april 2023 lanceerde Stability AI, het bedrijf achter Stable Diffusion, StableLM, een reeks open-source alternatieven voor ChatGPT.

Sommige van deze ontwikkelaars (zoals Stable Diffusion) bieden hun modellen aan via intuïtieve, eenvoudig te gebruiken dashboards, terwijl andere, zoals BLOOM, aanzienlijke resources vereisen om te kunnen draaien. Om te beginnen heeft u ongeveer 360 GB RAM nodig om BLOOM te draaien, maar er zijn veel handige trucs om de benodigde bronnen te verlagen.

Aangezien AI-geschikte hardware steeds goedkoper wordt en open-source modellen eenvoudiger in te zetten zijn, is het goed mogelijk dat vrijwel iedereen modellen zoals ChatGPT kan inzetten. In de gelekte Google-memo worden voorbeelden genoemd van mensen die LLaMA afstemmen en implementeren op consumentenapparaten, waaronder een MacBook.

Voor bedrijven met aanzienlijke IT-resources, Open-source modellen besparen geld en bieden datasoevereiniteit en controle over training en optimalisatie.

Niet iedereen is echter optimistisch over de impact van krachtige open-source AI. Onderzoeker op het gebied van cyberbeveiliging Jeffrey Ladis tweette bijvoorbeeld: "Bereid je voor op heel veel gepersonaliseerde spam en phishingpogingen" en "Het open sourcen van deze modellen was een verschrikkelijk idee".

AI-proliferatie maakt ons allemaal minder veilig. Lijkt me goed om te voorkomen, en ook een behoorlijk moeilijke uitdaging!

Het zou me niet verbazen als een staatsagent er in het komende jaar of de komende twee jaar in slaagt om de grensmodellen van OpenAI te bemachtigen. https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 mei 2023

Een andere waarnemer tweette: "Open source is een bedreiging, maar niet zoals jij denkt. Het is een bedreiging omdat AI in de handen van mensen die het voor hun eigen doeleinden kunnen gebruiken nog moeilijker te reguleren of bij te houden wordt, en dat is een groter probleem."

Google en OpenAI beweren dat ze bang zijn voor open source AI, er is "geen slotgracht" tussen hen. Maar dat is niet echt waar.

Open source is een bedreiging, maar niet zoals jij denkt. Het is een bedreiging omdat AI in de handen van mensen die het voor hun eigen doeleinden kunnen gebruiken nog moeilijker te... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 mei 2023

Yann LeCun, vaak beschouwd als een 'AI-godfather' naast Geoffrey Hinton en Yoshio Bengman, beweert het tegendeel"Zodra LLM's het belangrijkste kanaal worden waarlangs iedereen toegang heeft tot informatie, zullen mensen (en overheden) *eisen* dat het open en transparant is. De basisinfrastructuur moet open zijn."

LeCun was het ook niet eens met de gangbare verhalen over AI-risico's: "Ik denk dat de omvang van het AI-afstemmingsprobleem belachelijk is overschat en dat ons vermogen om het op te lossen op grote schaal wordt onderschat." Elon Musk sloeg terug in de Twitter thread door te zeggen: "Denk je echt dat AI een enkelzijdig zwaard is?".

Denk je echt dat AI een tweesnijdend zwaard is?

- Elon Musk (@elonmusk) 1 april 2023

Andere respondenten trokken parallellen tussen AI-regelgeving en cryptografie, waarbij de Amerikaanse overheid probeerde openbare cryptografische methoden te verbieden door ze classificeren als "munitie - de "Crypto-oorlogen" genoemd.

Nu heeft vrijwel iedereen het recht om encryptie te gebruiken - maar die strijd was zwaar bevochten - net als het geval zou kunnen zijn met open-source AI.

OpenAI's vervreemding van open-source AI

Open source is meer dan alleen software, code en technologie. Het is het principe, de denkwijze of de overtuiging dat een coöperatieve, open en transparante werkomgeving de concurrentie in een gesloten markt overtreft.

OpenAI, ooit een non-profit bedrijf gericht op publieke samenwerking en open-source ontwikkeling, is gestaag afgeweken van zijn naamgenoot.

De startup ging in 2019 over naar een 'for-profit' bedrijf, waarmee de relatie van het bedrijf met de open source-gemeenschap effectief eindigde. De investering van Microsoft heeft OpenAI losgekoppeld van elke vorm van 'open' R&D-activiteiten.

Medio mei kondigde het bedrijf een open-source model in de pijplijnmaar ze zijn niet openhartig geweest met de details.

Nu dringt OpenAI aan op regelgeving die opkomende AI-bedrijven het hardst zou treffen, om nog maar te zwijgen over het mogelijk criminaliseren van de open source-gemeenschap.

Dit heeft ertoe geleid dat sommigen het streven van OpenAI naar regulering bekritiseren als niets meer dan zakendoen - het beschermen van hun winstgevende modellen tegen open-source gemeenschappen die AI willen democratiseren.

Is open-source AI een risico voor big tech?

De combinatie van de uitgelekte memo van Google, de push van big tech voor regulering en Altmans denigrerende opmerkingen over AI-projecten aan de basis doen de wenkbrauwen fronsen. De legitimiteit van de risico's van AI - die regulering rechtvaardigen - is namelijk in twijfel getrokken.

Toen het Center for AI Safety (CAIS) bijvoorbeeld zijn seismische verklaring over AI-risico's publiceerde, mede ondertekend door meerdere AI CEO's, waren sommige externe waarnemers niet overtuigd.

In een selectie van reacties van experts op de verklaring gepubliceerd door het Science Media Centrezegt Dr. Mhairi Aitken, Ethics Research Fellow aan het Alan Turing Institute:

"De laatste tijd komen deze beweringen steeds vaker van grote techspelers, voornamelijk uit Silicon Valley. Hoewel sommigen suggereren dat dit komt doordat ze zich bewust zijn van de vooruitgang in de technologie, denk ik dat het eigenlijk dient als afleidingstechniek. Het leidt de aandacht af van de beslissingen van big tech (mensen en organisaties) die AI ontwikkelen en innovatie op dit gebied stimuleren, en richt in plaats daarvan de aandacht op hypothetische toekomstscenario's en ingebeelde toekomstige capaciteiten van AI."

Sommigen beweren dat big tech de vuurkracht heeft om middelen te wijden aan ethiek, bestuur en toezicht, waardoor ze de ergste regelgeving van zich af kunnen schudden en hun producten kunnen blijven verkopen.

Het is echter tegelijkertijd problematisch om AI-risico's af te doen als fantasie en te beweren dat regulering geen waarde heeft.

Er zijn sceptici in beide kampen

De risico's van AI afdoen als puur speculatief zou wel eens een kritieke fout voor de mensheid kunnen blijken te zijn.

Inderdaad, commentatoren zonder belangenverstrengeling waarschuwen al tientallen jaren voor AI, waaronder wijlen professor Stephen Hawking, die zei dat AI "het einde van het menselijk ras zou kunnen betekenen" en de "ergste gebeurtenis in de geschiedenis van onze beschaving" zou kunnen zijn.

Hoewel sommigen misschien beweren dat big tech visioenen van een AI-apocalyps gebruikt om marktstructuren te versterken en toegangsbarrières op te werpen, doet dat niets af aan de legitimiteit van AI-risico's.

AI-onderzoeksteams hebben bijvoorbeeld al bewezen dat AI in staat is om autonoom doelen stellen met mogelijk desastreuze gevolgen.

Andere experimenten laten zien dat AI's actief bronnen kunnen verzamelen, macht kunnen vergaren en proactieve stappen kunnen nemen om te voorkomen dat ze worden 'uitgeschakeld'. Geloofwaardige studies suggereren dat in ieder geval sommige AI-risico's niet overdreven zijn.

Verenigbare standpunten?

De vraag is of we onszelf kunnen vertrouwen met uitzonderlijk krachtige AI. Onszelf' zijn mensen overal, op elk niveau, van grote technische onderzoekslaboratoria tot de gemeenschappen die open-source AI bouwen.

Big tech wil misschien marktstructuren consolideren en tegelijkertijd oprechte bezorgdheid over de toekomst van AI voeden. Deze twee sluiten elkaar niet noodzakelijkerwijs uit.

Ondertussen is de opkomst van open-source AI onvermijdelijk en regelgeving riskeert ontevredenheid onder een gemeenschap die eigenaar is van een van de gevaarlijkste technologieën van de mensheid.

Het is al te laat om open-source AI te onderwerpen door middel van regelgeving en pogingen om dat te doen zouden kunnen leiden tot een destructief tijdperk van AI-verbod.

Tegelijkertijd moeten discussies over de gevaren van AI worden gedreven door het bewijs - het enige objectieve signaal dat we hebben over de potentiële schade van de technologie.