De race om krachtigere en efficiëntere AI-hardware ging deze week verder toen Intel en Google nieuwe chips aankondigden om minder afhankelijk te worden van NVIDIA-technologie.

Het lijkt wel of er elke week nieuwe AI-modellen worden uitgebracht. Achter elke release gaan weken van training op cloud computing datacenters schuil, waarvan de meeste worden aangedreven door NVIDIA GPU's.

Intel en Google hebben beide nieuwe eigen AI-chips aangekondigd die grote AI-modellen sneller kunnen trainen en inzetten terwijl ze minder stroom gebruiken.

Intel's Gaudi 3 AI-acceleratorchip

Intel staat waarschijnlijk beter bekend om de chips die je pc van stroom voorzien, maar dinsdag heeft het bedrijf aangekondigd zijn nieuwe AI-chip genaamd Gaudi 3.

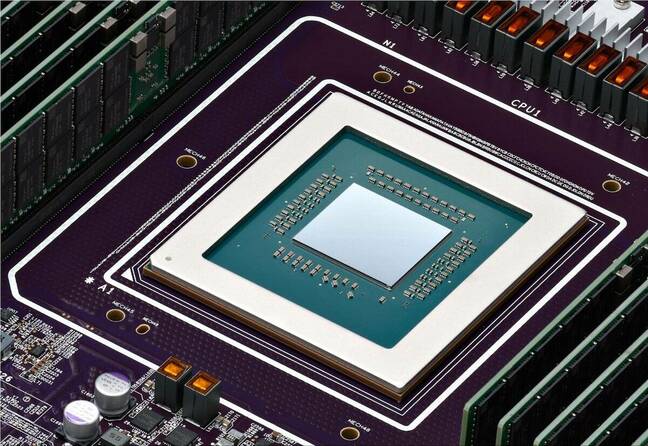

NVIDIA's H100 GPU's hebben het grootste deel van AI-datacenters gevormd, maar Intel zegt dat Gaudi 3 "gemiddeld 50% betere inferentie en gemiddeld 40% betere energie-efficiëntie levert dan Nvidia H100 - tegen een fractie van de kosten."

Een grote bijdrage aan de energiezuinigheid van Gaudi 3 is dat Intel het 5 nm-proces van Taiwan Semiconductor Manufacturing Co heeft gebruikt om de chips te maken.

Intel gaf geen prijsinformatie, maar op de vraag hoe het zich verhoudt tot de producten van NVIDIA zei Das Kamhout, VP Xeon software bij Intel: "We verwachten dat het zeer concurrerend zal zijn."

Dell Technologies, Hewlett Packard Enterprise, Lenovo en Supermicro zullen als eerste Gaudi 3 inzetten in hun AI-datacenters.

Intel CEO Pat Gelsinger vatte de AI-ambities van het bedrijf als volgt samen: "Intel brengt AI overal in de onderneming, van de pc tot het datacenter tot de rand."

De #IntelGaudi 3 #AI versneller biedt een zeer concurrerend alternatief voor NVIDIA's H100 met hogere prestaties, grotere schaalbaarheid en PyTorch-integratie. Ontdek meer belangrijke productvoordelen. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9 april 2024

Google's Arm en TPU-upgrades

Op dinsdag kondigde Google zijn eerste aangepaste Op Arm gebaseerde CPU's die het wil gebruiken om zijn datacenters van energie te voorzien. De nieuwe chip, Axion genaamd, is een directe concurrent voor de CPU's van Intel en AMD.

Google beweert dat Axion "30% betere prestaties levert dan de snelste algemene Arm-gebaseerde instances die vandaag beschikbaar zijn in de cloud, tot 50% betere prestaties en tot 60% betere energie-efficiëntie dan vergelijkbare huidige generatie x86-gebaseerde instances."

Google heeft verschillende van zijn diensten, zoals YouTube en Google Earth, verplaatst naar zijn huidige generatie Arm-gebaseerde servers die binnenkort worden geüpgraded met de Axion-chips.

Een krachtige Arm-gebaseerde optie maakt het makkelijker voor klanten om hun CPU-gebaseerde AI-training, inferencing en andere toepassingen te migreren naar Google's cloudplatform zonder ze opnieuw te hoeven ontwerpen.

Voor grootschalige modeltraining heeft Google grotendeels vertrouwd op zijn TPU-chips als alternatief voor de hardware van NVIDIA. Deze zullen ook worden geüpgraded met één nieuwe TPU v5p die nu meer dan het dubbele aantal chips bevat van de huidige TPU v4 pod.

TPU v5p, onze krachtigste en meest schaalbare TPU, is nu algemeen verkrijgbaar! #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google cloudtechnologie (@GoogleCloudTech) 9 april 2024

Google is er niet op uit om zijn nieuwe Arm-chips of TPU's te verkopen. Het bedrijf wil zijn cloudcomputingdiensten stimuleren in plaats van een directe hardwareconcurrent van NVIDIA te worden.

De verbeterde TPU's zullen een boost geven aan Google's AI Hypercomputer die grootschalige AI-model training mogelijk maakt. De AI Hypercomputer maakt ook gebruik van NVIDIA H100 GPU's die volgens Google binnenkort worden vervangen door NVIDIA's nieuwe Blackwell GPU's.

De vraag naar AI-chips zal waarschijnlijk niet snel afnemen en het ziet er minder naar uit dat NVIDIA een eenpaardrace is dan voorheen.