Onderzoekers publiceerden een studie waarin de nauwkeurigheid en kwaliteit van samenvattingen die LLM's produceren werden vergeleken. Claude 3 Opus presteerde bijzonder goed, maar mensen hebben nog steeds een streepje voor.

AI-modellen zijn erg handig voor het samenvatten van lange documenten als je geen tijd of zin hebt om ze te lezen.

De luxe van groeiende contextvensters betekent dat we modellen kunnen vragen om langere documenten, wat hun vermogen om altijd de feiten op een rijtje te zetten in de samenvatting op de proef stelt.

De onderzoekers van de University of Massachusetts Amherst, Adobe, het Allen Institute for AI en Princeton University, een onderzoek gepubliceerd waarin werd onderzocht hoe goed AI-modellen zijn in het samenvatten van boeklengte (>100k tokens).

FABLES

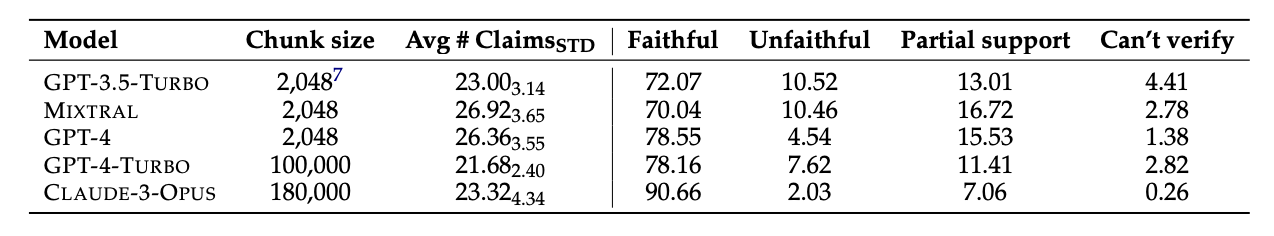

Ze selecteerden 26 boeken die in 2023 en 2024 werden gepubliceerd en lieten verschillende LLM's de teksten samenvatten. De recente publicatiedata werden gekozen om mogelijke datavervuiling in de oorspronkelijke trainingsgegevens van de modellen te voorkomen.

Nadat de modellen de samenvattingen hadden gemaakt, gebruikten ze GPT-4 om er decontextuele beweringen uit te halen. De onderzoekers huurden vervolgens menselijke annotators in die de boeken hadden gelezen en vroegen hen de beweringen op feiten te controleren.

De resulterende gegevens werden samengevoegd in een dataset genaamd "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES bevat 3.158 annotaties van trouw op claimniveau in 26 verhalende teksten.

De testresultaten toonden aan dat Claude 3 Opus "de meest waarheidsgetrouwe samenvatter van boeken met een aanzienlijke marge" was, met meer dan 90% van de beweringen geverifieerd als waarheidsgetrouw of accuraat.

GPT-4 kwam op een verre tweede plaats met slechts 78% van zijn beweringen geverifieerd als waarheidsgetrouw door de menselijke annotators.

Het moeilijke deel

De geteste modellen leken allemaal met dezelfde dingen te worstelen. De meeste feiten die de modellen fout hadden, hadden te maken met gebeurtenissen of toestanden van personages en relaties.

Het artikel merkte op dat "de meeste van deze beweringen alleen ongeldig kunnen worden gemaakt door multi-hop redeneren over het bewijs, wat de complexiteit van de taak benadrukt en het verschil met bestaande instellingen voor het verifiëren van feiten".

De LLM's lieten ook vaak belangrijke informatie weg in hun samenvattingen. Ze leggen ook te veel nadruk op inhoud aan het einde van boeken, waardoor ze belangrijke inhoud aan het begin over het hoofd zien.

Zal AI menselijke annotators vervangen?

Menselijke annotators of factcheckers zijn duur. De onderzoekers gaven $5.200 uit om de menselijke annotators de beweringen in de AI-samenvattingen te laten controleren.

Had een AI-model de klus voor minder kunnen klaren? Eenvoudig feiten ophalen is iets waar Claude 3 goed in is, maar de prestaties bij het verifiëren van beweringen die een dieper begrip van de inhoud vereisen zijn minder consistent.

Toen de geëxtraheerde beweringen werden gepresenteerd en gevraagd om ze te verifiëren, deden alle AI-modellen het minder goed dan menselijke annotators. Ze presteerden vooral slecht bij het identificeren van ontrouwe beweringen.

Hoewel Claude 3 Opus met enige afstand de beste claimverificateur was, concludeerden de onderzoekers dat het "uiteindelijk te slecht presteert om een betrouwbare autorater te zijn".

Als het aankomt op het begrijpen van de nuances, complexe menselijke relaties, plotpunten en motivaties van personages in een lang verhaal, lijkt het erop dat mensen voorlopig nog steeds een streepje voor hebben.