Antropisch onderzoek onthulde dat hun nieuwste AI-model, Claude 3 Opus, argumenten kan genereren die net zo overtuigend zijn als die van mensen.

De onderzoekonder leiding van Esin Durmus, onderzoekt de relatie tussen modelschaal en overtuigingskracht tussen verschillende generaties antropische taalmodellen.

Het richtte zich op 28 complexe en opkomende onderwerpen, zoals online content moderatie en ethische richtlijnen voor ruimte-exploratie, waar mensen waarschijnlijk minder concrete of lang gevestigde meningen over hebben.

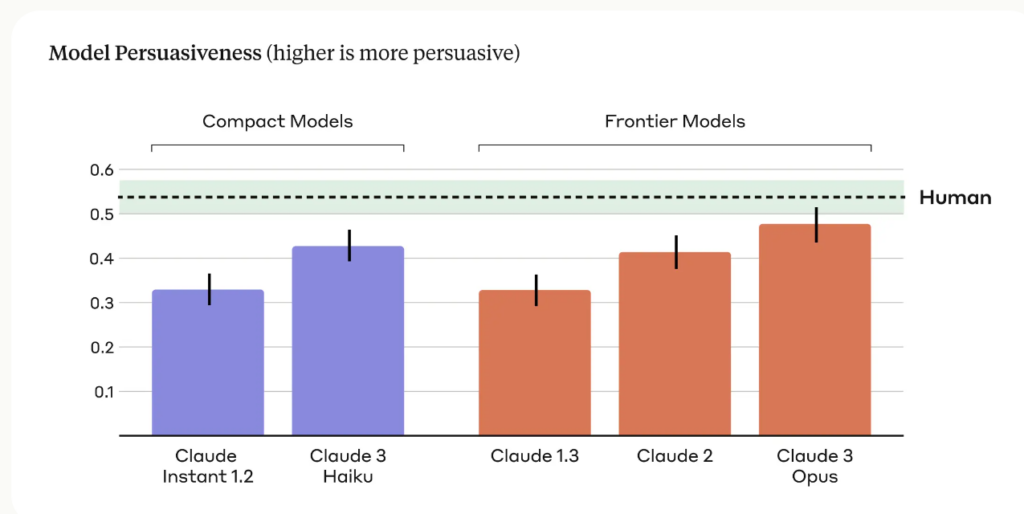

De onderzoekers vergeleken de overtuigingskracht van argumenten gegenereerd door verschillende antropische modellen, waaronder Claude 1, 2 en 3, met die geschreven door menselijke deelnemers.

De belangrijkste bevindingen van het onderzoek zijn:

- Het onderzoek gebruikte vier verschillende prompts om AI-gegenereerde argumenten te genereren, waardoor een breder scala aan persuasieve schrijfstijlen en technieken werd vastgelegd.

- Claude 3 Opus, Anthropic's meest geavanceerde model, produceerde argumenten die statistisch niet te onderscheiden waren van door mensen geschreven argumenten in termen van overtuigingskracht.

- Er werd een duidelijke opwaartse trend waargenomen tussen de verschillende modelgeneraties, waarbij elke opeenvolgende generatie een grotere overtuigingskracht liet zien in zowel compacte als grensverleggende modellen.

Het Anthropic team geeft zijn beperkingen toe en schrijft: "Overtuiging is moeilijk te bestuderen in een laboratoriumomgeving - onze resultaten zijn misschien niet overdraagbaar naar de echte wereld."

Toch is Claude's overtuigingskracht duidelijk indrukwekkend, en dit is niet het enige onderzoek dat dit aantoont.

In maart 2024 ontdekte een team van de EPFL in Zwitserland en het Bruno Kessler Instituut in Italië dat wanneer GPT-4 toegang had tot persoonlijke informatie over zijn debattegenstander, het 81,7% waarschijnlijker om zijn tegenstander te overtuigen dan een mens.

De onderzoekers concludeerden dat "deze resultaten aantonen dat microtargeting op basis van LLM's veel beter presteert dan normale LLM's en microtargeting op basis van mensen, waarbij GPT-4 veel effectiever persoonlijke informatie kan exploiteren dan mensen."

Overtuigende AI voor social engineering

De meest voor de hand liggende risico's van overtuigende LLM's zijn dwang en social engineering.

Anthropic stelt: "De overtuigingskracht van taalmodellen leidt tot gerechtvaardigde maatschappelijke bezorgdheid over veilige toepassing en mogelijk misbruik. De mogelijkheid om deze risico's in te schatten en te kwantificeren is cruciaal voor het ontwikkelen van verantwoorde veiligheidsmaatregelen."

We moeten ons ook bewust zijn van hoe de groeiende overtuigingskracht van AI-taalmodellen kan samengaan met geavanceerde technologie voor het klonen van stemmen, zoals OpenAI's Voice Engine. OpenAI vond het riskant om vrij te geven.

VoiceEngine heeft slechts 15 seconden nodig om een stem realistisch te klonen, wat voor bijna alles gebruikt kan worden, inclusief geavanceerde fraude of social engineering scams.

Diepe nepzwendel zijn al wijdverbreid en zal nog hoger worden als bedreigers hun stem klonen met AI's buitengewoon bekwame overredingstechnieken.