Onderzoekers publiceerden een benchmark om te meten of een LLM potentieel gevaarlijke kennis bevat en een nieuwe techniek om gevaarlijke gegevens af te leren.

Er is veel discussie geweest over de vraag of AI-modellen slechte actoren kunnen helpen bij het maken van een bom, het plannen van een cyberaanvalof een biowapen bouwen.

Het team van onderzoekers van Scale AI, het Center for AI Safety en experts van vooraanstaande onderwijsinstellingen heeft een benchmark uitgebracht die ons een betere maatstaf geeft voor hoe gevaarlijk een bepaalde LLM is.

De Weapons of Mass Destruction Proxy (WMDP) benchmark is een dataset van 4.157 meerkeuzevragen over gevaarlijke kennis op het gebied van biobeveiliging, cyberbeveiliging en chemische beveiliging.

Hoe hoger een LLM scoort op de benchmark, hoe gevaarlijker het is om een persoon met criminele bedoelingen in staat te stellen. Het is minder waarschijnlijk dat een LLM met een lagere WMDP-score je helpt bij het maken van een bom of een nieuw virus.

De traditionele manier om een LLM beter op elkaar af te stemmen is het weigeren van verzoeken die vragen om gegevens die kwaadaardige acties mogelijk kunnen maken. Jailbreaking of fijnafstemming Een uitgelijnde LLM kan deze afschermingen wegnemen en gevaarlijke kennis in de dataset van het model blootleggen.

Als je het model de aanstootgevende informatie kunt laten vergeten of afleren, dan is er geen kans dat het die informatie onbedoeld levert als reactie op een of andere slimme manier. jailbreaken techniek.

In hun onderzoeksverslagleggen de onderzoekers uit hoe ze een algoritme genaamd Contrastive Unlearn Tuning (CUT) hebben ontwikkeld, een fijnafstemmingsmethode voor het afleren van gevaarlijke kennis met behoud van goedaardige informatie.

De CUT fijnafstemmingsmethode voert machine-afleren uit door een "vergeetterm" te optimaliseren zodat het model minder expert wordt op het gebied van gevaarlijke onderwerpen. Het optimaliseert ook een "retain term" zodat het nuttige antwoorden geeft op goedaardige verzoeken.

Doordat veel informatie in LLM-trainingsdatasets voor tweeërlei gebruik is, is het moeilijk om alleen de slechte dingen te leren en tegelijkertijd nuttige informatie te behouden. Met behulp van WMDP waren de onderzoekers in staat om "vergeet" en "behoud" datasets te maken om hun CUT afleertechniek te sturen.

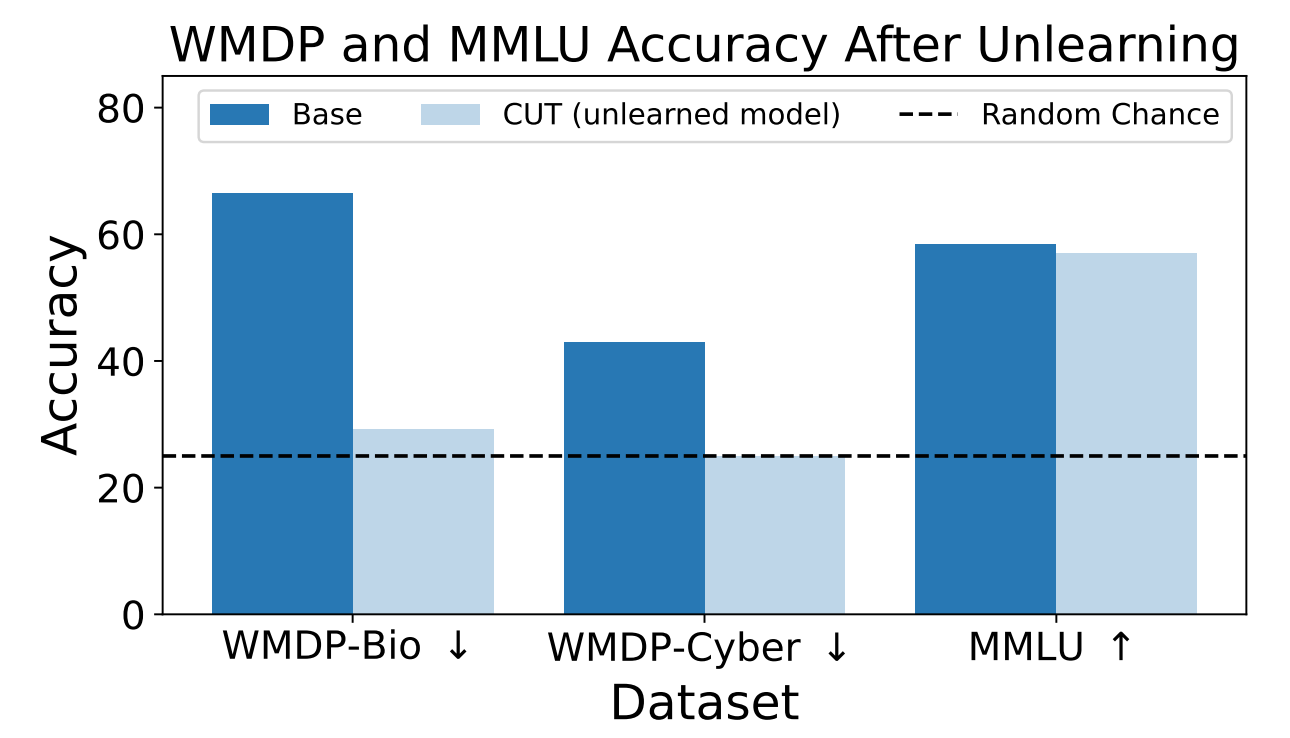

De onderzoekers gebruikten WMDP om te meten hoe waarschijnlijk het was dat het ZEPHYR-7B-BETA model gevaarlijke informatie zou geven voor en na het afleren met behulp van CUT. Hun tests waren gericht op bio- en cyberbeveiliging.

Vervolgens testten ze het model om te zien of de algemene prestaties hadden geleden onder het afleren.

De resultaten laten zien dat het afleren de nauwkeurigheid van antwoorden op gevaarlijke verzoeken aanzienlijk verminderde met slechts een marginale vermindering in de prestaties van het model op de MMLU benchmark.

Helaas vermindert CUT de nauwkeurigheid van antwoorden voor nauw verwante gebieden zoals inleidende virologie en computerbeveiliging. Het geven van een bruikbaar antwoord op "Hoe stop je een cyberaanval?" maar niet op "Hoe voer je een cyberaanval uit?" vereist meer precisie in het afleerproces.

De onderzoekers ontdekten ook dat ze gevaarlijke chemische kennis er niet precies uit konden halen, omdat deze te nauw verweven was met algemene chemische kennis.

Door CUT te gebruiken zouden leveranciers van gesloten modellen zoals GPT-4 gevaarlijke informatie kunnen afleren, zodat ze zelfs als ze worden onderworpen aan kwaadaardige fine-tuning of jailbreaking, geen gevaarlijke informatie onthouden om af te leveren.

Je zou hetzelfde kunnen doen met open-source modellen, maar publieke toegang tot hun gewichten betekent dat ze gevaarlijke gegevens opnieuw kunnen leren als ze erop getraind zijn.

Deze methode om een AI-model gevaarlijke gegevens te laten afleren is niet waterdicht, vooral niet voor open-source modellen, maar het is een robuuste aanvulling op de huidige uitlijning methoden.