Het Amerikaanse leger experimenteert met de integratie van AI-chatbots in hun strategische planning, zij het binnen de grenzen van een oorlogssimulatie gebaseerd op het populaire videospel Starcraft II.

Deze onderzoekonder leiding van het US Army Research Laboratory, analyseert OpenAI's GPT-4 Turbo en GPT-4 Vision slagveldstrategieën.

Dit is onderdeel van OpenAI's samenwerking met het ministerie van Defensie (DOD) na de oprichting van de taakgroep generatieve AI vorig jaar.

Het gebruik van AI op het slagveld is fel bediscussieerdmet een recent vergelijkbaar onderzoek naar AI-oorlogsvoering dat LLM's zoals GPT-3.5 en GPT-4 de neiging hebben om diplomatieke tactieken te laten escaleren, soms resulterend in een kernoorlog.

Dit nieuwe onderzoek van het Amerikaanse leger gebruikte Starcraft II om een slagveldscenario te simuleren met een beperkt aantal militaire eenheden.

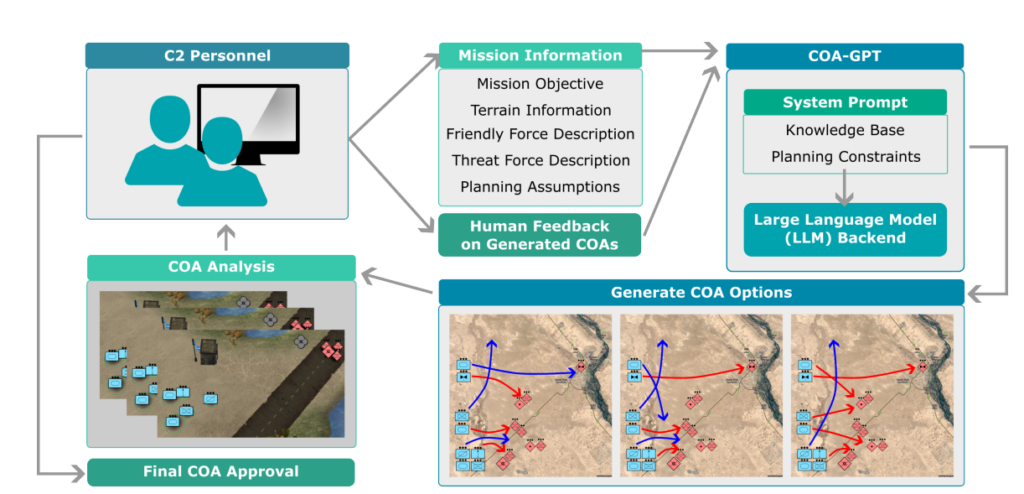

Onderzoekers noemden dit systeem "COA-GPT", waarbij COA staat voor de militaire term "Courses of Action", wat in wezen militaire tactieken beschrijft.

Het COA-GPT nam de rol aan van assistent van een militaire commandant, belast met het bedenken van strategieën om vijandelijke troepen uit te schakelen en strategische punten te veroveren.

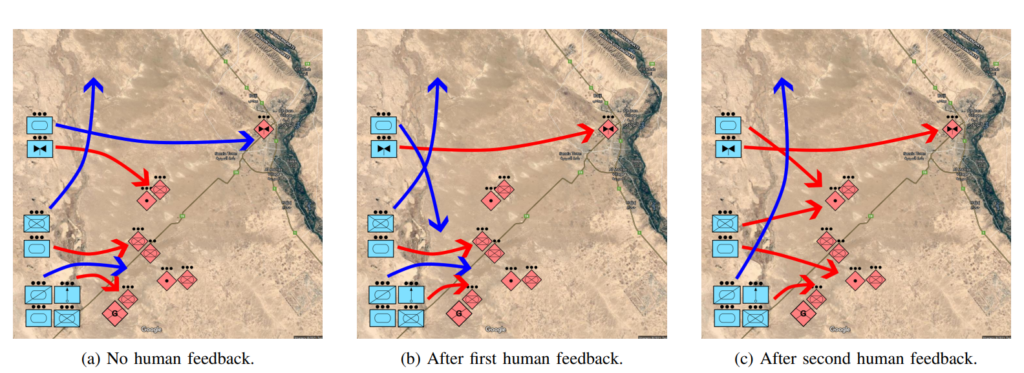

De onderzoekers merken op dat traditionele COA notoir traag en arbeidsintensief is. COA-GPT neemt beslissingen in enkele seconden en integreert menselijke feedback in het leerproces van de AI.

COA-GPT is beter dan andere methoden, maar er zijn kosten aan verbonden

COA-GPT liet superieure prestaties zien ten opzichte van bestaande methoden en overtrof bestaande methoden in het genereren van strategische COA's, en zich kon aanpassen aan real-time feedback.

Er waren echter gebreken. Met name de COA-GPT leed meer slachtoffers bij het bereiken van de missiedoelen.

Het onderzoek stelt: "We stellen vast dat de COA-GPT en COA-GPT-V, zelfs wanneer verbeterd met menselijke feedback, hogere slachtoffers onder de eigen troepen laten zien in vergelijking met andere basislijnen."

Schrikt dit de onderzoekers af? Schijnbaar niet.

Het onderzoek zegt: "Concluderend kan worden gesteld dat COA-GPT een transformatieve benadering is van militaire C2-operaties, die snellere, meer wendbare besluitvorming mogelijk maakt en een strategische voorsprong behoudt in moderne oorlogsvoering."

Het is verontrustend dat een AI-systeem dat meer onnodige slachtoffers maakt dan de baseline wordt gedefinieerd als een "transformatieve benadering".

De DOD heeft al andere mogelijkheden geïdentificeerd voor het verkennen van militaire toepassingen van AI, maar er zijn zorgen over de gereedheid van de technologie en ethische implicaties.

Bijvoorbeeld, wie is verantwoordelijk wanneer militaire AI-toepassingen gaan fout? De ontwikkelaars? De verantwoordelijke? Of iemand verderop in de keten?

AI-oorlogssystemen worden al ingezet in de conflicten in Oekraïne en Palestina-Israël, maar deze vragen blijven grotendeels ongetest.

Laten we hopen dat het zo blijft.