Onderzoekers van de Universiteit van Surrey hebben een methode ontwikkeld om foto's van honden om te zetten in gedetailleerde 3D-modellen.

Het trainingsmateriaal? Geen echte honden, maar computergegenereerde beelden uit de virtuele wereld van het hitspel Grand Theft Auto V (GTA V).

Moira Shooter, een postdoctorale onderzoeksstudent betrokken bij het onderzoek, gedeeld door het onderzoekOns model werd getraind op CGI-honden, maar we konden het gebruiken om 3D-skeletmodellen te maken van foto's van echte dieren. Dat zou natuurbeschermers in staat kunnen stellen om gewonde wilde dieren te spotten, of kunstenaars kunnen helpen om realistischere dieren te creëren in het metaversum."

Tot nu toe worden bij methodes om AI te leren over 3D-structuren echte foto's gebruikt naast gegevens over de werkelijke 3D-posities van objecten, vaak verkregen met behulp van motion capture-technologie.

Als je deze technieken echter toepast op honden of andere dieren, zijn er vaak te veel bewegingen om te volgen en is het moeilijk om honden zich lang genoeg te laten gedragen.

Om hun hondendataset samen te stellen, pasten de onderzoekers de code van GTA V aan om de menselijke personages te vervangen door hondenavatars via een proces dat bekend staat als "modding".

Onderzoekers produceerden 118 video's die deze virtuele honden vastlegden in verschillende acties - zitten, lopen, blaffen en rennen - in verschillende omgevingsomstandigheden.

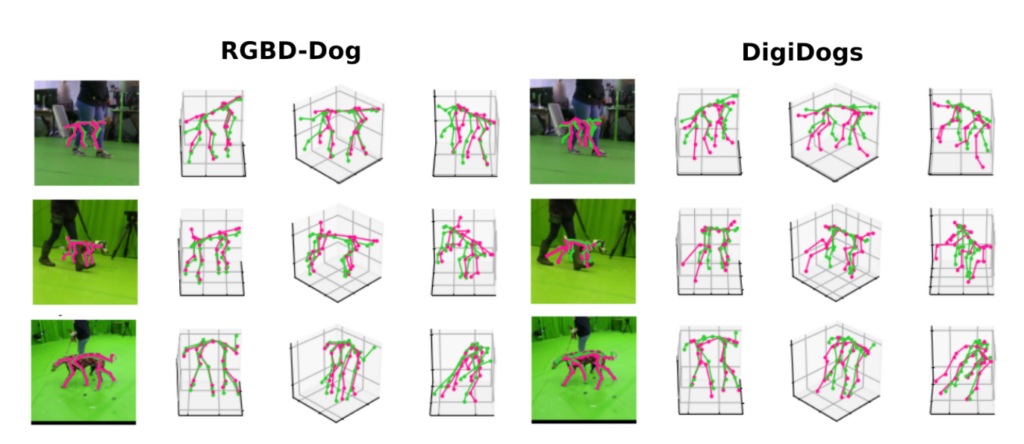

Dit culmineerde in de creatie van 'DigiDogs', een rijke database met 27.900 frames van hondenbewegingen, vastgelegd op een manier waarop het verzamelen van gegevens in de echte wereld niet mogelijk was.

Met de dataset in de hand werd in de volgende stappen het DINOv2 AI-model van Meta gebruikt vanwege zijn sterke generalisatievaardigheden. Dit model werd verfijnd met DigiDogs om nauwkeurig 3D-houdingen te voorspellen op basis van RGB-afbeeldingen met één weergave.

Onderzoekers toonden aan dat het gebruik van de DigiDogs dataset voor training resulteerde in accuratere en levensechtere 3D honden poses dan die getraind op echte datasets, dankzij de variatie in hondenverschijningen en acties die werden vastgelegd.

De verbeterde prestaties van het model werden bevestigd door grondige kwalitatieve en kwantitatieve evaluaties.

Hoewel dit onderzoek een grote stap voorwaarts betekent in het modelleren van 3D-dieren, erkent het team dat er nog meer werk te doen is, vooral in het verbeteren van de manier waarop het model het diepteaspect van de beelden (de z-coördinaat) voorspelt.

Shooter beschreef de potentiële impact van hun werk door te zeggen: "3D poses bevatten zoveel meer informatie dan 2D foto's. Van ecologie tot animatie. Van ecologie tot animatie, deze nette oplossing heeft zoveel mogelijke toepassingen."

De papier won de prijs voor de beste paper op de IEEE/CVF Winter Conference on Applications of Computer Vision.

Het opent de deur naar betere modelprestaties op gebieden zoals natuurbehoud en 3D-objectrendering voor VR.