Kunnen mensen leren om betrouwbaar door AI gegenereerde vervalsingen te detecteren? Hoe beïnvloeden ze ons op cognitief niveau?

OpenAI's Sora-systeem onlangs een voorproefje van een nieuwe golf van synthetische, door AI aangedreven media. Het zal waarschijnlijk niet lang duren voordat elke vorm van realistische media - audio, video of beeld - kan binnen enkele seconden worden gegenereerd met prompts.

Naarmate deze AI-systemen steeds capabeler worden, zullen we nieuwe vaardigheden in kritisch denken moeten aanscherpen om waarheid van fictie te kunnen scheiden.

Tot nu toe hebben de pogingen van Big Tech om deep fakes af te remmen of te stoppen weinig opgeleverd dan sentiment, niet vanwege een gebrek aan overtuiging, maar omdat AI-content zo realistisch is.

Dat maakt het moeilijk te detecteren op pixelniveauAndere signalen, zoals metadata en watermerken, hebben hun gebreken.

Zelfs als AI-gegenereerde inhoud op grote schaal zou kunnen worden gedetecteerd, is het een uitdaging om authentieke, doelgerichte inhoud te onderscheiden van inhoud die is bedoeld om verkeerde informatie te verspreiden.

Het doorgeven van inhoud aan menselijke beoordelaars en het gebruik van 'community notes' (informatie die aan inhoud wordt toegevoegd, vaak te zien op X) biedt een mogelijke oplossing. Soms gaat dit echter gepaard met subjectieve interpretatie en bestaat het risico op onjuiste etikettering.

Bijvoorbeeld in de Israël-Palestijns conflictWe zijn getuige geweest van verontrustende beelden die als echt werden bestempeld terwijl ze nep waren en omgekeerd.

Als een echte afbeelding als nep wordt bestempeld, kan dit een 'leugendividendwaar iemand of iets de waarheid als nep kan afdoen.

Dus wat kunnen we eraan doen als er aan de technologische kant geen technische methoden zijn om diepe vervalsingen te stoppen?

En, in hoeverre beïnvloeden diepe vervalsingen onze besluitvorming en psychologie?

Als mensen bijvoorbeeld worden blootgesteld aan valse politieke beelden, heeft dit dan een tastbare invloed op hun stemgedrag?

Laten we eens kijken naar een paar onderzoeken die precies dat beoordelen.

Hebben diepe vervalsingen invloed op onze meningen en psychologische toestand?

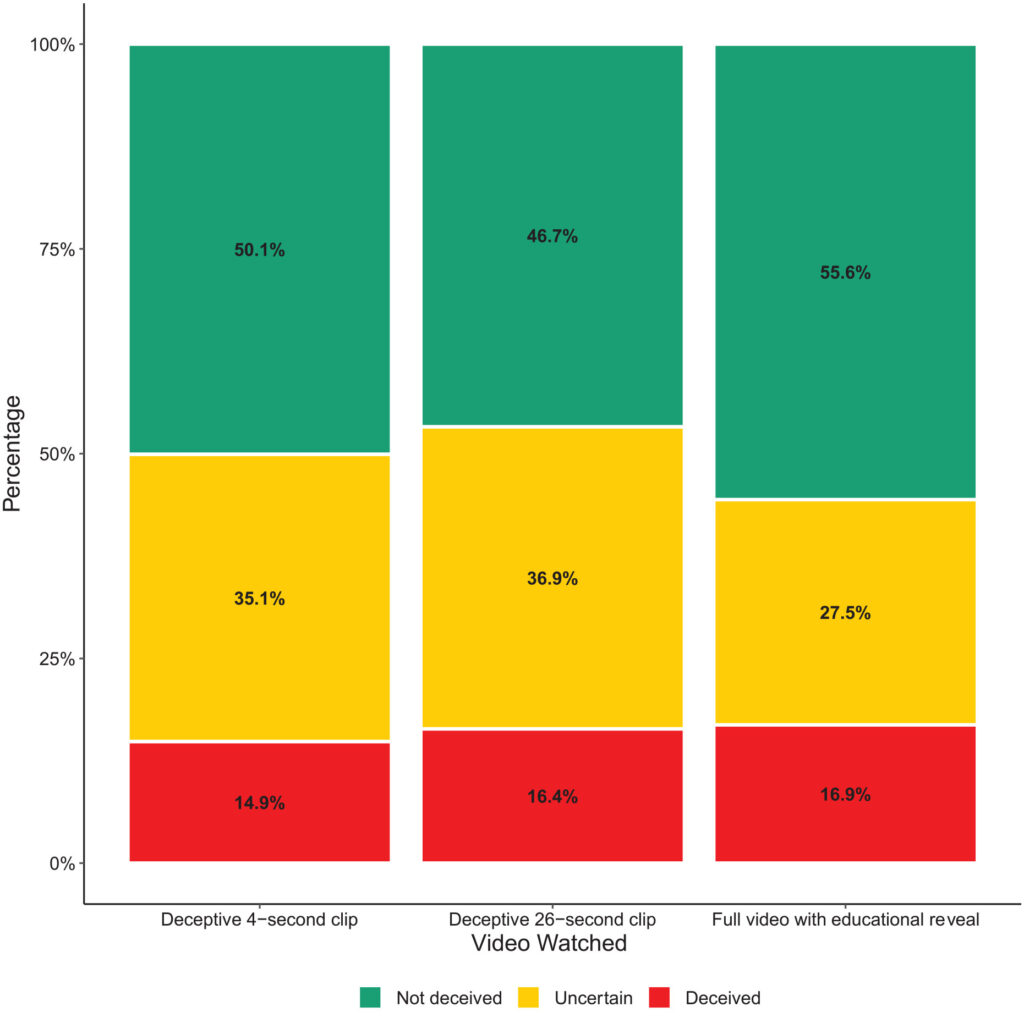

Een onderzoek uit 2020Deepfakes en desinformatie: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News" onderzocht hoe deep fake video's de publieke perceptie beïnvloeden, vooral wat betreft het vertrouwen in nieuws dat gedeeld wordt op sociale media.

Het onderzoek bestond uit een grootschalig experiment met 2.005 deelnemers uit het Verenigd Koninkrijk, ontworpen om reacties te meten op verschillende soorten deep fake video's van de voormalige Amerikaanse president Barack Obama.

Deelnemers werden willekeurig toegewezen om een van de drie video's te bekijken:

- Een clip van 4 seconden waarin Obama een verrassende uitspraak doet zonder enige context.

- Een clip van 26 seconden die enkele hints bevatte over de kunstmatige aard van de video, maar vooral misleidend was.

- Een volledige video met een "educatieve onthulling" waarin de kunstmatige aard van de deep fake expliciet werd onthuld, met Jordan Peele die de technologie achter de deep fake uitlegt.

Belangrijkste bevindingen

De studie onderzocht drie belangrijke gebieden:

- Misleiding: Het onderzoek vond minimale aanwijzingen dat deelnemers de valse beweringen in de diepe vervalsingen geloofden. Het percentage deelnemers dat misleid werd door de diepe vervalsingen was relatief laag in alle behandelingsgroepen.

- Onzekerheid: Een belangrijk resultaat was echter een grotere onzekerheid bij de kijkers, vooral bij degenen die de kortere, misleidende clips zagen. Ongeveer 35,1% van de deelnemers die de clip van 4 seconden zagen en 36,9% van de deelnemers die de clip van 26 seconden zagen, meldden dat ze zich onzeker voelden over de echtheid van de video. Daarentegen had slechts 27,5% van degenen die de volledige educatieve video bekeken dit gevoel.

- Vertrouwen in nieuws: Deze onzekerheid had een negatieve invloed op het vertrouwen van deelnemers in nieuws op sociale media. Degenen die werden blootgesteld aan de misleidende deep fakes vertoonden een lager vertrouwensniveau dan degenen die de educatieve onthulling bekeken.

Hieruit blijkt dat blootstelling aan deep fake beelden onzekerheid op de langere termijn veroorzaakt.

Na verloop van tijd kan nepbeeldmateriaal het vertrouwen in alle informatie, inclusief de waarheid, verzwakken.

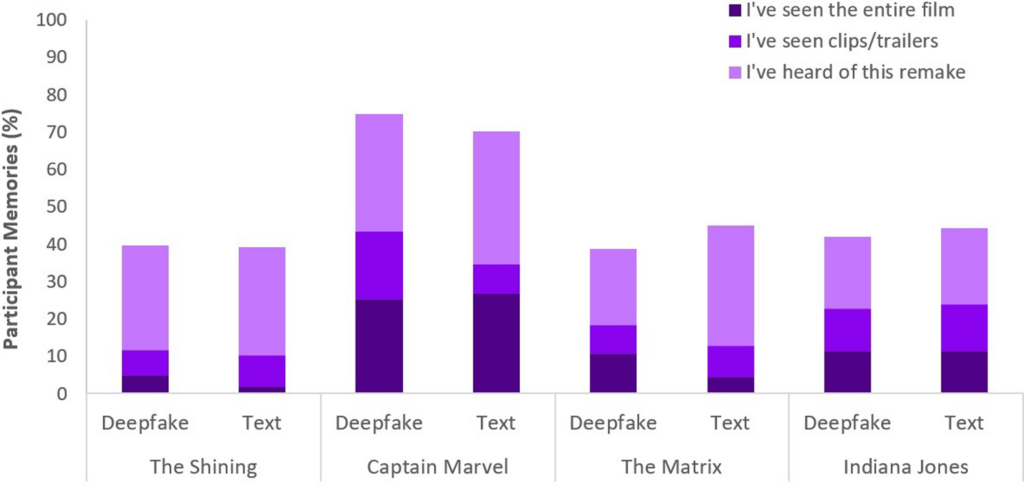

Vergelijkbare resultaten werden aangetoond door een recenter onderzoek 2023"Face/Off: Changing the face of movies with deepfake", waarin ook werd geconcludeerd dat nepbeelden langetermijneffecten hebben.

Mensen 'onthouden' nepcontent na blootstelling

Het Face/Off-onderzoek, uitgevoerd met 436 deelnemers, onderzocht hoe diepe vervalsingen onze herinnering aan films zouden kunnen beïnvloeden.

Deelnemers namen deel aan een online enquête om hun percepties en herinneringen aan zowel echte als denkbeeldige filmremakes te onderzoeken.

De kern van het onderzoek bestond uit het voorleggen van zes filmtitels aan de deelnemers, waaronder een mix van vier echte en twee fictieve remakes.

MDe films werden gerandomiseerd en in twee formaten gepresenteerd: De helft van de films werd geïntroduceerd door middel van korte tekstbeschrijvingen, en de andere helft werd gekoppeld aan korte videoclips.

Fictieve remakes van films bestonden uit versies van "The Shining", "The Matrix", "Indiana Jones" en "Captain Marvel", compleet met beschrijvingen waarin ten onrechte werd beweerd dat bekende acteurs betrokken waren bij deze niet-bestaande remakes.

Deelnemers kregen bijvoorbeeld te horen over een nepremake van "The Shining" met Brad Pitt en Angelina Jolie in de hoofdrollen, die nooit heeft plaatsgevonden.

De echte remakes van films die in het onderzoek werden gepresenteerd, zoals "Charlie & The Chocolate Factory" en "Total Recall", werden daarentegen nauwkeurig beschreven en gingen vergezeld van echte filmfragmenten. Deze mix van echte en neppe remakes was bedoeld om te onderzoeken hoe deelnemers onderscheid maken tussen feitelijke en verzonnen inhoud.

Deelnemers werden ondervraagd over hun bekendheid met elke film, met de vraag of ze de originele film of de remake hadden gezien of er enige voorkennis van hadden.

Belangrijkste bevindingen

- Vals geheugen fenomeen: Een belangrijk resultaat van het onderzoek is de onthulling dat bijna de helft van de deelnemers (49%) valse herinneringen ontwikkelde aan het kijken naar fictieve remakes, zoals het zich voorstellen van Will Smith als Neo in "The Matrix". Dit illustreert het blijvende effect dat suggestieve media, of het nu gaat om diepe nepvideo's of tekstuele beschrijvingen, kunnen hebben op ons geheugen.

- Specifiekstond "Captain Marvel" bovenaan de lijst, met 73% van de deelnemers die zich de AI-remake herinnerden, gevolgd door "Indiana Jones" met 43%, "The Matrix" met 42% en "The Shining" met 40%. Van degenen die ten onrechte in deze remakes geloofden, dacht 41% dat de remake van "Captain Marvel" superieur was aan het origineel.

- Vergelijkende invloed van diepe vervalsingen en tekst: Een andere ontdekking is dat diepe vervalsingen, ondanks hun visuele en auditieve realisme, niet effectiever waren in het veranderen van het geheugen van de deelnemers dan tekstuele beschrijvingen van dezelfde fictieve inhoud. Dit suggereert dat het formaat van de verkeerde informatie - visueel of tekstueel - de impact op geheugenvervorming binnen de context van film niet significant verandert.

Het fenomeen van valse herinneringen in dit onderzoek is uitgebreid onderzocht. Het laat zien hoe mensen effectief valse herinneringen construeren of reconstrueren waarvan we zeker weten dat ze echt zijn, terwijl dat niet zo is.

Iedereen is gevoelig voor het maken van valse herinneringen, en dNeppers lijken dit gedrag te activeren, wat betekent dat het bekijken van bepaalde inhoud onze perceptie kan veranderen, zelfs als we bewust begrijpen dat het niet authentiek is.

In beide onderzoeken hadden diepe vervalsingen tastbare, mogelijk langdurige gevolgen. Het effect kan ons besluipen en zich in de loop van de tijd opstapelen.

We moeten ook niet vergeten dat valse inhoud circuleert onder miljoenen mensen, dus kleine veranderingen in de perceptie kunnen zich verspreiden over de hele wereldbevolking.

Wat doen we tegen diepe vervalsingen?

Ten strijde trekken tegen diepe vervalsingen betekent vechten tegen het menselijk brein.

Terwijl de opkomst van nepnieuws en misinformatie mensen de afgelopen jaren heeft gedwongen om een nieuwe mediageletterdheid te ontwikkelen, zullen AI-gegenereerde synthetische media een nieuw niveau van aanpassing vereisen.

We hebben al eerder te maken gehad met dergelijke omslagpunten, van fotografie tot speciale CGI-effecten, maar AI zal een evolutie van onze kritische zintuigen vereisen.

Vandaag de dag moeten we verder gaan dan alleen onze ogen geloven en meer vertrouwen op het analyseren van bronnen en contextuele aanwijzingen.

Het is essentieel om de motieven of vooroordelen van de inhoud te onderzoeken. Komt het overeen met bekende feiten of spreekt het die juist tegen? Is er bevestigend bewijs uit andere betrouwbare bronnen?

Een ander belangrijk aspect is het vaststellen van wettelijke normen voor het identificeren van vervalste of gemanipuleerde media en het aansprakelijk stellen van de makers.

De US DEFIANCE-wet, UK Online Safety Act, en equivalenten wereldwijd zijn wettelijke procedures aan het opstellen voor het omgaan met deep fakes. Hoe effectief deze zullen zijn, valt nog te bezien.

Strategieën om de waarheid te onthullen

Laten we afsluiten met vijf strategieën voor het identificeren en ondervragen van potentiële diepe vervalsingen.

Hoewel geen enkele strategie foutloos is, is het stimuleren van een kritische houding het beste wat we gezamenlijk kunnen doen om de impact van AI-misinformatie te minimaliseren.

- Bronverificatie: Het onderzoeken van de geloofwaardigheid en herkomst van informatie is een fundamentele stap. Authentieke inhoud is vaak afkomstig van bronnen met een goede reputatie en betrouwbaarheid.

- Technische analyse: Ondanks hun raffinement kunnen diepe vervalsingen subtiele gebreken vertonen, zoals onregelmatige gezichtsuitdrukkingen of inconsistente belichting. Bestudeer de inhoud en kijk of deze digitaal is gewijzigd.

- Verwijzingen naar: Informatie verifiëren aan de hand van meerdere betrouwbare bronnen kan een breder perspectief bieden en de authenticiteit van inhoud helpen bevestigen.

- Digitale geletterdheid: Inzicht in de mogelijkheden en beperkingen van AI-technologieën is essentieel voor het beoordelen van inhoud. Onderwijs in digitale geletterdheid op scholen en in de media, met inbegrip van de werking van AI en de ethische implicaties ervan, zal van cruciaal belang zijn.

- Voorzichtige interactie: Interactie met door AI gegenereerde desinformatie versterkt de effecten ervan. Wees voorzichtig met het liken, delen of opnieuw plaatsen van inhoud waar je twijfels over hebt.

Naarmate 'deep fakes' zich verder ontwikkelen, zullen ook de technieken die nodig zijn om schade op te sporen en te beperken, zich verder ontwikkelen. 2024 zal veelzeggend zijn, omdat ongeveer de helft van de wereldbevolking dan gaat stemmen bij belangrijke verkiezingen.

Er zijn aanwijzingen dat diepe vervalsingen onze perceptie kunnen beïnvloeden, dus het is verre van vreemd om te denken dat AI-foute informatie de resultaten wezenlijk zou kunnen beïnvloeden.

Naarmate we verder gaan, zullen ethische AI-praktijken, digitale geletterdheid, regelgeving en kritische betrokkenheid van cruciaal belang zijn bij het vormgeven van een toekomst waarin technologie de essentie van de waarheid versterkt in plaats van verduistert.