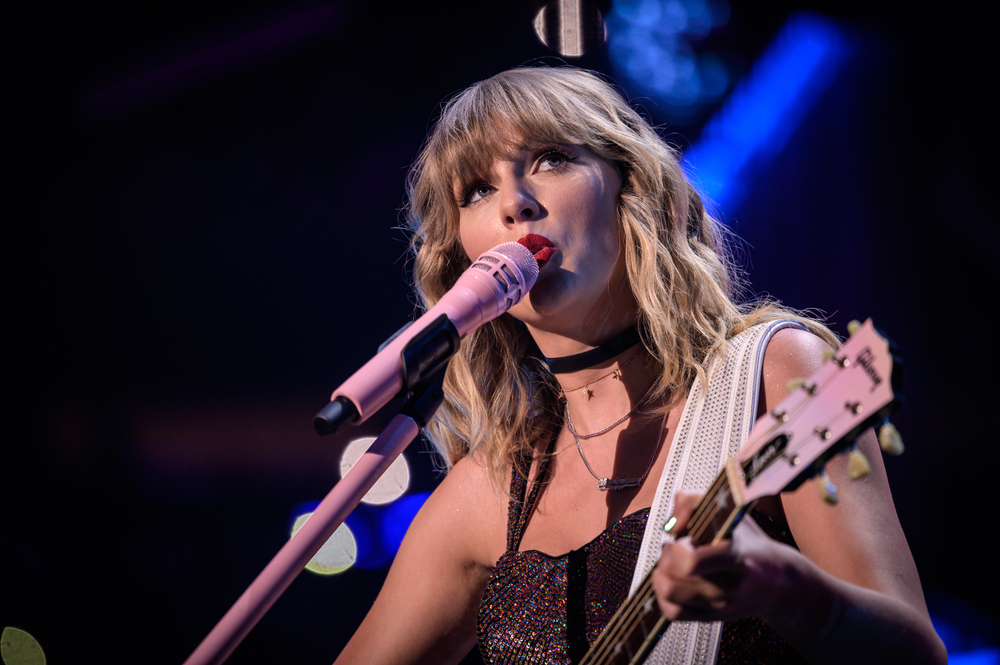

Expliciete, door AI gegenereerde deep fake-afbeeldingen van popster Taylor Swift circuleerden onlangs op sociale media, wat leidde tot wijdverspreide ophef.

Ondanks strenge regels tegen dergelijke inhoud, werd Swift op deze niet-consensuele foto's in seksueel expliciete posities afgebeeld. De foto's waren 19 uur lang live en vergaarden meer dan 27 miljoen views en 260.000 likes voordat het postaccount werd geschorst.

Het incident draagt bij aan een stortvloed van vragen over de effectiviteit van sociale-mediabeleid tegen diepe valse desinformatie.

Kan het worden gestopt? Schijnbaar niet. Dus hoe bestrijden we het? AI-detectieservices (vergelijkbaar met factcheckers) en 'Community Notes', die aan berichten op X worden toegevoegd, zijn twee mogelijke oplossingen, maar beide hebben hun gebreken.

De expliciete beelden van Taylor Swift circuleerden voornamelijk op het sociale mediaplatform X, maar vonden ook hun weg naar andere sociale mediaplatforms, waaronder Facebook, wat laat zien hoe controversiële AI-inhoud zich als een lopend vuurtje verspreidt.

Een woordvoerder van Meta reageerde op het incident en zei: "Deze inhoud is in strijd met ons beleid en we verwijderen het van onze platforms en ondernemen actie tegen de accounts die het hebben geplaatst. We blijven het controleren en als we nog meer schendende inhoud ontdekken, zullen we deze verwijderen en passende maatregelen nemen."

Miljoenen gebruikers gingen naar Reddit om de vertakkingen en gevolgen te bespreken van deze en andere recente virale deep fake-incidenten, waaronder een foto van de Eiffeltoren die in brand stond.

Er doet een TikTok-video de ronde, miljoenen keren bekeken, waarin wordt beweerd dat de Eiffeltoren in brand staat. De Eiffeltoren staat niet in brand. pic.twitter.com/IxlsKOqOsI

- Alistair Coleman (@alistaircoleman) 22 januari 2024

Hoewel velen deze beelden als overduidelijk nep zouden beschouwen, kunnen we niet aannemen dat het bredere publiek hiervan op de hoogte is.

Een commenter op Reddit zei over het Taylor Swift-incident: "Nu weet ik hoeveel mensen niet weten wat deepfakes zijn", wat duidt op een laag bewustzijn van het probleem.

Experts uit de industrie bespraken het probleem ook met ex-stability manager Ed Newton-Rex, die aanvoerde dat de 'gung-ho' houding van techbedrijven en de slechte betrokkenheid van besluitvormers bijdragen aan het probleem.

Expliciete, niet-consensuele AI deepfakes zijn het resultaat van een hele reeks tekortkomingen.

- De 'schip-zo-snel-mogelijk'-cultuur van generatieve AI, ongeacht de gevolgen

- Opzettelijke onwetendheid binnen AI-bedrijven over waar hun modellen voor worden gebruikt

- Een totale minachting voor vertrouwen en...- Ed Newton-Rex (@ednewtonrex) 26 januari 2024

Ben Decker van Memetica, een digitaal onderzoeksbureau, gaf commentaar op het gebrek aan controle over de gevolgen van AI: "Dit is een uitstekend voorbeeld van de manieren waarop AI wordt losgelaten voor een heleboel snode redenen zonder dat er genoeg vangrails zijn om het publieke plein te beschermen."

Hij wees ook op de tekortkomingen in de contentmonitoringstrategieën van sociale mediabedrijven.

Rapporten suggereren dat Taylor Swift nu juridische stappen overweegt tegen de diepe neppornosite die de beelden host.

Er zijn talloze vergelijkbare incidenten geweest van expliciete diepe vervalsingen, waarbij meestal vrouwen en kinderen betrokken waren, soms met de bedoeling om mensen om te kopenook wel "sexploitation" genoemd.

AI-beelden van seksueel misbruik van kinderen zijn het donkerste, meest verontrustende effect van technologie voor het genereren van beelden. Een Amerikaanse man werd onlangs veroordeeld tot 40 jaar in de gevangenis voor het bezit van dergelijke afbeeldingen.

In de nasleep van dit en andere soortgelijke incidenten is de roep om wetgeving om deze vorm van AI-misbruik aan te pakken toegenomen.

US Representative Joe Morelle beschreef de verspreiding van de Swift deepfakes als "verschrikkelijk" en pleitte voor dringende juridische stappen. Hij merkte op: "Wat er met Taylor Swift is gebeurd, is niets nieuws" en onderstreepte de onevenredige gevolgen van dergelijke inhoud voor vrouwen.

Diepe valse desinformatie werd ook uitgebreid besproken op het Wereld Economisch Forum in Davos met stijgende angst dat gemanipuleerde inhoud de aandelenmarkten, verkiezingen en de publieke opinie kan beïnvloeden.

Er wordt hard gewerkt aan de bestrijding van deep fakes, waarbij zowel startups als techgiganten detectietechnologieën ontwikkelen.

Intel heeft bijvoorbeeld een product gelanceerd dat nepvideo's kan detecteren met een nauwkeurigheid van 96%.

De uitdaging blijft voorlopig echter grotendeels onoverkomelijk, aangezien de technologie zich snel ontwikkelt en verspreidt over het internet.