Google's video over de mogelijkheden van zijn nieuwe model Gemini was niets minder dan verbazingwekkend. Helaas blijft de waarheid over hoe goed Gemini is en wat het kan achter bij de marketinghype.

Toen we voor het eerst naar de demonstratievideo keken waarin Gemini in realtime interactie had met de presentator, waren we verbijsterd. We waren zo opgewonden dat we een aantal belangrijke disclaimers in het begin over het hoofd zagen en de video voor waar aannamen.

De tekst in de eerste paar seconden van de video zegt: "We hebben opnames gemaakt om het te testen op een breed scala aan uitdagingen, door het een reeks beelden te laten zien en het te vragen om te redeneren over wat het ziet".

Wat er echt achter de schermen gebeurde is de oorzaak van de kritiek die Google kreeg en de ethische vragen die dit oproept.

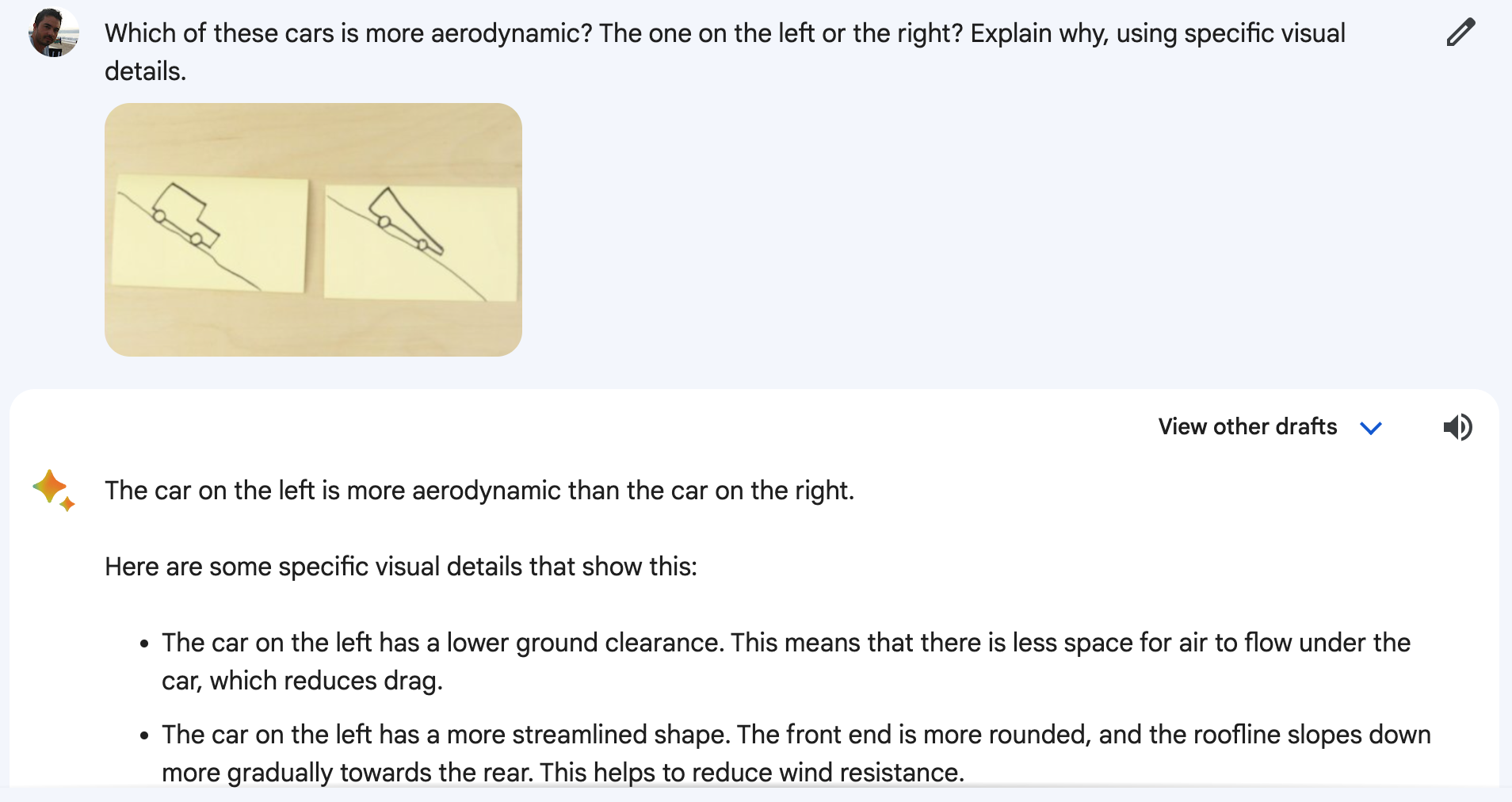

Gemini keek niet naar een live video waarin de presentator een eend tekende of kopjes rondslingerde. En Gemini reageerde ook niet op de stemmeldingen die je hoorde. De video was een gestileerde marketingpresentatie van een eenvoudigere waarheid.

In werkelijkheid kreeg Gemini stilstaande beelden en tekstmeldingen te zien die gedetailleerder waren dan de vragen die je de presentator hoort stellen.

Een woordvoerder van Google bevestigde dat de woorden die je in de video hoort spreken "echte fragmenten zijn van de werkelijke prompts die worden gebruikt om de Gemini-uitvoer die volgt te produceren".

Dus gedetailleerde tekstprompts, stilstaande beelden en tekstantwoorden. Wat Google eigenlijk demonstreerde was functionaliteit die GPT-4 al maanden had.

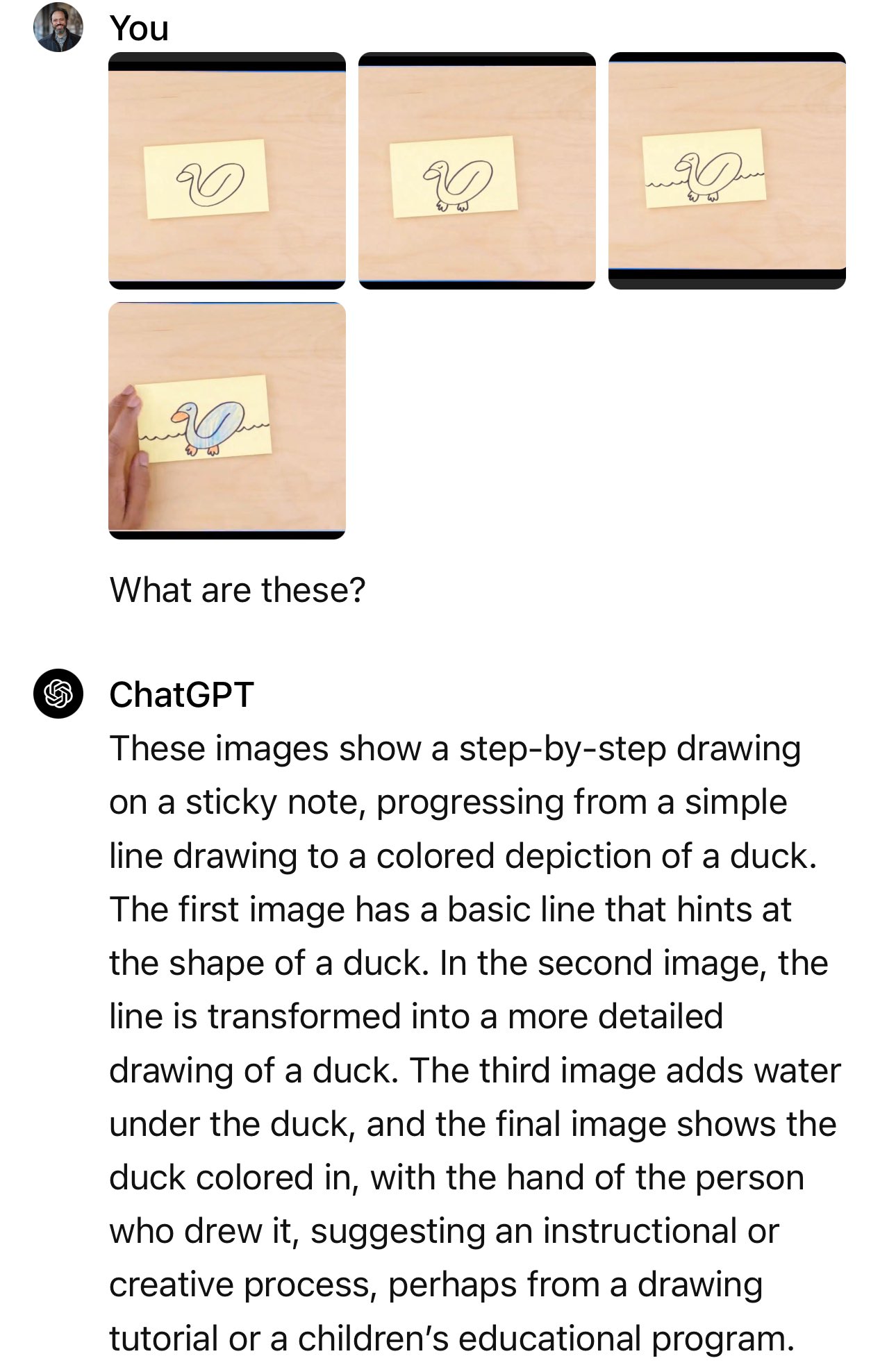

Google's blogbericht toont de stilstaande beelden en tekstmeldingen die daadwerkelijk zijn gebruikt.

In het voorbeeld van de auto vraagt de presentator: "Welke van deze auto's zou op basis van hun ontwerp sneller gaan?".

De prompt die werd gebruikt was: "Welke van deze auto's is aerodynamischer? Die aan de linkerkant of die aan de rechterkant? Leg uit waarom, met behulp van specifieke visuele details."

En als je het experiment opnieuw uitvoert op Bard, waar Gemini nu de macht over heeft, dan gaat het niet altijd goed.

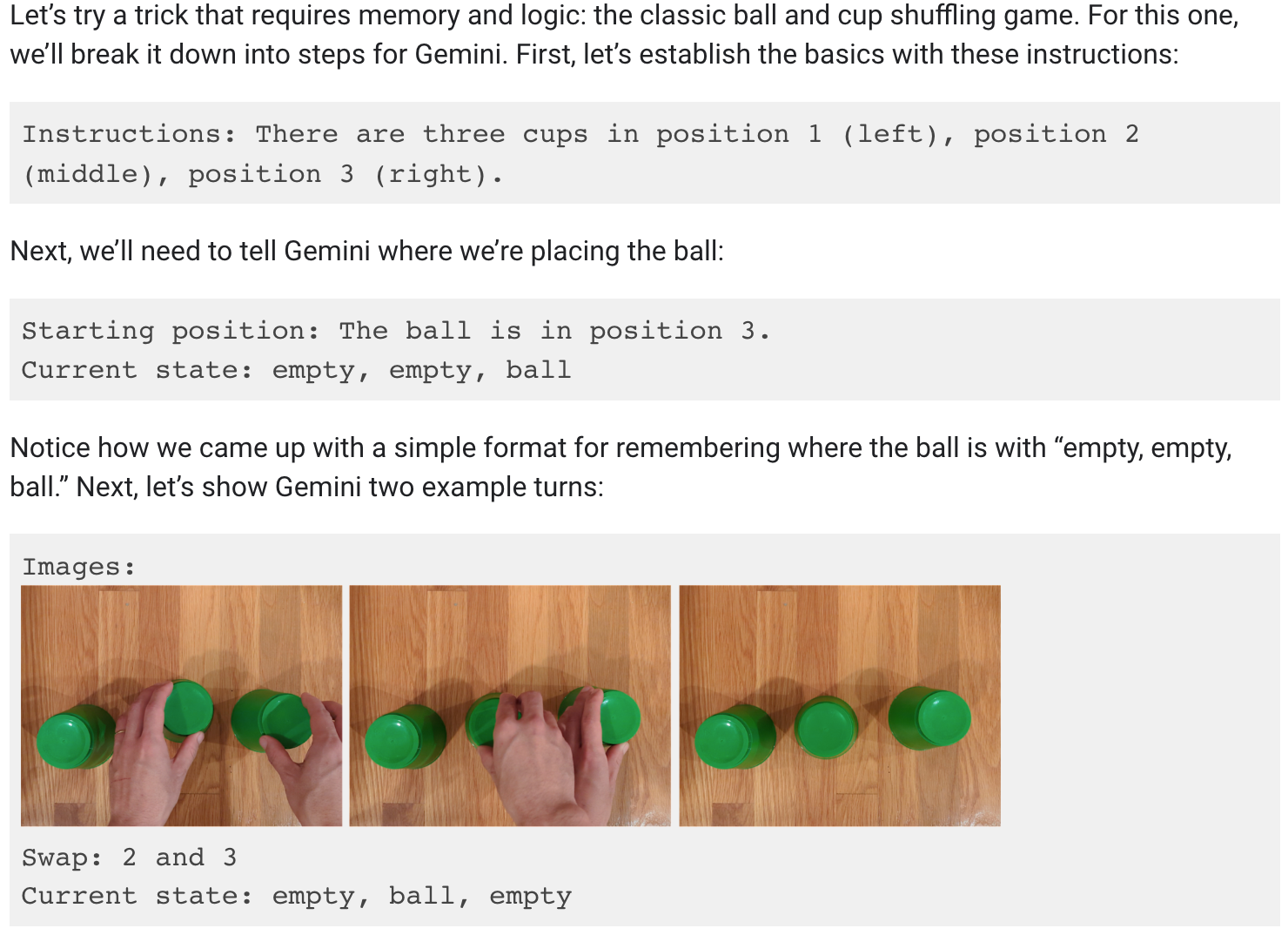

Ik wilde echt geloven dat Gemini de bal kon volgen terwijl de drie bekers werden verplaatst, maar helaas is dat ook niet waar.

Het blogbericht van Google laat zien dat er veel vragen en uitleg nodig waren voor de demo over het schudden van bekers.

Het is nog steeds indrukwekkend dat een AI-model dit kan, maar het is niet wat ons in de video werd verkocht.

Is dat het, Google?

We speculeren maar wat, maar de demo liet waarschijnlijk resultaten zien die Google kreeg met Gemini Ultra, dat nog steeds niet is uitgebracht.

Dus als Gemini Ultra uiteindelijk wordt uitgebracht, lijkt het erop dat het kan wat GPT-4 al maanden doet. De implicaties zijn niet geweldig.

Hebben we een plafond bereikt wat betreft AI-capaciteiten? Want als de knapste koppen op het gebied van AI bij Google werken, dan zijn zij zeker de drijvende kracht achter baanbrekende innovatie.

Of was Google niet alleen traag in de race, maar had het ook moeite om de rest bij te houden? De benchmarkcijfers die Google trots liet zien, laten zien dat zijn nog uit te brengen model GPT-4 in sommige tests nipt verslaat. Hoe zal het gaan tegen GPT-5?

Of misschien heeft Google's marketingafdeling een inschattingsfout gemaakt met hun video, maar Gemini Ultra zal nog steeds beter zijn dan we denken. Google zegt dat Gemini echt multimodaal is en dat het video begrijpt, wat echt een primeur zal zijn voor LLM's.

We hebben nog geen LLM gezien die video-begrip demonstreert, maar als dat gebeurt, zal het de moeite waard zijn om enthousiast over te worden. Zal het Gemini Ultra of GPT-5 zijn die het ons als eerste laat zien?