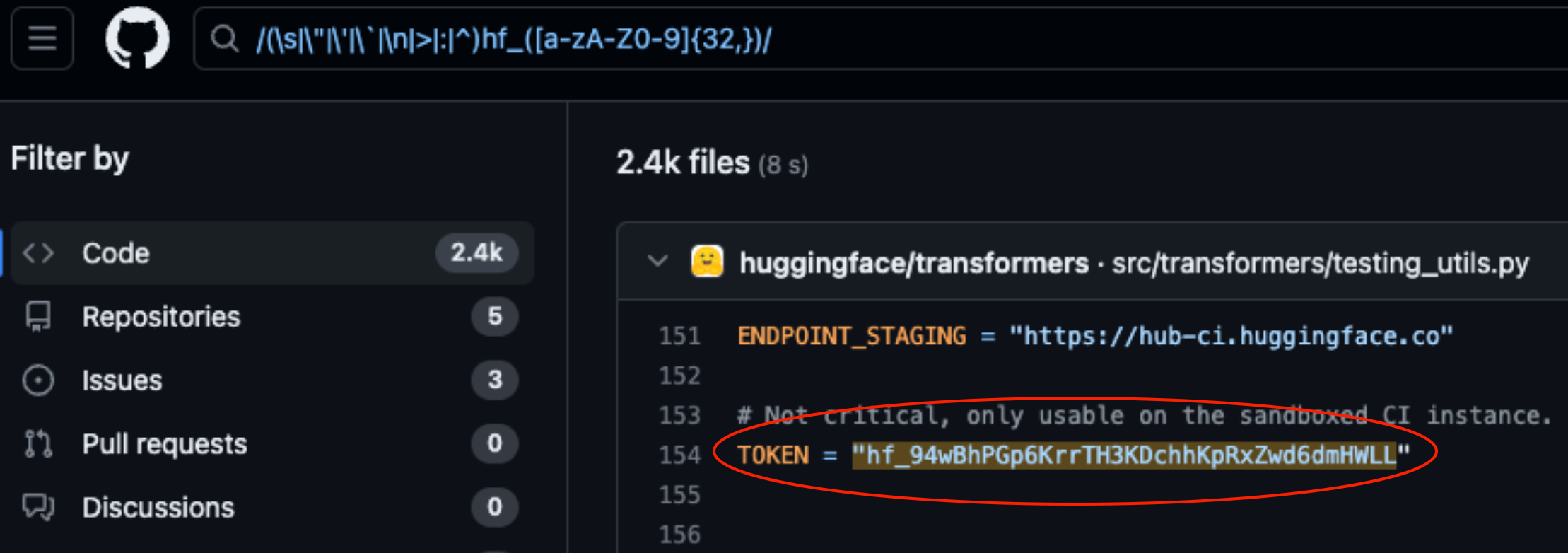

Lasso Security heeft beveiligingslekken blootgelegd op HuggingFace en GitHub na het vinden van 1681 blootgestelde API tokens die hard gecodeerd zijn in code die is opgeslagen op de platformen.

HuggingFace en GitHub zijn twee van de populairste repositories waar ontwikkelaars toegang kunnen geven tot hun AI-modellen en code. Zie deze als mappen in de cloud die worden beheerd door de organisaties die er eigenaar van zijn.

HuggingFace en GitHub maken het eenvoudig voor gebruikers om via API's te communiceren met honderdduizenden AI-modellen en datasets. Het stelt organisaties die eigenaar zijn van de modellen en datasets ook in staat om de API-toegang te gebruiken om repositories of bestanden te lezen, creëren, wijzigen en verwijderen.

De rechten die aan je API token zijn gekoppeld, bepalen het toegangsniveau dat je hebt. Lasso gevonden dat ze met wat graafwerk veel tokens konden vinden in code die was opgeslagen in repositories op de platformen.

Van de 1681 geldige tokens die ze vonden, hadden 655 tokens van gebruikers schrijfrechten, waarvan 77 met volledige accountrechten.

Waarom is dit zo belangrijk?

Zie een API token als een sleutel van je voordeur. Het is misschien handig om de sleutel onder je deurmat te leggen, maar als iemand hem vindt, krijgt hij toegang tot je huis.

Wanneer ontwikkelaars een stuk code schrijven dat moet interageren met hun AI-model of dataset, worden ze soms een beetje lui. Ze kunnen de tokens hard coderen in hun code in plaats van veiligere manieren te gebruiken om ze te beheren.

Sommige van de tokens die Lasso vond gaven hen volledige lees- en schrijfrechten op Meta's Lama 2, BigScience Workshop en EleutherAI. Deze organisaties hebben allemaal AI-modellen die miljoenen keren zijn gedownload.

Als Lasso de slechteriken waren, dan hadden ze de modellen of datasets in de blootgelegde repositories kunnen aanpassen. Stel je voor dat iemand wat stiekeme code toevoegde aan Meta's repository en het vervolgens door miljoenen mensen liet downloaden.

Toen Meta, Google, Microsoft en anderen hoorden van de blootgestelde API tokens, trokken ze deze snel in.

Diefstal van modellen, vergiftiging van trainingsgegevens en het combineren van datasets van derden en vooraf getrainde modellen zijn allemaal grote risico's voor AI-bedrijven. Ontwikkelaars die API-tokens terloops in code laten staan, maken het alleen maar makkelijker voor slechte actoren om hier misbruik van te maken.

Je moet je afvragen of de technici van Lasso de eersten waren die deze kwetsbaarheden ontdekten.

Als cybercriminelen deze lopers hadden gevonden, zouden ze het zeker heel stil hebben gehouden terwijl ze de voordeur openden.