Nvidia heeft zijn Eos AI supercomputer geschaald en geoptimaliseerd om nieuwe MLPerf AI training benchmark records te vestigen.

Toen Nvidia in mei zijn AI-supercomputer Eos aanzette, kwamen 10.752 NVIDIA H100 Tensor Core GPU's tot leven en ze zijn zojuist onderworpen aan een aantal praktijktests.

Deze ongekende verwerkingskracht in combinatie met nieuwe softwareoptimalisaties heeft Eos in staat gesteld om MLPerf benchmark in recordgebied.

De open-source MLPerf benchmark is een set van trainings- en inferentietests ontworpen om de prestaties van machine learning workloads op echte datasets te meten.

Een van de opvallende resultaten was dat Eos in staat was om een GPT-3 model met 175 miljard parameters te trainen op een miljard tokens in slechts 3,9 minuten.

Toen Nvidia minder dan 6 maanden geleden het record vestigde op deze benchmark duurde het bijna 3 keer zo lang met een tijd van 10,9 minuten.

Nvidia was ook in staat om een efficiëntie van 93% te behalen tijdens de tests, wat betekent dat het bijna alle rekenkracht gebruikte die theoretisch beschikbaar is in Eos.

Microsoft Azure, dat grotendeels dezelfde H100-opstelling gebruikt als Eos in zijn ND H100 v5 virtuele machine, kwam binnen 2% van de testresultaten van Nvidia in zijn MLPerf-tests.

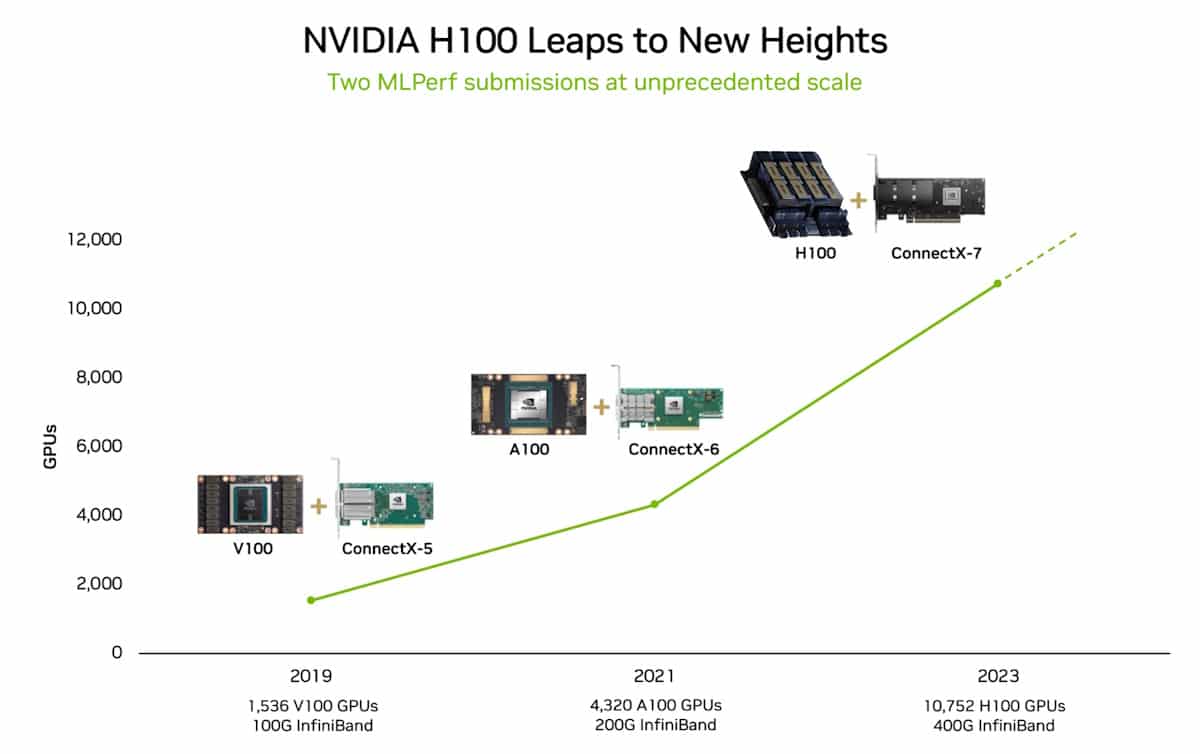

In 2018 zei Jensen Huang, de CEO van Nvidia, dat de prestaties van GPU's elke twee jaar meer dan verdubbelen. Deze bewering werd de Wet van Haung genoemd en is waar gebleken, want het laat Wet van Moore verdwijnt in de computerachteruitkijkspiegel.

Nou en?

De MLPerf benchmark trainingstest waar Nvidia goed in was, gebruikt slechts een deel van de volledige dataset waar GPT-3 op is getraind. Als je de tijd neemt die Eos heeft ingesteld in de MLPerf-test en deze extrapoleert voor de volledige GPT-3 dataset, dan kan het volledige model in slechts 8 dagen worden getraind.

Als je dat zou doen met het vorige geavanceerde systeem van 512 A100 GPU's, zou het ongeveer 170 dagen duren.

Als je een nieuw AI-model zou trainen, kun je je dan het verschil in tijd tot de markt en kosten voorstellen dat 8 dagen versus 170 dagen vertegenwoordigt?

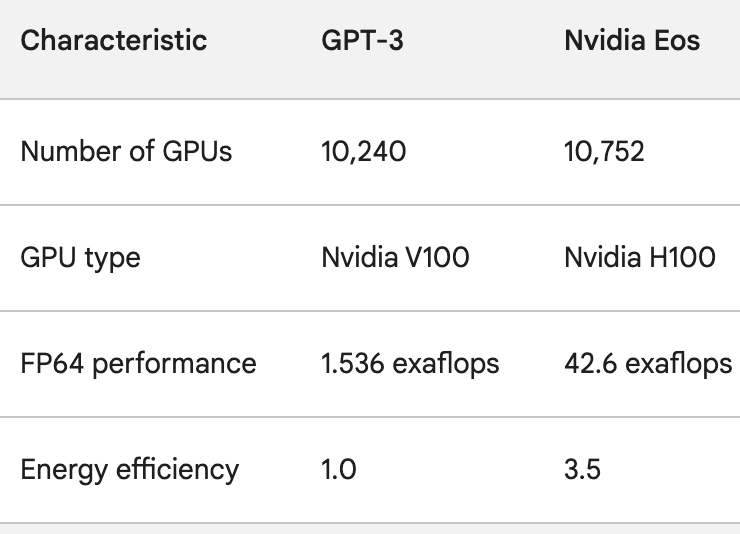

De H100 GPU's zijn niet alleen veel krachtiger dan de A100 GPU's, ze zijn ook tot 3,5 keer energiezuiniger. Energieverbruik en De koolstofvoetafdruk van AI zijn echte problemen die moeten worden aangepakt.

Om een idee te krijgen van hoe snel AI-verwerking verbetert, kun je denken aan ChatGPT, dat iets minder dan een jaar geleden live ging. Het onderliggende model, GPT-3, werd getraind op 10.240 Nvidia V100 GPU's.

Minder dan een jaar later heeft de Eos 28 keer de verwerkingskracht van die opstelling met een 3,5x hogere efficiëntie.

Toen OpenAI's Sam Altman de recente DevDay afsloot, zei hij dat de projecten waar OpenAI aan werkte, de laatste releases van OpenAI ouderwets zouden doen lijken.

Gezien de sprong in rekenkracht die bedrijven als Nvidia aan het maken zijn, geeft Altman's bewering waarschijnlijk de toekomst van de AI-industrie als geheel weer.